|

Wirklich wahres Wingmen SEO Wissen für wache Webmarketer #53

|

|

|

Ein SEO ist immer auch ein Kammerjäger

|

|

Ein Glück scheint die Sonne. Denn in der letzten Woche sind ein paar betrübliche Pannen aufgetaucht. Da Du Dir mehr Einblick in unseren Alltag gewünscht hast, kannst Du unten meinen Bugreport der letzten Woche lesen.

Außerdem:

-

Behrend beurteilt das Entfernen der Rich Results aus der Search Console und hat immer noch was zu moppern

-

Andreas achtet auf Spam bei Kundenprojekten

-

Nora nähert sich dem Geotargeting

-

Flo ärgert sich mal wieder über Google, den Javascript-Könner

Für längere Einleitungen ist das Wetter zu gut. Genieß die Sonne!

Und jetzt: Viel Spaß beim Lesen

|

|

|

Käfer-Chaos und kritische Katastrophen

|

|

Kurz, aber intensiv. Eine Woche voller Erkenntnisse und Bugs. Miese kleine Käfer. Letzte Woche war wirklich der Wurm drin. Eine Wurmwoche sozusagen:

-

Dienstag: Robots.txt Disallow für eine ganze Domain. Falls Google die überarbeitete Robots.txt nicht sofort nehmen will:

Hier der Link.

-

Mittwoch: Gehackte Subdomain mit Spam. Lösung: Subdomain disconnecten und deindexieren via Google Search Console.

-

Donnerstag: Ein Teaser-Banner wird auf der Startseite eingebaut. Der erste Link zur Landingpage auf der Seite ist jetzt nicht mehr das Keyword, da das Alt-Attribut des Banners nicht den Linktext enthält. Daher wird der Linktext mit relevantem Keyword eines zweiten Links zur Landingpage weiter unten entwertet. Ergebnis: Die Zielseite rankt nicht mehr. Eine Änderung des Alt-Attributs bringt das Seite 1 Ranking zurück. Um Umwelt-Einflüsse in der Schlussfolgerung zu reduzieren, versuchen wir gerade das Verhalten zu reproduzieren.

-

Freitag: Kunde hat Links auf eine Subdomain eingerichtet. Allerdings mit Tracking-Parametern. Auf der Subdomain entstehen so 2 Mio. unique URLs aus dem Hauptangebot. Diese URLs versucht Google zu crawlen und zwingt den Service der Subdomain in die Knie. Eigentlich besteht die Subdomain nur aus 100 URLs, die gut gecached sind.

Alles meine Kunden. Und ein Fehler klingt konstruierter als der andere. Ist aber wirklich so passiert. Ich schwöre (und kann es beweisen).

Dazu kommt ein Publisher: Irgendwie spielen wir heute keine Werbung aus. Ein Case, den man sich als SEO nur wünschen kann. Denn jetzt kann man eindeutig den Impact der Ads auf die Ladezeiten belegen. Yay!

Noch ein Bug vergangene Woche: Der Googlebot wurde von der Consent-Weiche nicht ausgenommen und mit JavaScript-Weiterleitung auf eine Consent-URL geschickt. Damit konnte Google die Seite nicht mehr crawlen und hat begonnen die Inhalte aus dem Index zu werfen.

Und weil es so schön ist mit den Bugs:

Als Marcus, Alex und ich über das Google-Update der letzten Woche gesprochen haben

sind wir darüber gestolpert, dass die

Startseite einer Domain auf Noindex steht

.

Aber Bugs passieren nicht nur im SEO.

Klarna zeigt den Kunden einfach beim Einloggen jedes Mal Daten anderer Kunden an

. Bitter.

Ein Glück, dass diese verbuggte Woche nur vier Tage hatte!

Um Dich von derlei Überraschungen abzusichern,

bietet sich im Übrigen ein Website-Monitoring an.

Kleiner Nachteil: Du kannst Dich damit nur vor solchen Bugs schützen, die Du selbst in Erwägung ziehst. Wenn dann aber ganz wilde und kreative Dinge passieren, die außerhalb des eigenen Vorstellungsbereichs liegen, kann man sich dagegen leider nicht so wirklich schützen. Aber: Jeden neuen Bug, nachdem er einmal aufgetreten und beseitigt wurde, ins bestehende Monitoring mit aufnehmen - damit beim nächsten Mal die Alarmglocke losgeht!

|

|

|

Rich Results Rest in Peace

|

|

Keine Panik, Rich Results in der SERP bleiben da, wo sie sind. Es geht um das Reporting der Rich Results in der GSC. Wieder einmal wird Nutzer-Feedback umgesetzt. Ab 01.08.2021 sind wir das

Rich Result Sammelbecken los

. Die Erkenntnis, dass die Breadcrumbs fast überall ausgespielt werden, hat uns nie wirklich weitergeholfen. Inzwischen sind

die wichtigsten Rich Snippet Varianten als eigene Kategorie vertreten

und man kann den Search Appearance Bericht schon fast sinnvoll nutzen. Problematisch sind weiterhin die Auswertung für Event und Job Ergebnisse, die selbst, wenn man die

Dokumentation der Zählweise

verstanden hat, nicht weiterhelfen. Für mich ist aber das GSC-Feedback der Woche:

As a SEO-Analyst I want to be able to use filters to exclude values for the dimensions Countries, Search Appearance and Devices to be able to filter for URLs without a certain page experience or rankings from countries other than my target market

Denn es wäre doch praktisch, wenn Du einen Kernmarkt ausschließen könntest, um zu sehen, was aus dem Ausland an Klicks auftaucht. Oder wie sich der Traffic für URLs mit schlechter Page Experience entwickelt. Wenn Du das auch so siehst: Der Feedback-Button in der GSC ist wie gewohnt links unten in der Seitenleiste. Den Text kannst Du gerne einfach von hier kopieren und einfügen.

|

|

|

Beschütze Deine Website vor Spam

|

|

Am 26.05.2021 hat Google im Search Central Blog darauf

hingewiesen

, dass die Low-Quality Inhalte in bestimmten Seitenbereichen auf die Rankings der ganzen Website eine negative Auswirkung haben können. Deswegen empfiehlt Google die Inhalte auf der Seite regelmäßig zu prüfen und bei Bedarf aufzuräumen.

In erster Linie sind damit natürlich alle Websites gemeint, die über ein Forum, Gästebuch oder Kommentare verfügen. Denn wenn die Nutzer ohne Kontrolle Inhalte erstellen können, dann können das auch die Bots oder die SEOs. Also, wenn es auf Deiner Seite sowas gibt, solltest Du unbedingt Moderation, Captcha und Login-Funktion in diesen Bereichen einführen.

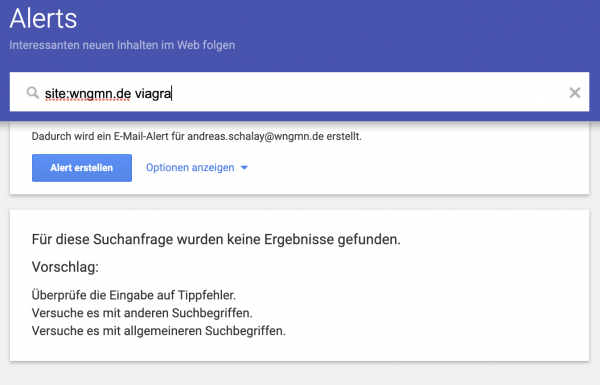

Putzig ist auch der Tipp von Google, Alerts für die Site-Abfragen in Kombination mit unterschiedlichen klassischen „Spam-Keywords“ einzurichten. Wir sind erstmal safe, und Du?

Aber es geht nicht nur um UGC, denn zu „Low-Quality“ Content gehören auch leere Filterseiten, Tag-Seiten ohne Artikel und andere Seiten ohne Mehrwert für den Nutzer. Deswegen empfehlen wir, die Seite regelmäßig zu crawlen und zu prüfen, ob alle verlinkte Seiten eine Existenz- und Verlinkungsberechtigung haben.

Kleiner Tipp: Um leere Kategorieseiten und ähnliches zu finden, können die Custom Extraction Funktionen von Screaming Frog und anderen Crawlern extrem nützlich sein. Darüber kannst Du zum Beispiel ganz einfach die angegebene Menge an Elementen in einer Liste mit Produkten extrahieren. Oder die Menge an Text innerhalb eines bestimmten Bereichs. Außerdem immer ein guter Ort, an dem Du eine kleine Marie Kondo Aktion starten kannst: Die Google Search Console. Welche URLs haben in den letzten 3, 6, 9, 12 Monaten kaum mehr Impressionen oder Klicks erhalten? Was dümpelt alles so im “Excluded”-Bereich des Coverage Reports rum? Einen hilfreichen Artikel, um Deine Inhalte auf den Prüfstand zu stellen,

hat Johan schon mal für Dich aufgeschrieben

.

|

|

|

Kann nun Google dieses Javascript oder nicht?

|

|

In der

18. Episode von Search of the Record Podcast

wurde wieder die Frage, ob Google mit Javascript umgehen kann, gestellt.

John Mueller berichtet von seiner kleinen Hobby-Seite, die er mit einem Static Site Generator gebaut hat. Als er Weiterleitungen einrichten wollte, musste er feststellen, dass es nur mit Javascript gehen würde. Deshalb fragte er seinen Podcast-Kollegen und Google Developer Martin Splitt, ob es deswegen mit Google Probleme geben könnte.

Daraufhin erklärt Martin, dass Google grundsätzlich keinen Unterschied zwischen statischen HTML und Javascript Content macht. Google crawlt die Seite und indexiert den HTML Inhalt. Dann wird die Seite gerendert und damit auch der DOM final aufgebaut. Es sollte also keine Probleme mit Inhalten, die nur mit Javascript erreichbar sind, geben. Damit könnte man die ganze Diskussion zum Thema Google und Javascript abschließen. Wären da nicht diese zwei Aussagen, die Martin am Ende seiner Ausführungen noch ergänzend hinzugefügt hatte:

-

"There's nothing that is fundamentally different between JavaScript generated content and static content, except for when there's edge cases, and we can't see content that is generated by JavaScript"

-

"I think links are also immediately extracted from the crawled HTML, and then we do that again where we have the rendered HTML. I think there's a logic that gets us link discovery as early as possible in the process, too"

Möchtest Du also das Risiko vermeiden, dass wichtige Inhalte, als „edge cases“ durch Google nicht wahrgenommen werden? Möchtest Du außerdem sicher gehen, dass die wichtigsten internen Links durch Google so schnell wie möglich in die Pagerank-Bewertung einbezogen werden? Dann solltest Du die wichtigsten Inhalte und Verlinkungen auf der Seite auch ohne Javascript erreichbar machen. "Don't make Google think" predige ich schon seit vielen grauen Haaren!

|

|

|

Kurzer Ausflug mit Google ins Geo-Targeting

|

|

In dem aktuellen

SEO-Office-Hours-Hangout von Google

erklärt John Müller (unter anderem) zwei Wege, wie Du Deine Seite Geo-Targeting-tauglich machen kannst.

Eine Möglichkeit wäre, eine Country-Code-Top-Level-Domains (ccTLDs) zu verwenden. Im Falle Deutschland wäre dies eine Domain mit der Endung .de

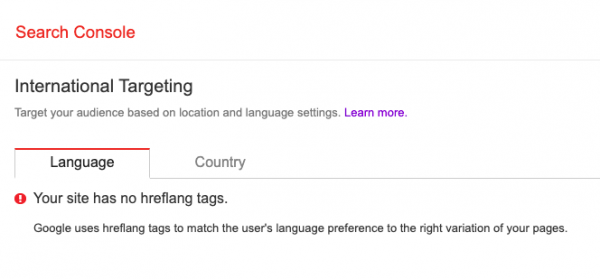

Eine weitere Option ist es, eine generische Top-Level-Domain wie .com verwenden und stattdessen das Geo-Targeting-Setting in der Google Search Console zu nutzen. Du findest diese Einstellungsmöglichkeit unter “Legacy tools and reports” -> “International Targeting”.

Unter Country hast Du die Möglichkeit, ein Land auszuwählen. Von dort aus gelangst Du auf eine Übersichtsseite und hast unter Country die Möglichkeit, ein Land auszuwählen.

Diese Einstellung bezieht sich laut Google

nur auf geografische Daten. Diese Option der Länderspezifizierung hat jedoch ihre Grenzen. Wenn Du zum Beispiel eine Seite hast, die auf Deutsch ist, aber auch für Nutzer aus Österreich und der Schweiz von Relevanz sein könnte, würdest du Deine potenzielle Nutzergruppe bei der Wahl “Deutschland” eventuell einschränken. Im Zweifel also lieber den Trichter oben weiter offen lassen. Außer Du bist Dir wirklich ganz sicher, nur diese bestimmte Region ansprechen zu wollen.

Für solch einen Fall könnte die zweite Übersicht interessant sein. Unter Language erhältst Du eine Auflistung verwendeter Hreflang-Attribute (wenn vorhanden) und deren Fehler. Diese Übersicht kann vor allem für multiregionale und mehrsprachige Websites hilfreich sein. Wenn keine Hreflangs, aber verschiedene Sprach- oder Länder-Versionen vorhanden sind, solltest Du Dir dazu möglicherweise mal dringend ein paar Gedanken dazu machen. Dabei kann Dir dieser

ausführliche Wissensbeitrag von Behrend

behilflich sein. Genauso wie dieses

nützliche Hreflang-Generator-Tool von Aleyda

.

Falls Du eine multiregionale und/oder mehrsprachige Website hast, gibt Google Dir in

diesem Artikel

außerdem nützliche Tipps zum verwalten und optimieren Deiner Inhalte.

Ich hoffe Dir hat unser kurzer Ausflug mit Google in die Möglichkeiten des Geo-Targeting gefallen!

Zum Thema internationales SEO bereiten wir gerade mit unseren Freunden von

Wieners+Wieners

ein Whitepaper vor. Schick mir gern eine kurze Notiz an

[email protected]

und ich schicke Dir ein Update, wenn das Whitepaper in ein paar Wochen fertig ist.

|

|

|

|

|

Fragen? Immer gerne fragen!

|

Wir sind für Dich da.

Schreib uns gern jederzeit

eine E-Mail an

[email protected]

oder

ruf uns einfach kurz an:

+49 40 22868040

Bis bald,

Deine Wingmen

|

|

Anckelmannsplatz 1, 20537 Hamburg, Germany

|

|