Content — Qualität vor Quantität

Fokussierung ist eine einfache Strategie: Lösche, was nichts bringt, verbessere was übrig bleibt und generiere damit mehr qualitativ hochwertigeren Traffic. So einfach das aktuell beliebte Konzept.

Bei der Umsetzung stellen sich allerdings zwei Fragen:

- Wie finde ich heraus, was ich lösche und was ich behalte?

- Was heißt löschen konkret?

Beide Fragen sind nicht einfach und für beide gilt: „Es kommt darauf an“. Dennoch können wir ein wenig Richtschnur geben.

Vorweg ein wenig Hintergrund:

Warum ranke ich mit weniger Seiten besser?

In der Tat ist dieser Punkt für Viele erst einmal kontraintuitiv. Doch sind die Mechanismen leicht zu verstehen, betrachtest Du folgende Punkte:

- Google hat mehr Ressourcen, um die wertvollen Inhalte zu verarbeiten

- Google hat eine höhere Trefferquote, um qualitativ hochwertige Inhalte zu finden

- Die interne Verlinkung wirkt zielgerichtet

- Die Optimierung des verbliebenen Inventars wirkt wie eine lösbare Aufgabe (und wird angegangen)

- Die aufgeräumte Seite ist im Verhältnis aktueller und qualitativ hochwertiger

Entscheidend ist natürlich, dass wir vor allem die Inhalte löschen, die wenig zum Erfolg beitragen.

Welchen Content löschen?

Du solltest allen Content löschen, der nicht positiv auf Branding, relevanten Traffic und Conversion einzahlt. Losgelöst von Branding und Conversion, ist aus SEO-Sicht Content positiv, der...

- bereits Traffic erhält,

- intern stark verlinkt wird,

- Linkverteilerfunktion für die interne Verlinkung hat,

- Links von außen einsammelt und

- indexierbar ist.

Wenn wir diese Bedingungen umkehren, wird daraus eine einfache Checkliste, nachdem irrelevanter Content identifiziert werden kann (Schwellenwerte solltest Du dabei individuell gestalten):

- URL erhält über einen längeren Zeitraum (saisonale Effekte berücksichtigen!) weniger als 1 Klick je Tag, laut Google Search Console (Schwellenwert vorab definieren, beziehungsweise anpassen)

- URL gehört nicht zu den 25% intern bestverlinkten URLs

- URL trägt nur geringfügig zur internen Verlinkung bei

- URL hat keine Aufrufe mit fremdem Referrer / keine externen Links

- URL ist nicht indexierbar und bietet keinen Mehrwert für Deine Besucher (beispielsweise, wenn bei Duplicate Content mit noindex gearbeitet wird)

Schematisch kann man das vereinfacht so darstellen:

Natürlich ist es möglich, die Auswertung komplexer zu gestalten und weitere Daten zu erheben, anhand derer man den Content überprüft. Denkbar ist die Einbeziehung von Conversions, die Länge von Texten, etc. – aber das nur am Rande.

Die konkrete Prüfung, wie mit den zu löschenden Inhalten zu verfahren ist, könnte so aussehen:

Wie wollen wir löschen?

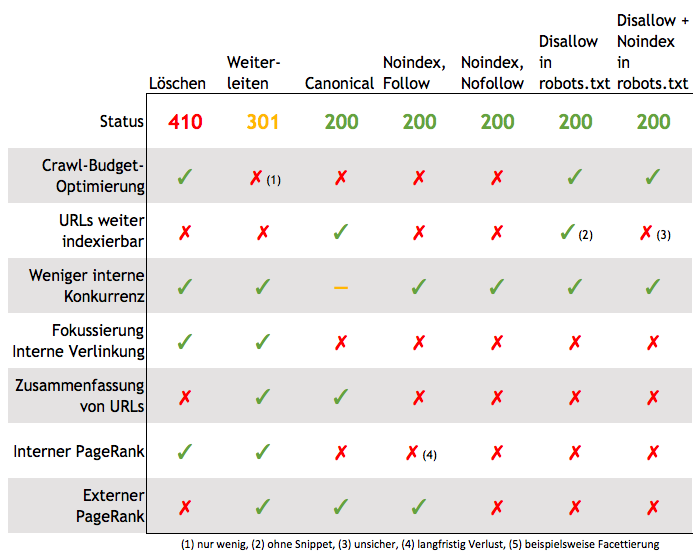

Grundsätzlich gibt es 5 Alternativen (natürlich gibt es noch mehr, aber die meisten Optionen lassen sich gut in dieses Muster integrieren):

- Löschen / 410 oder 404 –> Vernichten der URL

- Weiterleiten / 301 –> Weiterleiten der URL

- Canonical –> „Weiches“ weiterleiten der URL

- Noindex (Meta-Robots oder X-Robots bei Bildern, PDF, etc.) –> Indexierung der URL verbieten

- Disallow in Robots.txt –> Crawling der URL verbieten

Genau genommen, bleibt der Content bei den beiden letztgenannten Optionen erhalten und wird nicht gelöscht. Aber aus Google-Sicht rückt er zugunsten anderer Inhalte aus dem Fokus. Achtung: Ein Disallow in der robots.txt führt nicht zur Deindexierung einer URL!

Detailliert sieht das dann so aus:

Kommentare:

- Löschen (404/410): Bei wenigen externen Links bevorzugte Lösung

- Weiterleiten (301): Bei identischem Inhalt bevorzugte Lösung

- Canonical: Ein Hinweis, keine Anweisung an Google

- Noindex: Noindex wirkt mittel- bis langfristig wie Noindex, Nofollow

- Noindex, NoFollow: Nur als Notfallmaßnahme bei strukturellen Problemen sinnvoll (beispielsweise schlechte Facettierung)

- Disallow: (Robots.txt): Kontrollverlust über Indexierung, nur Notfall-Maßnahme bei Crawling-Problemen

- Disallow: + Noindex (Robots.txt): Nicht offiziell supportet, nicht verlässlich, scheint seit 01/2018 nicht mehr zu funktionieren. Mehr zu Noindex in der Robots.txt findest Du in unserem Robots.txt Wissensartikel

Tipp: Vor dem Löschen noch eine Sicherungskopie erstellen. Eventuell bietet es sich an den Content zu recyclen, aufzuhübschen, zu kombinieren und dann als neuen aktuellen Beitrag zu veröffentlichen.

Fazit:

- Sei gründlich in der Auswahl der zu löschenden Seiten.

- Sei gründlich in der Auswahl der Löschmethode - Löschen ist die einzige Variante, die alle Probleme behebt.

- Weiterleiten kann sinnvoll sein, wenn die Inhalte ähnlich sind. Wenn nicht, wird Google die Weiterleitung ignorieren. Sofern weiterleiten wenig Aufwand wäre, ist das die optimale Lösung.

- Noindex verliert mittelfristig die Linkpower, es ist nur kurzfristig besser als Robots.txt.

- Robots.txt Disallow ist eine reine Notlösung. Selbst eine zusätzlich NoIndex-Anweisung bringt hier keine Sicherheit. Achtung: Blockieren über Robots.txt führt dazu, dass HTTP-Status und Meta-Robots-/X-Robots-Indexierungsangaben nicht verarbeitet werden können.

- Ranke besser, mit mehr Fokus.

Die beste Variante ist, wertlose URLs gar nicht erst zu erzeugen.

Erstellst Du keinen Schrott, dann musst Du Dir keine Gedanken darüber machen, wie Du ihn entsorgst. — Seofuzius

Changelog

- 05.07.2018: Formulierung zu Noindex in Robots.txt verschärft.

--

Hat Dir der Artikel gefallen?

Neue Artikel, Updates zu unseren Artikeln und Artikel von anderen Stellen wir regelmäßig unserem Newsletter.

Beispielausgaben und Anmeldung findest Du unter Wingmen-Newsletter