|

Wirklich wahres Wingmen SEO Wissen für wache Webmarketer #63

|

|

|

🌚 Du hast die Schuld

|

|

Also ganz so schlimm ist mein Deutsch im Urlaub doch nicht geworden.

Natürlich heißt es „Du bist Schuld“. Und natürlich bist Du nicht wirklich schuld. Aber ich liebe diese Formulierung meiner Kinder. Denn „Du hast die Schuld“ klingt sehr nach schwarzer Peter, nach dem Schieben von Verantwortung und nicht nach der Lösung von Problemen.

Seit einigen Wochen warte ich darauf diese Überschrift zu verwenden. Und endlich gibt mir Behrend mit seinem Artikel einen Anlass.

Außerdem:

-

erklärt Hannah, warum SEOs PDFs meist nicht mögen

-

sagt Noni hallo

-

spricht Anita über Meerjungfrauen

-

rezensiert Lars das Gespräch zwischen Astrid und mir

Und jetzt: Rein in den Text und viel Spaß beim Lesen.

|

|

|

Die Search Console ist nicht immer Schuld

|

|

Das ist jetzt keine bahnbrechende Erkenntnis, aber man sollte sich das bei Traffic-Analysen immer zur Gemüte führen. Ein kleiner Erfahrungsbericht von meinem Freitag Nachmittag:

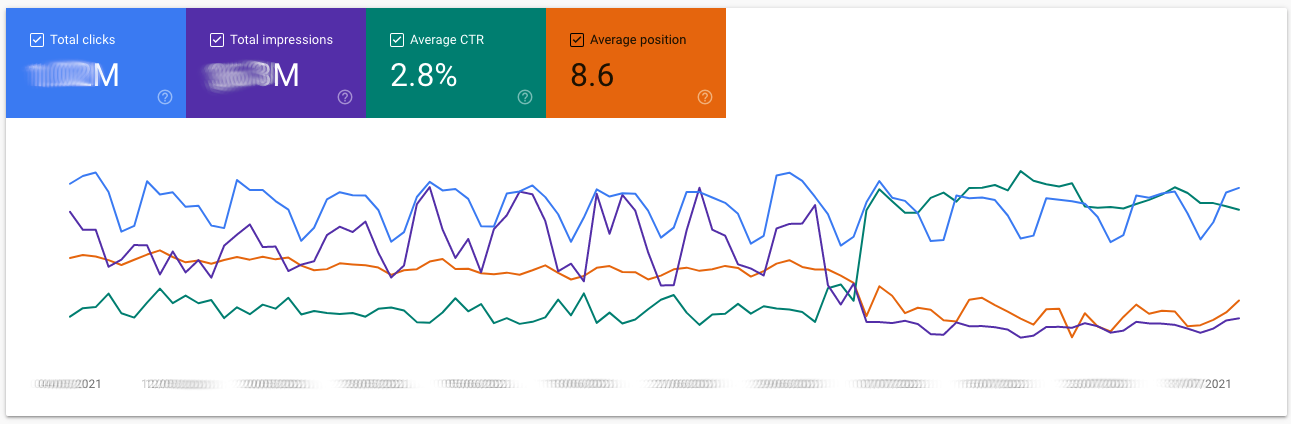

Einer unserer Kunden hatte einen massiven Einbruch an Impressions für die US-Domain zu verzeichnen. Während die Klicks und damit der eigentliche Traffic stabil bleiben, sind die Impressionen um >70% gefallen.

Plötzlicher Impressions-Verlust bei unserem Kunden

Plötzlicher Impressions-Verlust bei unserem Kunden

Was ist da los? Erste Analyseschritte grenzen das Problem ein:

-

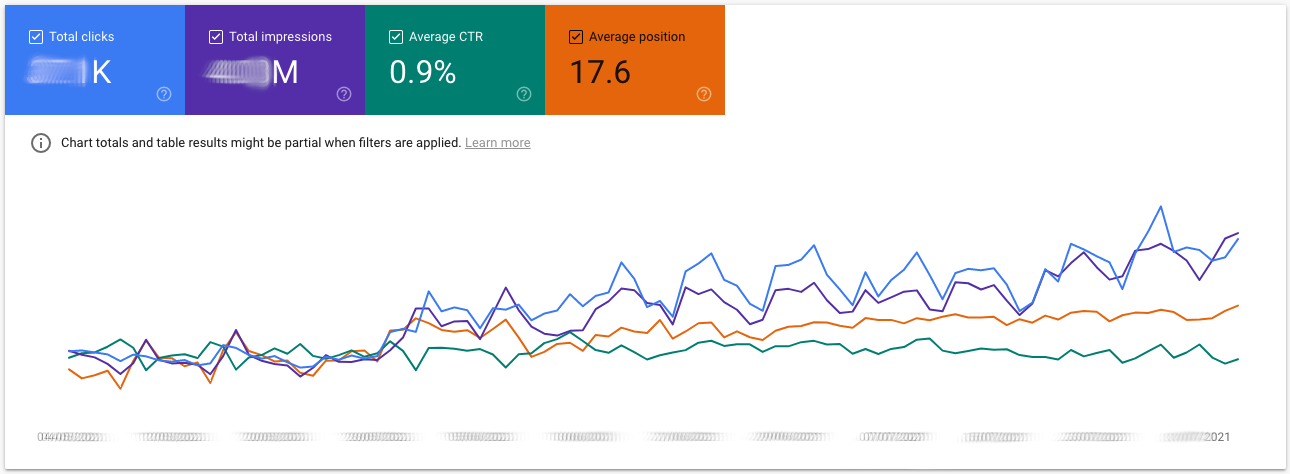

Der Non-Brand Traffic scheint überhaupt nicht betroffen und setzt den positiven Trend der letzten Monate ungehindert fort. Er hat sich in den letzten Wochen von Ø-Position 18 auf 15 verbessert, mit entsprechendem Einfluss auf Klicks und Impressionen. Erfreulich.

Non-Brand-Traffic entwickelt sich weiter positiv

Non-Brand-Traffic entwickelt sich weiter positiv

-

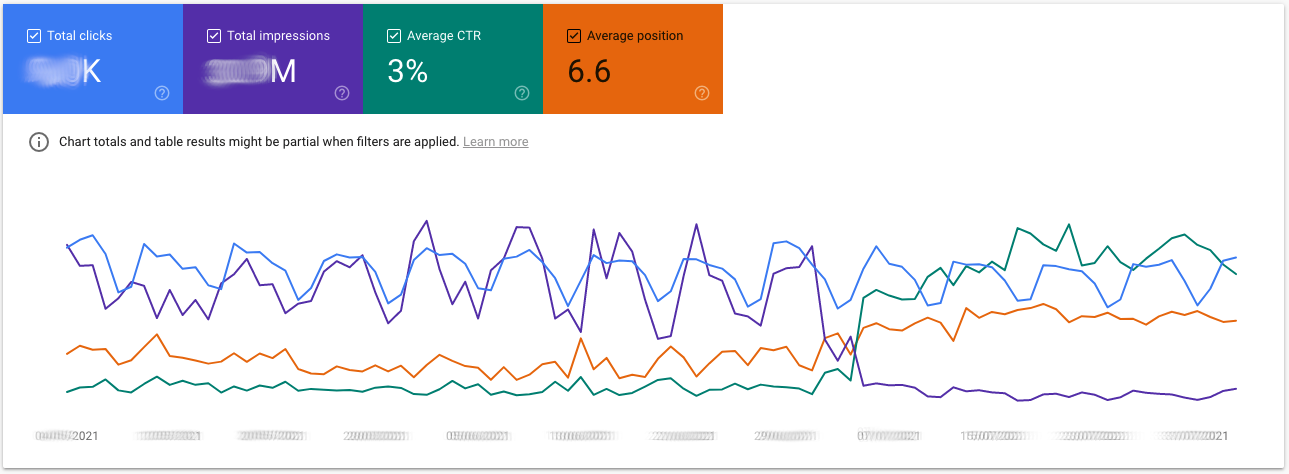

Der Impressions-Verlust hat ausschließlich den Brand-Traffic betroffen. Hier gab es aber keinen Verlust an Klicks und die Ø-Positionen haben sogar einen Sprung von Ø-Position 7 auf 5 gemacht.

Brand-Traffic verliert an Impressionen

Brand-Traffic verliert an Impressionen

-

Im Vergleich Mobile vs Desktop gibt es keine Unterschiede, die uns Aufschluss geben.

-

Countries. Aha, hier liegt der Hase im Pfeffer: Die US-Domain hat ihr Ranking in Deutschland unterhalb der deutschen Hautpdomian verloren.

Die verlorenen Impressions bezogen sich auf Brand suchen aus Deutschland (+ Österreich und Schweiz). Dort rankte die US-Domain auf Position ~7 hinter der deutschen Haupt-Domain. Da die Marke in Deutschland um ein Vielfaches bekannter ist als in den USA, haben diese “versehentlichen” Impressionen 90% der Brand-Impressionen und damit gute ⅘ der gesamten Impressionen für die US-Domain ausgemacht.

Problem identifiziert, diese “versehentlichen” Rankings waren bereits bekannt (auch wenn auch das Ausmaß so vor Augen geführt etwas erschreckt hat). Das Google damit aufgehört hat, die US-Domain in Deutschland und anderen deutschsprachigen Märkten auszuspielen, ist genau genommen sogar gewünscht und hängt wahrscheinlich mit Anpassungen in der Hreflang-Struktur und einer damit einhergehenden Neubewertung der regionalen Relevanz der Domains zusammen.

Soweit so gut... Dann die Rückfrage unserer Kundin: Warum wird die Position in Brand besser, in Non-Brand auch besser, geht aber insgesamt plötzlich nach unten. Eine gute Frage, die ich nicht auf Anhieb beantworten konnte. Aber kein Problem, das findet man fix raus, dachte ich zumindest. Ich bin sofort in die tiefe Analyse eingestiegen und damit habe ich einen Kardinalfehler gemacht.

Den halben Nachmittag bis in den frühen Abend habe ich mit dem Filtern von Daten verbracht. Auf einzelne Länder gefiltert, mit und ohne Brand Traffic, anonymisierte Queries quantifiziert, byPage und byProperty. Die Detail-Daten über die API gezogen und in Python ausgewertet. Impressionen mit Suchvolumina und Sistrix Rankings abgeglichen. Die ganze Klaviatur der GSC-Analyse einmal rauf und wieder runter und kein Hinweis, wie dieser verflixte Positionsverlust in den Gesamtdaten entstanden ist, wo sich doch alle Einzelgruppen verbessern. Es ergab einfach keinen Sinn… und dann kam die Erkenntnis.

Die Erklärung war so einfach wie offensichtlich. So einfach, dass es mir geradezu peinlich ist… So peinlich, dass ich zur Selbsttherapie diesen Artikel schreibe.

Und alle Informationen die es brauchte lagen von Anfang an vor. Jemand™ hätte einfach nur die Y-Achse beachten müssen: Der Non-Brand Traffic verbessert seine Position, aber im Vergleich zu Brand Traffic natürlich auf wesentlich schlechteren Positionen. Wenn Brand Impressionen wegfallen, wird das Gewicht der Non-Brand Impressionen höher. Genug, dass es den

gewichteten

Mittelwert der Position insgesamt nach unten zieht.

Was gibt es jetzt für Dich dabei zu lernen:

-

Manchmal ist ein Problem gar kein Problem, sondern sieht nur so aus

-

Schöne Graphen sind manchmal irreführend. Achte immer genau auf die Achsen. IMMER.

-

Die Daten in der Search Console sind objektiv richtig, aber es gibt viele Feinheiten. Sei Dir immer im Klaren darüber, was Du gerade anguckst und womit Du es vergleichst.

-

Die GSC ist natürlich doch Schuld, da bei der Darstellung von mehr als zwei Metriken der Performance Report keine Beschriftung mehr an der Y-Achse hat, und somit der Vergleich der Dimensionen natürlich nicht auffallen konnte #rausgeredet

|

|

|

Wieso wir SEOs PDFs nicht mögen

|

|

Es ist Dienstagmorgen. Du hast gestern den ganzen Tag an der Erstellung eines wunderschönen Inhalts in Form eines PDFs gesessen. Das gute Stück überprüfst Du nun noch einmal, während Du Deinen hochverdienten Kaffee trinkst. Sieht gut aus! Du hast nützliche Informationen zusammengetragen, tolle Bilder gefunden, eine aufwendige Infografik gebaut und

musst das Dokument jetzt nur noch auf Deine Website laden.

Du findest Dich hierin wieder? Dann sage ich nun: “Stop!”

Keine Sorge, den Kaffee darfst Du in Ruhe trinken, aber warum Du das PDF nicht hochladen solltest, sondern die Elemente lieber einzeln auf Deine Website stellst, erzähle ich Dir jetzt:

Infografiken und Bilder sind toll - in einem PDF versteckt aber leider vergebene Liebesmüh, denn der Googlebot indexiert diese leider nicht.

Je nach PDF liest der Googlebot den Text eventuell nicht, beispielsweise wenn es sich um einen Scan handelt. Wenn ein PDF gut formatiert ist und der Text auslesbar ist, werden PDFs auch indexiert, aber hey - sicher ist sicher!

Auch PDF-Inhalte können zu Duplicate Content Problemen führen. Hierbei musst Du also beispielsweise darauf achten, die Canonicals korrekt zu setzen. Im Fall von PDFs ist ein reguläres Canonical Tag wie wir es aus HTML-Dokumenten kennen nicht möglich, aber es gibt ein sogenanntes X-Canonical, welches über den HTTP-Header gesetzt werden kann. Wenn es den Inhalt (mehr oder weniger) 1:1 auch irgendwo als HTML-Inhalt gibt, könnte diese URL als Original referenziert werden.

PDFs können der Ladezeit schaden, wenn sie nicht optimiert und komprimiert sind. Und die ist, wie wir alle wissen, ein wichtiger SEO Hebel.

Weiterhin zu beachten ist das Thema der Verlinkung - Links in PDF-Dateien können Page Rank übertragen, die Links können aber nicht als “nofollow” gekennzeichnet werden - was Du aber manchmal ja mitunter gern tun würdest.

Mobile friendly sind PDFs meistens nicht - ich zumindest versuche erst garnicht mir auf meinem Smartphone PDFs anzugucken. Ranzoomen, hin und herschieben, huch in der Zeile der Tabelle doch verrutscht - puh, nein danke!

Wo wir gerade schon beim Thema mobile sind - es hat nicht jeder unbegrenzt Datenvolumen. Und wenn Dein Nutzer dann vielleicht irgendwo in der Pampa ein PDF mit 1 MB herunterladen soll um etwas zu lesen... nunja, macht das auch nicht jeder sondern springt vielleicht doch lieber auf eine andere Seite - und das willst Du natürlich nicht.

Da wären wir auch direkt beim nächsten Punkt - wo ist denn Dein Nutzer, wenn er sich Dein PDF anschaut? Genau! Nicht mehr auf Deiner Seite - willst Du das? Nein ;)

Hierbei möchte ich noch erwähnen, dass es auch durchaus Nutzer gibt, die nicht merken, dass sie sich ein PDF runtergeladen haben - die klicken dann mitunter immer und immer wieder (irgendwann dann ziemlich genervt!) auf einen Link weil sie denken, dass sie doch eigentlich irgendwo hingelangen müssten… auch die verlassen die Seite dann eventuell, weil sie nicht zu ihrem gewünschten Ziel kommen.

Und glaub mir, es wird sie auch später nicht freuen, wenn sie 15 mal das selbe Dokument in ihrem Download-Ordner finden und (wenn es ganz mies gelaufen ist) auf dem Dokument nicht einmal ersichtlich ist, woher es eigentlich kommt.

Stichwort Accessibility - Bedenke dazu bitte einfach die folgenden Punkte:

-

Kann jeder das PDF-Dokument öffnen?

-

Kann jeder das Dokument lesen?

-

Um auch für Screenreader beispielsweise zu funktionieren, müssen die PDFs bestimmten Standards wie WCAG 2.0, WCAG 2.1, HHS oder PDF/UA entsprechen - tut das Dein Dokument? Die meisten PDF-Dokumente tun es leider nicht. Versuch einmal ein PDF Dokument als normales Dokument zu konvertieren und schau Dir an, was für ein Chaos da meistens bei rauskommt - so ist es leider auch für Personen, die auf entsprechende Programme angewiesen sind.

-

Auch das automatische Übersetzen von Websites funktioniert für PDFs leider nicht. Lässt sich ein Franzose also Deine Seite übersetzen, kann zumindest der Inhalt des PDFs nicht direkt nachvollzogen werden. Wenn Du also Deine Produktdetailseite nur als PDF hochlädst, wird der Franzose Dein Produkt wahrscheinlich nicht kaufen, weil er nicht weiss, was drin ist oder was Dein Produkt tolles kann.

Auch das Stichwort Tracking solltest Du im Kopf haben, bevor Du etwas als PDF auf Deiner Seite hochlädst - mein lieber Kollege Justus, der absolute Tracking-Experte meint dazu

“Anders als in normalen HTML Dokumenten ist Webanalyse per JavaScript in PDFs nicht möglich und serverseitige Lösungen sind erheblich komplizierter umzusetzen – bei gleichzeitig deutlich kleinerem Funktionsumfang.”

Ganz verteufeln möchte ich die armen PDFs natürlich nicht - es gibt durchaus Dokumente, bei denen es sinnvoll ist, sie dem Kunden zur Verfügung zu stellen. Hierbei denke ich beispielsweise an Aufbauanleitungen für Dein Produkt oder ein Formular, welches Du herunterladen und ausfüllen kannst.

Wie sieht es bei Dir aus? Hast Du PDFs auf Deiner Website?

|

|

|

Servus!

|

|

Ich bin Noni (Ramona) und seit Anfang August ein Wingmensch! Ich werde Florian, Johan und alle Wingmenschen als Assistentin der GF unterstützen.

Ich komme ursprünglich aus Bayern und lebe seit 2015 in Hamburg. Bevor ich zu Wingmen gekommen bin, habe ich bei der Kassenärztlichen Vereinigung und bei der Ganske Verlagsgruppe gearbeitet.

Ich freue mich auf neue Herausforderungen und auf neue Eindrücke und ein liebes Team!

|

|

|

Über Meerjungfrauen und Spam

|

|

Wie vermutlich bei jeder Sache, die es so gibt auf der Welt, gibt es auch seit jeher im Bereich der Suchmaschinen Spammer. Sie versuchen, das System zu gamen um anderen zu schaden und sich selbst zu bereichern. Das wollen Suchmaschinen natürlich unterbinden, denn es liegt in ihrem Interesse, dass Nutzer*innen vertrauensvoll auf jedes Ergebnis klicken können, ohne Angst zu haben, auf irgendwelche unseriösen, betrügerischen oder anderweit schädlichen Websites zu gelangen.

Natürlich ist auch Google sehr bemüht, Spam in allen Formen wie Unkraut so schnell und gründlich zu vernichten. Klar kommt es vor, dass wir hier und da mal kleinere Fälle entdecken. Aber in der Regel nichts Wildes.

In Norwegen scheint es da einen Fall mit größerem Ausmaß zu geben. Wir sind über

diessen Blogpost von Alex

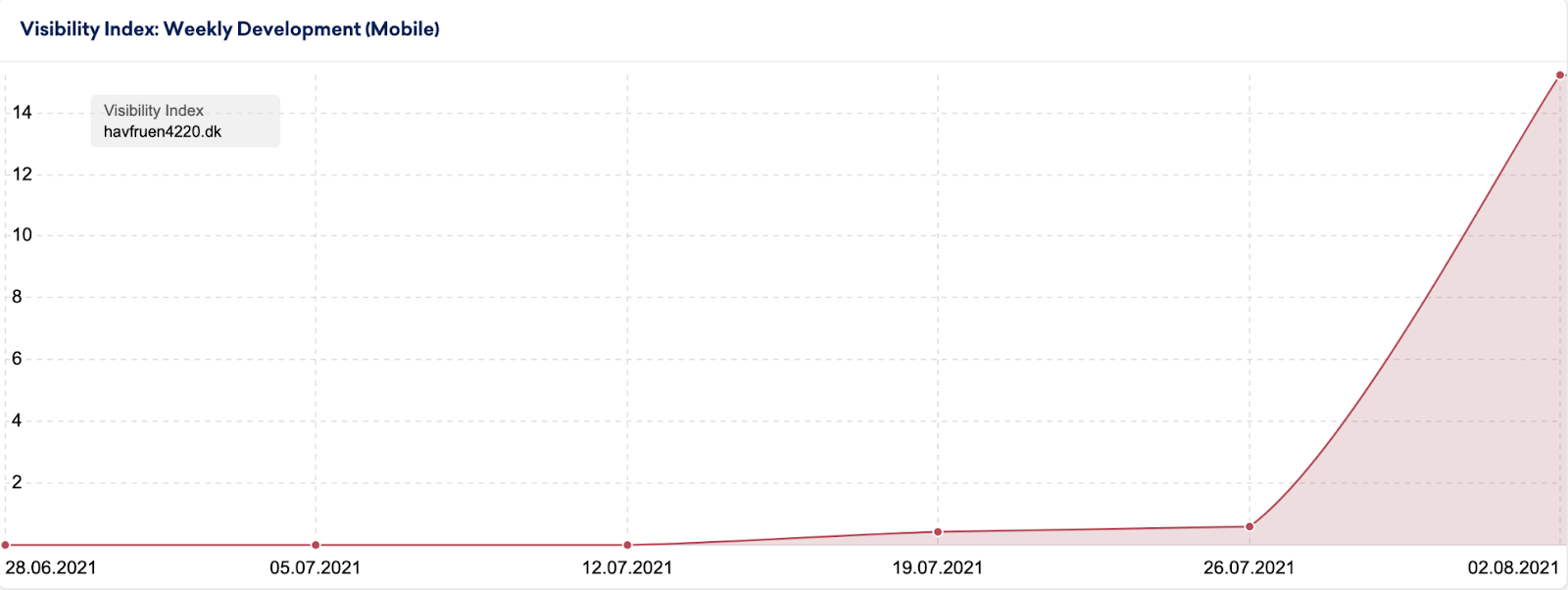

gestolpert. In Norwegen gibt es wohl seit kurzem (nicht nur eine!) Domain, die zu extrem vielen Anfragen ziemlich gut rankt. Nicht nur in Norwegen, sondern auch in Schweden https://no.sistrix.com/havfruen4220.dk/seo/countries, sagt SISTRIX.

It’s so bad that I’m convinced that this one spam domain is getting a large cut of all Google Search traffic in Norway. I can search for basically anything and find it in the first few pages with a very high probability.

Jede Menge Queries, zu denen die Domain ein Ranking einstreicht, hat Alex im Artikel aufgeführt. Auch dazu, wie die Betreiber das schaffen und was sie da genau für unseriöse Dinge treiben, gibt es im Beitrag detaillierte Infos.

Ich fand den Fall spannend und hab mir auch nochmal ein paar Dinge angeschaut. Interessant beispielsweise: Die Domain ist noch nicht mal norwegisch, sondern dänisch. Im

Sichtbarkeitsindex von SISTRIX

kann man gut sehen, wie sie Ende Juli / Anfang August auf einmal “explodiert” ist.

Dabei hat sie laut SISTRIX gerade mal

36 Backlinks von nur 11 verschiedenen Domains

vorzuweisen.

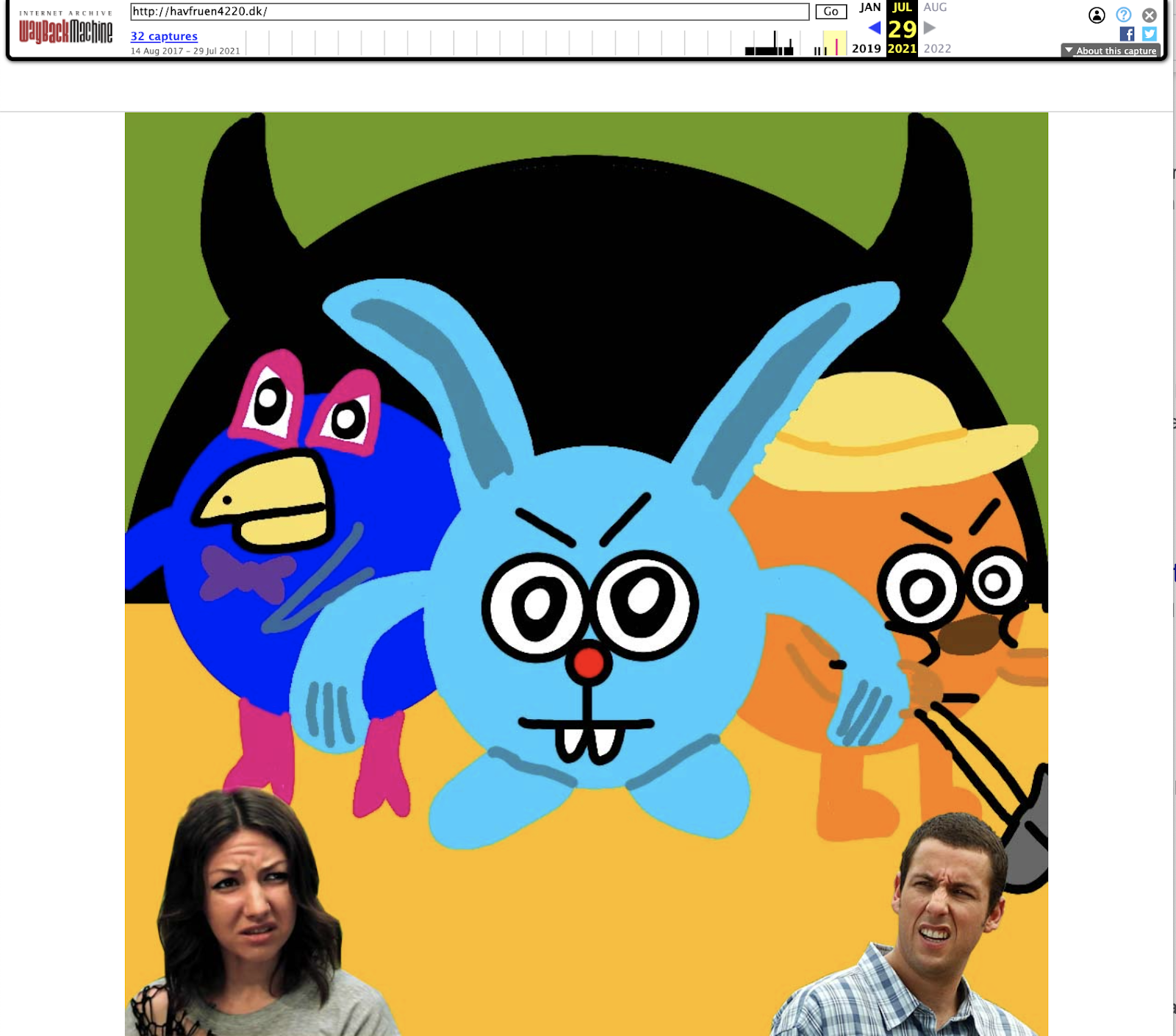

Direkt anschauen kann man sich die Seite mittlerweile leider nicht mehr. Denn sie ist nicht mehr erreichbar. Aber auf die Wayback Machine ist Verlass:

Sie hat für den 29. Juli einen Snapshot gespeichert.

Wobei mir da natürlich nicht entgangen ist, dass die Domain hier schon länger bekannt ist und der erste Screenshot aus August 2017. Der vorletzte Screenshot aus dem Januar diesen Jahres suggeriert, dass es sich bis dahin um die

Website eines Restaurants

gehandelt hat (Google Translate for the win!).

Da die Seite mittlerweile nicht mehr erreichbar ist kann es gut sein, dass sich das Phänomen schon wieder in Luft aufgelöst hat, bis Du das liest. Dennoch finde ich es spannend, dass es den Betreibern möglich war, die Rankings und den Traffic an sich zu reißen. Selbst wenn die Domain, die wir uns angeschaut haben, mittlerweile nicht mehr erreichbar ist, haben sie sicherlich schon weitere Domains, die sie auf den Weg schicken, um sich mit unseriösen Methoden zu bereichern. Außer natürlich, Google findet eine Möglichkeit, die Sache systematisch zu unterbinden.

Ein Martin kommentiert zumindest:

Hey, there is a LOT of domains like this and I mean a lot. We did some SEO for Norwegian market and its unbelivable what this spammer did!

Btw, this spammer made a whole network of sites like this accross all EU.

Was kannst Du tun, wenn Dir so etwas begegnet? Die entsprechende Seite an Google reporten. Auf dieser Seite findest Du Infos und Links zu unterschiedlichen Formularen https://developers.google.com/search/docs/advanced/guidelines/report-spam, über die Du die Meldung einreichen kannst.

Ach ja… wie komm ich eigentlich auf Meerjungfrauen? Die Domain enthält das Wort “havfruen”. Das ist dänisch für Meerjungfrau.

|

|

|

Hindern andere Johan daran perfekt zu sein?

|

|

Gemeinsam mit

Astrid

war Johan im

Webinar von SEMrush

zu Gast. Thema ihres angeregten Austauschs: Perfektionismus in der SEO Beratung oder wie sieht die Realität aus?

Eine These, die die beiden in dem Zusammenhang diskutieren, finde ich spannend: Wenn alle, die üblicherweise an einer Website beteiligt sind, einen perfekten Job machen würden, dann könnte sich SEO um seine eigentlichen Aufgaben kümmern. Denn oft haben wir ein Auge auf Themen, die eigentlich gar nicht in unserer Verantwortung liegen (sollten). Ladezeiten sind Johans Beispiel: Eigentlich sollte die Technik von sich aus auf gute Ladezeite achten, da sie aus so vielen Gesichtspunkten wichtig ist. Es sollte eigentlich nicht des SEOs bedürfen darauf hinzuwirken und Schwellenwerte festzulegen.

Wobei es auch immer ein bisschen auf die Sichtweise ankommt. Verstehen wir es als unsere Rolle, die Nutzer zu vertreten und ihnen eine bestmögliches Erfahrung zu ermöglichen, dann können wir uns durchaus in verschiedenen Themen mit einbringen. Und zum Beispiel dafür sorgen, dass es definierte und verbindliche Thresholds für bestimmte Metriken gibt. Dann aber bitte nicht nur punktuell oder einmalig optimieren, sondern Prozesse aufsetzen und stetig weiterentwickeln. Nicht nur im Bereich Page Speed, versteht sich von selbst.

Unterhaltsam ist auch der kleine Ausflug in die Vergangenheit der Website Audits. Hinsichtlich dessen, ob und wie diese Art von Analyse angegangen wird - und auch in welcher Form am Ende der Transfer von Ergebnissen und Empfehlungen stattfindet - hier hat sich einiges getan in den vergangenen Jahren.

Ein schöner Austausch mit zwei schlauen und sympathischen Menschen, der reichlich Input mit sich bringt und sich trotzdem gut weghören lässt. Ganz nebenbei erfährst Du dann auch, wieso Johans Fototapete nicht perfekt ist und wieviel Erfolg er bei seinem Linkkauf hatte.

|

|

|

|

|

Fragen? Immer gerne fragen!

|

Wir sind für Dich da.

Schreib uns gern jederzeit

eine E-Mail an

[email protected]

oder

ruf uns einfach kurz an:

+49 40 22868040

Bis bald,

Deine Wingmen

|

|

Anckelmannsplatz 1, 20537 Hamburg, Germany

|

|