| Wirklich wahres Wingmen SEO Wissen für wache Webmarketer #143 |

|

| 🤖 Die einzigen SEO News diese Woche FAST ohne ChatGPT |

Wenn ChatGPT eines geschafft hat, dann dass mir die Meldungen in den Medien aktuell zum Hals heraus hängen. ChatGPT hier, ChatGPT da. Haben wir SEOs nicht Sorgen genug? Aber im Ernst:

Bevor wir ChatGPT die Bühne überlassen, sollten wir doch wenigstens als SEOs unsere Hausaufgaben gemacht haben. Deshalb haben wir Dir viele spannende Artikel über für Deinen SEO-Alltag und NUR EINEN Artikel zu AI mitgebracht – Danke Caro!:

- Annemieke über SEO im Affiliate-Marketing

- Jolle führt Dich in die Filterfalle

- Caro hat ihre Gedanken zum Thema AI für News-Publisher in ein Trinkspiel gegossen. Du wirst das Bingowort spielerisch leicht erraten

- Anita rät Euch, die Augen bei der Outfit-Wahl offen zu halten

- und ich erzähle Dir etwas über CDNs, Interstitials und wieso Google so etwas doof findet

Viel Spaß beim Lesen,

Deine Wing-bots, äh -Menschen!

|

|

| Auch Affiliate-Marketing braucht eine SEO-Strategie |

Heute handelt mein Beitrag von dem neuen Artikel von Jessie Williams und Shelby Backley auf WTF is SEO. Die beiden Publishing-Profis beschäftigen sich mit dem Thema SEO und erklären vor allem dem Journalismus-Publikum immer wieder leicht, worauf es da ankommt. In der vergangenen Woche beschäftigten sie sich mit dem Thema Affiliate Marketing SEO.

Beim Thema Affiliate Marketing denkt man schnell an Hobbyblogger, für die der schnelle Rubel im Vordergrund steht. Dass dieser Eindruck täuscht und es viele seriöse Seiten gibt, zeigen beispielsweise viele Newsportale oder renommierte Infoportale wie Finanztip.de. (Anmerkung der Redaktion: "renommiert" räusper

Affiliate Marketing beschreibt eine partnerschaftliche Zusammenarbeit zwischen Produkthersteller/-vertreibendem und dem Webseitenbetreiber, der die Ratgeber Inhalte produziert sowie die jeweiligen Produkte innerhalb seines Contents empfiehlt oder bewertet.

Der Websitebetreiber spricht Kaufempfehlungen für die jeweiligen Produkte aus und stellt die direkte Weiterleitung zu dem Shop des Verkäufers her, zumeist aus seinem Text und/oder am Ende innerhalb einer übersichtlichen Platzierungstabelle, heraus. Eine Provision ist an einen Erfolg geknüpft, das kann der Kaufabschluss eines Produktes oder auch nur ein Klick auf einen Partnerlink bedeuten.

Laut den Erhebungen des Digital Marketing Institutes informieren sich 53% der Verbraucher im Vorwege online über ihren potentiellen Produktkauf, entsprechend hoch ist demnach die Relevanz der eigenen Affiliate-Strategie für den Verkauf der eigenen Produkte.

Eine Herausforderung besteht hier darin, dass die Kunden die Produktseiten häufig nicht als Brand kennen und sie nach dem gewünschten Produkt oder Vergleichs-Keywords suchen. Aus diesem Grund ist es wichtig, für generische Keywords zu ranken und bestenfalls besser als die Anbieter/ Hersteller selbst.

SEO & Affiliate - Warum SEO nicht aus dem Affiliate-Marketing wegzudenken ist:

Wie bei vielen Dingen im SEO sind auch hier wieder Keywords der Schlüssel zum Erfolg, denn auch hier ist es das Ziel, bestmöglich bei Google zu ranken. Die Konkurrenz ist groß und für Deine erfolgreiche Affiliate-Strategie ist es notwendig, dass potentielle Kunden, die eine Affiliate-Page als eines der ersten Ergebnisse zu ihrer Suchanfrage finden. So können sie sich direkt dort informieren und es kann zur angestrebten Conversion kommen.

Die Unterscheidung zwischen den kommerziellen und transaktionsbezogenen Suchbegriffen aus dem Artikel von Jessie Williams und Shelby Blackley sind besonders spannend. Mit transaktionsbezogenen Suchbegriffen zielen Nutzer direkter auf einen Kauf ab. Bei den kommerziellen Suchbegriffen geht es vordergründig darum, sich über bestimmte Marken oder Dienstleistungen zu informieren. Sie sind quasi die informationalen unter den transaktionalen Suchbegriffen 😵💫. Die kommerziellen Suchbegriffe sollten Deine Website-Besucher informieren und auch mögliche Nutzerfragen sollten nicht außer Acht gelassen werden.

Ende letzten Jahres hat Google seine Quality Rater Guidelines aktualisiert und dem E-A-T- Konzept ein zweites E hinzugefügt. Zudem sind die E-A-T-Faktoren mit dem Zusatz der Erfahrung ein wichtiger Bestandteil, um Vertrauen aufzubauen, damit die Leser Deinen Empfehlungen auch folgen. Ebenso wichtig zu wissen ist, dass Google mit den Product Review Updates vom August 2022 die Erfahrung und Expertise mittlerweile noch schwerer gewichtet.

Durch dieses Update ist es für die Pappnasen in der Online-Welt nicht mehr so einfach möglich, ungetestete Produkte zu vertreiben. Es werden Nutzer belohnt, die die hilfreichsten Bewertungen zuerst veröffentlichen, unabhängig davon, ob sie positiv oder negativ ausgefallen sind.

Produktbewertungen, die beispielsweise einen Nutzen, sowie Vor-und Nachteile aufführen, werden im oberen Bereich der Suchergebnisse aufgeführt und der Thin-Content rückt nach unten.

Abschließend war es für mich spannend zu sehen, dass sich nun auch Publisher mit dem Thema Affiliate Marketing und SEO auseinandersetzen und es für sie ein wichtiger Einnahmekanal sein kann.

|

|

| Vorsicht: Filterfallen verführen zu Fehlern |

Bei unseren Kundenprojekten hantieren wir oft mit großen Datensätzen, die gängige Programme für Tabellenkalkulationen zum Ächzen bringen. Zum Glück helfen Tools wie Knime oder die Pythonskripte, die unserem Highfivemind entspringen, die dicksten Brocken in handliche Scheiben zu schneiden, mit denen sich vernünftig weiterarbeiten lässt.

Zudem sind wir große Fans der 80/20-Regel (auch: des Pareto-Prinzips), nach der sich mit gut 20 Prozent des Aufwands oft 80 Prozent der Ergebnisse und Erkenntnisse erzielen lassen. Der Aufwand für die letzten 20 Prozent bis zu einem perfekten Ergebnis kann umgekehrt nochmal exorbitant ansteigen und 80 Prozent der Arbeit locker überschreiten. Die genaue Aufteilung spielt für dieses Sinnbild keine Rolle.

Wo setzt Du den Datenschnitt an?

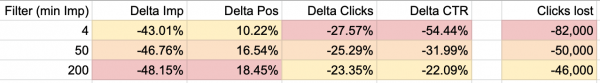

Neulich war ich mit einem Datensatz aus der Google Search Console (GSC) beschäftigt. Ich habe zwei Zeiträume vor und nach einem gravierenden Traffic-Einschnitt untersucht, um herauszufinden, ob bestimmte Gruppen und Typen von Seiten und Suchanfragen besonders betroffen sind.

Bei den Suchanfragen mit wenigen Impressionen handelt es sich häufig um Vertipper und Zufalls-Rankings, die wenig Klicks bringen und für das Kerngeschäft im Projekt meist keine Rolle spielen. Deshalb habe ich anfangs den Filter großzügig auf mindestens 200 Impressionen pro Suchanfrage und Seite entweder im Vorher- oder Nachher-Zeitraum gesetzt.

Ein Großteil der verlorenen Klicks ist mir in diesem Fenster zu den Daten aber direkt flöten gegangen. Also habe ich den Filter auf 50 Impressionen mindestens gedrosselt. In diesem Fall war das immer noch viel zu grobschlächtig. Letztlich habe ich mit einem Filter von mindestens 4 Impressionen gearbeitet, um wirklich einen repräsentativen Blick auf das Problem zu bekommen.

Was ich gelernt habe

Niemals vergessen: Filtern verfälscht Daten, also Aussagekraft der abgeleiteten Erkenntnisse gegenprüfen Positionen und Impressionen können gleichzeitig im Longtail stabiler bleiben (weniger verlieren) und dennoch stärker leiden (mehr verlieren), wenn es um den Traffic-Rückgang (Klicks) geht

Hast Du ähnliche Anekdoten? Welche Filter-Szenarien haben Dich in Deinen Analysen überrascht? Wir sind immer gespannt, wie die Welt von Deiner Warte aus aussieht, also meld Dich bei uns!

|

|

| Was ist eigentlich mit der AI-Spielerweiterung für News Publisher? |

Weiter geht's mit unseren Gedanken rund um AI und SEO. (Sorry Andreas!)

Jolle hat Dir letzte Woche schon ihre Gedanken zu strategischen Schachzügen in ihrer Spielanleitung verkündet. Behrend hatte dargelegt, wieso dieses Spiel auch mal Spielfehler aufzeigen kann.

Diese Woche gibt's den Wunsch nach einer Spielerweiterung für News Publisher: Viele große Publisher sprechen über mehr Spielregeln für ein faires Spiel. Dabei kommen nicht nur Sorgen bei einigen News Publishern um die eigene gute Partie in diesem riesen Schachspiel hoch, sondern auch Zweifel an der Spielqualität selbst, wenn AI vielleicht auch mal unabsichtlich schummelt oder eben immer wieder Spielfehler auftreten:

"Other news trade groups are also watching search chatbots closely. "We are very concerned about the role this revolutionary technology, which has the potential to do good, can play in the exponential proliferation of misinformation," says Paul Deegan, president and CEO of trade body News Media Canada. "Real journalism costs real money, and it is in Big Tech platforms' self-interest to negotiate fair content licensing agreements with news publishers."" - Wired Magazine

Dass AI das Spiel komplett übernimmt und alle SEO-Schachzüge von News Publishern verhindert, erscheint für uns erstmal unwahrscheinlich:

AI-zusammengestellte News benötigen eine Datenbasis. Ohne Datenbasis keine Schachzüge für AI. Die Spielpartner sind also in einer gegenseitigen Abhängigkeit. Außerdem ist die Gefahr von Spielfehlern noch viel zu hoch. Passend dazu ein kleiner Fun Fact: ChatGPT fällt durch das bayrische Abitur

Natürlich kennt kein Spieler die nächsten Schachzüge des anderen, aber das Spiel wird noch sehr lange weitergespielt werden, bis es tatsächlich eine revolutionäre Spielerweiterung geben wird. Und selbst dann werden News Publisher weiterhin zum Kreis der Schachspieler gehören müssen.

Spielst Du noch oder bangst Du schon um die neue Spielerweiterung?

P.S.: Kennst Du die AI-Spielerweiterung für Katzenliebhaber schon? (Selbstverständlich entdeckt von unserem Katzenliebhaber Behrend).

|

|

| Augen auf bei der Outfit-Wahl |

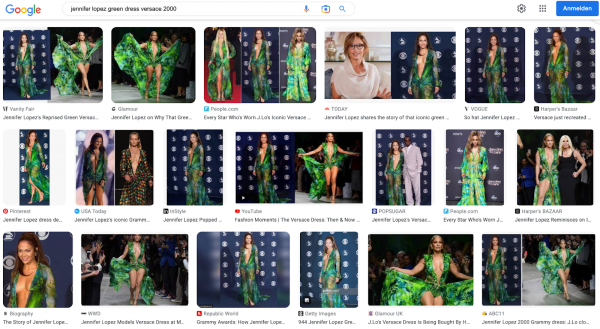

Stell Dir vor, Du gehst auf 'ne Party – und ein halbes Jahr später launcht Google deshalb ein neues Produkt. Klingt komisch, ist aber Jennifer Lopez wirklich passiert. Am 23. Februar 2000, also vor dezent 23 Jahren (Uff, fühlst Du Dich gerade auch unfassbar alt?), trug sie ein grünes Kleid von Versace auf dem Red Carpet der Grammy Awards. Das Outfit wurde ziemlich gefeiert und quasi über Nacht explodierte die Suche nach dem grünen Kleid. Da es die Bildersuche damals noch nicht gab, wurde sie tatsächlich deshalb erfunden.

"In 2000, Google Search results were limited to simple pages of text with links. Google's developers worked on developing this further, and they realized that an image search tool was required to answer "the most popular search query" they had seen to date: the green Versace dress of Jennifer Lopez worn in February 2000." - Wikipedia

Falls Du Dich jetzt fragst, wie denn ein Kleid, das einen solchen Hype auslöst, aussieht: Hier ein Screenshot aus der Google Bildersuche.

Eric Schmidt führt die Geschichte hier auch nochmal etwas weiter aus:

"When Google was launched, people were amazed that they were able to find out about almost anything by typing just a few words into a computer. The engineering behind it was technically complicated, but what you got was pretty rough: a page of text, broken up by ten blue links. It was better than anything else, but not great by today's standards.

So our co-founders Larry Page and Sergey Brin – like all other successful inventors – kept iterating. They started with images. After all, people wanted more than just text. This first became apparent after the 2000 Grammy Awards, where Jennifer Lopez wore a green dress that, well, caught the world's attention. At the time, it was the most popular search query we had ever seen. But we had no surefire way of getting users exactly what they wanted: JLo wearing that dress. Google Image Search was born."

Ziemlich verrückte Geschichte, finde ich. Auch wenn es schon eine Weile her ist, dass ich zum ersten Mal davon gelesen habe, muss ich doch immer schmunzeln und bin amüsiert, wenn ich wieder mal darüber stolpere. Wie sieht es bei Dir aus? Hast Du diese Geschichte bereits gekannt? Welche anderen kuriosen und unterhaltsamen Geschichten aus der Suchmaschinen-Welt faszinieren Dich?

|

|

| Auch gute Bots lösen kein Recaptcha |

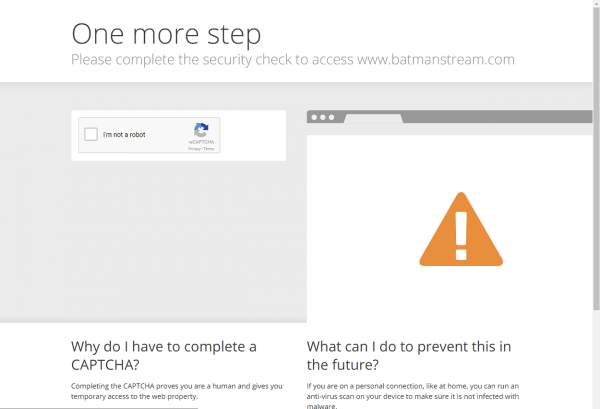

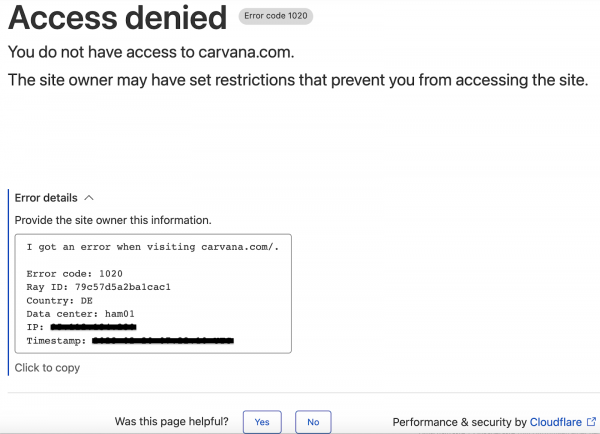

Wie oft ist es Dir selber schon passiert, dass Du auf einer Website als erstes einmal ein ReCapcha ausfüllen musstest, um zur eigentlichen Website "durchzukommen"? CloudFlare und auch andere CDNs bieten dies in Form einer SpamBot- Protection ihren Kunden an und dies kann unter Umständen auch für Deine Website wichtig sein, wenn Du mit vielen DDOS-Attacken zu kämpfen hast. Gary Illyes von Google hat jetzt noch einmal darauf hingewiesen, dass Du dabei unbedingt sicherstellen solltest, dass Google Bots (und ich denke, dass wir das auf alle anderen, uns wichtigen, Bots ausweiten können) diese so genannten Interstitial niemals zu Gesicht bekommen sollten.

Vielleicht fragst Du Dich wieso? Wenn wir uns die Funktionsweise eines Crawlers anschauen, dann ruft dieser eine beliebige URL aus seiner Verarbeitungs-Warteschlange ab und versucht den Inhalt für diese URL abzurufen. So zumindest die stark vereinfachte Annahme der Funktionsweise des Googlebot Schedulers, der uns hier für unsere Zwecke ausreicht 😉.

Antwortet nun ein CDN mit einem Interstitial, so nimmt der Crawler an, dass dies der Inhalt für die angeforderte URL wäre, schließlich wurde der Inhalt mit einem StatusCode 200 ausgeliefert. Nach dem Aufbau würde Google diesen Inhalt vermutlich als "Thin Content" bzw. "Duplicate Content" klassifizieren. Passiert dies nur ab und zu, so werden Deine Inhalte vermutlich immer mal wieder ranken, dann wieder nicht und Du wirst Dich fragen, weshalb Deine doch so guten Inhalte nicht auf den vordersten Plätzen gerankt werden.

Aus diesem Grund solltest Du sicherstellen, dass alle Bots aller Dir wichtigen Suchmaschinen alle wichtigen Inhalte zu jeder Zeit abrufen können und auch wirklich ausgeliefert bekommen.

Aber auch regionsbezogene Blockierungen solltest Du, wenn es Dir möglich ist, vermeiden. So gehen Dir nicht nur potentielle Neukunden verloren, sondern Du blockierst ggf. aus Versehen auch andere wichtige Bots der Suchmaschinen.

CDNs wie z.B. Cloudflare bieten Dir dafür Sicherheitseinstellungen an, die Du Dir unbedingt nach diesem Artikel einmal anschauen und verstehen solltest. Um die Einstellungen des Cloudflare Security Levels zu verstehen, empfehle ich Dir einmal die Dokumentation von Cloudflare direkt.

|

|

|

|

|

Fragen? Immer gerne fragen!

|

Wir sind für Dich da.

Schreib uns gern jederzeit

eine E-Mail an [email protected] oder

ruf uns einfach kurz an: +49 40 22868040

Bis bald,

Deine Wingmen

|

|

Anckelmannsplatz 1, 20537 Hamburg, Germany

|

|