| Wirklich wahres Wingmen SEO Wissen für wache Webmarketer #144 |

|

| 📉 🚨 📉 🚨 AAHHHH, Hilfe 10% weniger Conversions diesen Monat |

Bevor Dein Chef morgen Panik schiebt, dass im Februar der Umsatz eingebrochen ist, weis ihn vielleicht schon heute darauf hin, dass der Februar 10% kürzer ist als andere Monate. Das wirkt sich natürlich auch auf manche Kostenstellen aus. Also bevor Du gesunkene Serverkosten feierst, überleg, ob ein Year-over-Year-Vergleich oder ein genereller Blick auf 28-Tage-Fenster vielleicht bessere Ergebnisse liefert.

Und auch wenn der Februar kürzer ist, noch ist er nicht vorbei. Wir geben heute auch noch die letzten fehlenden 10% Februar SEO Content:

Jolle zieht Google vor Gericht Caro sammelt Erkenntnisse aus IVW-Zahlen Andreas erklärt, warum Du Dir IPv6 vielleicht doch einmal anschauen solltest Behrend hat die neusten News zur GSC Nora erzählt Dir von den Herausforderungen für Produkttests

Viel Spaß beim lesen und komm gut in den März,

Deine Wingmenschen

|

|

| Google vor Gericht: Sind Empfehlungsalgorithmen redaktionelle Entscheidungen? |

Google und andere Internetriesen stehen gerade vor dem US-amerikanischen Verfassungsgericht, wo Section 230 des Communication Decency Acts von 1996 verhandelt wird (Gonzalez vs. Google, Twitter, Inc. vs. Taamneh).

Angehörige von Opfern von Terrorismusanschlägen machen Empfehlungsalgorithmen sozialer Medien wie Youtube, Facebook oder Twitter mitverantwortlich dafür, dass sich Menschen im Netz zu Terrorist:innen radikalisieren.

Section 230 hat viele Jahre lang Internetplattformen in die Situation eines Mischwesens versetzt. Einerseits genossen sie die Vorteile reiner Hostinganbieter, bei denen Nutzer:innen Inhalte posten konnten, für die die Plattformen selbst nicht zur Verantwortung gezogen werden konnten.

Andererseits durften die Unternehmen durchaus Spam, Gewalt und sonstige unerwünschte Inhalte nach eigenen Regeln moderieren und entfernen, ohne dass sie dadurch automatisch als Medienunternehmen mit redaktioneller Verantwortung für ihre Inhalte klassifiziert wurden.

Der gesellschaftliche Wunsch nach Verantwortung

Während wir Zeitungen zur Rechenschaft ziehen, auf Unterlassung verklagen und zur Gegendarstellung bringen können, wenn diese ihrer journalistischen Sorgfaltspflicht nicht nachkommen, haben wir bei obszönen Falschmeldungen und extremen Verschwörungserzählungen in sozialen Medien keine griffige Handhabe.

Obwohl Internetfirmen aus dem Eigeninteresse heraus, ein ziviles Produkt als angenehme Umgebung für Werbeeinnahmen zu bauen, schon viel Anstößiges löschen, sperren und moderieren, sind die Rufe nach mehr Verantwortung gerade nach live gestreamten Terrorakten groß. Schärfer eingreifen, fordern die einen. Zensur und Verstoß gegen die Meinungsfreiheit die Anderen.

Maschinelle Redaktion?

Bislang konnten sich die Plattformen darauf zurückziehen, lediglich die Infrastruktur für die Beiträge der Nutzer:innen zu stellen, selbst aber keine Inhalte zu publizieren.

Neu in der Argumentation der zwei Gerichtsverfahren, die hier vom Guardian skizziert sind, ist Folgendes: Die Algorithmen, die vorschlagen, welche Videos man sich als nächstes ansehen könnte, lassen sich nicht mehr als User Generated Content (UGC) bezeichnen. Sie sind vergleichbar mit der redaktionellen Entscheidung, welche Themen es in eine Zeitung schaffen und welche nicht.

Das leuchtet ein. Die Auswirkungen auf das Ökosystem Internet, wenn Section 230 gekippt würde, lässt sich allerdings kaum überschätzen. Man muss sich vor Augen führen, dass vermutlich mehr als 90 Prozent aller Inhalte im Internet Schrott, Spam und Betrug sind. Stellt man die Internetplattformen vor die Wahl, entweder gar nicht auszusieben und alles durchwinken oder aber für alles, was noch gepostet werden darf, die volle Verantwortung zu übernehmen, gibt es zwei Optionen:

Eine Welt mit noch mehr Mist, bei dem man selbst kaum noch zu den Perlen, die man gerne konsumieren möchte, finden würde. Oder eine Welt, in der übervorsichtig viel zu viel gelöscht würde.

"Horror-Show" vs. "Truman Show", wie der Google-Anwalt es ausdrückte. Ohne Twitter wären die Besorgnisse von Virologen nach dem Covid-19-Ausbruch vermutlich erst wesentlich später in die öffentliche Sphäre gelangt. Videos von Polizeigewalt würden es ohne soziale Medien mit Section-230-Schutz vermutlich nicht geben.

Wettbewerbshindernisse für die Kleinen

Beide Extremszenarien würden außerdem kleineren Plattformen das Leben schwerer machen als den großen Playern. Mit ungefilterten Schrottinhalten wird es kaum möglich sein, sich am Markt zu etablieren. Unsummen in ein ausreichend funktionierendes Content-Filtering zu investieren, kann sich dagegen eine aufstrebende Plattform vermutlich kaum leisten.

Der Supreme Court scheint sich der Verantwortung bewusst zu sein – auch wenn Richterin Elena Kagan zugab:

"You know, these are not like the nine greatest experts on the internet."

Was hat das mit SEO zu tun

Nun, das Internet ist das Ökosystem, in dem wir alle Inhalte auf Webseiten und sozialen Medien publizieren. Algorithmen, nach denen Player wie Google "entscheiden", welche Inhalte gesehen werden und welche nicht, sind die Basis, von der wir unsere Handlungsempfehlungen ableiten.

Wie siehst Du das? Sind Algorithmen wie redaktionelle Entscheidungen? Oder gerade kein menschliches Abwägen im Einzelfall? Wie könnte eine Kompromisslösung aussehen, wonach wir als Gesellschaft Regeln aufstellen wollen, die eingrenzen, was online verfügbar sein und priorisiert gezeigt werden sollte und was nicht?

|

|

| IVW: Insights zum Verlauf der Wettbewerber |

Nein, IVW steht nicht für Insights zum Verlauf der Wettbewerber. Aber das schlechte Wortspiel hat zu lange gebraucht, um es nun nicht zu benutzen. Und es vereinfacht vielleicht auch, was die Informationsgemeinschaft zur Feststellung der Verbreitung von Werbeträgern e.V. uns ermöglicht.

Johan hatte sich neulich für ein Projekt genauer mit den IVW-Zahlen auseinandergesetzt und für Online News Publisher verschiedene Datenansichten gebaut, um sich die Entwicklung verschiedener Publisher anzusehen.

Was für Erkenntnisse wir daraus ziehen konnten, zeigen wir Dir heute:

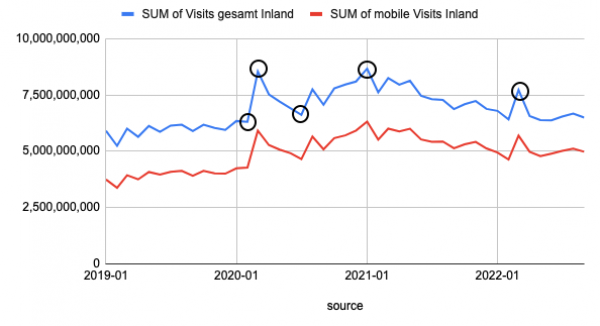

In der Gesamtentwicklung mit allen Besuchen in Deutschland für alle Online Publisher ist ein spannender Verlauf zu erkennen: Die Geschehnisse in der Welt beeinflussen unseren Nachrichtenkonsum enorm.

Im Graphen sehen wir dies genau:

Langsame Steigerung bis Beginn 2020, dann aber explosionsartiger Anstieg mit Beginn der Pandemie Ein abflachender Verlauf zum Sommer hin (Pandemie-Lage hatte sich etwas entspannt) Erneuter Aufwärtstrend über den Winter 20/21 Langsamer Abfall während des gesamten Jahres 2021 Anfang 2022 gab es dann wieder einen Peak mit Beginn des Russland-Ukraine-Krieges

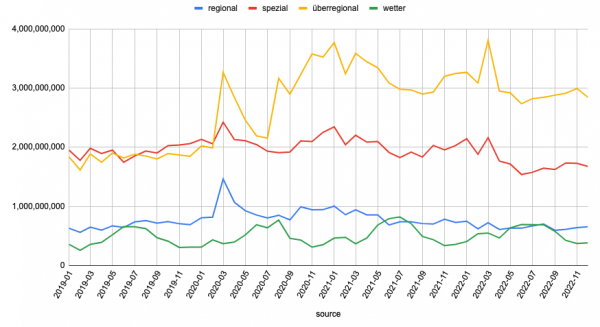

Diese Ansicht hat Johan auch für verschiedene Publisher-Gruppierungen aufgesplittet:

Regionale Publisher Überregionale Publisher Spezial-Publisher Wetter

Was wir hier ableiten können:

Corona hat lokale und überregionale Publisher stark gepusht Überregionale Publisher liegen weiterhin massiv über 2019 und haben im Schnitt 1/3 mehr Traffic als 2019. Putins Krieg hat für einen weiteren Peak bei überregionalen Publishern gesorgt. Regionale Publisher haben 2021 schon gegenüber 2020 verloren und 2022 nochmals. Spezial-Publisher haben nur kurz von Corona profitiert. Putins Krieg schadet ihnen aber enorm Wetter ist im Sommer interessanter als im Winter und unbeeinflusst vom Weltgeschehen.

Hast Du diese Entwicklungen auch so, wie die IVW-Zahlen es uns zeigen, zu spüren bekommen?

|

|

| Wie steht es eigentlich um IPv6 und Deiner Website? |

Eine neue Sau, die durchs SEO-Dorf getrieben wird? Wohl eher nicht! Aber vermutlich doch eine eher nicht so angenehme Frage, wenn man bedenkt, dass im Jahr 2012 schon alle IPv4-Adressen vergeben waren und ein riesiger Aufschrei um die Welt ging. Damals musste der Umstieg auf IPv6 schnell vorangetrieben werden. Aber wie sieht es heute, 11 Jahre danach aus? Ist Deine Website native über IPv6 erreichbar? Warum Du dies auf dem Schirm haben solltest, erkläre ich Dir in diesem Artikel.

Was ist IPv6 noch einmal?

IPv6 wurde als Internetprotokoll eingeführt, da die IPv4-Adressen zur Neige gingen. Eine IPv4-Adresse besteht aus 32 Bits und so kann es max. 4,3 Milliarden IPv4-Adressen geben. Um dies aufzufangen, wurde unseren Routern Network Address Translation (NAT) beigebracht, womit wir nun schon Jahrzehnte arbeiten. Jedoch zeigte sich schnell, dass auch diese Technologie nicht ausreichen wird und eine größere Anzahl an IP-Adressen benötigt wird. Vor diesem Hintergrund und mit einer Vielzahl an Verbesserungen wurde dann das IPv6-Protokoll erarbeitet. Mit diesem sind theoretisch bis zu 340 Sextillionen (340.282.366.920.938.463.463.374.607.431.768.211.456) IP-Adressen möglich. Jedoch müssen die Geräte selbst mit dem neuen Protokoll ausgestattet werden, was bei den teuren Anschaffungspreisen und beschränkten Update-Fähigkeiten zu einer jahrzehntelangen Aufgabe geworden ist.

Wo stehen wir in der Umsetzung?

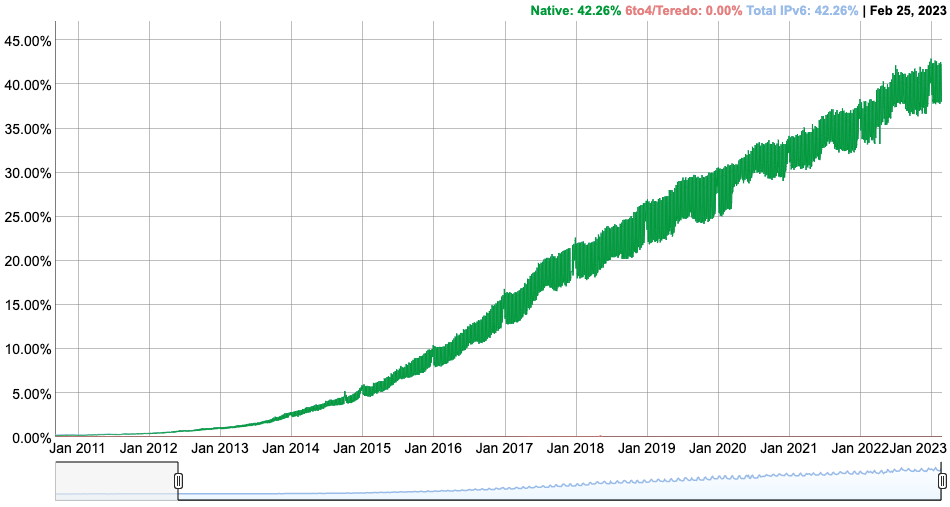

Laut einer Erhebung von Google stehen wir weltweit zwischen ca. 38% und 43% aller von Google getesteten Geräte. Eine so geringe Zahl an Geräten, 11 Jahre nach Einführung von IPv6, ist vermutlich auf Tunnel-Technologien wie "6in4" und "4in6" zurückzuführen.

Klicke aufs Bild und schau Dir die Livedaten an.

Klicke aufs Bild und schau Dir die Livedaten an.

Diese Technologien erlauben es, Datenpakete zwischen den beiden Protokoll-Welten zu transferieren und haben so den Schmerz bzw. die Notwendigkeit einer Umstellung geringer erscheinen lassen. Und so ist ganz heimlich der Druck vom Kessel genommen worden.

In Europa steht Deutschland (66,79%) in der Umstellung hinter Frankreich (75,3%) gar nicht mal so schlecht da. Jedoch zeigt es auch, dass es noch einiges zu tun gibt, bevor wir uns endgültig von IPv4 verabschieden können.

Warum solltest Du jetzt prüfen und IPv6 jetzt einrichten?

Es gibt zahlreiche Verbesserungen im IPv6-Protokoll. Darunter zählen:

Effizienteres Routing ohne Fragmentierung von Paketen

(Von Google wird hier die Latenz meist mit -10ms gemessen) Eingebaute Quality of Service (QoS), die verzögerungs-empfindliche Pakete unterscheidet und eine Vielzahl an weiteren Funktionen ermöglicht, die auf die Unterscheidung von Datenpaketen angewiesen ist (Filter, Bandbreitenbegrenzungen, besserer Umgang mit Paketverlusten) NAT und damit zeitfressende Zuordnungs-Prozesse im Router gehören der Vergangenheit an Eingebaute Sicherheit auf Netzwerkschicht (IPsec) Zustandslose Adressen-Autokonfiguration für einfachere Netzwerkverwaltung Verbesserte Header-Struktur mit weniger Verarbeitungsaufwand Benötigt keine Tunnel-Technologien wie "4in6" oder "6in4" (Spart mit jedem Abruf Strom und CO2)

So einfach kann es sein! Oder doch nicht?

Teste, ob Deine Website nicht schon über eine IPv6 erreichbar ist (Ist dies nicht der Fall, dann mache mit Schritt zwei weiter). Prüfe, ob der Server Deiner Website mit einer IPv6-Adresse ausgestattet ist. Logge Dich dazu in das Backend Deines Providers ein oder wende Dich an Deinen Website-Administrator. Ist dem Server noch keine IPv6-Adresse zugewiesen, so wende Dich an Deinen Provider, um dies zu ändern. Bei Providern wie DigitalOcean, MS Azure oder der AWS muss dies ggf. ein Administrator aus Deinem Unternehmen oder Deiner Agentur erledigen. Nachdem der Server eine IPv6-Adresse zugewiesen bekommen hat, muss nun noch der Webserver (Aapche, NGNIX usw.) angewiesen werden, auch auf Anfragen an dieser IP-Adresse zu warten und diese anzunehmen. Auch dies wird meistens von Deinem Administrator oder Deinem Provider übernommen. Ist der Webserver konfiguriert, muss nun noch die neue IP-Adresse im DomainNameServer (DNS) hinterlegt werden. Dazu verwenden wir einen AAAA-Record für die Domain. Wir erinnern uns, ein A-Record wird für die Auflösung einer IPv4-Adresse verwendet. AAAA-Record sind für IPv6-Adressen gedacht. Achte dabei darauf, dass Du für alle A-Records der Domain auch einen AAAA-Record mit der neuen IPv6-Adresse einrichtest.

Fertig! Damit ist Dein Webserver im sogenannten Dual-Stack-Modus konfiguriert und beantwortet Anfragen via IPv4 und IPv6. Du kannst dies durch den oben aufgeführten Test erneut prüfen.

|

|

| Permission to Bulk export granted |

Die Entwickler der Google Search Console (GSC) waren mal wieder fleißig und haben in den letzten Tagen zwei relevante Updates rausgehauen:

Users and permissions

Die User Permissions wurden angepasst. Zugegeben, das bringt Dir jetzt keine spannenden neuen Insights für Deine SEO-Aktivitäten, aber es ist relevant. Es ist nun nicht nur möglich, die Nutzer mit Zugriff und deren Rolle einzusehen, sondern es gibt auch eine History und eine Auflistung der Verification-Tokens, die eventuell noch rumfliegen.

Nicht wenige Properties sind aus unterschiedlichen Gründen mehrfach authentifiziert. Da gibt es bespielsweise die Accounts dieser generischen Performance Marketing Agentur, die seit Jahren nicht mehr mit Deinem Unternehmen zusammenarbeitet. Dein Vorgänger hatte vielleicht vergessen, deren Zugriff auf Eure GSC abzuklemmen. Das hast Du vielleicht bereits nachgeholt, als Du den Posten übernommen hast. Jetzt kannst Du in der GSC aber auch sehen, dass von denen immer noch ein GSC-Verification HTML im Root Deiner Domain vor sich hin oxidiert.

Guck Dir also die neuen Berichte über Nutzer und Berechtigungen Deiner GSC-Properties mal an. Vielleicht gibt es da was aufzuräumen. Auch wenn es ein langweiliges Thema ist.

Big Query Bulk Export

Für die meisten Properties reicht das GSC-Frontend mit seinen 1.000 Zeilen nicht aus, um die Details des Performance Reports auszuspucken. Mit viel Filter-Mühe bekommt man im Zweifel das meiste geklärt.

Aber die GSC-API ist da schon ein Game Changer. Damit kann man zügig ein komplettes Bild abfragen. Außer die Property ist wirklich groß. Dann läuft man in das Daily-data-row-limit. Das ist zwar selten ein Problem. Aber es gibt dann doch Properties, wo das einen signifikanten blinden Fleck hinterlässt...

Doch nun gibt es Abhilfe: Die Big Query Bulk data exports. Sobald das Feature für Deine Property ausgerollt ist, kannst Du Dir die Search Console Daten in ein Big Query Projekt pumpen lassen. Und dann ohne das Daily-data-row-limit. Als einzige Begrenzung bleiben die anonymized Queries...

Aber nicht nur das. Die Dokumentation für die GSC Big Query Tables zeigt einige interessante Details. Neben ein paar praktischen Dimensionen wie "isanonymizedquery", um Filtern zu erleichtern (und sparsamere Big Query Abfragen bauen zu können).

Und last but not least: in Deinem Big Query Projekt, bestimmst Du, wie lange Du die Daten speicherst. 16 Monate wie in der GSC, 24 Monate, um volle Year-over-Year-Vergleiche machen zu können, für immer und ewig oder einfach nur 3 Monate, weil Du Dich nostalgisch nach den einfacheren Zeiten der alten Search Console sehnst Budget für Big Query möglichst gerin halten willst.

Denn bei all der Freude über viele Daten solltest Du natürlich bedenken, dass die Auswertung nicht ganz trivial ist und BigQuery im Gegensatz zur GSC durchaus Geld kostet. Je nach Anwendungsfall sind Tools wie Ryte – wir sind übrigens sehr freiwillig Ryte-Partner, die ebenfalls mehr GSC-Daten bieten, eine mögliche Alternative.

Wenn man die Abfragen geschickt gestaltet und Big Query Best Practices einhält, lässt sich das Preisschild aber durchaus in einem vertretbaren Rahmen halten. Mir juckt es auf jeden Fall in den Fingern, die ersten Auswertungen zu starten.

|

|

|

|

|

Fragen? Immer gerne fragen!

|

Wir sind für Dich da.

Schreib uns gern jederzeit

eine E-Mail an [email protected] oder

ruf uns einfach kurz an: +49 40 22868040

Bis bald,

Deine Wingmen

|

|

Anckelmannsplatz 1, 20537 Hamburg, Germany

|

|