|

Wirklich wahres Wingmen SEO Wissen für wache Webmarketer #73

|

|

|

Frisches Salz für Deine SEO-Kürbissuppe

|

|

Mit voller Besetzung und voller Kraft sind wir in eine neue Woche, voller SEO-Abenteuer, gestartet. Unsere Chefs Johan und Flo sind frisch erholt aus ihrem wohlverdienten Urlaub zurück und ich hege noch die Hoffnung, dass wir die Erholung der beiden nicht gleich in der ersten Woche aufbrauchen :-) Solange die Beiden die freie Zeit genossen haben, haben die anderen Wingmenschen solange die Stellung gehalten, auf Justus achtes Firmenjubiläum angestossen, sich in Kundenprojekten getummelt und um folgende Themen für Euch gekümmert:

-

Anita hat sich Gedanken zu Monitoring gemacht

-

Nils hält Euch über Google Discover auf dem Laufenden

-

Behrend erklärt Euch die nächsten Probleme in der GSC

-

Ich durfte mir das Thema JavaScript, Frameworks und Suchmaschine genauer angesehen

-

Und Johan hat noch Kommentare zu Snippets

|

|

|

I try to Discover

|

|

Google Discover ist hier im Newsletter ja immer mal wieder ein Thema. Falls Du Dich bisher noch nicht damit befasst hast, Dein Wissen auffrischen möchtest oder Du ein paar Grundlagen dazu mit Deinem Team teilen möchtest: Dieser Rundumschlag von Lily Ray sei Dir sehr ans Herz gelegt!

Wie immer gibt es bei Lily Ray einen riesigen Berg an Infos, gut strukturiert und verständlich erklärt. Von den Basics - Was ist dieses Discover eigentlich und wieso ist es für uns SEOs von Interesse? - hin zu tiefergehenden Details - Was sind Ranking-Faktoren in Discover und was kann ich da alles hinsichtlich meiner Performance analysieren? - ist alles dabei.

Dabei betont Lily, wie fragil der schwer analysierbare Discover-Traffic ist und dass man die Inhaltsrichtlinien für Discover einhalten sollte, sonst gibt es eventuell eine Penalty.

Spannend ist die eigene Analyse, die Lily durchgeführt hat, basierend auf 12k URLs aus über 75 Domains. Auf dieser Grundlage hat sie 5 Thesen abgeleitet, die für eine gute Performance in Google Discover von Relevanz sind:

-

Discover Content is highly emotional.

-

Clickbait headlines appear to drive traffic, but be careful not to get a manual action.

-

What works best in Discover might not work at all in regular organic search (and vice versa).

-

Posing questions in headlines appears to drive high CTRs in Google Discover.

-

Content that deeply targets users’ interests performs best in Discover.

Hier findest Du bei Bedarf noch weitere Ausführungen und konkrete Beispiele dazu.

Wenn Du schon dort bist, kannst Du Dir auch die Slides zu Lilys Präsentation von Anfang September auf der DeepSEO Conference anschauen.

An dieser Stelle darf natürlich eine Empfehlung der SEO Meetup Hamburg Ausgabe mit Teresa Wolf nicht fehlen. Da erklärt Teresa nochmal ganz genau, worauf es bei Google Discover ankommt.

A propos Google Discover: Ein neues Feature namens Follow wird derzeit getestet.

Quelle:

developers.google.com

Es ermöglicht eine Art Abo eines Discover Feeds, üblicherweise in Form von RSS oder Atom. Dafür scheinen nur ein paar kleine Code Snippets an der richtigen Stelle erforderlich zu sein. Die ausführlichen Infos nochmal genauer zu betrachten, lohnt sich sicherlich, wenn das Feature es aus der Beta und auch zu uns schafft.

|

|

|

GSC-Faktup 357274734 nicht gelöst, aber geklärt

|

|

Inkonsistent wirkende und tatsächlich inkonsistente Daten in der Google Search Console existieren ja, meiner Vermutung nach, hauptsächlich dafür, um Behrend zu ärgern. Man denke nur mal an den epischen durch die

Canonical Consolidation verursachte Canonical-Hreflang-Fuckup

. Oder Minimum, um möglichst viele Menschen damit zu verwirren. Wie war das nochmal

mit "by Property" und "by URL" Daten

?

Manche Phänomene sorgen erstmal für Unmut, sind dann aber doch irgendwie leicht zu erklären und dann auch nachzuvollziehen.

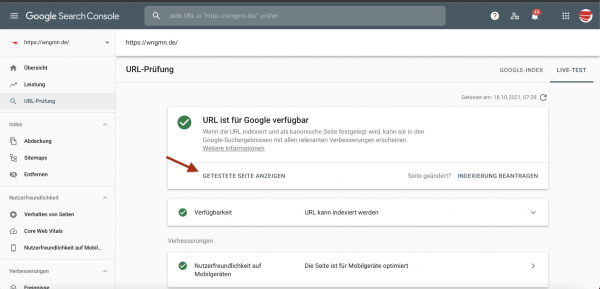

Zum Beispiel gibt es an verschiedenen Orten in der GSC Informationen zum Indexierungsstatus einer URL. Erstmal nicht schlimm. Nur doof, wenn sie sich widersprechen und man keine Ahnung hat, was denn nun stimmt oder warum das so ist.

Im Index Coverage Report gibt es beispielsweise den Status "Crawled - currently not indexed". Also URLs, die der Googlebot sich grundsätzlich schon mal angeguckt hat, aber wohl gerade noch nicht in den Index gepackt hat. Gleichzeitig kann es sein, dass eine URL aus diesem Report im URL Inspect Tool keinerlei Probleme aufweist und "Submitted and indexed" als Status hat. Was soll das? Wie kann das sein? Das haben sich offenbar einige Nutzer*innen nicht nur selbst gefragt, sondern auch direkt an Google reportet.

Diese Erläuterung

dazu, die auf Twitter via Google Search Central veröffentlicht wurde, ist durchaus einleuchtend: Die Daten im Coverage Report werden seltener und langsamer aktualisiert als die, die uns das URL Inspect Tool liefert. Daher kann es sein, dass eine URL im Coverage Report noch den veralteten "Crawled - currently not indexed" Status ausgewiesen bekommt, obwohl die URL mittlerweile in den Index aufgenommen wurde.

Da die Informationen des URL Inspect Tools aktueller sind, sollte man sich in diesem Fall also eher darauf verlassen. Wie so häufig, hat sich an der GSC damit nichts geändert und die Widersprüche sind noch da, aber wir wissen, wo es herkommt und worauf wir achten müssen.

Natürlich kann Google sich nur mit solchen Ungereimtheiten und Daten-Stolperfallen auseinandersetzen, über die Kenntnis besteht. Deswegen ist das Feedback-Formular in der GSC ein wichtiges und nützliches Tool. Daher - mal wieder - der Aufruf: Nutze es!

|

|

|

Javascript oder kein Javascript das ist hier die Frage

|

|

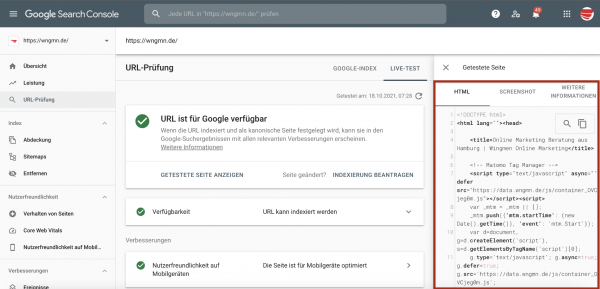

Gefühlt kommt fast jeden Tag ein neues JavaScript-Framework auf den Markt, diese versprechen uns neue tolle Funktionen, Zeitersparnis in der Umsetzung und ganz neue Benutzer-Erlebnisse. Doch wie reagieren eigentliche Suchmaschinen wie Google auf diese Frameworks und Javascripte allgemein? Mit diesen Fragen rund um Frameworks, Javascript und dessen Auswirkungen auf die Suchmaschinen durfte ich mich in der letzten Woche für einen Kundenworkshop auseinandersetzen und auch

Martin und Bartosz luden in der letzten Woche zu einem Webinar

mit genau diesem Thema ein und stellten sich den Fragen der Teilnehmer. Dabei gefiel Johan besonders das Renaming von "JavaScript SEO" hin zu "Rendering SEO", denn so wird viel deutlicher, worauf es eigentlich ankommt: Egal welche Techniken wir anwenden oder in Zukunft anwenden werden: Rankingrelevante Inhalte haben im HTML-Quellcode zu stehen.

Kleine Hilfsmittel

Wenn Du dich fragst, wie es um Eure Website gestellt ist, empfehle ich Dir zwei kleine schnelle Check-ups:

-

Schalte in Deinem Browser doch einfach mal das Javascript ab und schau Dir die Website ohne Javascript an und denke dabei auch unbedingt an die mobilen Versionen der Seite. Was kannst Du noch sehen?

-

Prüfe in der GSC einmal die wesentlichen URLs deiner Website und schaue Dir dabei den HTML-Quellcode an, der dem Googlebot ausgeliefert wurde.

Kurz zusammengefasst gilt

-

Alle für das Ranking relevante Inhalte müssen schon im HTML-Quellcode vom Webserver ausgeliefert werden

-

Einmal ausgelieferte Inhalte wie z.B. der Seitentitel, die Meta-Description, Überschriften usw. sollten nachträglich nicht mehr durch Javascript verändert werden

Kommen moderne Frameworks wie Angular, Vue.js & Co. ins Spiel, bei denen ich keinen (oder nur schwer) Einfluß auf den HTML-Quellcode habe, ist ServerSideRendering (SSR) Pflicht. Dabei entscheidet SSR maßgeblich den SEO-Erfolg (oder Flop) und deswegen sollte man hier genügend Zeit zum Testen und für Korrekturschleifen einplanen.

|

|

|

Kommentare zu Snippets, Snippets zu Kommentaren

|

|

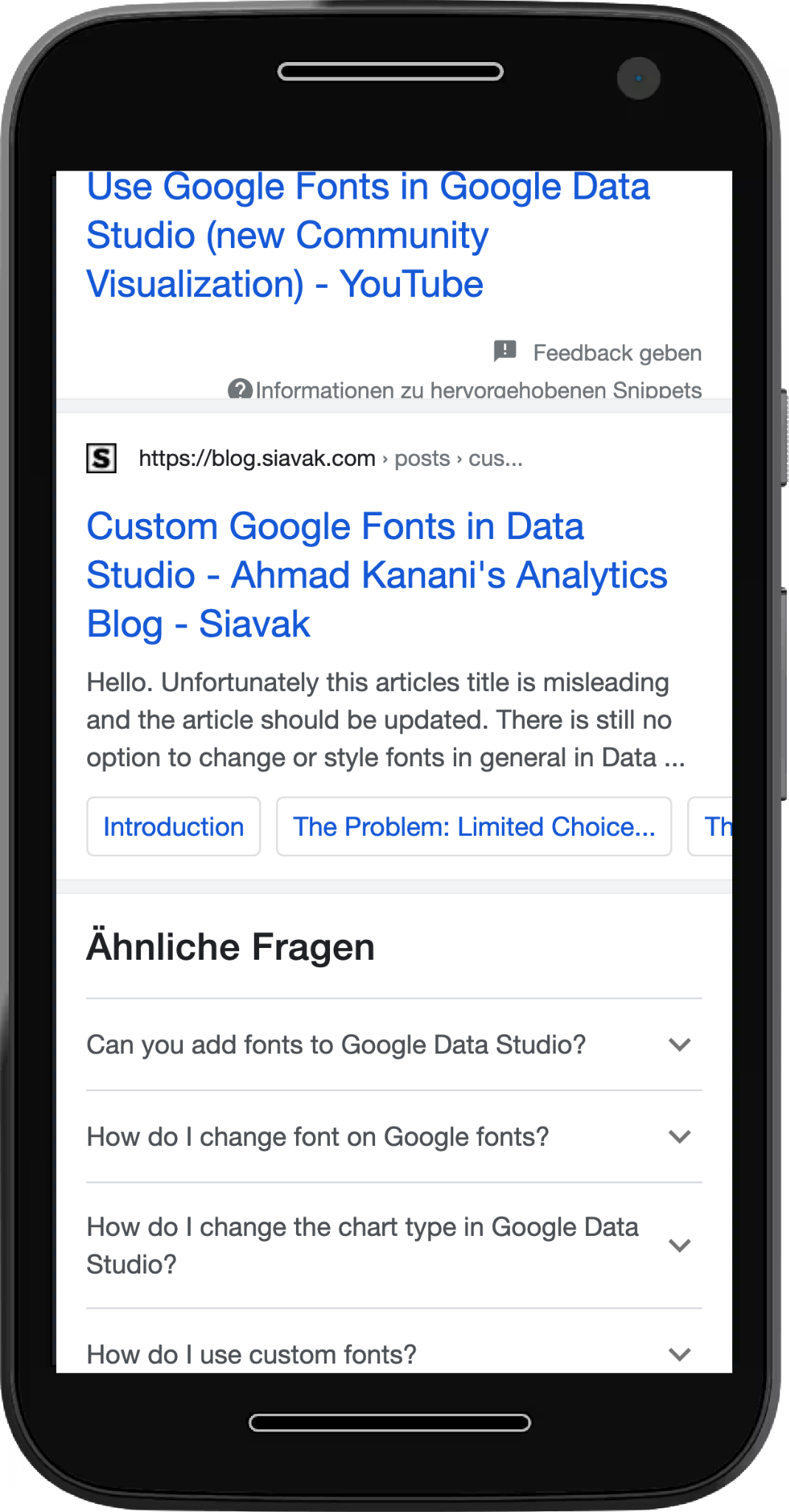

Behrend hat neulich schon gezeigt, wie es aussieht, wenn

Google das Cookie Banner im Snippet darstellt

.

Auf Twitter sind wir diese Woche auf dieses wunderschöne Beispiel gestoßen,

wie Google Kommentare als Description im Snippet einbaut

. Das zeigt aber auch, dass Kommentare nicht nur für das Nutzer-Engagement hilfreich sind, sondern sie können auch ein Ranking-Asset sein.

Ich habe mir deshalb noch einmal Gedanken zu SEO-freundlichen Kommentaren gemacht:

-

Die Moderation kostet Arbeit, aber ist Pflicht, damit es funktioniert. Ungepflegte Kommentare sind gefährlich und sollten lieber garnicht erst ermöglicht werden. Insbesondere bei politisch brisanten Themen ist es auch bei der besten Moderation häufig ratsam, die Kommentare für einzelne Artikel zu deaktivieren. Eine entsprechende Funktion zum Deaktivieren muss für die Moderatoren verfügbar sein.

-

Links wollen in den Kommentaren natürlich als

User Generated Content (oder zumindest nofollow)

ausgezeichnet sein.

-

Wenn jetzt noch Entwickler-Kapazitäten frei sind, können wohl-moderierte Kommentare

in den strukturierten Daten ausgezeichet

werden.

In einer perfekten Welt kannst Du Kommentare nicht nur moderieren und deaktivieren, sondern auch selektiv mit einem

data-nosnippet-Attribut

aus den SERPs tilgen, ohne die Kommentare gleich komplett zu deaktivieren. Für viele Seiten lohnt der Aufwand bei der geringen Anzahl an Kommentaren nicht, da es eher selten vorkommen wird, dass Dein Snippet so unvorteilhaft wie im Beispiel aussieht..

Und mal ehrlich, solch einen fantastischen Clickbait, wie das Beispiel (

das gestern übrigens noch live funktioniert hat

), bekommt man gezielt nur selten in die SERP.

|

|

|

Termine, Termine, Termine

|

|

Es ist mal wieder Zeit für das SEO Meetup Hamburg: Heute Abend gibt es die 66. Ausgabe. Stefan Rudolph und Boris Bamberger bringen eine Case Study zum Thema "Die Local SEO Strategie von McMakler 2021" mit.

Zur Anmeldung bei Meetup geht es hier.

Dort werdet ihr auch den Link zum Stream finden. Wir freuen uns auf Dich!

|

|

|

|

Fragen? Immer gerne fragen!

|

Wir sind für Dich da.

Schreib uns gern jederzeit

eine E-Mail an

[email protected]

oder

ruf uns einfach kurz an:

+49 40 22868040

Bis bald,

Deine Wingmen

|

|

Anckelmannsplatz 1, 20537 Hamburg, Germany

|

|