| Wirklich wahres Wingmen SEO Wissen für wache Webmarketer #265 |

|

|

| 🔱 SEO-Halbgötter in Braunschweig |

Ich habe Dir heute neben dem obligatorischen Käffchen ein zweites Frühstück ans Bett gestellt: ein göttliches Recap unseres Offsites in Braunschweig. Zwischen Löwenstatue und Fachwerkfassaden jagten wir zunächst in vier Teams bei unserem Teamevent, einer iPad-Rallye, durch die Innenstadt Braunschweigs. Wir beantworteten knifflige Fragen, lösten Rätsel und legten virtuelle Fallen für die gegnerischen Teams aus. Es war ein Kopf-an-Kopf-Rennen auf der Punktetabelle.

Die Wingmenschen aus dem Siegerteam der iPad-Rallye wurden von unserer Eventführerin Dörte übrigens als “Halbgötter” ausgerufen. Eine Titulierung, die intern hartnäckig ignoriert wird, extern aber gern aufgegriffen werden darf.

Frisch gelüftet ging es für uns danach in unser Offsite-Kämmerlein, wo wir uns den Themen SEO, GEO, aber vor allem Chancen angenommen haben. Es lässt sich ein klares Resümee aus unseren Sitzungen ziehen: Wir haben Appetit bekommen!

Unsere mutigen Helden haben diese Woche folgende Themen für Dich bekämpft:

- Saskia über die verborgenen Gefahren von Cloudflare

- Nora schießt ihren Pfeil ins Auge des Wegwerfcontents

- Hannemann verfasst die Epen von Google & ChatGPT

- Behrend über das goldene Vlies der GSC Daten

- Lara entlarvt den trügerischen Multitasking-Mythos

Viel Spaß beim Lesen!

Deine Wingmenschen

|

|

| Take good care while using Cloudflare ☁️ |

Nutzt Du Cloudflare? Oder vielleicht Deine Kunden? Freunde? Bekannte?

Ehrlich gesagt: Wer genau es nutzt, spielt gar keine so große Rolle.

Denn aus unserer Sicht ist es für ALLE relevant, dass man mit dem Cloudflare AI Audit Feature den Google-& BingBot blocken kann und damit Googles organischen Index von der eigenen Seite aussperrt.

Wait what??

Ja, wir waren auch erstmal skeptisch – und haben’s getestet.

Aber bevor wir zum Ergebnis kommen, lass uns kurz vorne anfangen, denn wir müssen vorab zwei Cloudflare Funktionen voneinander abgrenzen:

AI Audit (Worum es in unserem Test gehen wird) und dem neuen Security Bot Blocking Feature

Das Security Bot Blocking Feature

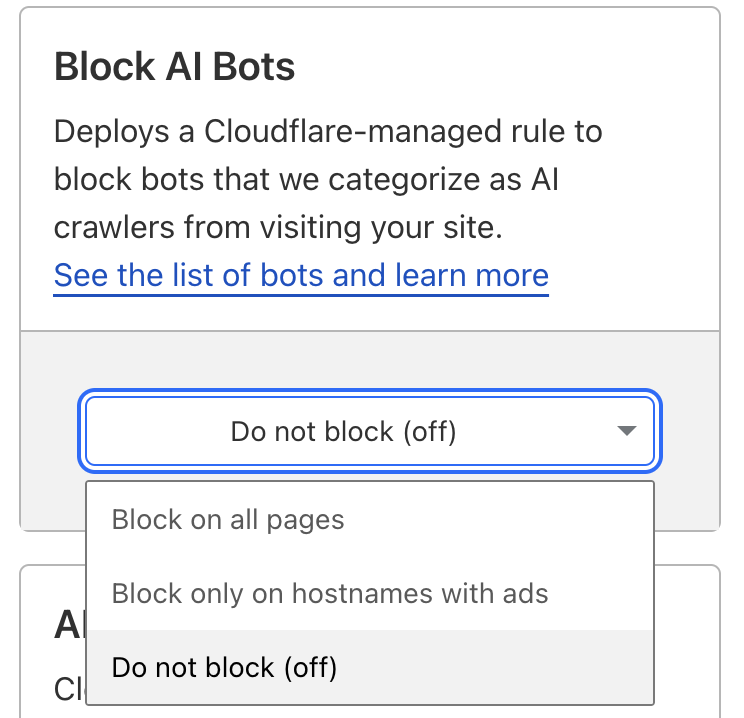

Dieses Feature ermöglicht es einem, AI Bots zu blockieren. Mittels Dropdown kann ausgewählt werden, ob man das für alle Seiten, nur Hostnamen mit Ads oder gar nicht möchte.

Ansicht: Cloudflare Security Bot Blocking

Ansicht: Cloudflare Security Bot Blocking

Dieses Feature ist standardmäßig aktiviert für neue Accounts. Die Bots, die dadurch blockiert werden, kannst Du zum einen in der Doku von Cloudflare zu AI Bots und, weil in dieser ersten Ansicht nicht alle Bots aufgeführt sind, auch noch einmal im Cloudflare Radar > Bots > Traffic > Directory, einsehen.

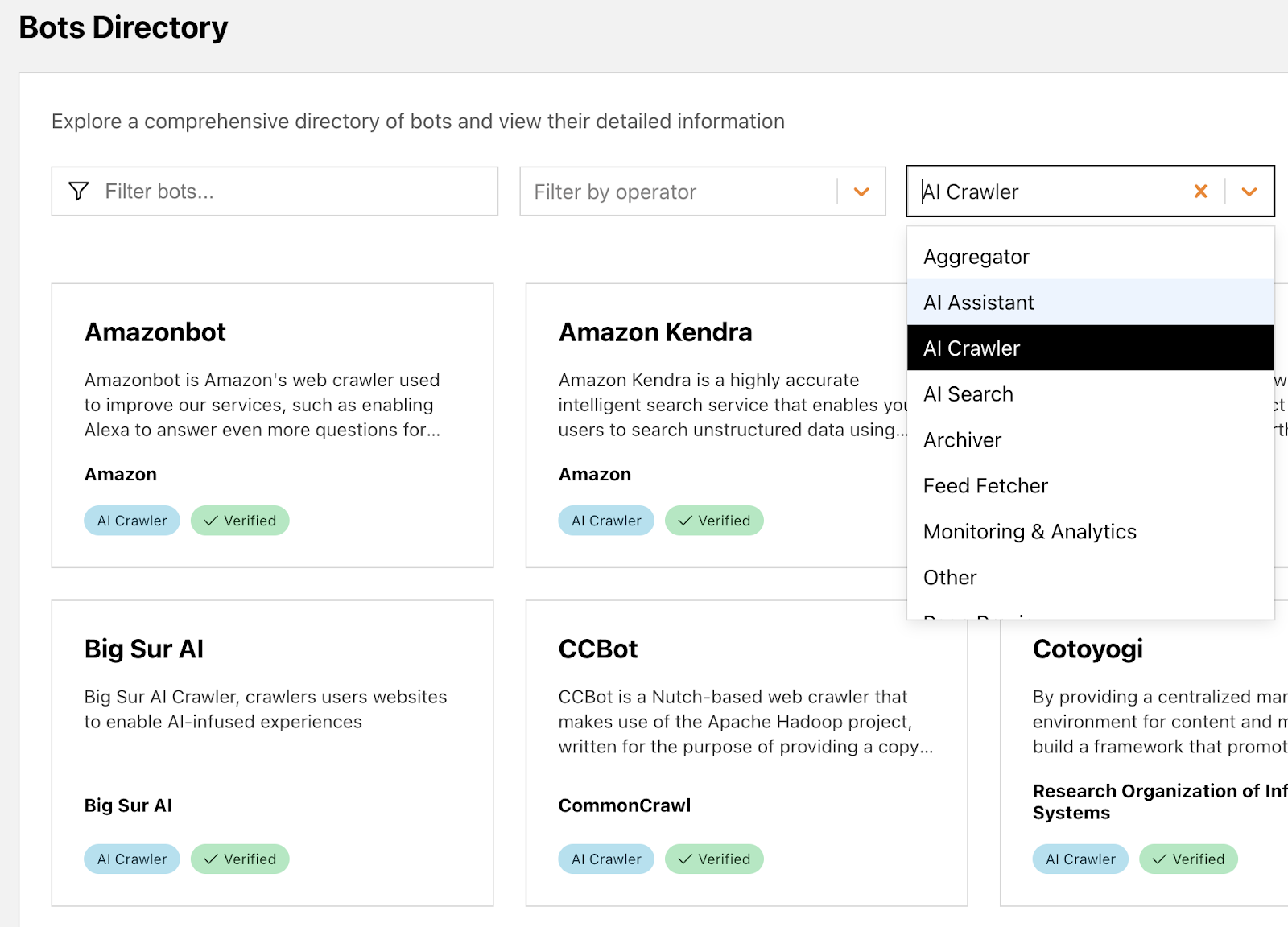

Setzt man hier den Filter auf

- AI Assistant

- AI Crawler

- AI Search

so bekommt man eine zusätzliche Übersicht darüber, welche Bots außerdem geblockt werden.

Ansicht: Cloudflare Bots Directory

Ansicht: Cloudflare Bots Directory

Wie sinnvoll das ist, da Cloudflare mit Shopify kooperiert und dadurch neue Shops im Standard erstmal auf Block stehen, wie auch Kevin Indig bestätigt, das ist Thema für einen eigenen Artikel.

Nun also zu dem zweiten, bereits länger bestehenden AI Audit Bericht.

Was genau kann der AI Audit Bericht?

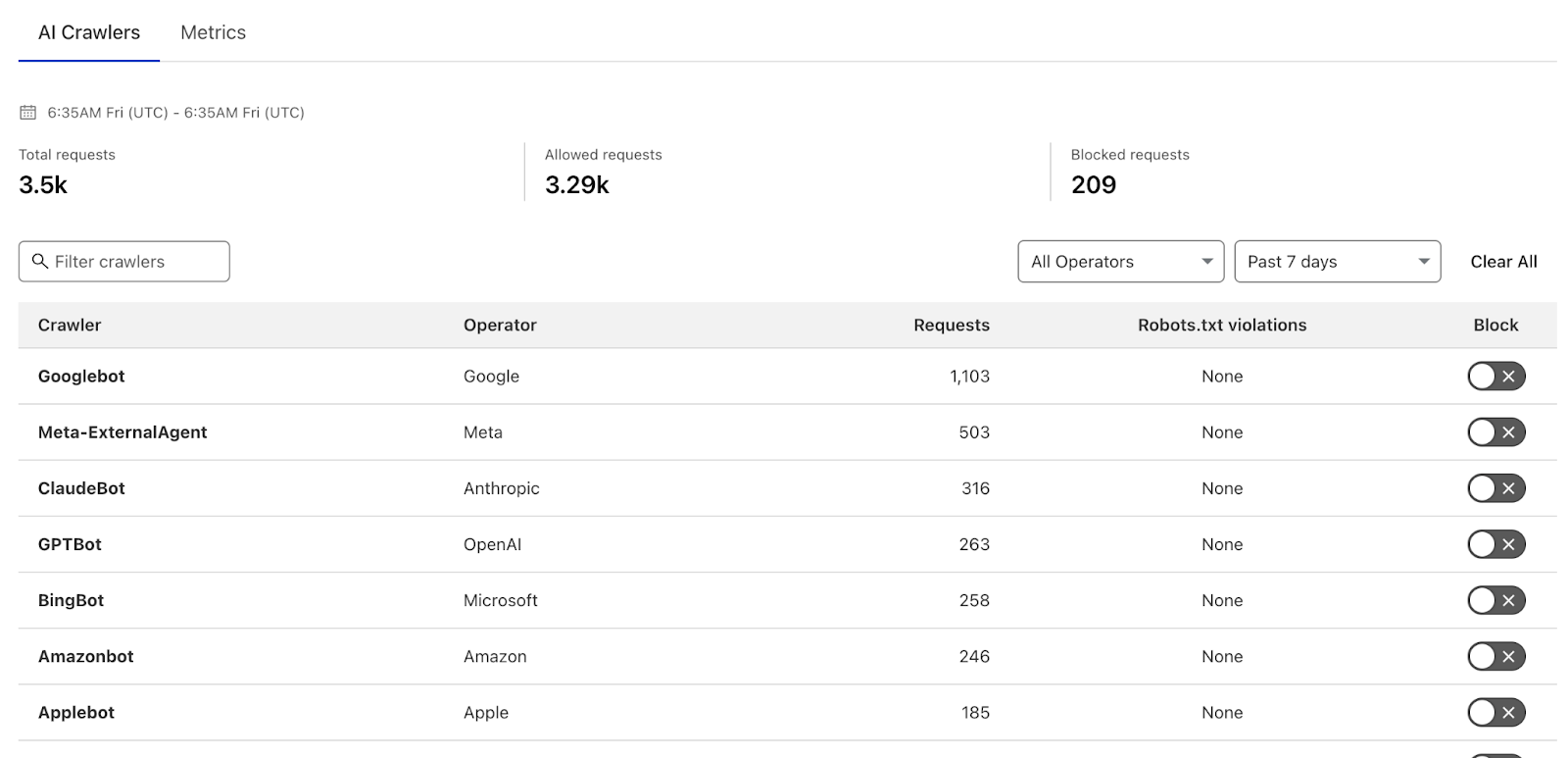

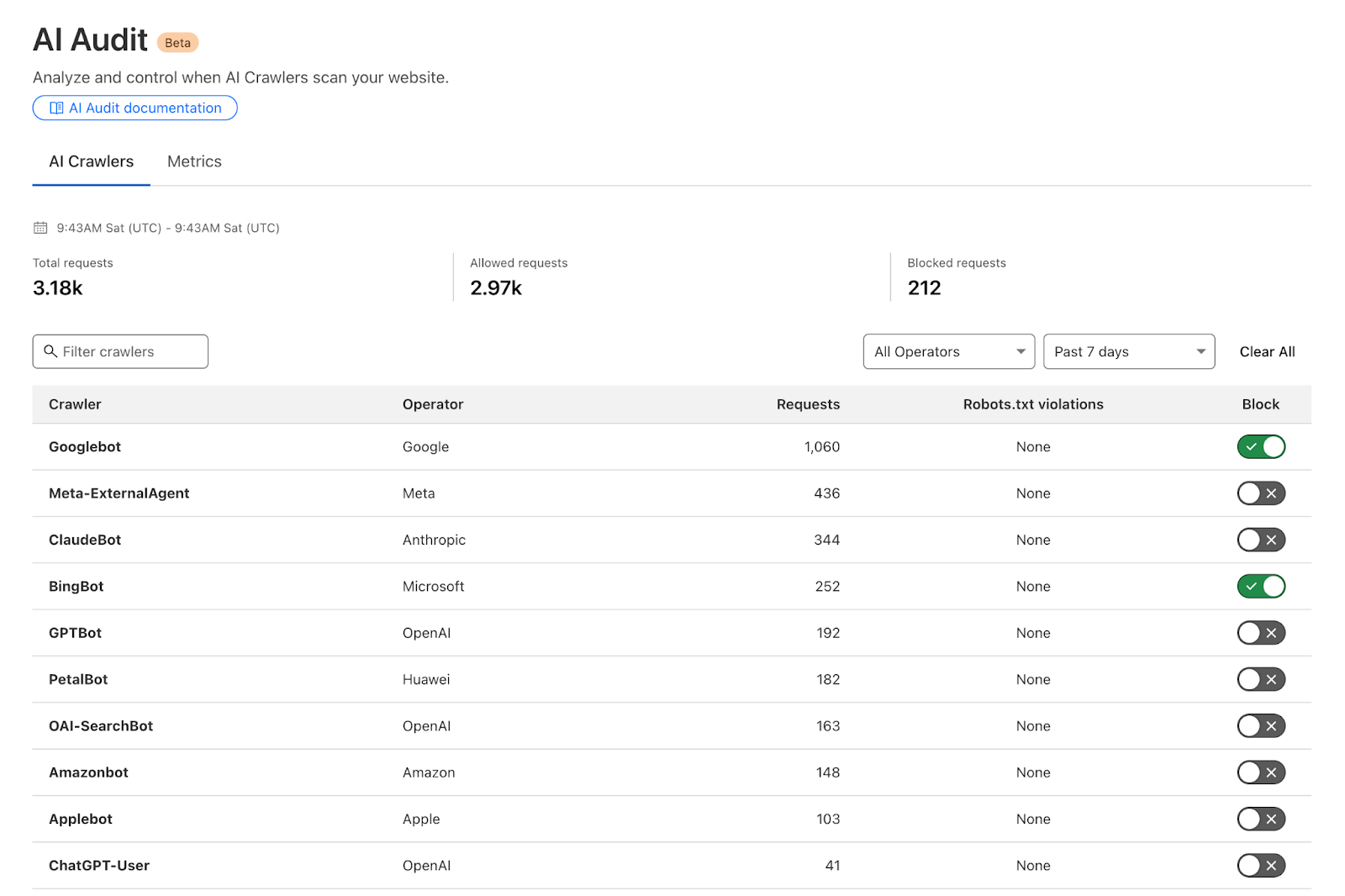

Cloudflare bietet einen Bericht an, er nennt sich AI Audit, aus dem sich ablesen lässt,

- wie viele Zugriffe (Hits) welcher Bot erzeugt und

- ob diese Zugriffe gegen die Angaben in Deiner robots.txt verstoßen.

Außerdem lassen sich gezielt Bots blockieren, mittels Kippschalter, und diese werden damit technisch komplett blockiert:

Ansicht: Cloudflare Feature Bot Blocking

Ansicht: Cloudflare Feature Bot Blocking

In dieser Liste befinden sich, im Gegensatz zum Security Feature, auch der Google- und der BingBot.

Die unangenehme These:

Hakt man diesen Kippschalter an, weil man denkt, man würde innerhalb des AI Audits “testen” oder “probieren” und lediglich AI-Bots ausschließen, kann es passieren, dass man sich über kurz oder lang, ganz aus dem Google Index katapultiert.

Wie kommen wir darauf?

Schaut man auf die Funktionsweise des Googlebot-Extended, der zuständig ist für Trainingsdaten, dann sagt Google selber darüber folgendes

“Google-Extended doesn’t have a separate HTTP request user agent string.

Crawling is done with existing Google user agent strings; the robots.txt user-agent token is used in a control capacity.”

Ergo: Googles GoogleBot-Extended stellt keine HTTP-Requests.

Wir hätten also hier einen Bericht, der unsere Seite von der Indexierung ausschließen kann, ohne einen Disclaimer, der uns anschreit, damit wirklich aufzupassen…

Klingt wild, oder? Das fanden wir auch, also haben wirs getestet

Das Testsetup

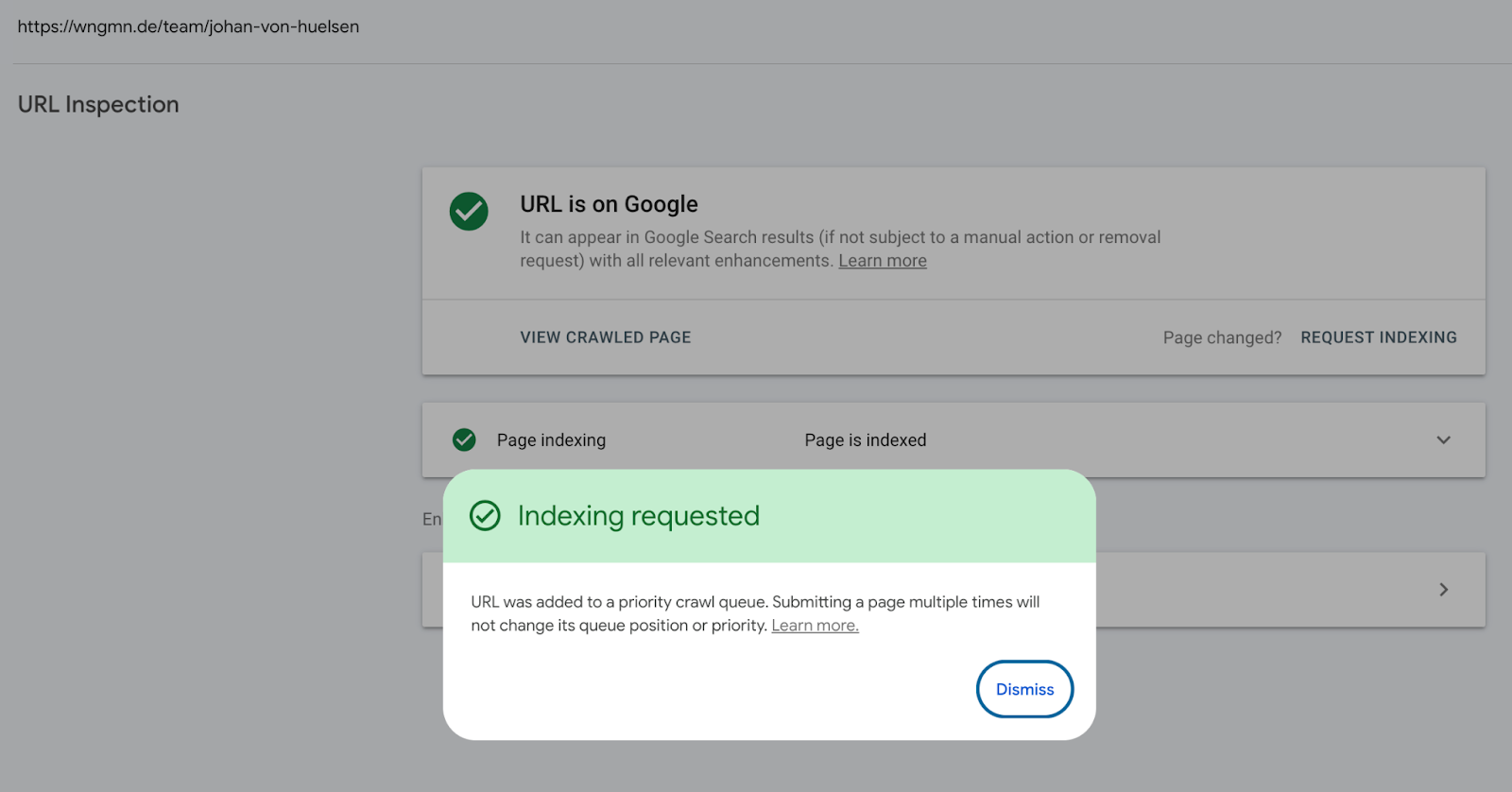

Um 11:43 Uhr am Samstag hat Johan das Blocking des Googlebots und des Bingbots im AI Audit live gestellt

Ansicht: Cloudflare Feature Bot Blocking

Ansicht: Cloudflare Feature Bot Blocking Anschließend hat er einen Indexing Request für seine Team Page gestellt

Ansicht: Search Console URL Inspection der https://wngmn.de/team/johan-von-huelsen

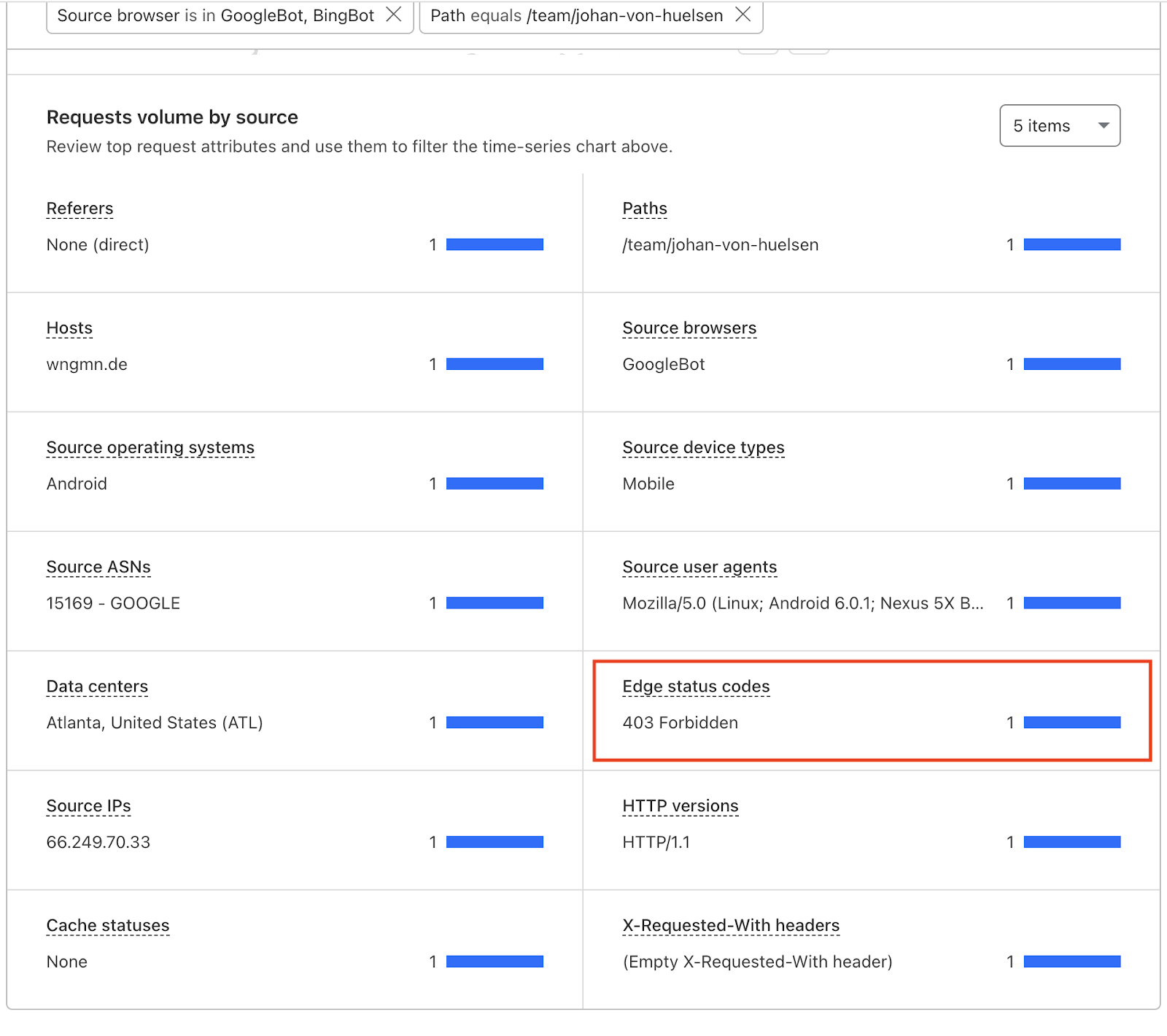

Ansicht: Search Console URL Inspection der https://wngmn.de/team/johan-von-huelsen Und siehe da: Googlebot bekommt einen 403er zurückgeliefert. Sprich, der Bot wird ausgesperrt.

Ansicht: Cloudflare “Requests volume by Source, Setup: Source Browser = GoogleBot, BingBot & Page ist die Teamseite von Johan

Ansicht: Cloudflare “Requests volume by Source, Setup: Source Browser = GoogleBot, BingBot & Page ist die Teamseite von Johan

Was bleibt unterm Strich?

- Dieser Bericht ist nicht nur eine Übersicht, wie man zunächst denken könnte und auch kein reines AI-Bot-Blocking, denn es betrifft ganz konkret auch Suchbots.

- Wer Cloudflare nutzt und innerhalb dieses Berichts sich bewegt, läuft Gefahr gleichzeitig Googles organischen Index von der eigenen Seite auszuschließen.

Was bedeutet das für Dich?

Wenn Du oder Deine Kunden Cloudflare nutzt, solltest Du genau hinschauen und ein paar Dinge im Hinterkopf behalten:

- Sei sensibel mit dem Blocken von Bots mittels Cloudflare, egal in welchem Feature oder Bericht

- Check Dein Setup und das Deiner Kunden

- Treten plötzlich Indexierungsprobleme auf, könnte dieser Bericht der Grund sein

Falls Du Support beim challengen Deines Set-ups brauchst, melde Dich gerne bei uns! 📬

|

|

| Schluss mit Wegwerf-Content: Aktionsseiten strategisch nutzen 🎯 |

Der Umgang mit Aktionsseiten ist aus SEO-Sicht manchmal gar nicht so einfach. Oft hängt das Thema an vielen verschiedenen Befindlichkeiten:

- Kampagnenverantwortliche brauchen maximale Flexibilität,

- Stakeholder wollen schnelle Sichtbarkeit,

- und SEO denkt sich leise: "Und was passiert mit der Seite danach?"

Ich kenne das aus dem Beratungsalltag nur zu gut. Gerade bei wiederkehrenden Aktionen wie Black Friday, Singles’ Day oder Osterangeboten werden die Seiten jedes Jahr neu gebaut, weil sie genau dann gebraucht werden. Aber geht das nicht besser?

Spoiler: Es gibt nicht den einen richtigen Weg, aber es gibt definitiv bessere Strategien als den „Wegwerf-Content“-Ansatz.

Typen von Aktionsseiten

Grundsätzlich müssen wir zwei Typen von Aktionsseiten unterscheiden:

- Einmalige Aktionen wie z. B. eine Jubiläumskampagne, ein temporärer Sortiments-Sale oder eine spontane Kooperation. Beispiel: AEG-Traumsommer.

- Wiederkehrende Aktionen, alles, was jedes Jahr (oder sogar mehrfach jährlich) stattfindet. Klassiker: Black Friday, Valentinstag, Ostern oder Back-to-School. Beispiel: Singles Day bei Nordic Nest.

Warum das wichtig ist? Weil sich daraus unterschiedliche Strategien für Weiterleitung, Contentpflege und Deine Seitenarchitektur ergeben.

Einmalige Aktionen: Nach dem Hype wird aufgeräumt 🧹

Nach Ablauf des Aktionszeitraums solltest Du aufräumen. Wenn es ein passendes Weiterleitungsziel gibt, etwa eine passende Kategorieseite oder ein Sale-Angebot, leite die Seite per 301 weiter. Gibt es kein passendes Weiterleitungsziel, sei ehrlich und sage per 404/410: Diese Seite gibt es nicht mehr. Unabhängig davon, ob Du weiterleitest oder löscht – die Seite sollte aus der internen Verlinkung verschwinden.

Bonus-Tipp: Manchmal braucht es für einmalige Aktionen gar keine eigene Seite. Wenn es z.B. auf Dyson Ventilatoren Rabatt gibt, reicht es vielleicht, auf der Ventilatoren-Kategorieseite mit einem entsprechenden Banner zu arbeiten und das Sorting anzupassen.

Wiederkehrende Aktionen: Evergreen statt Mülleimer

Aktionsseiten, die jedes Jahr gebraucht werden, sollten bleiben. Warum?

- Eine URL, die regelmäßig gepflegt wird, baut Sichtbarkeit auf und muss sich nicht jedes Jahr neu beweisen.

- Auch wenn die Seite gepflegt werden muss – sie muss nicht jedes Jahr von Scratch neu gebaut werden. Häufig reicht es, kleinere Dinge anzupassen. Das spart Ressourcen.

- Nur weil der Black Friday im November stattfindet, heißt das nicht, dass nur im November danach gesucht wird.

Laut Sistrix hatte „black friday“ allein im Juli 2024 rund 23.300 Suchanfragen. Noch spannender wird’s bei Brand-Kombis:

- „formel skin black friday angebot“ hatte im Mai Ø 4.300 Suchen

- „otto black friday“ im selben Monat Ø 1.150 Suchen

Das heißt: Die Nachfrage existiert – auch ohne laufende Aktion. Und genau das sollten wir SEO-seitig nutzen.

Kein Angebot? Kein Problem! Content-Ideen für Off-Season-Phasen

Auch ohne laufende Aktionen kann Dein Content gut performen. Ein tolles Beispiel liefert MediaMarkt:

- Ein kurzer Einleitungstext informiert über die nächsten Aktionszeiträume

- Die Seite dient als Hub für die interne Verlinkung zu aktuell beliebten Produkten

- Micro-Conversions werden eingebaut, z. B. eine Newsletter-Anmeldung

- Am Ende gibt es ein FAQ mit den wichtigsten Fragen rund um Black Friday

Ebenfalls gelungen finde ich die Black Friday Seite von Bergfreunde. Hier liegt der Fokus noch etwas mehr auf der Stärkung relevanter Kategorieseiten.

Was ich jetzt machen würde

- Aktionskalender aufstellen und regelmäßig wiederkehrende Aktionen identifizieren

- Bestehende Seiten prüfen. Was kann weiterverwendet oder umgebaut werden?

- Off-Season-Content planen (FAQs, Teaser, Conversions)

- Evergreen-Inhalte intern verlinken & regelmäßig optimieren

Besonders im E-Commerce werden Kampagnen mal eben “on the fly” gebaut und das ist vollkommen okay. Aber bei wiederkehrenden Aktionen lohnt sich eine langfristige Denkweise, denn:

- Starke URLs performen besser, je älter sie sind,

- Suchintents enden nicht mit der Aktion,

- Conversion-Ziele gibt’s auch ohne Sale.

Wenn Du möchtest, helfe ich Dir gern beim Sortieren oder wir entwickeln gemeinsam ein Framework, das sowohl SEO als auch Deine Kampagnenmenschen glücklich macht. 🤝

|

|

| Nutzt ChatGPT heimlich Google? |

Es ist bekannt, dass OpenAI Bing für die Suchanfragen in SearchGPT benutzt. Inzwischen ist allerdings fraglich, ob Bing überhaupt noch die Hauptquelle ist.

Der SEO-Experte Alexis Rylko hat das vor kurzem in seinem Newsletter „SEO, Data & Growth“ untersucht. Dafür analysierte er die Query Fanouts, die SearchGPT bei einer Suchanfrage sendet und legte diese gegenüber mit den SERPs aus der direkten Suche. Die Daten zeichnen ein klares Bild:

- Treffer-Übereinstimmung: Über 90 % der von ChatGPT zitierten URLs stammen aus Googles Top-Ergebnissen. Bei Bing lag die Übereinstimmung bei nur 30 %.

- Snippets: Die Snippets in den Antworten stimmen exakt mit denen aus Googles Ergebnisdarstellung überein, nicht mit Bings.

- Datumsformat: Das Veröffentlichungsdatum erscheint mit dem selben Unix-Zeitstempel wie bei Google.

- JS-Inhalte: Auch Inhalte, die per JavaScript geladen werden, tauchen in Antworten auf. Das funktioniert über eine von ChatGPT gesendete “site:”-Abfrage. Da Bing historisch gesehen öfter Schwierigkeiten mit JavaScript hat, legt auch das die Verwendung von Google nahe.

- Tracking-Parameter: Viele Links enthalten Googles typischen ?srsltid-Parameter.

- Bevorzugte Quellen: Plattformen wie Reddit werden auffällig oft zitiert. Etwas, das wir auch sehr gut von Google kennen.

Wenn Du mehr darüber lesen möchtest, wie Alexis das untersucht hat, empfehle ich Dir sehr, seinen Artikel dazu zu lesen.

Warum wechselt ChatGPT von Bing zu Google?

Ein möglicher Grund ist, dass Microsoft die Bing Search API abstellt. Das heißt, Partner können diese nicht weiter nutzen oder müssen über Azure zugreifen. Möglicherweise hat OpenAI Sonderrechte, doch dazu hat sich keine der beiden Firmen bisher geäußert. Andere News deuten auch nicht darauf hin:

Eine Neustrukturierung des Vertrags zwischen OpenAI und Microsoft ist seit längerem im Gespräch und hat in der Vergangenheit wohl schon für einigen Streit zwischen den Parteien gesorgt. Die Gründe dafür sind vielfältig. Microsoft ist als Investor mittlerweile tiefer in OpenAI verankert, als die Firma es wünscht. Dadurch, dass OpenAI eine Umstrukturierung zu einem For-Profit Unternehmen anstrebt, wird es zwangsläufig zu einer Umverteilung kommen, was die Debatte anheizt.

Zusätzlich dazu plant OpenAI laut The Verge ein Open-Weight-Sprachmodell, das nicht nur auf Azure, sondern auch über Drittplattformen wie Hugging Face verfügbar sein soll. Damit öffnet sich OpenAI bewusst für Alternativen und wendet sich von Microsoft ab.

OpenAI will in Kürze auch selbst einen Browser launchen. Laut eigenen Angaben, um mit Chrome in Konkurrenz zu treten. Doch für Microsofts Bing wird das auch keine erfreuliche Wendung sein.

Neben den vertraglichen Fragen gibt es natürlich noch eine weitere Möglichkeit: Google liefert schlicht die besseren Ergebnisse. Schnellere Indexierung, präzisere Snippets, besseres Verständnis von JavaScript. Wenn OpenAI Nutzererfahrung am Herzen liegt, könnte sie das überzeugt haben.

Was bedeutet das für Dich als SEO?

Ob OpenAI komplett auf Google gewechselt hat und was die Gründe sind, ist zwar nicht ganz klar, aber als SEOs können wir trotzdem etwas daraus mitnehmen:

- JS-Inhalte müssen für Google verständlich sein, dann landen sie auch in ChatGPT

- Klar strukturierte und ansprechende Snippets lohnen sich, denn ChatGPT übernimmt sie direkt aus den Suchanfragen

- GEO ist SEO: Gute Platzierungen bei Google bedeuten gute Chancen auf Sichtbarkeit in generativen AI-Antworten.

Fazit: Konzentriere Dich weiter auf Google und Du bist auch in den generativen Anfragen von ChatGPT vorne dabei.

|

|

| Deine GSC Daten sind Gleich aber manche sind Gleicher |

Weil ich neulich mal wieder unnötig viel Zeit damit verbracht habe, Diskrepanzen zwischen einer GSC-API-Abfrage und der Darstellung im GSC Frontend zu debuggen, sei es hier noch einmal notiert:

Die GSC-API gibt die exakt gleichen Daten aus wie das GSC-Frontend. Immer. Keine Ausnahmen. Nicht mal klitzekleine.

Wenn es einen Unterschied gibt, dann weil die Filter unterschiedlich gesetzt sind.

Weil es an dieser Aussage doch immer mal wieder Zweifel gibt, habe ich eine Liste von Prüfschritten geschrieben, um die Quelle für Abweichungen zu finden., Die Liste ist nach der gefühlten Häufigkeit und Prüf-Einfachheit der Abweichungen sortiert, gewichtet nach Behrends besonders berufserfahrenem Bauchgefühl (höchst zuverlässige Metrik, wenn ihr mich fragt):

1. Parallele Property-Paare

Vergleichst Du gerade versehentlich eine Domain-Property mit einer URL-Prefix-Property? Oder eine Folder-Property mit einem URL-Filter?

Ja? Ärgere Dich nicht, das passiert ständig. Andernfalls gucken wir weiter:

2. Defekte Daten

Insbesondere tückisch, wenn Du das Frontend auf Englisch benutzt und Daten in den ersten 12 Tagen des Monats abrufst, weil die Amis ja darauf bestehen, das Datum falsch herum zu notieren. Merke: 05.06.2025≠ 05/06/2025. Warum das Frontend nicht konsequent das universelle, von der ISO 8601 empfohlene "YYYY-MM-DD"-Format verwendet, ist mir ein Rätsel.

Und auch sonst kommt es schnell mal vor, dass der Zeitraum nicht exakt gleich abgefragt wurde.

Du erkennst Dich in diesem Szenario wieder und glaubst, dass ich an die Situation gedacht habe, als ich Dich das eine mal auf genau diesen Fehler hingewiesen habe? Damit liegst Du vielleicht richtig, aber es gibt mehrere Menschen, die ich schon einmal auf diesen Fehler hingewiesen habe. Du bist also in guter Gesellschaft.

3. Filter Fauxpas

Sind ansonsten die gleichen Filter eingestellt? Also wirklich exakt die gleichen? Gleicher Query Filter, gleicher Page Filter, gleiche Filter für Country, Search Appearance, Device?

Auch nicht der Fehler? Na gut, nächster Punkt:

4. Dimensions-Debakel

Fragst Du die gleichen Dimensionen ab? Wenn Du Dir die Queries ausgeben lässt, oder einen Filter auf Queries setzt, werden die anonymized Queries von der Ausgabe ausgeschlossen.

Achtung: Wenn Du im Frontend die Keyword Tabelle anguckst, sind ohne einen Query-Filter die aggregierten Zahlen oben noch ungefiltert, während in der Tabelle nur die ersten 1000 Keywords ausgegeben werden. In der API werden alle Keywords ausgegeben (bis zum API Limit von 50000 Zeilen).

Analog gilt das Gleiche für die Page-Dimension: Beliebt ist hier zum Beispiel der Vergleich eines Page-Filters auf einen Folder mit einer Folder-Property.

Die Daten passen natürlich auch hier nicht zusammen, denn wir vergleichen byProperty- mit byPage-Logik (es sei denn, Du setzt in der Folder-Property zusätzlich einen Page-Filter…).

Aber eigentlich ist Dir das ja schon beim ersten Check aufgefallen, oder?

Dimensionen stimmen alle überein? Dann wars vielleicht:

5. Fehlende Finalität

Vergleichst Du Daten der letzten Tage? Dann sind die vorläufigen Daten der GSC vielleicht das Problem. Das Frontend zeigt, wenn das gestrige oder heutige Datum in der date-Range ausgewählt wurden, preliminary data an.

Die API dagegen zeigt per default nur die finalisierten Daten an und lässt die Daten von gestern und heute weg, selbst wenn Du als endDate ein aktuelles Datum vergeben hast. Um hier Preliminary Data mit einzubeziehen, musst Du "dataState" extra mit angeben.

Auch nicht der Grund für Deine Daten-Diskrepanz? Nächster Check:

6. Untypische Types

Das kommt zugegebenermaßen selten vor/merkt man schnell, aber vergleichst zufällig gerade Äpfel mit Birnen Websuche mit Bildersuche, oder Discover mit googleNews, oder sowas? Dann passt natürlich vorne und hinten nix zusammen.

Gut, der ist ziemlich offensichtlich... wenns das war, kommst Du Dir vermutlich gerade blöd vor. Mir geht es zumindest immer so, wenn mir das passiert :D

Wenn es das auch nicht war, ist es dann vielleicht das hier:

7. Big Query-Banalitäten

Exakt gleich sind nur GSC-API und GSC-Frontend. Der BigQuery Bulk Data Export der GSC weist tatsächlich mehr Daten aus. Über die Unterschiede zwischen GSC Frontend/API-Daten und denen aus Big Query könnte ich einen eigenen Artikel schreiben...

Ups, das ist ja gar kein Checklisten Item sondern ein Teaser für den nächsten Newsletter... Naja, was soll ich sagen... ¯\_(ツ)_/¯

Aber wenn Du wirklich API-Daten mit dem Frontend vergleichst und nicht Bulk Export Daten…, dann:

8. Behrend behauptet Bockmist

Du hast alles geprüft und Deine GSC-API-Daten passen wirklich nicht mit den Frontend-Zahlen zusammen? Es scheint Dir, dass Ich falsch liegen könnte (so unrealistisch Du es auch findest)?

Dann melde Dich gerne bei mir! Ich nehme mir gerne die Zeit, um mit Dir auf Deine Daten zu gucken, alles zu prüfen und Dich eines Besseren zu belehren (oder vielleicht mich? Wollen wir wetten? Wenn wir doch eine Diskrepanz finden, die sich nicht erklären lässt, dann schulde ich Dir ein Bier/Kaffee/Keks/eins der letzten 403 Forbidden SEO-Spiele/o.Ä. und eine Richtigstellung im Newsletter).

|

|

| Multitasking: Warum es sich produktiv anfühlt, aber ineffizient ist |

Mails beantworten, während man an der nächsten Präsentation feilt, mit einem halben Ohr im Call hängen, nebenbei eine To-Do-Liste aktualisieren und vielleicht noch schnell den Slack-Status ändern. Willkommen im Arbeitsalltag 2025. Multitasking ist längst zum Synonym für Effizienz geworden. Es vermittelt das Gefühl, besonders viel zu schaffen, besonders schnell zu sein.

Doch genau hier liegt das Problem: Multitasking fühlt sich produktiv an, ist es aber nicht.

Der Mythos vom parallelen Denken

Unser Gehirn ist schlichtweg nicht fürs echte Multitasking gemacht. Was wir im Alltag als „gleichzeitiges Arbeiten“ erleben, ist in Wirklichkeit ein ständiges Hin- und Herspringen zwischen Aufgaben. In der Neurowissenschaft spricht man von Task Switching. Und jedes Umschalten kostet Energie. Studien zeigen: Wer häufig zwischen Tätigkeiten wechselt, braucht im Schnitt bis zu 40 % mehr Zeit und macht mehr Fehler.

Der Grund dafür liegt im präfrontalen Kortex, der für komplexe Denkprozesse, Entscheidungsfindung und Konzentration zuständig ist. Bei jedem Aufgabenwechsel muss dieser Bereich die neue Information „hochfahren“, während der vorherige Kontext „geparkt“ oder vergessen wird. Dieser mentale Wechsel ist wie ein ständiges Ein- und Aussteigen aus einem fahrenden Zug. Anstrengend, unökonomisch und auf Dauer ziemlich zermürbend.

Kleine Reize, große Wirkung

Warum tun wir’s dann trotzdem?

Weil unser Gehirn ständig nach Belohnung sucht und Multitasking versorgt es mit einem bunten Strauß an Mini-Belohnungen: Neue E-Mails, Chatnachrichten oder Social-Media-Updates aktivieren unser dopaminerges Belohnungssystem. Kurz gesagt: Wir bekommen einen kleinen Kick. Das fühlt sich gut an, auch wenn es unsere Produktivität sabotiert.

Langfristig trainieren wir unser Gehirn dadurch auf ständige Ablenkbarkeit. Das kann dazu führen, dass es uns immer schwerer fällt, in einen Zustand tiefer Konzentration zu kommen. Ein Phänomen, das der Autor Cal Newport in seinem Buch “Deep Work: Rules for Focused Success in a Distracted World“ treffend als „Shallow Work“ beschreibt: viel Aktivität, wenig Tiefe.

Was passiert im Gehirn beim Multitasking?

Neuroimaging-Studien, z. B. mit funktioneller Magnetresonanztomographie (fMRT), zeigen, dass bei häufigem Task Switching der dorsolaterale präfrontale Cortex besonders aktiv wird. Dies ist ein Bereich, der bei kognitivem Stress und hoher mentaler Belastung eine große Rolle spielt. Gleichzeitig wird die Aktivität in Arealen reduziert, die für langfristiges Planen, Gedächtnisbildung und Kreativität zuständig sind.

Kurz gesagt: Wir sind zwar „on fire“, aber es brennt auch schneller aus.

Multitasking im Büro: der neue Normalzustand?

Besonders im digitalen Arbeitskontext ist Multitasking fast unvermeidlich. Tools wie Slack, Mails, Projektmanagement-Plattformen oder SEO-Tools arbeiten in Echtzeit und fordern genau das auch von uns. Doch gerade kreative Arbeit, strategisches Denken oder fokussierte Beratung brauchen Zeit, Tiefe und innere Ruhe.

Multitasking wirkt hier wie ein permanenter Hintergrundlärm, der verhindert, dass unser Gehirn in den Modus des Deep Work kommt, also jenem mentalen Zustand, in dem wir wirklich in Aufgaben eintauchen und Lösungen entwickeln, die Substanz haben.

Monotasking: die unterschätzte Superkraft

Die gute Nachricht: Man kann lernen, besser mit dieser Reizflut umzugehen und sich bewusst gegen Multitasking entscheiden.

- Fokuszeiten blocken: Etwa mit der Pomodoro-Technik oder festen Deep-Work-Zeiträumen ohne Unterbrechungen.

- Benachrichtigungen ausschalten: Klingt banal, wirkt aber Wunder.

- Routinen schaffen: Feste Arbeitsorte, Musik, oder kleine Rituale helfen dem Gehirn, in den Konzentrationsmodus zu kommen.

- Eine Aufgabe – volle Aufmerksamkeit: Klingt oldschool, ist aber der effizienteste Weg zu echter Produktivität.

Fazit: Weniger gleichzeitig = mehr geschafft

Multitasking ist keine Superkraft, es ist ein Mythos. Unser Gehirn arbeitet am besten, wenn es sich auf eine Sache konzentrieren darf. Wer dauerhaft leistungsfähig, kreativ und gesund bleiben will, sollte lernen, den Reiz des „Schnell-viel-Schaffens“ kritisch zu hinterfragen und sich stattdessen auf das nacheinander besinnen.

Oder, ganz einfach gesagt: Weniger Tabs, mehr Klarheit.

|

|

|

|

|

Fragen? Immer gerne fragen!

|

Wir sind für Dich da.

Schreib uns gern jederzeit

eine E-Mail an [email protected] oder

ruf uns einfach kurz an: +49 40 22868040

Bis bald,

Deine Wingmenschen

|

|

Anckelmannsplatz 1, 20537 Hamburg, Germany

|

|