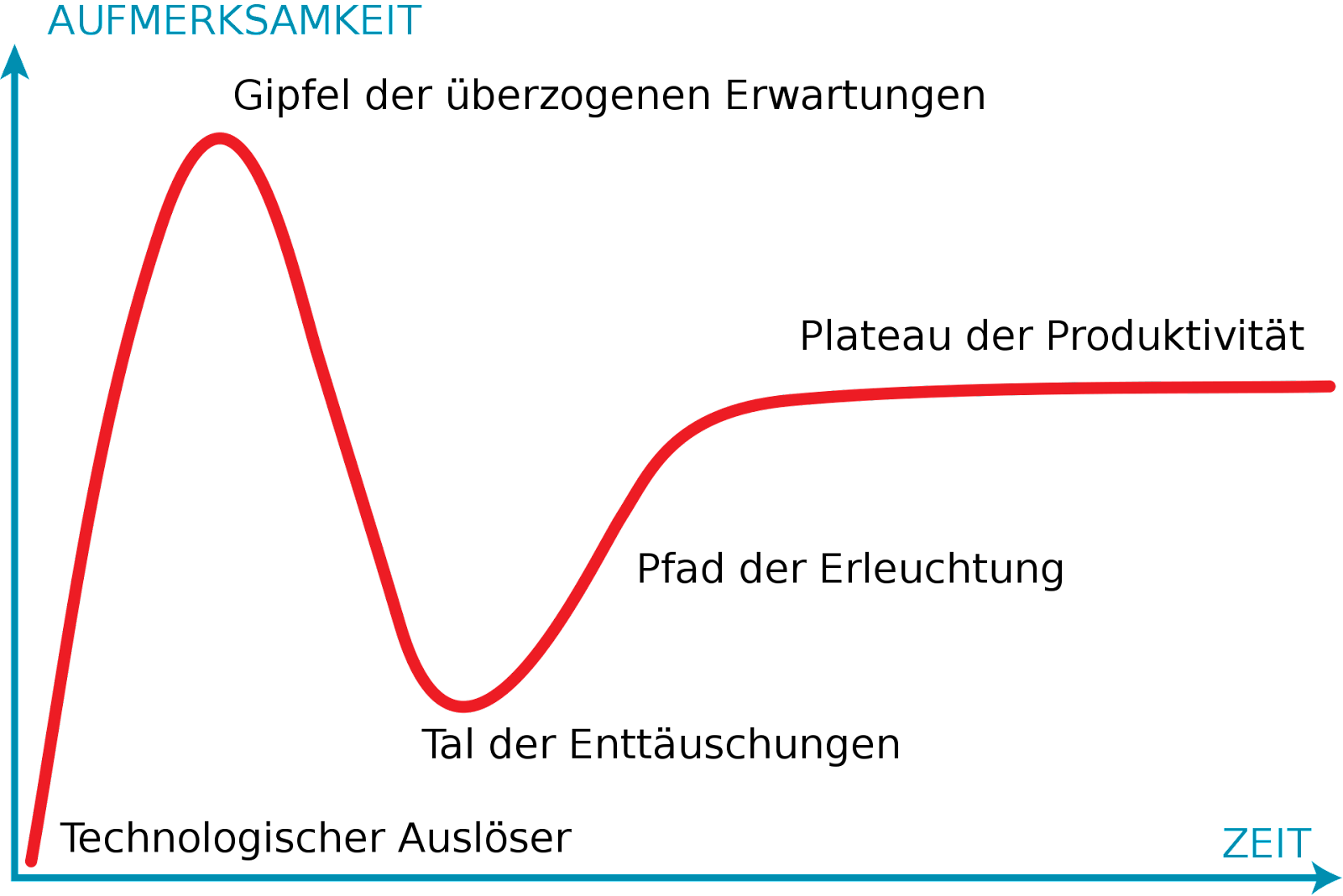

Ja, sorry, schon wieder ChatGPT. Aber auch wenn das Thema für eine Nachrichtenlage schon viel zu lange präsent und für die Memes auf Social schon wieder viel zu ausgelutscht und altbacken ist, im Hype Cycle nach Gartner sind wir noch nicht mal auf dem Gipfel der überzogenen Erwartungen angekommen.

Bild: Hype-Zyklus nach Gartner Inc. CC BY-SA 3.0

Die Early Adopter haben erste Experimente gestartet, ein bisschen gespielt und überlegen sich, für welche Fälle sie die neuen AI-Modelle produktiv einsetzen können. Die Skepsis-Fraktion lässt sich nicht heiß machen, hat schon viele Trends kommen und gehen gesehen und konzentriert sich aufs Tagesgeschäft. Und na klar: beide Fraktionen haben gute Argumente und die Wahrheit liegt irgendwo in der Mitte.

Im Content Performance Podcast sind Benjamin und Fabian skeptisch. Googles Algorithmen zu gamen, ist das Gegenteil ihres Markenkerns. Sie fühlen sich an die Nullerjahre erinnert, als Techies Textspinner programmiert haben, über die automatisiert massenweise schlechter Content produziert wurde, der damals auch noch wunderbar bei Google gerankt hat. Der schlechte Ruf, der SEO noch heute in jedem Redaktions-Workshop verfolgt, rührt genau da her. Da wollen wir alle nicht wieder hin.

Benjamin haut laut Fabian regelmäßig Kunden von den Socken, wenn er zeigt, wie aus sterilen "SEO-Texten" mit ein paar handwerklichen Kniffen (nach jahrelanger Redaktionserfahrung) individueller Content wird, der die spezifische Domänenexpertise atmet und die Zielgruppe anspricht. Dagegen kann AI-Content nicht anstinken. Keine Frage.

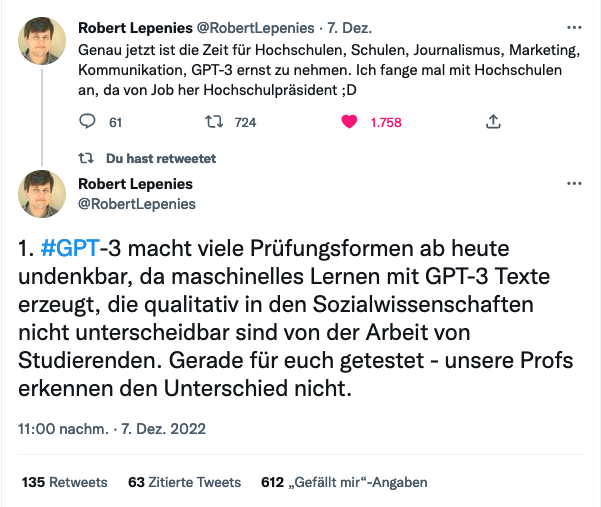

Aber klar ist auch: Die meisten Leute sind nicht Benjamin und der AI-Content von heute hat verglichen mit Spinning-Texten eine ganz andere Qualität. Schon jetzt können weder Menschen noch Google zuverlässig sagen, ob ein Text von einem Menschen oder einer Maschine erstellt wurde.

Link zum Tweet

Erst recht, wenn es noch eine menschliche Korrekturschleife gibt, die auf den Sprachfluss und die Korrektheit der Fakten achtet.

Der menschliche Input kommt aber noch an einer anderen Stelle zum Tragen. Gerade, wenn es um Domain Expertise geht, wird es künftig darum gehen, die Sprachmodelle mit dem eigenen Textkorpus der eigenen Firma in der eigenen Branche mit den eigenen SOPs (Standard Operating Procedures), Wikis, FAQs und Service-Tickets zu trainieren, um eben genau diese spezifische Expertise in die Inhalte zu bringen. Dann ist der Content eben nicht von der nächsten Bude per Knopfdruck kopierbar.

Manuell gelingt es heute schon nur durch intensive Mühen, dass eine Firma eine Sprache spricht. Die Fachkräfte sollen in der Fachabteilung arbeiten und nicht vom Marketing mit Korrekturschleifen für das Unternehmensblog lahmgelegt werden. Deshalb drückt die Website so häufig nicht das aus, was an Expertise eigentlich in der Firma steckt.

Wir sind auch deshalb so fasziniert davon, wenn ChatGPT vermeintlich korrekte Antworten in Sekunden ausspuckt, weil uns das bei unseren eigenen Hausaufgaben, Klausuren, Blogposts, Newslettern und Landingpages nie so leicht von der Hand ging.

Und ganz ehrlich: Auch die Textgilde hat nur selten richtig Bock drauf, die Basics aufzuschreiben: Die Definitionsartikel, die "XY für Anfänger"-Guides. Sondern will tief einsteigen bei den "Thoughtleadership Pieces".

Mein Prof hat uns einst mit folgenden Worten aus der Pflicht entlassen, Hausarbeiten in den Semesterferien abzugeben, wenn wir stattdessen im Kursraum Essays "on the spot" schreiben:

"Sie wollen's nicht schreiben, ich will's nicht lesen, und was bei Ihnen in den letzten 60 Minuten zwischen den Ohren passiert ist, wüsste ich gerne jetzt."

Die offensichtlichen Probleme mit AI-Content

Die Texte basieren auf Wahrscheinlichkeitsrechnung. Die KI bemüht keine Wissensdatenbanken, sondern würfelt jedesmal aus, welche Wörter in welchem Kontext besonders oft aneinander gereiht werden. Das kann inhaltlich totaler Bullshit sein. Wir haben hier also keinen Taschenrechner, der beim selben Input immer wieder die eine, korrekte Lösung ausgibt. Im Gegenteil. Beim Rechnen liegt die KI regelmäßig daneben. (Ben Thompson dazu.) Weil die KI so schnell ist und die Sprache so rund, hört sich das alles nach einer Autorität an. Nicht blenden lassen. Unbedingt die Fakten checken. Noch ist die Datenbasis ein veralteter Stand. Von neuen Ereignissen hat die KI noch keine "Kenntnis". Per Definition ist sämtlicher Content wiedergekäut. Es gibt nur Neuzusammensetzung, keinen genuin kreativen Gedanken. Fun Fact: Menschliche Kreativität funktioniert allerdings gar nicht mal so unähnlich... 😬 Ressourcen (s.u.)

Wofür Suchmaschinen, wenn es Antwortmaschinen gibt?

Viele überlegen, wie sie jetzt die neuen Technologien in ihre Content-Produktion einbauen. Aber der transformative Umbruch wird größer sein. Jono Alderson bringt schon mal diese Frage ins Spiel: Warum müssen wir überhaupt Inhalte auf Halde vorrätig haben, wenn KI sie auch in dem Moment erstellen kann, wenn sie gebraucht wird?

An der Stelle sehen viele Google schon in der Defensive. Wofür braucht es Suchmaschinen, wenn es auch Antwortmaschinen gibt? So vergleicht der Hard Fork Podcast die Odyssee, auf die Du von Google inklusive 40 SERP-Features und Klickoptionen geschickt wirst, mit einem kleinen Forschungsprojekt, während ChatGPT auf die Frage "Welche Schuhe braucht ein Mann?" eine ziemlich brauchbare Antwort ausspuckt.

Doch nicht zu vorschnell. Google ist mit LaMDA absolut auf der Höhe der Zeit. ChatGPT ist deshalb so ein Durchbruch gelungen, weil das Chat-Interface das Ausprobieren so unglaublich einfach macht. Die Frage ist ähnlich wie zum Beginn des Internets: Wie genau sehen Produkte aus, die diese Technologie erfolgreich monetarisieren?

Dazu kommt ein krasses Ressourcenproblem. Rechen-Ressourcen sind teuer. Monetär und was die CO2-Bilanz betrifft. Huggingface gibt daher den Environmental Impact bei seinen Modellen dankenswerterweise mit an.

Link zum Tweet

Was machen wir jetzt damit?

Für Teilaufgaben wie das Clustern von Datensätzen lässt sich GPT schon heute gut einsetzen. Nächstes Jahr kommt die neue Generation GPT4 raus und soll um ein Vielfaches besser sein, als das, was wir aktuell mit GPT3 sehen.

Ansonsten müssen wir die KI nicht fürchten, solange wir uns auf die menschlichen Stärken besinnen. Spannender, als die ganzen ChatGPT-Screenshots durchzulesen, ist es natürlich, selbst Ideen für die Inputs zu entwickeln. AI-Prompting ist ein Skill, der in verschiedensten Rollen am Arbeitsmarkt gefragt sein wird.

Dazu muss die Fähigkeit kommen, den AI-Output zu bewerten und zu veredeln. Der AI-Editor als Job wird kommen. Wenn man mit Ben Thompson mitgeht, dann macht es schon jetzt Sinn, Kindern bei den Hausaufgaben keine Textzusammenfassungen mehr schreiben, sondern den Output kritisch diskutieren zu lassen. Dann müssen Lehrer:innen auch keine Angst haben, verarscht zu werden.

Viele meinen, ohne die langweiligen Texte, die Redakteur:innen oft zu Beginn ihrer Karriere schreiben müssen, könnten diese ihr Handwerk gar nicht erst richtig entwickeln. Übung mache schließlich den Meister. Kann sein. Vielleicht weiß man gewaschene Wäsche auch dann erst richtig zu schätzen, wenn man sie per Hand in Seifenlauge über ein Waschbrett gewetzt hat. Vielleicht können wir aber auch die Vorteile neuer Tools nutzen und uns auf den Teil fokussieren, bei dem wir kaum zu schlagen sind. Kritische Einordnung und Kreativität.

Wo stehst Du Stand heute?

|