|

Wirklich wahres Wingmen SEO Wissen für wache Webmarketer #74

|

|

|

⛏️ Wer anderen eine Grube grubt sich selber in den Käse pubt

|

|

Mit dieser Weisheit kamen meine Kinder neulich um die Ecke. Und sie haben Recht. Es ist nicht lange her, da haben wir über schlimme Freitags-Fehler berichtet. Und dann letzte Woche? Haben wir doch tatsächlich in der Schlussredaktion den Artikel von Anita vergessen. Und im Beitrag von Nils sind ein paar - nicht ganz unwesentliche - Links abhanden gekommen, Uiuiuiui. Da haben wir uns ein wenig über uns selbst und die Technik geärgert.

Danke an Sven Giese, der uns als erstes auf unser Versagen hingewiesen hat. In dieser Ausgabe ist Anitas Artikel vorneweg. Aufgrund des Hinweises von André Gärtner gibt es am Ende nochmal als Zugabe den Discover-Artikel von Nils - dieses Mal mit sämtlichen verweisen, versprochen!

Aber auch sonst haben wir Schönes für Dich zusammengestellt:

-

Andreas Röne hat ein wenig mit den Performance-Daten von httparchive gespielt

-

Nora hat sich den überarbeiteten Movers&Shakers-Report von Sistrix angesehen

-

Über IndexNow und You.com habe ich mir Gedanken gemacht

-

Und Behrend fantastisches Last-Minute Update zur GSC

Nicht so schön läuft es natürlich gerade bei Google.

Die Anti-Trust Claims und die damit zusammenhängenden Veröffentlichungen hast Du aber sicher im Blick.

|

|

|

Besser versichert

|

|

Es gibt so Themen, die einfach so die ganze Zeit mitlaufen, ohne groß auffällig zu werden. Und dann ist man plötzlich innerhalb weniger Tage mehrfach damit konfrontiert. Aus verschiedenen Gründen, zu unterschiedlichen Begebenheiten. Dann merkt man wieder: Oh ja, gute Sache! Sollte man unbedingt dran denken. Im Idealfall auch etwas umsetzen.

Dieses Thema, welches letzte Woche bei uns häufiger aufgeploppte, ist das Monitoring von Websites. Daher eine gute Gelegenheit, auch hier - mal wieder - einen kleinen Reminder abzufeuern. Denn mit Website-Monitoring verhält es sich folgendermaßen: Entweder Du hast es. Oder Du solltest Dir gut und gründlich überlegen, ob Du es Dir leisten willst, darauf weiter zu verzichten.

Denn: Fehler passieren. Gerade bei Websites, an denen viele Menschen an verschiedensten Stellen aus unterschiedlichsten Gründen regelmäßig rumschrauben. Da kann man noch so vorsichtig sein - ein Risiko, dass irgendwo irgendwie irgendwer doch mal einen Haken falsch setzt, etwas vergisst oder unbeabsichtigt verschlimmbessert, ist real. Und kann mitunter unangenehm bis richtig schmerzhaft werden. Zum Beispiel, wenn mit dem Traffic auch die Conversions verschwinden.

Aus diesem Grund haben wir die

Grundlagen und einige Anregungen

zum Thema Website-Monitoring für Dich zusammengetragen. Außerdem gibt es eine kleine

Tool-Übersicht in unserem Wissensbereich

, welche Tools zum Monitoring Deiner Website geeignet sind und wie Du sie in diesem Rahmen nutzen kannst.

Wie schauts aus bei Dir? Wie ist das Monitoring Deiner Website aufgesetzt?

|

|

|

Ein MiniWow für IndexNow

|

|

Bing und Yandex machen das Indexieren einfacher. Mit

IndexNow

haben sie eine

Initiative gestartet

, die Indexierung einfacher machen soll.

Das Problem

Suchmaschinen zügig über neuen Content benachrichtigen. Einfach nur warten bis der Crawler vorbeikommt reicht uns SEOs ja oft nicht.

Der Lösungsansatz

Du schickst einen HTTP-Request an eine URL von Bing oder Yandex mit zwei Parametern:

-

url: Die URL, die Du gerade neu erstellt oder deren Inhalt Du verändert hast

-

key: Dein API-Key. Den denkst Du Dir selbst aus und speicherst ihn in einer TXT-Datei auf Deinem Server. Damit ermöglichst Du der Suchmaschine zu validieren, dass dieser Indexing-Request auch wirklich von Dir kommt

Das Lob

Die API ist herrlich einfach gestrickt. Da haben Bing und Yandex aus der (gescheiterten) Initiative von Google

rund um Pubsubhubbub

gelernt.

Und die 1-Click-Integration über Cloudfront (und möglicherweise Akamai) könnte tatsächlich für eine brauchbare Verbreitung sorgen.

Wenig Aufwand ist an der Stelle notwendig, denn die Relevanz von Bing ist in vielen Märkten so gering, das Extra-Locken wirklich nicht lohnen.

Und es ist ebenfalls gut, dass Bing sich hier auf die Socken macht. Bing crawlt wahnsinnig viel. Und unfassbar ineffizient.

Ebenfalls gut: Suchmaschinen die IndexNow implementieren

teilen die gepushten URLs miteinander

Die Kritik

Das Problem ist eigentlich schon gelöst. Wir haben ja Sitemaps. Die Suchmaschinen (und SEOs) haben es allerdings nie geschafft die zu einem echten Standard zu machen. 2009 hab ich mit meinem

damaligen Chef Christoph

immer gewitzelt, dass wir eigentlich eine Sitemap-Überwachungs-GmbH gründen müssten, weil News-Publisher immer wieder Basics nicht hinbekommen haben. Für einen einfachen Service gibt es immer noch eine Berechtigung, weil weiter Sitemaps veralten, nicht indexierbare Dateien eingetragen werden und die Last-Modifieds nicht sauber gepflegt werden.

Das Problem dabei: Wenn wir schon Sitemaps nicht hinbekommen, warum sollte dann irgendwas mit einer API besser werden?

Zusätzlich gibt es konzeptionelle Probleme: Wenn sich Suchmaschinen drauf verlassen, was passiert, wenn ein Teil der Website die API unterstützt (bspw. das Typo3), aber ein anderer Teil (bspw. das Shopware) nicht? Was passiert, wenn ein böser Mitmensch den Inhalt nachträglich ändert und über diese Änderung dann nicht benachrichtigt. Und was ist, wenn sich nur die Reihenfolge der Links ändert, aber nicht der Haupt-Inhalt? Soll das dann eingereicht werden oder nicht? Und natürlich ist ein einfaches Tool auch eine einfache Möglichkeit sich sein Crawl-Budget zu zerschiessen.

Das erste Fazit

Bing hat ein Problem erkannt und versucht das Problem mit Verbündeten für Seitenbetreiber einfach zu lösen. Trotzdem wird die Marktdurchsetzung eher unwahrscheinlich bleiben. Denn auch wenig Aufwand ist schnell zu viel Aufwand für wenig zusätzlichen Traffic. Für Websites in Märkten mit relativ hohem Bing- oder Yandex-Anteil kann eine Implementierung lohnen.

Wahrscheinlich ist es aber sinnvoller sich die Sitemaps noch einmal vorzunehmen, kritisch anzuschauen und zu optimieren und allen(!) Suchmaschinen damit besser zu helfen.

Wirklich großartig wäre es aber, wenn die Suchmaschinen diesen Ansatz nutzen würden ihren Crawl-Corpus zu öffnen. Wenn die Submits schon geteilt werden, dann könnten auch die Crawls geteilt werden. Dann bleibt immer noch der Aufwand den Index zu erstellen, aber es wäre ein deutlicher Treiber für Innovation auf dem Suchmaschinenmarkt und ein relevanter Beitrag zur Reduzierung des Internet-Traffics.

|

|

|

Sistrix: Jetzt individueller moven & shaken 🍸

|

|

Du bist inzwischen mit Deiner eigenen Toolbox in Sistrix bestens vertraut und kannst typische Muster im Sichtbarkeitsindex zu erkennen? Dann möchte ich Dir ans Herz legen, nicht nur die Daten für Deine eigene Website und Deine Wettbewerber zu betrachten, sondern auch mal einen Blick in die Movers & Shakers zu werfen.

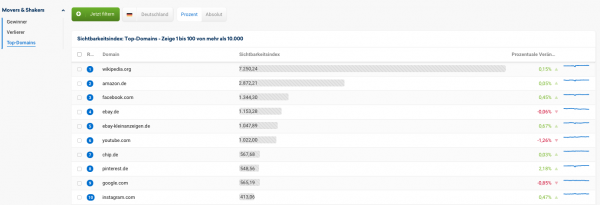

Unter Movers & Shakers kuratiert Sistrix die Gewinner- und Verliererlisten der Woche sowie die Top Domains nach Sichtbarkeitsindex . Hier kannst Du beispielsweise schauen, welche Auswirkungen ein Google-Update auf verschiedene Domains hatte.

Dieses

Feature wurde kürzlich überarbeitet

und ist damit- wie ich finde - noch interessanter und vor allem individueller!

Durch die neuen Funktionen und Filter ist es möglich:

-

Individuelle Zeiträume auszuwählen: So kannst Du Dir die Movers & Shakers beispielsweise quartalsweise oder über bestimmte Feiertage oder zu Google Updates. (zumindest seit dem 19.07.2021)

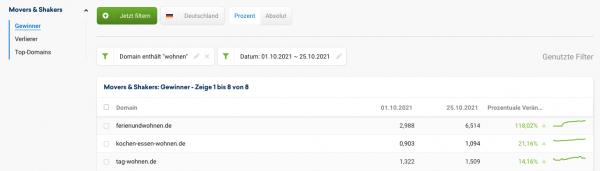

-

Zu filtern und zu sortieren: Du kannst Dir zum Beispiel nur Domainnamen anzeigen lassen, die das Wort "wohnen" enthalten.

-

Exporte zu generieren und mit den gewonnen Daten weiterzuarbeiten.

Natürlich kannst Du Dir die Movers & Shakers auch in allen anderen verfügbaren Sistrix-Ländern anschauen.

Weitere Analyse-Ansätze:

Und wonach möchtest Du die Mover-/Shaker am Liebsten filtern?

|

|

|

Googles Macht oder Google macht Webseiten schneller

|

|

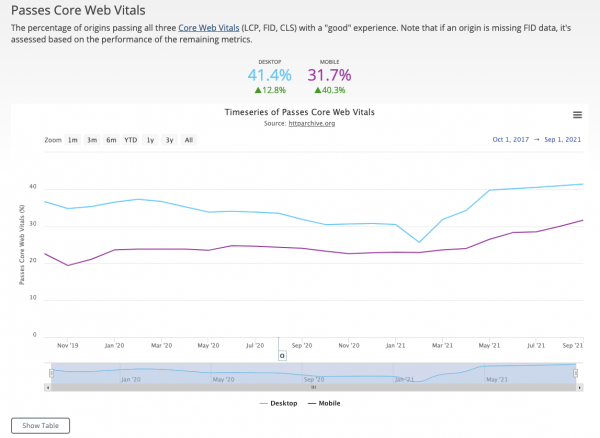

Welche Macht Google in Wirklichkeit hat zeigt der neue

CrUX-Berichte von httparchive.org

wieder einmal sehr deutlich. Im Mai 2020 hat Google das erste mal bestätigt, dass die Core Web Vitals Rankingfaktor werden sollte. Ab diesem Zeitraum wurde viel und wild über den Einfluß der Core Web Vitals auf die zukünftigen Rankings spekuliert. Nach der Einführung der CWVs als Rankingfaktor kam die Ernüchterung, dass die Auswirkungen dieser Werte doch nicht so stark wie erwartet waren. Dennoch sollte man seine CWVs nicht aus den Augen lassen.

Der neue Bericht von httparchive.org zeigt aber insgesamt eine klare Besserung der CWV-Werte über eine breite Masse an Websites zum Februar 2021; der Zeitpunkt kurz bevor Google die CWVs als Rankingfaktor eingesetzt werden sollten (Google hatte diesen Zeitpunkt ja noch einmal kurzfristig in den Juni 2021 verschoben).

Bildunterschrift: Entwicklung der CWV-Tests über den Datenbestand aller von httparchive.org getesteten Seiten

Bildunterschrift: Entwicklung der CWV-Tests über den Datenbestand aller von httparchive.org getesteten Seiten

Diese Reaktion der Webseitenbetreiber zeigt einmal mehr sehr gut welchen Druck ein Unternehmen wie Google auf Webseitenbetreiber ausüben kann. Nach der Kennzeichnung von unsicheren Verbindungen im Chrome Browser ist dies nun das zweite mal eine direkte Einflussnahme von Google auf die Entwicklung von Techniken im Netz.

In weiteren Charts der

CrUX-Berichte

wie etwa "Good First Contentful Paint", "Good Largest Contentful Paint" und vielen weiteren kannst Du Dir genau einen Blick über die Entwicklung der CWV im Netz machen. Dabei reichen die erhobenen Daten bis zum 01.10.2017 zurück.

Eine weitere Möglichkeiten diese Daten viel granularer auszuwerten bekommst Du in dem

Datastudio- Report von httparchive.org

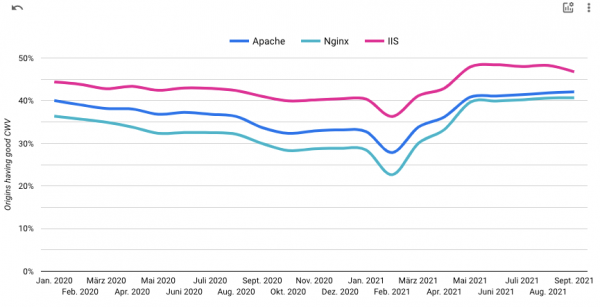

. In diesem Bericht kannst Du direkt nach Webtechnologien, Hostinganbietern, Zeiträumen und vielem mehr filtern und selektieren.

Aus diesen Daten können wir zum Beispiel ableiten, dass der Internet Information Server anscheinend sehr häufig bei gut performenden Websites eingesetzt wird und die Webserversoftware Apache wieder etwas zu seinem Konkurrenten NGNIX aufgeholt hat jedoch die eigentlichen Geschwindigkeitenverbesserungen nicht unbedingt durch die Wahl der Serversoftware direkt verbessert wird, sondern andere Faktoren für die Geschwindigkeitsvorteile verantwortlich waren.

Webseiten in % die in einem bestimmten Zeitraum den CWV-Test bestanden haben und auf der Serversoftware IIS, Apache, NGNIX gehostet wurden)

Webseiten in % die in einem bestimmten Zeitraum den CWV-Test bestanden haben und auf der Serversoftware IIS, Apache, NGNIX gehostet wurden)

Dahingehend kann die Wahl des richtigen CMS bzw. des richtigen Templates entscheiden für die Performance einer Website sein:

Webseiten in % die in einem bestimmten Zeitraum den CWV-Test bestanden haben und mit den Systemen Wordpress, TYPO3 oder Contao umgesetzt wurden

Webseiten in % die in einem bestimmten Zeitraum den CWV-Test bestanden haben und mit den Systemen Wordpress, TYPO3 oder Contao umgesetzt wurden

Was findest Du noch spannend an diesen Daten?

-

Vielleicht einen Vergleich der PageSpeed-Plugins für Wordpress

-

oder den Vergleich von Plugins, die Hinweise auf die Monetarisierung der Domain geben, wie WooCommerce, Paypal etc für Shops oder Adsense, Yahoo Advertising etc für Werbefinanzierung

-

einen Blick auf A/B-Testing-Tools und die Frage warum Optimizely im September so langsam geworden ist

-

oder den Websiten die vermutlich länger nicht angepasst wurden und noch einbindungen wie Google Plus oder Ähnliches mitschleppen

Wie immer gilt: Grundgesamtheit und Seiteneffekte berücksichtigen. Es macht beispielsweise einen Unterschied, ob man die Veränderungen auf Domain-Ebene oder auf Anzahl User analysiert.

Und so manches Ergebnis ist durch ein völlig unterschiedliches Ausgangslevel verfälscht. Aber dennoch: Ein interessanter Datenpunkt ist es allemal!

|

|

|

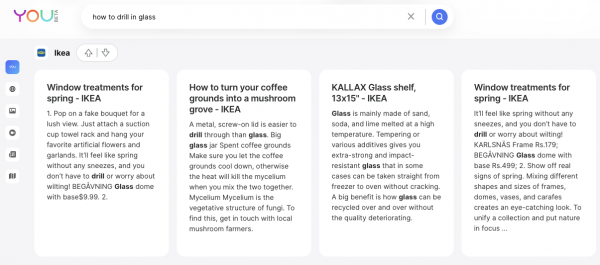

You.com: Eine Suche für Dich?

|

|

Vor einiger Zeit hatten wir von der neuen Suchmaschine

you.com

berichtet. In jüngster Vergangenheit hatte ich Dir einen Überblick über die

aktuelle Situation auf dem Suchmarkt gegeben

.

Letzte Woche wurde mein Beta-Zugang für you.com freigeschaltet. Und ich muss sagen, das Konzept ist gar nicht so uninteressant. Direkt beim Start wirst Du gebeten Domains rauf oder runter zu voten. Du kannst beeinflussen, wovon Du mehr oder weniger in den SERPs sehen möchtest.

Die Suchergebnisse selbst werden dann in horizontal scrollbaren Reihen angeboten. Das ist erst einmal ungewohnt, aber irgendwie auch ganz charmant.

Bei Programmier-How-To-Fragen wird natürlich als erstes Stack-Overflow angeboten (mit ziemlich umfangreichen Snippets). Die „normalen" organischen Treffer sind in einer Reihe angeordnet und Du kannst diese ebenfalls horizontal scrollen.

Und das gleiche Layout finden wir dann auch bei „People also asked/Featured Snippet"

Die einzelnen Boxen lassen sich hoch oder runter voten und die Suche passt sich dann an.

Insgesamt macht die Suche schon einen soliden Eindruck. Das System macht schon Spaß in der Benutzung. Auch wenn hier einfach verschiedene Ergebnislieferanten (Bing und einige APIs (Stackoverflow, Yelp, etc.) zusammengestöpselt werden. Das ist schon übersichtlich und hilfreich.

Und für den Use Case bei vielen Suchanfragen quasi Site-Abfragen für bestimmte Domains automatisch zu bekommen fallen mir schon eine Menge Situationen ein, bei denen ich das brauchen könnte.

Wenn das System dann auch noch mitlernt und anfängt clevere Vorschläge zu machen, dann kann das schon etwas werden.

Irritierenderweise werden aber auch in der Reihe der Ergebnisse „from the web" die Ergebnisse von YouTube nicht herausgefiltert, obwohl es dafür eigentlich eine eigene Ergebnisreihe gibt.

Und werden die Fragen longtailiger, dann werden die Ergebnisse ziemlich wenig hilfreich, weil versucht wird trotzdem viele Reihen anzuzeigen:

Interessant ist auch: Die Suche macht Desktop mehr Spaß als Mobile, dort ist der Gewinn zusätzlicher Übersicht nicht gegeben und dann werden die großen Snippets eher hinderlich.

Fazit: Ich find es spannend den Ansatz zu beobachten. Der Tab bleibt erstmal offen. Aber ich glaube nicht, dass ich bereit sein werde dafür Geld auszugeben.

|

|

|

GSC API Update

|

|

Gestern gab es dann noch

eine Nachricht

, die mich fast vor Freude hat platzen lassen.

Die Google Search Console wurde um gleich zwei ersehnte Features ergänzt

. Wenn Du es fix ausprobieren willst: der

Query Explorer

nutzt zwar noch "searchType" statt "type", Discover und GoogleNews werden nicht vorgeschlagen, aber die Queries funktionieren trotzdem.

Beim filtern via Regex sperrt sich die Validierung im Query Explorer noch etwas. Für den Test hat aber

Valentin schon einen Tipp

parat.

Diese Neuerung wird viele Analysen vereinfachen und mir persönlich einige arbeit ersparen. entsprechen werden wir unsere Tools schnellstmöglich updaten. Aber fühl Dich nicht gedrängelt Heiko! Es Reicht völlig wenn das gestern schon fertig ist.

Auf welche Analysemöglichkeit freust Du Dich damit am Meisten?

|

|

|

I try to Discover

|

|

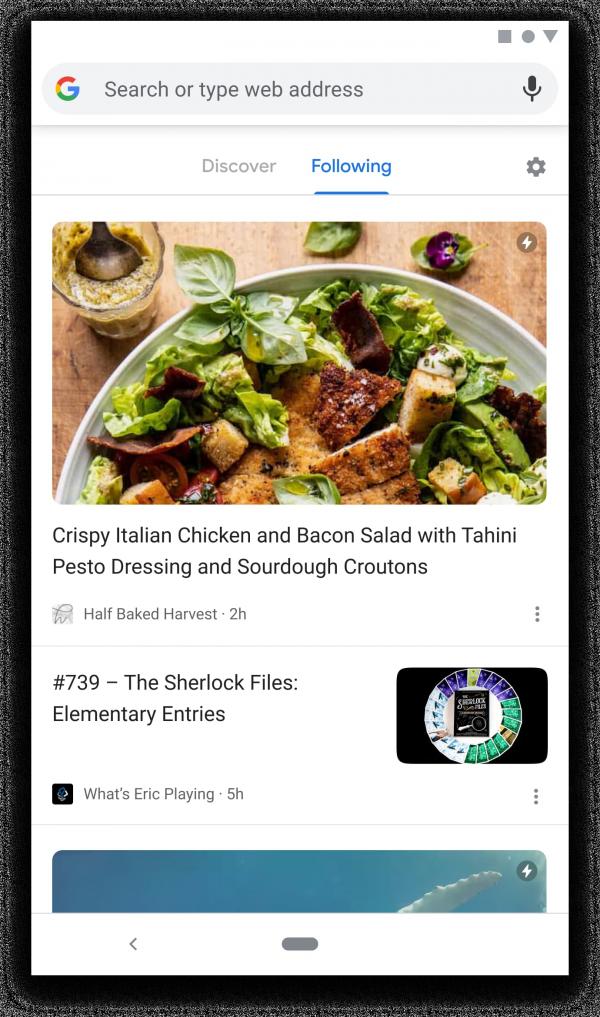

Google Discover ist hier im Newsletter ja immer mal wieder ein Thema. Falls Du Dich bisher noch nicht damit befasst hast, Dein Wissen auffrischen möchtest oder Du ein paar Grundlagen dazu mit Deinem Team teilen möchtest:

Dieser Rundumschlag von Lily Ray

sei Dir sehr ans Herz gelegt!

Wie immer gibt es bei Lily Ray einen riesigen Berg an Infos, gut strukturiert und verständlich erklärt. Von den Basics - Was ist dieses Discover eigentlich und wieso ist es für uns SEOs von Interesse? - hin zu tiefergehenden Details - Was sind Ranking-Faktoren in Discover und was kann ich da alles hinsichtlich meiner Performance analysieren? - ist alles dabei.

Dabei betont Lily, wie fragil der schwer analysierbare Discover-Traffic ist und dass man die

Inhaltsrichtlinien für Discover

einhalten sollte, sonst gibt es eventuell eine Penalty.

Spannend ist die eigene Analyse, die Lily durchgeführt hat, basierend auf 12k URLs aus über 75 Domains. Auf dieser Grundlage hat sie 5 Thesen abgeleitet, die für eine gute Performance in Google Discover von Relevanz sind:

-

Discover Content is highly emotional.

-

Clickbait headlines appear to drive traffic, but be careful not to get a manual action.

-

What works best in Discover might not work at all in regular organic search (and vice versa).

-

Posing questions in headlines appears to drive high CTRs in Google Discover.

-

Content that deeply targets users' interests performs best in Discover.

Hier findest Du bei Bedarf noch

weitere Ausführungen und konkrete Beispiele

dazu.

Wenn Du schon dort bist, kannst Du Dir auch die

Slides zu Lilys Präsentation

von Anfang September auf der DeepSEO Conference anschauen.

An dieser Stelle darf natürlich eine

Empfehlung der SEO Meetup Hamburg Ausgabe mit Teresa Wolf

nicht fehlen. Da erklärt Teresa nochmal ganz genau, worauf es bei Google Discover ankommt.

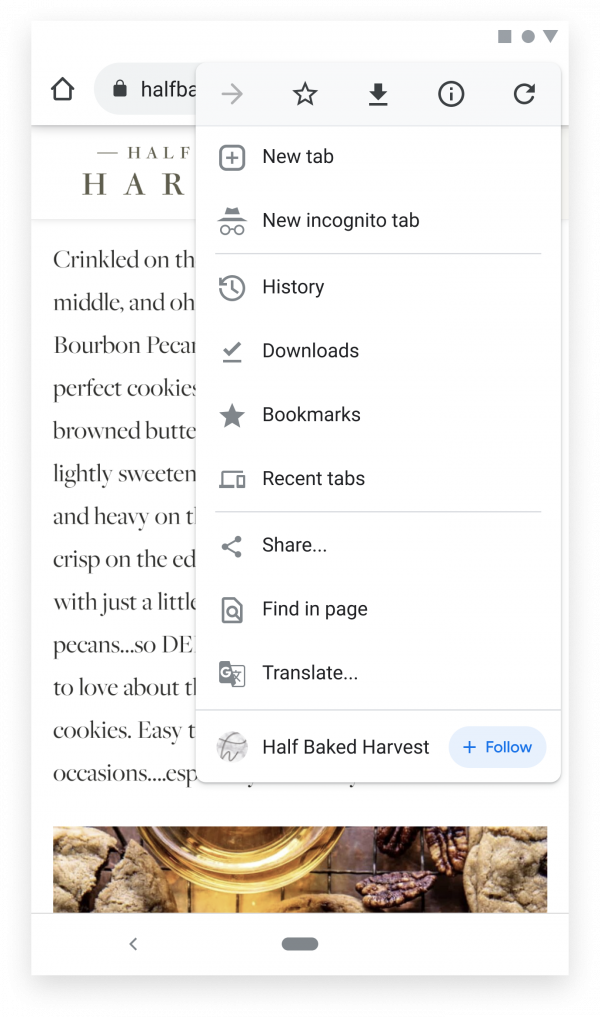

A propos Google Discover: Ein neues

Feature namens Follow

wird derzeit getestet.

Quelle:

developers.google.com

Es ermöglicht eine Art Abo eines Discover Feeds, üblicherweise in Form von RSS oder Atom. Dafür scheinen nur ein paar kleine Code Snippets an der richtigen Stelle erforderlich zu sein. Die ausführlichen Infos nochmal genauer zu betrachten, lohnt sich sicherlich, wenn das Feature es aus der Beta und auch zu uns schafft.

|

|

|

|

|

Fragen? Immer gerne fragen!

|

Wir sind für Dich da.

Schreib uns gern jederzeit

eine E-Mail an

[email protected]

oder

ruf uns einfach kurz an:

+49 40 22868040

Bis bald,

Deine Wingmen

|

|

Anckelmannsplatz 1, 20537 Hamburg, Germany

|

|