| Wirklich wahres Wingmen SEO Wissen für wache Webmarketer #176 |

|

| 📣 Wer hat noch nicht, wer will noch Mal? |

Eine weitere Runde gibt's umsonst! Gewinne, Gewinne, Gewinne! Wahrscheinlich gibt's auch ein paar Verlierer, denn: Nach August 2023 Core Update und September 2023 Helpful Content Update gibt's von Google seit dem 04. und 05. Oktober noch ein weiteres Core Update plus (!) ein Spam-Update gratis dazu. Das auch noch ohne direkt mit der Kreditkarte zu bestellen, Wahnsinn!

Es wird nicht langweilig in der SEO-Welt und dazu möchten auch unsere dieswöchigen Autoren beitragen:

Jolle mahnt zur Vorsicht bei den verheißungsvollen Quick-Win-Früchten Annemieke erzählt, warum die SEO-Expertise bei Migrationen nicht fehlen darf Anita berichtet über den Google Antitrust Prozess in den Staaten Philipp nimmt die Bedeutung von Ads und UX nach dem HCU kritisch unter die Lupe Hannah setzt ihr Tagseitenthema fort

Wie geht es Dir mit der nicht nachlassenden Flut an Google Updates? Schreib uns gerne, wie sich Dein Projekt bisher geschlagen hat!

Viel Spaß beim Lesen,

Deine Wingmenschen

|

|

| Faules Obst im Low-Hanging-Fruit-Korb 👃🍎 |

Markus Hövener hatte die niedrig hängenden Früchte neulich in seinem Podcast aufgegriffen und ich nickte zustimmend bei der Warnung, die er zum Ende mitgab. Dasselbe Thema hatte ich jüngst in diversen Kunden-Calls besprochen: Es geht um die Extrameile, die Du gehen musst, wenn Du mit Deinen Quick Wins wirklich an Gewinnen und nicht an Verschlimmbesserungen arbeiten möchtest.

Typische Quick-Win-Indikatoren und passende Maßnahmen

Wenn Du schon historische Daten in der Google Search Console (GSC) hast, dann lassen sich hervorragend Content und/oder Snippet-Optimierungsaufgaben ableiten, die zügig einen positiven Beitrag zu Sichtbarkeit und organischen Traffic versprechen.

CTR-Underperformer...

... sind Keyword-Seiten-Kombinationen, die bereits in der Top 10 von Google ranken, aber weniger geklickt werden, als wir anhand der Position erwarten würden. Der Maßstab für die Erwartung können CTR-Studien wie die von Sistrix oder Backlinko sein.

Sind CTR-Underperformer identifiziert, kannst Du mit der Arbeit am Title und der Description die Attraktivität Deines Google-Treffers verbessern, so dass Menschen eher geneigt sind, Dein Ergebnis zu klicken. Beschreib klar, worum es auf der angeteaserten Seite geht und warum sich ein Klick lohnt.

Auch der gemäßigte Einsatz von Sonderzeichen und Emojis kann Dich vom Wettbewerb abheben. Aber Vorsicht: Der Title ist relevant fürs Ranking. Schau, dass Du bei aller Motivation zum Optimieren nicht die wichtigen Keywords aus dem Title kegelst. Bei der Description hast Du dagegen mehr Freiheiten, weil sie außer als Teasertext für Suchende keinem weiteren Zweck dient.

Chancenrankings

Wenn Du zu bestimmten Suchanfragen mit Deinen URLs auf Seite 2 von Google (Position 11-20) oder sogar im unteren Bereich der Seite 1 (4-10) rankst, dann hast Du definitiv schon viel richtig gemacht und Dir eine gewisse Relevanz zum Thema erarbeitet. Die Klicks werden aber immer noch oberhalb Deines Scheitels eingefahren.

Bei den Seite-1-Rankings kann die Snippet-Optimierung zu mehr Klicks führen (s. o.). Der beste Hebel ist aber die Optimierung der rankenden Seite selbst:

Ist das Keyword im Title, der H1 oder zumindest in einer der Zwischenüberschriften (H2, H3, etc.) enthalten? Hat die Konkurrenz strukturierte Daten oder wichtige Open Graph Tags, die Dir fehlen? Streifst Du das Thema des Chancenrankings nur am Rande und könntest noch 1-2 Absätze ergänzen? Geben Dir die Fragen aus der People-Also-Ask-Box ("Ähnliche Fragen") Hinweise darauf, welche Fragen Du mit Deinem Inhalt noch beantworten könntest? Punktet der Wettbewerb mit Videos oder schlauen Grafiken?

All das können sinnvolle Ergänzungen sein, die für Dich vielleicht den Durchbruch in die Top-Rankings ausmachen.

Aber Vorsicht: Diese Gefahren lauern bei den vermeintlichen Quick Wins

Durchschnittliche CTR-Werte taugen in Deinem Fall nichts, weil das SERP-Layout längst nicht mehr aus "zehn blauen Links" besteht, sondern prominente SERP-Features weniger Klicks für die organischen Ergebnisse übrig lassen. Deine Zeit ist also verschwendet. Du baust das Chancen-Keyword in den Title und die Überschriften ein. Dabei gehen aber die Signale auf das viel wichtigere Keyword verloren, das mit Blick auf Dein Geschäftsmodell, Suchvolumen und Suchintention viel relevanter ist. Oder für das Chancen-Keyword gibt es bereits eine andere Seite auf Deiner Domain und mit Deinen Optimierungsmaßnahmen hast Du jetzt Kannibalisierung aufgebaut.

Wie vermeidest Du diese Fehler?

Vergleich Dich mit Dir selbst, um eine für Dich und Deine Branche aussagekräftige CTR-Benchmark zu bekommen. Kevin Indig hat hier bereits über Custom Click Curves geschrieben (Newsletterausgabe 157). Oder Du baust Dir nach dieser Vorlage das passende Bubble Chart (Newsletterausgabe 151). Wenn Du noch kein aussagekräftiges Keywordmapping hast, also eine Tabelle, die abbildet, welche Themen und Keywords auf welcher URL gespielt werden, dann bau Dir zumindest für den Quick-Win-Kontext eins mit GSC-Daten aus der API (zum Beispiel via Search Analytics for Sheets). Mehr dazu gleich. Schau Dir die SERPs an, bevor Du optimierst: Hast Du bei dem aktuellen Layout mit den vorhandenen Features Chancen auf Klicks? Dann leg los. Falls nicht, dann schnapp Dir das nächste Thema. Berücksichtige auch die Snippets und Inhalte der Wettbewerber, um zu verstehen, in welche Richtung Du mit der Optimierung stoßen solltest.

Keywordmapping für Deine Quick-Win-Kandidaten

Lass uns annehmen, dass Du bereits CTR-Underperformer oder Chancenrankings identifiziert hast. Das sind jeweils Kombinationen aus Keywords und URLs. Wenn Du sichergehen möchtest, dass Du die richtigen Seiten mit Blick auf die richtigen Keywords optimierst, musst Du in zwei Richtungen schauen:

Wenn Du Dir doppelt genannte Keywords in einer Tabelle farblich hervorhebst und ein paar Filter zum Beispiel für ein Minimum an Impressions setzt, kannst Du mit Blick auf die Performance-Daten aus der GSC schnell entscheiden, auf welcher Seite ein Thema/Keyword am besten gespielt werden sollte.

Schöner Nebeneffekt: Du siehst so schnell bestehende Kannibalisierung. So erfährst Du nicht nur, was Du auf einer Seite optimieren kannst, sondern auch, wo Du andere Seiten vielleicht de-optimieren solltest. Hier ist die Arbeit an Linktexten Gold wert. Wenn Seite B ein Thema streift, das primär auf Seite A stattfindet, musst Du den Text nicht löschen, sondern kannst ihn einfach auf Seite A verlinken und so mit den passenden Ankertexten die Relevanz von Seite A zum Thema stärken.

Wir werfen gerne gemeinsam einen Blick auf Deine Daten und helfen Dir bei der Umsetzung, falls Du den Ansatz spannend findest, aber selbst (noch) nicht dazu kommst. Schreib mir gerne eine Mail!

|

|

| SEO-Migrationen: Warum Expertise entscheidend ist |

Beim Umziehen denkst Du sicher oft an Kisten, Klebeband und das Schleppen von Möbeln. Doch bei den digitalen Umzügen sieht die Welt ganz anders aus: Hier sind es unter anderem Weiterleitungen und Seitenstruktur, die Dich ins Schwitzen bringen.

Hinzu kommt die Frage: Wie lange dauert es eigentlich, bis eine Seite, die von einer Domain auf eine andere migriert, wieder dasselbe Level an organischem Traffic hat wie vor dem Relaunch? Auf diese Frage gehen wir in diesem Artikel ein.

Von Domain zu Domain: Wie schnell kehrt der organische Traffic zurück?

Ein Artikel im Search Engine Journal zeigt, wie komplex und langwierig Migrationen sein können. Die durchschnittliche Zeit für eine erfolgreiche Migration beträgt demnach im Schnitt 229 Tage, bis die neue Domain das Traffic-Niveau der alten Domain erreicht hat.

Best Cases: Einige der untersuchten Domains haben diesen Wechsel in nur 16 bis 33 Tagen geschafft.

Langfristige Auswirkungen: Beeindruckend ist, dass 42% der in der Studie betrachteten Domain-Migrationen nie zum ursprünglichen Traffic-Level zurückkamen.

Warum variieren die Ergebnisse so?

Jede Website ist ein Unikat. Die Faktoren, die eine Migration beeinflussen, sind zahlreich. Es gibt bekannte Best Practices, aber auch situationsbedingte Entscheidungen, die Du treffen musst. Eine interessante Anmerkung kam neulich von John Mueller, der meinte, dass das frühzeitige Starten einer neuen Website vor einer Migration den Prozess erleichtern könnte.

Hier zeigt sich, warum Expertise so wichtig ist. SEO-Einsteiger könnten vermuten, dass das Verschieben aller Inhalte und die Anpassung der Domain in den Servereinstellungen ausreichen. Doch es gibt noch viele weitere Aspekte, die berücksichtigt werden müssen.

Domain-Komplexität: Es ist für Google erheblich herausfordernder, eine umfangreiche Website wie Amazon mit seinen Millionen von URLs zu crawlen und zu verarbeiten als eine kleine Website wie die Deiner nahegelegenen Zahnarztpraxis.

Rankings erhalten: Am allerwichtigsten sind für SEO die Rankings. Wenn Google vorher Deine Seite mit bestimmten URLs für bestimmte Suchanfragen in der Suche angezeigt hat, gehen diese Rankings flöten, es sei denn, Du stellst wie beim echten Umzug einen Nachsendeantrag: Im SEO sind das die 301-Weiterleitungen.

Backlink-Profil: Ein entscheidender Faktor für den SEO-Erfolg einer Domain. Wenn sich die URLs auf Deiner neuen Domain ändern, was zwangsläufig passiert, wenn Du den Domain-Namen wechselst, dann zahlen alte Backlinks nicht mehr auf Deine Domain ein. Deshalb ist es wichtig, für alle relevanten URLs ein Keyword-Mapping anzulegen und sie per 301-Redirect auf die neue URL weiterzuleiten. Andernfalls kann es Monate oder sogar Jahre dauern, bis der Traffic wieder da ist.

Seitenstruktur und -aufbau: Eine klare, logische Struktur ist für Suchmaschinen essenziell. Bei einer Migration muss diese Struktur erhalten oder sogar verbessert werden.

Technische Aspekte: Dabei geht es um Weiterleitungen, Canonical Tags und andere technische Details. Wenn diese nicht korrekt gehandhabt werden, kann das verheerende Folgen für Dein SEO haben.

Expertise der Beteiligten: Technische Maßnahmen können erheblich dazu beitragen, dass ein Relaunch reibungslos verläuft. Wenn jedoch solche Schritte vernachlässigt werden und beispielsweise das Konzept für Weiterleitungen fehlt oder fehlerhaft implementiert wird, können die Rankings verloren gehen.

Migrationen sind kompliziert und es gibt keinen "Einheitsweg". Du solltest Dir jedoch der möglichen Dauer und der damit verbundenen Risiken bewusst sein. Wir Wingmenschen unterstützen Dich gerne bei Deinem Migrationsprojekt, damit Deine Rankings möglichst schnell wieder mindestens auf das Vorher-Level kommen.

|

|

| Google Antitrust Trial |

In meinem kleinen "Was geht grad so bei Google"-Medley aus Ausgabe 173 hatte ich es eher am Rande erwähnt: Google muss sich in den USA vor Gericht verantworten. Aber warum eigentlich? Und was ist im Prozess bisher passiert?

Der Vorwurf

Du hast es vielleicht selbst schon mitbekommen, dass Google auf verschiedenen Smartphones und in bestimmten Browsern die vorgegebene Standard-Suchmaschine ist. Dafür hat Google angeblich jede Menge Geld bezahlt, so vermuten es das US-Justizministerium und mehrere US-Bundesstaaten.

Und nicht nur das: Die Verträge sollen die Zusammenarbeit mit Konkurrenten untersagt haben. Daher lautet die Anschuldigung, dass Google "seine marktbeherrschende Stellung bei Suchmaschinen auf illegale Weise erlangt" habe.

Googles Sicht

Google weist diese Vorwürfe von sich: Der Grund für den hohen Marktanteil? Google sei einfach besser als der Rest und Nutzer*innen wüssten das. Wenn sie wollten, könnten sie ja auch einfach eine andere Suchmaschine als Standard festlegen.

Außerdem gäbe es noch viele andere Suchsysteme, die regelmäßig genutzt werden (andere Apps und ChatGPT beispielsweise) - es gäbe also durchaus Konkurrenz. (Quelle)

Das Verfahren

...ist auf 10 Wochen angesetzt und soll daher bis Mitte November laufen. Sollte Google verlieren, drohen potenziell einschneidende Konsequenzen wie die gerichtlich angeordnete Abspaltung einzelner Geschäftsbereiche. In diesem Fall ist es jedoch sehr wahrscheinlich, dass Google in Berufung geht, um in der nächsten Instanz ein anderes Urteil zu erzielen.

Search Engine Land beobachtet den Prozess und fasst die wichtigsten Entwicklungen in einem Artikel zusammen, der regelmäßig aktualisiert wird. Denn natürlich spitzen hier die SEOs ihre Ohren: Wer weiß, welche für die SEO-Welt relevanten und spannenden Informationen über Google im Rahmen des Prozesses ans Licht kommen? Mal ganz abgesehen davon, dass das Urteil am Ende durchaus größeren Einfluss auf unseren SEO-Alltag haben könnte.

Ich kann die Lektüre des SEL-Artikels nur empfehlen! Falls Dir dazu die Zeit fehlt, habe ich hier eine (einigermaßen) kurze Zusammenfassung für Dich:

Zur Marktdominanz von Google

Google ist in vielen Systemen als Standard-Suchmaschine festgelegt. Wer lieber eine andere Suchmaschine nutzen möchte, kann das ändern, meint Google. Verschiedene Zeugen entgegnen jedoch, dass der Wechsel oftmals langwieriger und komplizierter ist, als man es den Nutzer*innen zumuten könnte.

Zur Schädigung von Konkurrenten

Durch die bestehenden Verträge inklusive Gewinnbeteiligungen ist es für andere Suchmaschinen schwer bis unmöglich, selbst zum Standard zu werden. Teilweise ist seitens der Anbieter noch nicht mal die Bereitschaft, einen Platz am Verhandlungstisch zu geben, da. Die Wettbewerber von Google werden so effektiv ausgehebelt und daran gehindert, sich zu etablieren. Microsoft beispielsweise sieht dadurch auch keinen Anreiz dafür, in die eigene Suche zu investieren, da ja ohnehin keine Chance besteht, Google hier etwas abzunehmen.

Zu den Standard-Suchmaschinen

Google gibt jährlich über 10 Milliarden US-Dollar dafür aus, um die Standard-Suchmaschine verschiedener Systeme zu bleiben. Weil beispielsweise auch Apple so von Google mit viel Geld beworfen wird, wurden Pläne, eine eigene Suchmaschine zu entwickeln, eingestellt.

Zudem gibt es hier eine kleine Grundsatzdiskussion, wer im Rahmen des Verfahrens mit Google im Wettbewerb steht: Sind es Player aus dem allgemeinen Suchmarkt wie Bing und DuckDuckGo oder auch (teils eher nischige) spezielle Suchplattformen wie Yelp, Expedia und Amazon? Google plädiert auf letzteres, um sich selbst weniger gefährlich und dominant zu machen, das US-Justizministerium und die Wettbewerber sehen das anders.

Zum womöglich wettbewerbswidrigen Verhalten

Google hat bei den Ads etwas herumgemauschelt. Unter anderem wird die kombinierte Schaltung von Anzeigen in Google und Bing erschwert.

Außerdem soll Google Beweismaterial zerstört und Maßnahmen getroffen haben, um den Nachweis der Wettbewerbsverletzungen zu erschweren.

Auf dem Laufenden bleiben

Für uns ist es, wie bereits erwähnt, auch deswegen spannend, den Prozess zu verfolgen, da interessante Informationen zur Funktionsweise der Suchmaschine bekannt werden könnten.

Dabei sollte gut aufgepasst werden, um nichts falsch zu verstehen. In einem Wired-Meinungsartikel wurde offenbar verstanden, dass Google die Suchanfragen von Nutzer*innen verändert, um Ergebnisse zu triggern, die kommerzieller sind. Das klingt schon etwas wild.

Der Artikel macht gerade fröhlich die Runde, während Google das in Form von einem Mastodon-Post von Search Liaison Danny Sullivan direkt abbügelt.

Soweit der aktuelle Stand. Ich bin gespannt, wie sich das in den nächsten Wochen noch entwickelt und werde Dich auf dem Laufenden halten!

|

|

| Weniger ist mehr – oder nicht? |

Google sagt: "Ihr Nutzer*innen liebt unsere Ads".

Dem würde ich nicht vollständig widersprechen – wenn Ads nicht funktionieren würden, gäbe es sie nicht. Aber nur weil etwas funktioniert, ist es nicht automatisch gut. Aber das ist ein Thema für einen anderen Artikel.

Ich habe mich mit dem Nachbeben des Helpful Content Updates beschäftigt. Mir ist dabei gar nicht so wichtig, ob eine individuelle Seite gewonnen oder verloren hat, sondern mehr, was das bedeutet. Und Ads scheinen dabei auch eine Rolle gespielt zu haben.

Schlechte UX = abgerauscht

Eine Beobachtung, die öfters geteilt wurde: Die, die eine schlechte UX haben, haben verloren.

Schlechte UX? Was heißt das eigentlich? Und wie kann Google das messen? Spannende Frage, die auch diese Woche in der täglichen Dosis SEO aufkam. Um den Artikel nicht unnötig lang zu machen, beschränken wir uns aber auf das, was Google empfiehlt. Schließlich kommt ja auch das Update von Google.

Im April hat Google die Page Experience Dokumentation aktualisiert. Bevor Du das aufmerksam liest, möchte ich Dir aber eine Frage stellen:

Wie findest Du Ads, die im Content auftauchen, nichts mit dem Content zu tun haben und sich am besten auch noch bewegen, flimmern oder die Farbe verändern?

Die Antwort, egal wen man fragt, wäre wohl: Das macht keinen Spaß, Inhalte so zu konsumieren.

Google schreibt:

"Does the content lack an excessive amount of ads that distract from or interfere with the main content?

Do pages lack intrusive interstitials?

Is the page designed so visitors can easily distinguish the main content from other content on your page?"

Einige der Seiten, die verloren haben, haben eine schlechte UX, weil es ein Übermaß an (nervigen) Ads gibt, die den Content nahezu ungenießbar machen. Vor allem dann, wenn es mehr Ads anstatt eigentlichen Inhalt gibt, haben wir ein Problem.

Die Beobachtung mit den Ads hat unter anderem auch Glenn Gabe gemacht. Zufällig ist auch bei web dev zur Zeit des Updates ein Artikel erschienen, der uns zeigt, wie wir Ads vernünftig einbinden können.

Die richtige Balance finden

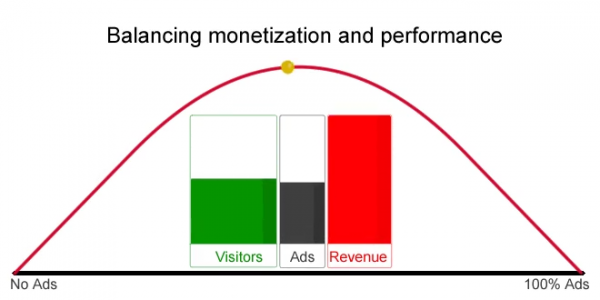

Abseits der sehr guten Tipps fand ich folgende Grafik (ebenfalls aus dem Beitrag von web dev) sehr hilfreich:

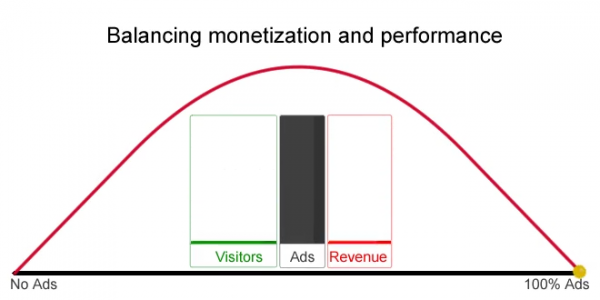

In einem Geschäftsmodell, bei dem mit Anzeigen Geld verdient wird, kann das obige Bild nicht der Punkt sein, an dem man eine goldene Mitte aus der Nutzerzufriedenheit, den Einnahmen und der Anzahl/Frequenz an Anzeigen erreicht hat.

Wird die Anzahl der Ads hochgeschraubt, steigt der Umsatz. Eine Zeit lang machen die Nutzer*innen das auch mit. Die Zufriedenheit nimmt nicht linear oder exponentiell ab.

Dann kommt mit zunehmenden Ads ein Punkt X, der Sweet Spot (hier durch den goldenen Punkt visualisiert). Der Umsatz ist maximiert, die Nutzerzufriedenheit akzeptabel und "alle sind glücklich". Wenn die Gier zu groß wird und es zu viele Ads werden, wendet sich das Blatt erneut.

Zu viele Ads = kein Umsatz = keine Nutzerzufriedenheit. Wir sehen also: Wir müssen herausfinden, wo dieser Sweet Spot, die goldene Mitte, liegt.

Der SEO Publisher, der das getestet hat

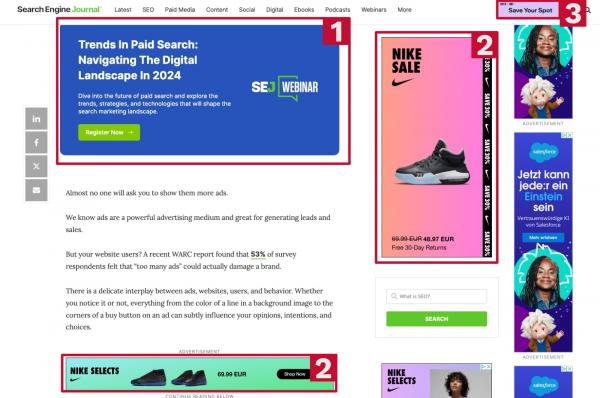

Search Engine Journal ist eine beliebte amerikanische Quelle für SEO News. Ich weiß nicht, wie Du es siehst, aber ich persönlich empfinde die Menge an Ads dort als zu viel.

Darum anbei mal ein Beispiel:

Vom gesamten Viewport nehmen die Ads in etwa 35% Prozent ein Die Brand Ad (1) empfinde ich als passend – sie passt zum Design und ist durch die farbliche Füllung prominent hervorgehoben Die Nike Anzeigen (2) sind für mich irrelevant, besonders die untere im Content selbst lenkt ab

Daher spannend, dass sie ein Experiment durchgeführt haben.

Die folgenden Fragen sollten beantwortet werden:

Welche Ads werden bevorzugt – reine Brand Ads (z. B. Werbung für ein eigenes Webinar oder Programmatic Ads (basierend auf dem Nutzungsverhalten der User und deren Interessen – auch abseits von SEO und Online Marketing) oder eine Mischung? Wie wirken sich mehr oder weniger Ads auf das Nutzerverhalten aus?

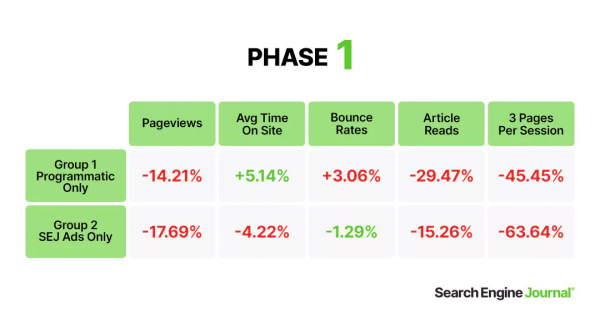

Um den Erfolg/Misserfolg zu messen, wurde auf folgende Metriken geschaut:

Das Ergebnis für Test 1, Status Quo vs. nur Brand Ads vs. Programmatic Ads, ergab dabei folgendes Bild:

Eine insgesamt deutliche Verschlechterung ist zu identifizieren. Unerwartet, muss ich sagen.

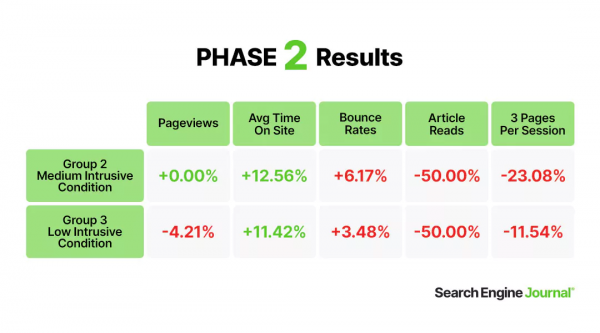

Experiment 2 war dann ein Vergleich des Nutzerverhaltens, wenn weniger Ads als der Status Quo geschaltet wurden. Die Reduzierung fand in zwei Stufen statt, von hoch (Status Quo) bis niedrig (Ads nur in der Sidebar, ober- und unterhalb des Contents und in der Navigation Bar).

Das Ergebnis brachte folgende Metriken:

Auch wenn es leicht positive Entwicklungen bei der durchschnittlichen Verweildauer gab, sind die negativen Auswirkungen massiv. Auch ein Vergleich der Scrolltiefe offenbarte die Erkenntnis, dass weniger Nutzer*innen bis zum Content scrollen, wenn weniger Ads eingesetzt werden.

Ich bin wie das Team von Search Engine Journal (SEJ) verwirrt.

Woran könnte das liegen?

SEJ nennt unter anderem folgende Gründe, die dafür verantwortlich sein könnten:

Halo-Effekt = wir schließen von einem Merkmal auf ein unbekanntes Merkmal (z. B. ist jemand hübsch assoziieren wir gleichzeitig, dass diese Person klug ist) und Spill-over-Effekt = eine Ad wird als positiv erachtet, dann wirkt sich das positiv auf weitere Ads aus) Zu häufige Wiederholung von ähnlichen Ads IKEA-Effekt (Erklärung gibt es unten) Reziprozität = Konsum von Ads wird als "Bezahlung" für den Content gesehen, die es mit weniger/keinen Ads nicht mehr gibt Das Gefühl von Zugehörigkeit Das Gefühl von Vertrautheit Unterschiede in der Intention von Nutzer*innen.

Wenn ich auf jeden einzelnen Punkt im Detail eingehen würde, wäre das vermutlich ein Wettbewerber für den längsten Newsletter-Artikel aller Zeiten. Also gibt's meine Einschätzung in kürzerer Form.

Einige der genannten Effekte werden hinsichtlich ihrer Bedeutung falsch wiedergegeben. Der IKEA-Effekt beispielsweise sagt eigentlich aus, dass wir Dinge, die wir (teilweise) selbst erstellen/aufbauen, höher bewerten, als wenn wir sie fertig kaufen würden.

Das lässt sich ausdehnen und auf z. B. das Phänomen versunkener Kosten oder das "nicht hier erfunden" Syndrom überführen, nicht aber auf "Nutzer*innen nehmen das Konsumieren von Ads als ein Aufbauen von Search Engine Journal als eigene Teilleistung wahr".

Was für mich besonders plausibel klingt: Wenn es total normal ist, dass so viele Ads auf Search Engine Journal zu sehen sind, dann wirkt es ungewohnt, wenn auf einmal weniger Ads da sind. Das ist das Gefühl von Vertrautheit.

Eine weitere Möglichkeit sehe ich in der "Personalisierung" durch gute Programmatic Ads. So was wird vielleicht nicht aktiv wahrgenommen und wenn man direkt fragt, würde auch niemand sagen "ja, mir gefällt es, wenn ich personalisierte Ads sehe". Aber Menschen tun häufig irrationale, nicht mit logischen Argumenten erklärbare Dinge.

Randnotiz: Ich kann das Buch "Predictably Irrational" wärmstens empfehlen.

Was Du daraus mitnehmen kannst?

Die wichtigste Botschaft, die ich für Dich habe: Mehr Ads ungleich mehr Umsatz. Wie so oft gilt: It depends!

Das Ergebnis der Studie ist unerwartet. SEJ schreibt selbst, dass sie weiter forschen müssen. Und dass die Ergebnisse für eine einzige Website in einem Teilmarkt gültig sind. Unterschiedliche Kulturen haben andere Gewohnheiten.

Das gleiche Experiment würde in unterschiedlichen Ländern – so vermute ich – ganz andere Ergebnisse erbringen. Die Botschaft "Finde es am besten selbst heraus" passt daher gut.

Was ich, bevor ich den Stift niederlege, hervorheben möchte: Die Studie ist hervorragendes Content Marketing. Auch außerhalb der SEO Bubble wird das vermutlich externe Verlinkungen erzeugen und Aufmerksamkeit bekommen.

Es wurde ein pikantes Thema gewählt, das in dem Experiment ein kontroverses Ergebnis erbracht hat. Ein Thema, das für alle Publisher relevant ist. Davon kann man sich gerne eine Scheibe abschneiden, anstatt nach Tricks, Shortcuts & Co. zu suchen, die langfristig keinen Erfolg liefern werden.

|

|

| Taggadi, Tagada - Das richtige Tag für einen Artikel finden - tadaa 🎉 |

In der letzten Ausgabe haben wir uns damit befasst, was Tagseiten eigentlich sind und wozu man sie überhaupt gebrauchen kann. Aber wie finden wir die richtigen Tags für unsere Artikel? Dieser Frage widmen wir uns heute.

Das Vertaggen von Artikeln ist nicht einfach. Häufig ist das Tag/Schlagwort-Feld auch nur optional. Selten wissen Redaktionen intuitiv, wie mit den Tags umgegangen werden sollte und was daraus entstehen soll. Deswegen ist es immer hilfreich wenn die Person, die die Tags setzt, weiß, wozu das gemacht wird. So kann sie bestmöglich einschätzen, welche Tags sinnvoll sind.

Je nach Verwendung von Tags können dabei Stolperfallen entstehen. Ist der Redaktion freie Hand gelassen bei der Setzung der Tags, dann können zu ein und demselben Thema einige unterschiedliche Tags entstehen, welches dann wiederum wieder zu Problemen führen kann.

Ich hab zwei regionale Beispiele mitgebracht:

Beispiel Sportverein

Mögliche Tags:

HSV Hamburger SV Hamburger Sportverein Hamburger Sport Verein

Stolperfalle: All diese Tags müssen im Idealfall zusammengefasst werden, sodass Nutzer sich beispielsweise anhand der Tags auf der Seite orientieren und mehr Artikel dazu finden und lesen können. (Für alle, denen jetzt nicht bewusst sein sollte, was mit den Tags gemeint ist: der HSV, Fußball-Verein in der 2. Bundesliga. Nicht zu verwechseln mit Hannover 96, dem Stadtteilverein St. Pauli oder dem Handball Sport Verein Hamburg. Ich will jetzt nicht sagen, dass ich so falsch gesetzte Tags schon gesehen habe, aber möglich wäre es...)

Beispiel Persönlichkeit aus der Politik

Mögliche Tags:

Stolperfalle: Hier wird es jetzt richtig spannend, denn es gab eine Zeit, in der Herr Tschentscher (ach ja – das wäre auch noch ein mögliches Tag) noch nicht Bürgermeister war und es wird wohl auch eine geben, in der er nicht mehr Bürgermeister sein wird. Und es gab vor ihm ja auch schon andere Personen, die dieses Amt ausgeführt haben – wie fasst man also die ganzen Tags zusammen?

Die Krux hierbei ist immer, es zu schaffen, dass alle Artikel, die zu dem Thema gehören und eventuell mit unterschiedlichen Tags versehen wurden, trotzdem dazu gefunden werden können. (In meinen Beispielen sind wir auch noch gar nicht auf Falschschreibweisen oder Synonyme eingegangen, die ebenfalls genutzt werden können, wenn der Redaktion keine konkreten Vorgaben gemacht werden.)

Um Tagseiten also sinnvoll nutzen zu können, müssen wir immer sicherstellen, dass unterschiedliche Tags auf einer Seite zusammengeführt werden. Also bei bereits bestehenden Tags eventuell normalisieren und clustern, sowie entsprechende Weiterleitungen setzen. Stehst Du noch vor der Einführung von Tags, kannst Du Dir viel Arbeit sparen, indem Du ein Keywordset vordefinierst und Cluster vorgibst.

Welches sind die für uns relevanten Tags?

Aus SEO Sicht sind die Tags wichtig, die den Inhalt beschreiben, also nicht "Plusartikel", "dpa" oder "Satire", sondern "HSV", "Horoskop Schütze" oder "Last Minute Mallorca".

Bei der Auswahl der Tags solltest Du darauf achten, dass diese so eindeutig wie möglich, best beschreibend für das Thema und zusätzlich mit einer möglichst unbegrenzten Gültigkeitsdauer vergeben werden. Also statt nur "Klitschko" zu verwenden wollen wir "Vladimir Klitschko" (oder "Vitali Klitschko"), statt "Angie" wollen wir "Angela Merkel" und statt "Sommerdom 2023" wollen wir "Dom" oder noch besser "Hamburger Dom" – denn wer sich für den Sommerdom 2023 interessiert, interessiert sich wahrscheinlich auch für den Winterdom und für den Sommerdom 2024 vielleicht auch.

Was ist also, wenn es jede Menge Synonyme, Falschschreibweisen und unterschiedliche Tags gibt, die auf ein Thema hinauslaufen? Dann müssen wir zusammenfassen – juhu. Idealerweise finden wir ein Leittag - die korrekte Schreibweise des kompletten Terms - die dann den Titel unserer Tagseite bildet. Dazu können dann Aliase definiert werden, die wiederum alle auf der Seite zusammengefasst werden.

Warum sind Tags wichtig für SEO?

Mithilfe von Tags können wir relativ einfach Links unterhalb des Artikels darstellen. Und dadurch können wir dann die einzelnen Artikel stärken. Wir können Artikel thematisch einordnen und verdeutlichen, dass wir Experte sind für das Thema – denn wenn für Suchmaschinen und Nutzer deutlich wird, dass wir schon 2000 Artikel über den HSV geschrieben haben, dann kennen wir uns wahrscheinlich mit dem Thema aus. Diese sogenannte Themenautorität hilft Dir dann ebenfalls bei Google Discover oder News.

Zusätzlich kann mit Tagseiten Traffic erzielt werden. Das sollte aber nicht Dein primäres Ziel sein, denn das funktioniert in den meisten Fällen nur, wenn es keine aktuelle Newslage zu einem Thema gibt und entsprechend in den meisten Fällen auch keine hohe Nachfrage.

Was können wir sonst noch mit Tagseiten machen?

Um Deine Tagseiten bestmöglich nutzen zu können, kannst du diese mit Metadaten anreichern. Hierfür kannst Du im Markup über das Attribut sameAs beispielsweise die Knowledge Graph ID angeben, Wikipedia-Einträge oder die offizielle Seite von Angela Merkel oder dem HSV. Je nachdem, worüber die Seite ist, kannst Du dann entweder eine Person auszeichnen oder eine Organisation und dann auch Daten ergänzen wie das Geburtsdatum oder Gründungsdatum, Geburtsort oder Firmensitz, andere Namen / Synonyme und vieles mehr. Achte hierbei wieder darauf, dass die Daten langfristig gültig sind, sodass Du diese nicht aktualisieren musst. Die Anzahl der Mitarbeiter oder Ähnliches kann sich beispielsweise rasant ändern.

Da wir gerade beim Thema Structured Data sind noch ein Tipp: Über die vergebenen Tags kannst Du per Vererbungsregeln die Attribute mentions oder about in Deinem Article Markup pflegen, sodass die Artikel auch darüber deutlich zugeordnet werden können.

Im nächsten Artikel widmen wir uns der spannenden Frage, wann Tagseiten denn indexiert werden sollten und wie daraus wirklich wertvolle Themenseiten werden können. Also stay tuned 🙂

|

|

|

|

|

Fragen? Immer gerne fragen!

|

Wir sind für Dich da.

Schreib uns gern jederzeit

eine E-Mail an [email protected] oder

ruf uns einfach kurz an: +49 40 22868040

Bis bald,

Deine Wingmenschen

|

|

Anckelmannsplatz 1, 20537 Hamburg, Germany

|

|