| Wirklich wahres Wingmen SEO Wissen für wache Webmarketer #158 |

|

| ☀️ Willkommen SEO-Sonnenschein |

Oh, wir kommen, wir kommen, wir kommen Sonnenschein – it's summer! Endlich hat auch das Jahr 2023 beschlossen, den Sommer einzuläuten. Wir arbeiten mit Sonne im Gesicht und in der einen oder anderen Mittagspause gibt's dann doch mal das obligatorische Eis zum Nachtisch.

Doch wer kennt es nicht, mit dem Wetterumschwung gehen immer allerlei Veränderungen einher. Auch bei den Wingmenschen. Und so haben wir diese Woche für euch:

Einen Johan, der mit Stolz den Wingmen-Beach-Body präsentiert und Dir gern zu Deiner eigenen SEO-Strandfigur verhilft. Eine Sandra, die gerne einen absolut barrierefreien Sommer verbringen möchte. Einen paranoiden Flo, der von sommerlichen SEO-Wettbewerben nichts hält, lieber am Beckenrand stehen bleibt und die Bademeister befragt. Einen Johan, der sich für einen luftigereren Haarschnitt, äh, Fontstyle entschieden hat. Einen Andreas, der nochmal schnell ein paar neue Sommershorts kaufen möchte, damit die Kalkstelzen dieses Jahr auch braun werden und dabei mal wieder an Shopify scheitert.

|

|

| Wir wollen nur Dein Bestes |

Neulich beim Offsite in Plau saßen wir gemeinsam am Lagerfeuer und haben über aktuelle, anstehende und abgeschlossene Projekte sinniert. Und darüber, dass wir uns vor Jahren ja sehr bewusst den Fokus auf SEO in Großbuchstaben auf die Flügel geschrieben haben. Und trotzdem ist es ganz schön krass zu sehen, was wir alles können und machen, obwohl wir uns auf einen einzelnen Kanal spezialisiert haben. Oder ist es gerade deswegen?

Wir sind ja von Natur aus eher bescheiden, aber rund um die Feierlichkeiten anlässlich unseres 10. Geburtstags ist es sicher in Ordnung, mal ein wenig zu flexen.

Das alles machen wir echt gut und sehr gerne:

GA4-Tracking-Setups konzeptionieren und in Workshops in die Inhouse-Teams tragen Themenrecherchen mit XX. Tausenden von Keywords datenbasiert und mit Empathie für die Relevanz für unsere Kunden und deren Kunden erstellen und in konkrete Redaktionspläne entwickeln Indexierungs- und Paginierungs-Strategien bei richtig großen Webshops Redaktionsteams von Tageszeitung Impulse fürs kontinuierliche Optimieren ihrer News für die Newsbox und Google Discover geben Mittelständlern sagen, welche 80% der SEO-Maßnahmen sie getrost sein lassen können, um auf 20% Vollgas zu geben Inhouse-Teams schlauer machen und für SEO sensibilisieren Redaktionsschulungen geben und Content-Briefings schreiben Überlegen wie wir AI sinnvoll nutzen können, um Prozesse zu optimieren Dabei helfen, dass SEO im Unternehmen höher priorisiert wird (Externe Agentur = mehr Dampf auf dem Kessel) Zur Analyse der interner Verlinkung haben wir nicht nur richtig viel Expertise, sondern auch einen sehr umfassenden, von eigenen Tools unterstützen Prozess Und ganz neu: Wir haben einen Accessibility-Audit konzeptioniert, der Unternehmen hilft, die Anforderungen des Barrierefreiheitsgesetzes rechtzeitig umzusetzen. (was zu dsgvo - "man könnte auf DSGVO und "lasst euch nicht davon überraschen wenn es zu spät" ist hinweisen")

Vermutlich hab' ich noch tausend Dinge vergessen, mit denen wir uns in den letzten 10 Jahren befasst haben 😅

Egal ob Routine- oder Spezialfall - wir sind super gespannt auf alle neuen Anfragen, Projekte und Herausforderungen, die die nächsten 10 Jahre für uns bereithalten. Also, falls Du bei einem der Punkte hellhörig geworden bist oder ohnehin schon immer gerne mit uns arbeiten wolltest, dann melde Dich bei uns!

|

|

| Friendly Reminder - die Accessibility-Uhr tickt |

Ab dem 28. Juni 2025 müssen Webseiten barrierefrei sein. Das weißt Du sicher, aber hast Du auch schon angefangen, Accessibility-Maßnahmen umzusetzen? Nein? Dann lass mich Dir erklären, warum Du damit am besten heute noch starten solltest.

Accessibility bedeutet mehr als alt-Attribute zu Bildern hinzuzufügen. Es ist auch mehr als nur Headlines in die richtige Reihenfolge bringen. Entsprechend der Web Content Accessibility Guidelines (WCAG) muss eine Webseite "perceivable, operable, understandable, and robust" sein. User müssen also die Inhalte deiner Webseite wahrnehmen können. Sie müssen zudem in der Lage sein, Deine Webseite zu bedienen, Deine Inhalte zu verstehen und Deine Webseite muss von verschiedenen User-Agents inklusive assistiver Technologien interpretiert werden können.

Ein paar konkrete Beispiele:

Screenreader sollten Deine Webseite korrekt vorlesen. Für die Tab-Navigation musst Du sicherstellen, dass alle interaktiven Elemente einen Fokus haben. Gleichzeitig braucht Deine Webseite ein Design, das Menschen mit visuellen Beeinträchtigungen es ermöglicht, Deine Webseite problemlos zu nutzen (Stichworte: non-color designator bei Links, Kontrastverhältnisse, Vergrößerungsmöglichkeiten, Bildschirmkompatibilität). Und dann gibt es da noch die barrierefreie Webseitenstruktur, die Du nicht vergessen solltest. Nutzt du valides HTML? Wie sieht's aus mit Semantik? Passt hier alles oder strukturierst Du deine Webseite ausschließlich mit <div>? Oder der SEO-Klassiker: Sind deine Linktexte aussagekräftig? Um auf die eingangs erwähnten Bilder zurückzukommen: Sind Deine Infografiken barrierefrei? Und damit meine ich nicht, ob sie einen alt-Text haben. Komplexe Bilder erfordern einen anderen Ansatz (w3.org hat dazu ein schönes Tutorial zusammengestellt).

Das sind nur einige Kriterien. Sie verdeutlichen aber, dass verschiedene Bereiche betroffen sind. Du kannst Accessibility nicht von oben auf die Webseite draufschrauben. Barrierefreiheit muss von Designer:innen, Redakteur:innen, Developer:innen etc. bereits im Entstehungsprozess mitgedacht werden. Die Umsetzung ist also nicht an einem Nachmittag erledigt, sondern wird ein stetiger Prozess.

Wenn du Argumente für deine/n Vorgesetzte/n benötigst, habe ich hier auch noch was für Dich:

16% der Welt-Bevölkerung (mehr als 1 Milliarde) hat eine Behinderung (Tendenz steigend). Gestaltest Du deine Webseite barrierefrei, erreichst Du mehr potenzielle Kunden. Barrierefreie Webseiten haben eine hohe Benutzerfreundlichkeit. Verbesserst Du die Accessibility, verbesserst Du auch die UX. Und User, die sich leichter zurechtfinden, werden auch leichter zu Kunden. Barrierefreiheit geht Hand in Hand mit SEO, denn durch eine bessere Webseitenstruktur – zum Beispiel indem Du semantisches HTML nutzt – verstehen nicht nur Screenreader-User deine Webseite einfacher, sondern auch Suchmaschinen. Das hilft dem Ranking. Das Barrierefreiheitsgesetz wurde am 22.07.2021 verkündet und wird ab dem 28.06.2025 Anwendung finden. Wessen Webseite danach nicht barrierefrei ist, riskiert hohe Bußgelder und zusätzlichen Behördenstress. Ein ähnliches Szenario gab es schon bei der DSGVO. 2025 erst kurz vor Ultimo zu starten bedeutet, Accessibility-Maßnahmen als "Bug-Fixes" zu verstehen. Und Bug-Fixes sind teuer, denn sie halten auf, Verbesserungen an gewinnbringenden Stellen umzusetzen. Karl Groves rechnet das in seinem Artikel "Understanding the cost of not being accessible" sehr anschaulich vor. Fang lieber jetzt schon damit an, kontinuierlich Barrieren auf deiner Webseite abzubauen.

Fazit: Accessibility ist gut für UX, gut für SEO, gut fürs Portemonnaie, gut für uns alle! Denn mal ehrlich, wenn Du selbst trotz zwei gebrochener Hände problemlos online shoppen könntest, wär das schon ganz cool, oder? (Brich Dir, wenn möglich, aber dennoch nicht beide Hände gleichzeitig.)

Überzeugt von Accessibility, aber Du weißt nicht, womit Du starten sollst? Schreib mir eine Mail und ich helfe Dir!

|

|

| Ich bin zu paranoid für Ranking-Contests |

SEO-Contests. Ich habe sie nie verstanden und werde sie nie verstehen.

Weder vom Aufwand vs. Nutzen noch von den vermeintlichen Insights, die man während der Wettbewerbsphase erhält, kann man mich hinterm Monitor hervorlocken.

Viel zu sehr denke ich: „Wenn ich Google wäre, dann würde ich mir die Entwicklung von allen Teilnehmer-Sites genau anschauen und schick durchs Raster schießen". Tatsächlich verstehe ich auch nicht, warum der BVDW dort als Sponsor mitläuft. Das kann mir vielleicht der SEO-Fachbeirat mal bei Gelegenheit erklären.

Wenn ich jetzt mit einem SEO-Blog, einer komplett neuen Site oder mindestens einer Subdomain antrete, dann riskiere ich wenigstens nicht mein Hauptprojekt, mit dem ich mein täglich Brot verdiene bzw. sogar nicht mal meine, sondern die des Arbeitgebers. Auf der anderen Seite frohlocken Gewinne im Wert von 10.000 Euro. Ein SEO-Day-Ticket, diverse Toolzugänge, afs+-Streaming, Zugänge zum BVDW-Fachkräftezertifikat, Bücher und natürlich die Mitgliedschaft im Portal des Veranstalters Agenturtipp.de – tolle Preise, ehrlicherweise aber eher persönliche für die SEOs, die da mitmachen. Die werden sich sicher freuen, aber die kritische Frage ist für mich, ob das zuträglich oder gar riskant für SEO und Marke der Wettstreiter sein kann.

So wundert mich beim diesjährigen Contest Conversionzauber zum Beispiel die Teilnahme von dm.de oder bauhaus.info.

Da ich aber alt und paranoid bin, habe ich einmal ein paar Experten um Ihre Meinung dazu gebeten:

Oliver Errichiello

Flo: Lieber Oliver, vielen Dank für Deine Zeit in diesem kurzen Interview. Stell Dich doch bitte den Leserinnen und Lesern, die Dich noch nicht aus Funk, Fernsehen oder aus diversen Büchlein von Dir und Arnd kennen, vor.

Oliver: Mein Name ist Oliver Erichiello. Ich bin Professor für Markensoziologie und leite zusammen mit meinem guten Freund und Business Partner Professor Dr. Arnd Zschiesche, seines Zeichens Professor an der Westküste in Heide, das Büro für Markenentwicklung. Das schon seit 2006, also einer gefühlten Ewigkeit.

Flo: Deine Einschätzung aus Sicht eines Markenexperten interessiert mich brennend. Bin ich wirklich zu paranoid? Wann geht ein Wettbewerb für eine Marke in Ordnung und wann lässt man lieber die Finger davon?

Oliver: Den von Dir aufgebrachten Aspekt sehen wir tatsächlich sehr, sehr kritisch. Warum? Marke hat immer etwas mit Vertrauen zu tun. Was kennzeichnet Vertrauen? Vertrauen ist etwas, das ich nicht befehlen kann oder sich mal eben schnell ergibt, sondern Vertrauen entsteht in dem Moment, wo Menschen sich auf bestimmte Handlungsweisen verlassen können. Über die Zeit, also immer wieder. Dann müssen wir nicht mehr nachdenken, sondern wir lehnen uns geistig im guten Glauben zurück, dass schon alles gut werden wird und die Leistung oder das Produkt kommen genau so wie ich es erwarte.

Bei dem hier geschilderten Beispiel geht es um kurzfristige Effekte. Da geht es eigentlich im Wesentlichen nicht um "Conversionzauber", sondern das ist ein "Budenzauber".

Das ist eine typische Jahrmarkts-Denke. Welche Tricks kann ich anwenden, um möglichst schnell einen "Erfolg" zu erzielen – oder wie es in Neudeutsch heißt "zu generieren".

Das ist aber eine vollkommene Verwechslung, denn Erfolge auf der Sichtbarkeitsebene zu erzeugen ist relativ einfach. Da muss ich alles aufwenden, was mir da vor die Flinte kommt und das integriere ich dann. Das wird dann sicher auch zu einem kurzfristigen Erfolg führen, aber wenn ich eben langfristig denke – und auch so ein Algorithmus von Google denkt ja eher langfristig – dann geht es ja darum, in den für mich passenden Kontext Vertrauenswürdigkeit über die lange Zeit aufzubauen. Menschen sollen sich auf mich verlassen können und dies als bestimmte Erwartungshaltung an mich aufbauen.

Was hier passiert ist das genaue Gegenteil von Verlässlichkeit. Das ist mal eben kurz zeigen "hier bin ich", "das kann ich", "ich wende alle Tricks an". Aber, wenn ich da solche Tricks anwende, was tue ich dann mit meinen Kunden? Wende ich da dann auch solche Tricks an, um nen schnellen Euro zu erwirtschaften, oder sage ich mir lieber, dass ich langfristig eine Marke aufbauen möchte. Darum geht's!

Kai Spriestersbach

Flo: Lieber Kai, für alle, die Dich noch nicht aus diversen Buch-Veröffentlichungen, jüngst veröffentlicht mit dem Titel „Richtig Texten mit KI: ChatGPT, GPT-4, GPT-3 und Co.", oder den SEO-Bühnen dieser Welt kennen, stelle Dich doch bitte einmal vor.

Kai: Hey Flo, ja vielen Dank! Ich bin Kai Spriestersbach, Jahrgang 1982, Unternehmer und selbstständiger Berater für Marketing und Digitalisierung. Ich betreibe drei Online-Magazine und bin aktuell als Interims Co-CMO bei einem deutschen B2B SaaS-Unternehmen im Amazon-Umfeld tätig und unterstütze ein lokales Fertigungsunternehmen mit Digitalisierungs-Stau bei der Automatisierung von Prozessen. Neuerdings bin ich auch noch Sachbuchautor, wie Du schon dankenswerterweise erwähnt hast!

Flo: Sehr schön, dass Du Zeit findest, um auf meine abweisende Einstellung zu dem Thema einzugehen.

Kai: Sehr gerne. Im Gegensatz zu Dir, habe ich in der Vergangenheit mit meiner Webseite search-one.de mehrfach an den großen SEO-Contests im Vorfeld der DMEXCO teilgenommen. Ich fand die Herausforderung und den sportlichen Wettbewerb spannend und wollte zeigen, was ich kann. 2013 konnte ich sogar den SEOPhonist-Wettbewerb gewinnen und schaffte es beim damals größten Contest, dem XOVILichter-Wettbewerb, ein Jahr später in die Top 3.

Danach verlor das Ganze seinen Reiz für mich, denn die Preise stehen in keinem Verhältnis zu dem Aufwand, den man treiben muss, um einen SEO-Contest zu gewinnen. In den Jahren nach 2014 wurden die SEO-Contests dann auch immer stärker von mehr oder weniger seriösen SEO-Agenturen dominiert, die das Ganze wie ein Kundenprojekt mit massig Ressourcen angegangen sind, um Werbung für sich zu machen, oder riesige Domains mit extrem viel Vertrauen bei Google haben mit einer Unterseite dort teilgenommen.

Manchmal habe ich aus Interesse noch die Wettbewerber und Rankings als passiver Beobachter analysiert, allerdings muss ich sagen, dass Googles Algorithmen damals auch noch sehr viel einfacher waren und ich es spannend fand zu sehen, welche Rankingfaktoren bei einem vollkommen neuen, weil künstlich geschaffenen Begriff am meisten Einfluss haben. Aber es war auch immer wieder frustrierend zu sehen, dass am Ende die Backlinks den größten Einfluss hatten und Google algorithmisch wenig Wert auf Themenrelevanz oder einen Nutzen für die Besucher bei der Bewertung der Links gelegt hat.

Mittlerweile habe ich weder die Zeit, noch das Interesse an solchen Wettbewerben teilzunehmen und schaue mir die Rankings und Teilnehmer noch nicht einmal mehr an, denn mit „echten" Rankings bei realen Suchanfragen haben diese wenig gemeinsam, so dass ich daraus auch keine neuen Erkenntnisse für meine Optimierungsstrategien gewinnen könnte.

Olaf Kopp

Flo: Last not least ein Interview-Partner, dessen Agentur beim Wettbewerb mitgemacht hat und auf dem 5. Platz gelandet ist. Lieber Olaf, stell Dich doch bitte einmal kurz vor.

Olaf: Ich bin Olaf, Co-Founder, CBDO und Head of SEO bei der Agentur Aufgesang. Wir sind als Agentur aufgetreten, aber eigentlich habe ich alleine bei dem Contest mitgemacht. Wir haben also keine Agentur Ressourcen außer Websites für die Veröffentlichung der Contest-LP und zum Generieren externer Links aus eigenen Assets genutzt. Die von mir eingesetzte Arbeitszeit war Privatzeit und umfasste insgesamt ca. 4 Std.

Flo: Sehr genial, dass Du trotz eines so provokanten Aufmachers meinerseits hier Rede und Antwort stehst. Erzähl doch mal... warum war dieser Wettbewerb für Euch sinnvoll? Was habt ihr gelernt und vor allem: was sind bei Euch die Grenzen, wenn ihr sowas macht?

Olaf: Wie im OM Cafe Podcast mit Markus Hövener besprochen sind solche Contests für mich ein sportliches Event, bei dem ich völlig frei Dinge ausprobieren und kurzfristige Effekte von Maßnahmen testen kann. Wir würden so nie ein Kundenprojekt angehen, da die Maßnahmen auch mit einem hohen Risiko verbunden sind. Man bekommt dennoch ein Gefühl dafür, wie Google mit Signalen wie Content-Anpassungen, Links ... etc. umgeht und wie schnell mögliche Effekte nach der Umsetzung einsetzen. Z.B. war es auch spannend zu sehen, wie unterschiedlich neu indexierte Inhalte in die Rankings einsteigen und welche Rolle die Autorität der Domain dabei spielt, wie häufig sich Rankings verändern ... Da Google zu den Keywords noch keine Daten gesammelt hat kann man Domain- und Landingpage spezifische Faktoren isolierter betrachten als bekannte Begriffe mit einer Historie. Zudem bringen solche Contests i.d.R. auch Backlinks und Erwähnungen über die Berichterstattung. Für mich sind die Gründe pragmatischer Art und den eingesetzten Zeitaufwand halte ich auch in Grenzen.

Vielen Dank an alle für die Einschätzungen und Kommentare. Was meinst Du dazu? Ich bin sehr gespannt auf Dein Feedback.

|

|

| Ich hab die Schriftart schön, ich hab die Schriftart schön, ich hab, ich hab, ich hab die Schriftart schön! |

„Aber Johan, wieso hast Du denn empfohlen, die Schriftart per Robots.txt zu blockieren? Dann kann Google die Seite doch nicht mehr rendern." 😱

Berechtigte Rückfrage, aber nur auf den ersten Blick. Im konkreten Fall hat das Caching der Schriftarten nicht hingehauen: Google hatte sich ziemlich in die Schriften verliebt und sie immer wieder gecrawlt (so ca. 20k Requests am Tag auf eine Handvoll Dateien). Diese Ressourcen sind besser für andere Dinge zu verwenden. Und selbst wenn dadurch nicht mehr wichtige Ressourcen gecrawlt werden, ist es immerhin gut für die Umwelt.

Um das Crawling zu reduzieren, gibt es verschiedene Möglichkeiten:

Caching-Settings fixen und hoffen, dass Google das berücksichtigt Einbindung der Datei für Google unsichtbar machen Status Code und Index-Status verändern (Status 404/410/503, X-Robots: Noindex) Blocken der Datei über Robots.txt

Variante 1 ist best practice: Wir wollen, dass Google alles crawlen und verarbeiten kann. Aber je nach Setup tut sich Technik mit solchen Aufgaben gelegentlich auch schwer.

Variante 2 und 3 mögen wir SEOs eigentlich nicht. Sie verschleiern und SEO bei Obscurity ist meist keine gute Idee. Denn früher oder später fällt es einem immer auf die Füße

Variante 4 nutze ich inzwischen viel lieber als früher. Es ist eine eindeutige Anweisung, es funktioniert und es wirkt mit minimalem Zeitaufwand sofort.

Das Problem beim Blocken per Robots ist aber: Google fehlt die Ressource, um die Seite darzustellen. Ist es also falsch, die Schriftarten zu blocken?

Ich bin überzeugt davon, dass es keinen Impact hat. Denn Google malt die Pixel ja nicht wirklich. Und so lange ich vernünftige Fallback-Fonts definiert habe, passen ja auch alle Objekte weiter an die richtige Stelle.

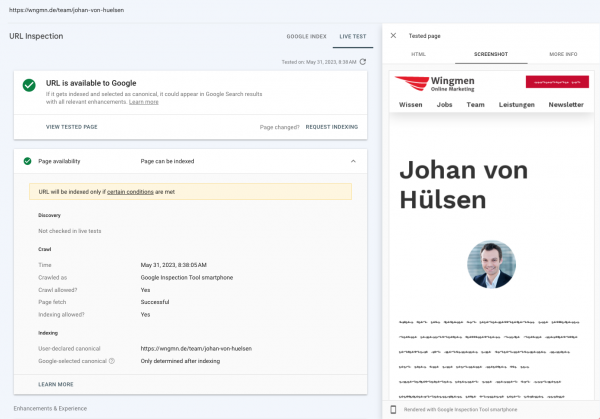

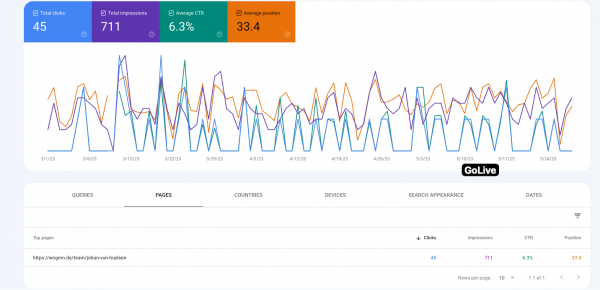

Grau ist alle Theorie. Daher habe ich unsere wichtigste Landingpage zum Test genutzt: Meine Teamseite.

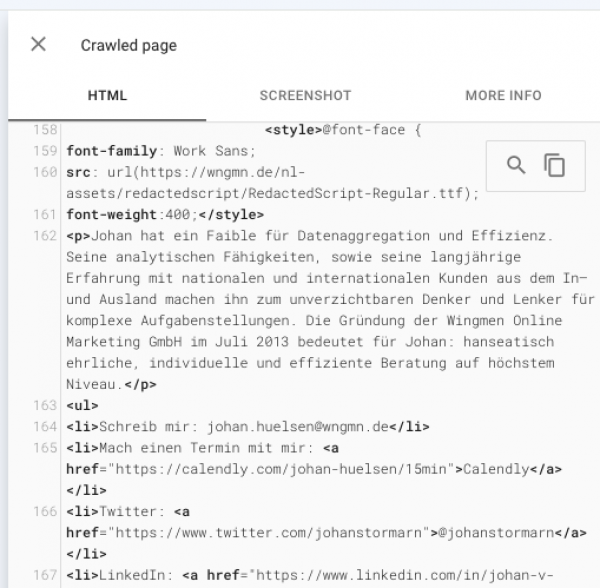

Wingdings war gestern. Heute nutze ich redacted script für den Test:

20 Tage nach Go Live und Indexierung sind die unglaublichen Rankings dieser Seite unverändert. Obwohl man die Schrift nicht mehr lesen kann.

Da die Schriftart aber nur die Darstellung des Textes regelt – nicht aber den Text selbst verändert – hat Google wie erwartet auch weiterhin den Premium-Content dieser Seite unverändert im Index:

Wenn das bei einer so wichtigen Seite funktioniert, dann sicher auch auf Deiner. Und wenn Google die Schriftart egal ist, dann können wir sie auch sperren, wenn sie Crawling-Ressourcen frisst.

Ich habe hier noch nie ein Problem gesehen. Du?

|

|

| Shopify und Sitemaps, Shop-Fuckup die Dritte |

Nachdem ich in meinem letzten Newsletterartikel schon einmal das Handling der Statuscodes für die Collection-Pages in Shopify unter die Lupe genommen hatte, möchte ich in diesem Artikel auf die erzeugten XML-Sitemaps in Shopify eingehen.

Optimalerweise legen wir Sitemaps als statische Dateien in das Dateisystem des Servers, so dass der Abruf dieser Sitemaps so wenig Server-Ressourcen und Zeit benötigt wie möglich. Doch es gibt immer noch Systeme, die dies nicht beachten. Eigentlich gar kein Problem, wenn die Server-Ressourcen ausreichen und die Sitemaps schnell genug ausgeliefert werden. Zusätzlich können sich häufig ändernde Parameter in den URLs der Sitemaps zu Problemen führen. Wieso? Weil mit jeder Änderung der Parameter im Prinzip eine neue Sitemap erstellt wird, die die Suchmaschinen erst einmal entdecken, auslesen und verarbeiten müssen. Ein Beispiel gefällig?

Ein Shopify-Shop besitzt in der Regel mehrere Sitemap-Dateien für die Produkte, Collections, Seiten und Blogbeiträge. Diese werden in einer Index-Sitemap zusammengefasst.

Beispiel einer solchen Index-Sitemap:\

<sitemapindex xmlns="http://www.sitemaps.org/schemas/sitemap/0.9">

<!-- This is the parent sitemap linking to additional sitemaps for products, collections and pages as shown below. The sitemap can not be edited manually, but is kept up to date in real time. -->

<sitemap><loc>https://meinsh

op.de/sitemap_products_1.xml?from=7333257329998&to=8414812483978</loc>

</sitemap>

<sitemap>

<loc>https://meinshop.de/sitemap_pages_1.xml</loc>

</sitemap>

<sitemap>

<loc>https://meinshop.de/sitemap_collections_1.xml</loc>

</sitemap>

<sitemap>

<loc>https://meinshop.de/sitemap_blogs_1.xml</loc>

</sitemap>

<sitemap>

<loc>https://meinshop.de/en/sitemap_products_1.xml?from=7333257329998&to=8414829483978</loc>

</sitemap>

<sitemap>

<loc>https://meinshop.de/en/sitemap_pages_1.xml</loc>

</sitemap>

<sitemap>

<loc>https://meinshop.de/en/sitemap_collections_1.xml</loc>

</sitemap>

<sitemap>

<loc>https://meinshop.de/en/sitemap_blogs_1.xml</loc>

</sitemap>

</sitemapindex>

Das Problem besteht nun in den Produkt-Sitemaps. Die Parameter in der URL geben an, welche Produkt-URLs jeweils in der Sitemap-Datei enthalten sein sollen. Ändert sich etwas an dem Produktsortiment, so ändern sich auch diese Parameter. Ergo, werden gegenüber den Suchmaschinen neue Sitemap-Dateien erzeugt und die alten verschwinden aus der GSC. Übrigens mit dem gesamten Abdeckungsbericht. Da die neuen Sitemaps noch nicht eingelesen wurden, kann die Erhebung des Abdeckungsberichts etwas dauern. Für sich häufig ändernde Sortimente ist dieses Verhalten natürlich unglücklich. Vor allem, wenn es um eine schnelle und saubere Indexierung der Produkt-Detail-Pages (PDPs) geht.

Eine Lösung kann hier eine Art "Sitemap-Proxy-Hosting" mit einem selbst geschriebenen Prozess sein, der die Sitemaps regelmäßig ausliest und auf einer Subdomain als statische Dateien zur Verfügung stellt und in deren URLs keine Parameter mehr enthalten sind. Ich gebe zu, eine nicht ganz so schöne Lösung. Aber für Shopify-Shops mit großem Sortiment und häufigen Anpassungen eine Lösung, die funktioniert und recht kostengünstig ist.

|

|

|

|

|

Fragen? Immer gerne fragen!

|

Wir sind für Dich da.

Schreib uns gern jederzeit

eine E-Mail an [email protected] oder

ruf uns einfach kurz an: +49 40 22868040

Bis bald,

Deine Wingmen

|

|

Anckelmannsplatz 1, 20537 Hamburg, Germany

|

|