|

Wirklich wahres Wingmen SEO Wissen für wache Webmarketer #90

|

|

|

🎶 99 Problems, but my SEO-Lieblingsnewsletter ain’t one

|

|

Wir hoffen Du bist romantisch in die neue Woche gestartet, falls nicht hast Du hoffentlich nach dem Lesen der Überschrift immerhin einen Ohrwurm 🤸

Während es woanders rote Rosen regnete, stehen wir mit ein paar schönen SEO-Geschenken für Dich unter Deinem Balkon:

-

Flo entführt Dich aufs (T)Raumschiff SEO-Enterprise 🛸

-

Nils fachsimpelt über die wundervolle Welt der Favicons 🦄

-

Behrend erzählt Dir Gruselgeschichten über Webtracker 👹

-

Anita überbringt Dir liebevolle Nachrichten zu Hreflang aus dem SEO-Chat 💌

-

Und ich gehe mit Dir in den angesagten Bing Pub(Hub) 🍻

Falls Du uns auch beschenken möchtest, nimm an unserer

RegEx Umfrage auf LinkedIn

teil und verrate uns ob Du und RegEx ein perfect Match seid! 😊🌸

Viel Spaß beim Lesen

Deine Wingmen ❣️

|

|

|

Unterschätze nie die Kraft der internen Verlinkung

|

|

Deine Website, unendliche Weiten. Wir schreiben das Jahr 2022. Dies sind die Abenteuer des Siteschiffs Enterprise-SEO, das mit seiner 400 Mann starken Besatzung unterwegs ist, um neue irrelevante Links in die Website zu bauen... ja, ok, ich habe mich

hier

ein bisschen inspirieren lassen.

So lustig es sich im ersten Moment liest, so dramatisch ist es in großen Unternehmen mit verschiedenen Verantwortlichkeiten und nicht abgestimmten Zielen von Abteilung zu Abteilung. Insbesondere beim Thema interne Verlinkung sollte die Website jedoch ganzheitlich betrachtet werden und gehört daher federführend in die Hände von SEO mit tatkräftigem Support von UX. Hauptsache aber ganzheitlich.

Immer wieder gibt es dazu auch spannende Vorträge auf Konferenzen von erfahrenen Experten, die mit Case Studies beweisen wie stark der Impact und wie groß das Potenzial sein können. Johan hat jüngst dazu auf der SEOkomm in Salzburg dazu gesprochen und ein geniales Python-Script 4 free rausgehauen, dass sich großer Beliebtheit erfreut. So beliebt übrigens, dass der Vortrag auf der

SMX Advanced

im September in Berlin neu aufgelegt werden wird.

Auch ich habe zum Thema interne Verlinkung mehr als einmal auf der Bühne gestanden, auch auf der SMX für die ich an dieser Stelle einmal kurz Werbung machen möchte. 15% auf

SMX-Tickets

gibt es mit dem Code

WNGMNSMX

Die aktuell unter anderem vom sehr geschätzten Link-Experten Dixon Jones promotete

Case Study von Inlinks

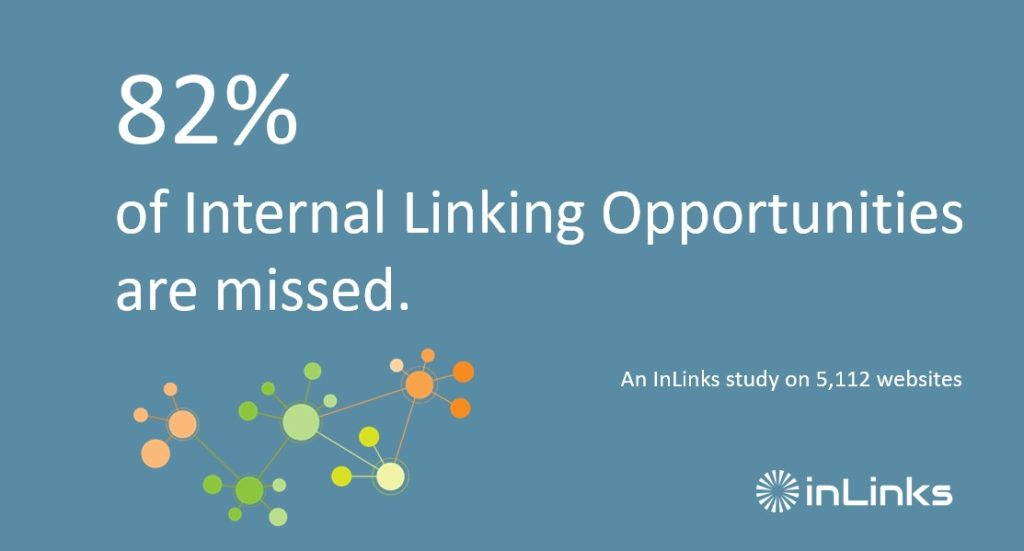

hat herausgefunden, dass 82% der internen Verlinkungschancen nicht genutzt werden.

Zugegeben ist so eine Studie von einem Anbieter für ein internes Verlinkungstool ein wenig biased, aber ausgehend davon, dass hier über 5000 Websites mit in die Studie eingeflossen sind, ist das schon sehr beachtlich.

Untersucht wurden Sites aus den verschiedensten Industrien vornehmlich in englischer Sprache. Ähnlich wie Johan es in seinem Script auch macht, werden zur Analyse die Links aus Hauptnavi, Footer, Sidebar, etc. herausgerechnet, um sich rein um die Links im Content zu kümmern. Das ist sehr hilfreich, um Probleme aufzudecken, erfordert aber immer einen gründlichen Double Check der Gesamtsituation bevor man mir nichts dir nichts den kompletten Linkgraph der Site zerschiesst.

Um die Links herauszufinden, die im Projekt fehlen könnten gehen die Kollegen von Inlinks wie folgt vor:

1. Mit einer semantischen Prüfung werden alle Entitäten einer Seite bestimmt -> schlau!

2. Der Seiteninhaber bestimmt dann - offenbar manuell - welche Seiten die wichtigsten sind. -> schlau! Warum die Maschine alles allein entscheiden lassen, wenn die Möglichkeit besteht menschliche Erfahrung mit Business, Industrie, Site, Produkt und Kunden einfließen zu lassen

3. Link-Vorschläge werden dann nach für mich diskussionswürdigen Kriterien vorgeschlagen:

-

wenn keine Links auf die ausgesuchte Zielseite bestehen -> Logisch, gehe ich mit!

-

wenn die Länge des Absatzes lang genug ist -> Angegeben werden hier >10 Worte -> hier würde ich gerne einmal ins Detail gehen. Jeder Absatz? Nur 10 Worte? Kann das im Deutschen funktionieren?

-

Konflikte mit bestehenden hard-coded Links werden ausgeschlossen -> Auch hier würde ich gern mehr Details erfahren. Nur weil da ein Redakteur einen Link gesetzt hat muss das noch lang keine gute Idee gewesen sein. Zu oft habe ich Schulungen in Redaktionen gegeben, die zuvor mit gefährlichem SEO-Halbwissen wilde Sau im Linkgraphen gespielt haben.

-

Der Kontext des Links zum Ziel wird überprüft und Silo-Regeln werden angewendet -> Let's talk! Das habe ich mehrfach in die Grütze gehen sehen wenn das ein Automat versucht, aber die Idee ist ja im Kern eine Gute.

-

Erschreckend sind die Ergebnisse der Studie. Satte 41% der Sites hatte nicht einen einzigen Link auf die definierten Ziele gesetzt.

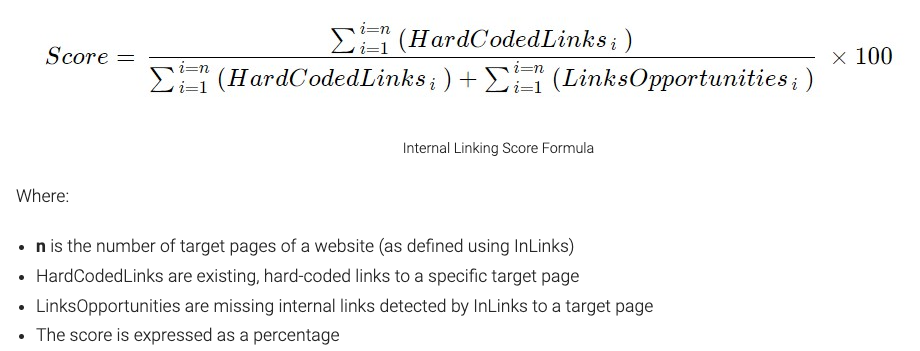

Als kleines Feature ist bei der Studie auch ein neuer Score zur Berechnung der internen Linkkraft herausgekommen:

Lies Dir die Studie unbedingt durch und bewerte die Einstellungen, Vorgehensweise und das Outcome selbstkritisch mit Blick auf Deine eigene Site.

|

|

|

Favicon Fun feinster Façon

|

|

Favicons. Tolle Sache, eigentlich. Ohne sie wäre wahrscheinlich jeder Browser-Nutzer, der mehr als drei Tabs benutzt, sehr schnell sehr orientierungslos. Mit ihnen kann man auch bei dreißig oder mehr Tabs noch (einigermaßen) den Überblick bewahren. Es soll ja sogar Menschen geben, die alle diese Tabs auch angeblich benutzen.

Aber nicht nur im Browser-Tab kann das Favicon für die Wiedererkennung nützlich sein. In den mobilen Suchergebnissen wird es auch neben der URL oben links im Snippet angezeigt. In der westlichen Leserichtung wahrscheinlich mit das erste, was man vom Snippet wahrnehmen kann. Natürlich gesetzt den Fall, dass es auch angezeigt wird.

Denn manchmal wird es das auch einfach nicht. Dann geht es auf die Suche. Woran könnte es denn liegen? Liegt die Datei womöglich in einem von der robots.txt gesperrten Verzeichnis? Oder ist die Bilddatei kaputt? Das sind jedenfalls klassische Beispiele. In unserem Fall war es diesmal ein wenig komplizierter. Denn die beiden genannten Möglichkeiten schieden schonmal aus, robots.txt war in Ordnung und die Bilddatei erreichbar. Trotzdem kein Favicon in den Suchergebnissen.

Bei einem harten Reload der Favicon-URL zeigte sich dann etwas spannendes. Nicht nur die angeforderte Bild-URL wurde geladen, sondern auch versucht, die Default-Favicon-Datei "favicon.ico" im Root-Verzeichnis zu öffnen damit er ein Favicon im Tab anzeigen kann. Das schlug in diesem Fall fehl, weil dort auch nichts lag. Normalerweise hätte die Startseite auf die richtige Location des Favicons hinweisen können. In diesem Fall befand sich die funktionale Startseite aber in einem Sprachfolder und die Root-URL leitete auf diese weiter.

Der Verdacht liegt also nahe, dass

Googles Favicon-Crawler

die Weiterleitung der Startseite nicht mitgeht und so den Verweis zur "echten" Favicon-Location nicht bemerkt hat. Interessant daran ist, dass oberflächlich erstmal alles zu stimmen scheint, weil alle relevanten URLs erreichbar sind. Am Ende scheitert es dann am Bot, der scheinbar von seinen Gewohnheiten nicht ablassen kann.

Ein gut gemeinter Rat: Wenn dich kein Umstand zwingt es anders zu machen, leg Dein Favicon einfach im Root ab. Viele Systeme nutzen nicht den Weg über das HTML und Du sparst Dir etwas Kopfzerbrechen. Dann noch dafür sorgen, dass die Referenzen auch sicher im HTML stehen und nicht nur im DOM, dann ist schon viel gewonnen.

Im Rahmen unserer Auseinandersetzung mit Favicons haben wir dann noch zwei weitere Tipps für Dich.

-

Favicons können heute viel mehr als ein Bild im Tab oder in den SERPs sein. Damit es überall ordentlich aussieht muss gar nicht viel getan werden. Einen guten Anfang kannst Du mit diesem

Favicon-Generator

machen.

-

Lies diesen Artikel über

Favicons im Jahr 2022

. Der bringt dich in ein paar Minuten englischer Lesezeit auf den aktuellen Stand.

Zum Schluss die vielleicht wichtigste Frage: wie sagt man eigentlich Favicon? Fave-Icon oder Fawikon?

|

|

|

Was ist eigentlich so schlimm an diesen Werbetrackern?

|

|

An dem ein oder anderen Newsletter-Artikel hast Du vielleicht schon gemerkt, dass das Thema DSGVO uns nicht loslässt. Die Gerichte und Datenschutzbehörden verkünden eine Entscheidung nach der nächsten.

Wenn man sich manche Beschlüsse durchliest, kann man zu dem Schluss kommen, dass ein einfacher CDN in Zukunft aus

Datenschutzgründen nicht mehr verwendbar

ist. Auf der anderen Seite haben diese Beschlüsse häufig gute Gründe und die meisten davon haben mehr oder weniger direkt mit Real Time Bidding zu tun.

Darum fand ich

diesen Vortrag von Johnny Ryan zu Real Time Bidding

und wieso der Status Quo der Online-Werbeindustrie Datenschutzrechtlich so problematisch ist besonders interessant.

Johnny Ryan war früher Chief of Policy bei Brave

und ist nun hauptberuflich Bürgerrechtler und Datenschützer. Der Vortrag hat also eine klare Agenda und das sollte man dabei natürlich im Hinterkopf behalten, genauso wie wenn sich Google oder Facebook zu dem Thema äußern.

Natürlich ist nicht die komplette Online-Werbebranche so böse wie hier dargestellt wird. Sicherlich verteilen nicht alle AdTech-Firmen die sensiblen Daten, ohne sich um Moral und Recht zu scheren. Aber es gibt mehr als genügend schwarze Schafe, sodass die beschriebenen Probleme real sind.

Wenn Du etwas mehr Zeit als Johan hast, und die fehlende Geschwindigkeits-Einstellung Vimeo nicht ganz so übel nimmst, wie er, schau Dir den

Vortrag

gerne selbst an.

Die ganze kurze Kurzfassung ist:

Für das Bieten auf Werbeplätze werden Nutzer mit Cookies identifizierbar gemacht und geben, wenn vorhanden, Informationen über den Nutzer preis:

-

Vieles ist relativ harmlos, wie "Nutzer interessiert sich für Autos"

-

Vieles ist aber grundsätzlich problematisch, angefangen bei Dingen wie Altersgruppe, Geschlecht oder ethnische Zugehörigkeit, die einer Diskriminierung Vorschub leisten können, bis zu Information mit extremer persönlicher und individueller Relevanz für einzelne Nutzer, wie zum Beispiel bei Geldproblemen oder Krankheiten.

-

und manche Informationen die, je nach genauer Situation, ebenfalls sehr sensibel sein können, wie besuchte URLs oder GPS Daten.

Die Nutzerinformationen werden für jede Anzeige die ausgespielt geteilt

-

im Hintergrund im Rahmen des Bietverfahrens an hunderte Third-Parties

-

ohne das es kontrollierbar oder auch nur nachvollziehbar ist, wer wann welche Information über einen Nutzer erhielt

-

und können im Hintergrund ggf. mit anderen Datenquellen verknüpft werden

Das daraus resultierende Targeting der Nutzer schadet aber nicht nur den Nutzern, sondern mittelbar auch denjenigen, die auf ihrer Domain Werbung anzeigen, und denjenigen, die Werbung buchen.

-

Publisher, die hochwertige Inhalte liefern, helfen dabei Nutzer zu charakterisieren, konkurrieren aber nicht mehr mit gleichwertigen Inhalten, sondern allen die der Nutzer besucht, was Preisverfall der Anzeigen zur Folge hat.

-

Intransparente Prozesse ermöglichen Betrug, wie Click-Bots, oder falscher Zuordnung von Conversions.

Über DSGVO, ePrivacy-Verordnung und Ähnliches arbeiten Legislative, Judikative und Exekutive daran, die bisherige Praxis nun immer weiter einzuschränken. Breite teile der "Ad Tech"-Industrie scheinen sich verzweifelt an den Status Quo zu klammern und reagieren eher träge. (🤔 Das Ads träge reagieren kommt mir von aus unzähligen Pagespeed Audits bekannt vor... vielleicht können die Prozesse eines neuen Status Quo auch etwas schneller ablaufen als "Real Time" Bidding.)

Soweit ich als Jura-Laie DSGVO, ePrivacy-Verordnung und Co verstehe, ist das bestehende Real Time Bidding schlicht nicht mehr legal, und auch Alternativen wie Googles Privacy Sandbox bewegen sich in einer Grauzone. Aber heutzutage kann man ja

nichtmal mehr Schriftarten einbinden ohne vor den Kadi gezerrt zu werden

.

Was wirklich bleibt, quasi als sichere Bank, ist das Contextual Advertising, also die Anzeige zu dem Inhalt schalten, nicht zu dem Nutzer. Für Publisher möglicherweise ein sehr interessantes Modell.

Vor fast genau einem jahr

hatte ich hier im Newsletter schon einmal einen

Wired-Artikel

referenziert, der gezeigt hat, dass das für Publisher sehr gut funktionieren kann. Und auch diejenige, die die Anzeigen schalten können davon profitieren, da

Werbung im passenden Kontext besser wahrgenommen

wird.

|

|

|

Hreflang SEO-Chat

|

|

#SEOchat ist ein wöchentlich stattfindendes Format, gehostet von

Mordy Oberstein

auf Twitter. In der Session Anfang Februar ging es unter der Regie von

Myriam Jessier

um ein Lieblingsthema von uns allen: Hreflang.

Wenn Du das Format noch nicht kennst: Alle dürfen mitmachen und die Fragen zum Thema beantworten und diskutieren. Ich war zum ersten Mal bei einem #SEOchat dabei und habe ein paar Tipps und Infos aus der Session für Dich zusammengetragen:

-

Gianna schwört auf Audisto

, wenn es darum geht, kaputte Hreflang-Gruppen zu entdecken

-

Samuel

nutzt gerne verschiedene Tools und wechselnde Locations via VPN für die Qualitätssicherung

-

Es gibt keine 1 fits all Lösung für die Startseite, da dies von vielen verschiedenen Faktoren abhängig sein kann. Es spielt beispielsweise auch eine Rolle, ob es eine Domain mit Subdomains oder Foldern ist oder eben doch mehrere eigene Domains pro Land - it depends, da sind sich unter anderem

Gianna

und

Lyndon

einig; mehr Antworten gibt's unter dem

Tweet

-

Die Praxis von automatischer Geo Detection und Redirection oder IP-basierter Weiterleitung hat wenige Fans. Vor allem

Alan

und

Gianna

sagen: NEIN! Und wir unterstützen das! Wir haben schon mehrfach erlebt, wie Google bei solchen Setups alle Varianten außer der amerikanischen aus den SERPs geworfen hat, weil das die einzige war, die der Googlebot noch crawlen konnte. Also: Lass bitte die Finger davon!

-

Neben Audisto, dem Screaming Frog und der Google Search Console sind für verschiedene Aufgaben rund um Hreflang zum Beispiel auch

Sitebulb und Content King

im Einsatz

-

Insbesondere das

Hreflang Tags Testing Tool von Merkle

und der

Hreflang Tags Generator von Aleyda Solis

werden von verschiedenen Menschen empfohlen - wenn Du die nicht kennst, sind sie sicherlich einen Blick wert!

-

Wir sind offenbar nicht die Einzigen, die darüber hinaus noch einiges an selbst gebastelten Tools, Scripten & Co im Einsatz haben

-

Die Antwort auf die Frage nach Hreflang Best Practices gestaltet sich schwierig und

Gianna fasst für uns zusammen, warum

:

"A5. 100% correct hreflang setup is not just about hreflang but:

-

canonicals

-

indexing directives (html head, http header)

-

internal linking

-

html lang

-

any other alternate URLs that might not be matching

-

correct content localisation and mapping

A5. Adding to this:

-

GSC settings (international targeting, exclusions)

-

parameter handling

-

ccTLD, gTLD

-

URL structure (domain, subdomain, directory, other unique identifiers)

-

database handling for automated mapping

-

crawling directives (robots.txt, HTTP headers)

A5.

And I am sure the longer I think of it, the more I find."

-

Dafür gibt es umso mehr

Hreflang Horror Stories

, unter anderem scheint es in einigen CMS wie Shopify diesbezüglich eher schwierig zu sein

Wenn Du generell noch mal nachlesen möchtest, sei Dir

Behrends umfassender Beitrag zu Hreflang

in unserem Wissensbereich ans Herz gelegt!

Wenn Du auch mal beim #SEOchat auf Twitter mitmachen möchtest, folge am besten

Mordy

.

Wenn Du eigene Erfahrungen, Tool-Tipps oder weitere Gedanken bezüglich Hreflang teilen magst, freuen wir uns!

|

|

|

Bi(n)g News 📰

|

|

Bing war laut seo-summary.de im Jahr 2021

die meist genutzte Suchmaschine in Deutschland nach Google. Deshalb hat Hannah in unserem Newsletter

"Alles neu macht der April"

auch Google und Bing für Dich verglichen.

Seit dem 08. Februar 2022 gibt es jetzt etwas Neues aus dem Hause Microsoft, das insbesondere für News Publisher interessant sein könnte:

Die

Bing News PubHub

Integration in den Bing Webmaster Tools!

🎉

Was ist PubHub und wie soll es funktionieren?

PubHub soll die

Reichweite von News-Redaktionen steigern

und Zielgruppen vergrößern, indem der Content breiter gestreut wird. Das Angebot richtet sich dabei an Nutzer von Windows 10/11 und Outlook. Zusätzlich zum Browser werden die Inhalte dabei über den Outlook News Connector sowie in der Bing-Such-App auf iOS und Android geteilt. Die Artikel erscheinen dann unter anderem bei

Microsoft Start

, innerhalb der Bing News und im Feed.

Wie kannst Du Dich für PubHub anmelden?

Die Voraussetzung für PubHub ist ein

Account in den

Bing Webmaster Tools

und eine Bestätigung der Nachrichten-Website. Im zweiten Schritt kann dann ein

Anmeldeformular für Bing News PubHub ausgefüllt

werden, um die Verifizierung zu beantragen. Damit die Verifizierung erfolgreich ist, sollten einige Punkte beachtet werden, wie beispielsweise, dass die Artikel einen gewissen Nachrichtenwert erfüllen und erkenntlich ist, dass die Informationen aus einer vertrauenswürdigen Quelle stammen. Alle Voraussetzungen findest Du in den

Bing News PubHub Guidelines für Newspublisher

.

Übrigens

Bing PubHub ist eigentlich gar nicht neu

. Bereits 2016 war es möglich, News über

pubhub.bing.com

einzureichen. Neu ist nur die Integration innerhalb der Bing Webmaster Tools.

Ich bin auf jeden Fall gespannt, ob durch PubHub wirklich die versprochene Reichweite erzielt werden kann - was meinst Du? 🤔

|

|

|

|

|

Fragen? Immer gerne fragen!

|

Wir sind für Dich da.

Schreib uns gern jederzeit

eine E-Mail an

[email protected]

oder

ruf uns einfach kurz an:

+49 40 22868040

Bis bald,

Deine Wingmen

|

|

Anckelmannsplatz 1, 20537 Hamburg, Germany

|

|