| Wirklich wahres Wingmen SEO Wissen für wache Webmarketer #182 |

|

| 🎮 Spannende SEO-Spielchen |

Letzte Woche haben wir uns live gesehen und das war schön. ❤️

Während der ein oder andere Wingmensch noch das Boßel- und Grünkohlspektakel vom Wochenende verdauen muss, stehen die anderen schon wieder in den Startlöchern.

Auch dieses Jahr geht es für einen Teil des Teams ins schöne Salzburg zur SEOkomm. Dabei freuen wir uns nicht nur auf spannende Vorträge und tolle Gespräche: Du kannst dieses Jahr auf der SEOkomm mit uns Och Menno! GUUHGL spielen inklusive exklusiver SEOkomm-Spielkarten. Komm gerne vorbei! 🎉

Falls Du nicht dabei bist, bringen wir die neusten News natürlich nächste Woche mit. 🙂

Um die Wartezeit zu überbrücken, haben wir auch diese Woche Lesestoff für Dich:

Annemieke zeigt Dir, wie Du Deine Konkurrenz in Google Discover spielerisch besiegst Behrend hat die Asse im Ärmel und berichtet Dir, wie bei OpenAI die Karten gemischt werden Anita geht all-in mit einem richtig respektablen robots.txt-Report Philipp erklärt Dir, warum Du Spam gnadenlos vom Spielbrett fegen solltest Motivationskönigin Hannah ruft Dich in die Bühnen-Spielarena

Viel Spaß beim Lesen ❣️

Deine Wingmenschen

|

|

| Dein Erfolgsrezept für mehr Discover-Traffic! 🚀 |

Lily Ray gibt Dir in ihrem Artikel bei MOZ reichlich Tipps und Tricks an die Hand, wie Du Deinen Traffic in Google Discover steigern kannst. Ich gebe Dir hier eine Checkliste mit allen wichtigen Aspekten mit auf den Weg.

Google Discover und die herkömmliche Google-Suche sind unterschiedlich. Das bedeutet auch, was in der Google Suche funktioniert, funktioniert nicht immer in Discover. Das liegt daran, dass die Google-Suche dem Pull-Marketing zugeordnet wird, Discover aber dem Push-Marketing.

1. Optimiere Deine Bilder

Nutze für Google Discover große, hochwertige Bilder (mind. 1200 px Breite) – eines pro Artikel genügt. Setze das Meta-Tag "max-image-preview:large" ein, um eine große Bildvorschau zu ermöglichen und die Klickrate zu verbessern.

Bei Verwendung von WordPress mit Yoast geschieht dies automatisch. Ein Chrome-Plugin hilft, die Darstellung in Discover zu prüfen.

2. Content und Website-Richtlinien einhalten

Gewährleiste die Übereinstimmung mit den Content-Richtlinien von Google für News und Discover. Discover zeigt Nutzern relevante und interessante Inhalte basierend auf ihrer Suchhistorie, Standort und anderen Daten. Nutzerstandort und Spracheinstellungen beeinflussen ebenfalls, was in Discover angezeigt wird.

3. Stelle sicher, dass Deine Website im Google Publisher Center registriert ist

Registriere Deine Website im Google Publisher Center, um sie in Google Discover zu integrieren. Gib dort Inhaltskategorien, Ziel-Land und Webseitenbereiche an.

Google indexiert Inhalte von Feeds oder Kategorieseiten und akzeptiert URLs, Feeds für spezifische Bereiche sowie YouTube-Kanäle für Playlists. Zusätzlich kannst Du personalisierte Feeds für Google News einreichen.

4. Implementiere die Follow-Funktion gemäß den Anweisungen von Google

Google fördert die "Follow"-Funktion" in Google News und Discover, die Chrome-Nutzern erlaubt, Publikationen zu folgen. Die Aktivierung dieser Funktion für Deine Publikation kann die Sichtbarkeit Deines Inhalts in Discover erhöhen, wenn Nutzer Deiner Seite folgen.

Diese Funktion ist allerdings derzeit nur für angemeldete Nutzer in den USA, Neuseeland, Südafrika, dem Vereinigten Königreich, Kanada und Australien verfügbar.

5. Analysiere die Interessen Deiner Zielgruppe

Google Discover personalisiert Feeds basierend auf Nutzerpräferenzen und Aktivitäten.

Um Deinen Website-Traffic zu steigern:

Analysiere die erfolgreichsten Inhalte Deiner Website aus den letzten 16 Monaten über die Google Search Console (API-Nutzung empfohlen) Ermittle die Traffic-treibenden Themen und Entitäten mit Datenanalyse-Tools und untersuche Trends mit Social Listening Erstelle eine Google-Persona Deiner Zielgruppe, um Einblicke in potenzielle Inhalte ihres Feeds zu erhalten

6. Erstelle keinen irreführenden Content

Google Discover kann manuelle Strafen für Inhaltsverstöße verhängen, wie irreführende medizinische Informationen oder Gewalt. Kenne die Richtlinien, um Strafen zu vermeiden.

Verbreitete Verstöße sind irreführende Titel. Bei Strafen musst Du den Inhalt korrigieren und eine Rezension anfordern. Prüfe den Search-Console-Bericht regelmäßig auf manuelle Maßnahmen.

7. Isoliere NSFW-Inhalte auf separaten Subdomains

Veröffentliche keine unangemessenen oder nur für Erwachsene geeigneten Inhalte, um in Google Discover zu erscheinen. Google filtert diese heraus. Inhalte, die SafeSearch ausschließt, erscheinen selten in Discover.

Selbst wenige unangemessene Inhalte können die Sichtbarkeit Deiner Domain in Discover verringern. Isoliere NSFW-Inhalte auf einer eigenen Website oder Subdomain, um den Discover-Traffic zu maximieren.

Eine Website, die gewalttätige Inhalte entfernte, erlebte eine sofortige Steigerung des Discover-Traffics.

8. Erkenne die Bedeutung des richtigen Bildes

Die Bildauswahl ist entscheidend für mehr Discover-Traffic. Bilder mit bekannten Gesichtern oder im Mehr-Panel-Format erhöhen die Klickrate. Infografiken können ebenfalls effektiv sein. Vermeide unscharfe Bilder, da sie die Klickrate senken. Optimiere Deine Bildstrategie durch Analyse der Bilder in Deinen Top-Artikeln.

9. Verfasse ansprechende Überschriften, die für Discover optimiert sind

Für hohe Klickraten in Google Discover sind Überschrift und das Feature-Bild wichtig. Google nutzt oft den Open Graph (OG)-Titel für Discover. Achte auf die Balance zwischen ansprechenden Überschriften für Discover und SEO.

Integriere Nutzerengagement, SEO, User Experience und Markenimage in die Wahl der Überschrift. Teste "Discover-freundliche" OG-Titel und wende SEO-Praktiken auf <title> und <h1> an. Anpassungen von H1 können die Discover-Performance steigern, wobei Googles Richtlinien einzuhalten sind, um Strafen zu vermeiden.

10. Lenke den Traffic mit Web Stories & Videos auf Deinen Beitrag

Web Stories sind ein gutes Tool für mehr Sichtbarkeit in Google Discover, ideal für Seiten ohne bisherigen Discover-Traffic. Sie können Traffic und Werbeeinnahmen erhöhen, unterstützt durch Googles eigene Ressourcen. Auch YouTube-Videos steigern durch Discover die Markensichtbarkeit.

11. Achte auf die durchschnittliche Lebensdauer Deiner Discover-Artikel

Beobachte die kurze Lebensdauer von Artikeln in Google Discover und aktualisiere sie zeitnah mit relevanten Informationen. Vermeide belanglose Updates, die von Google negativ gesehen werden könnten. Erstelle verwandte Artikel zu bereits erfolgreichen Themen. Halte Inhalte hochwertig, um Googles Strafen zu vermeiden, und frische ältere, erfolgreiche Beiträge auf, um erneut Traffic zu gewinnen.

12. Behalte Google-Updates im Auge und passe Deine Strategie entsprechend an

Google kommuniziert klar, dass Updates auch Einfluss auf die Performance in Discover haben können. Wenn Du einen Einbruch in Discover feststellst, kannst Du Deine Inhalte anhand der Guidelines zu Discover und hilfreichen Inhalten selbst prüfen.

13. Sei vorsichtig bei der Syndikation von Artikeln auf Partnerseiten

Beachte den Einfluss von Artikel-Syndikation auf die Sichtbarkeit in Google Discover. Google kann bei syndizierten Inhalten die Originalquelle schlecht erkennen, was oft dazu führt, dass die Partnerseite in Discover und News angezeigt wird. Das kann den Traffic für Partner erhöhen. Obwohl Google noindex für Syndikation empfiehlt, lehnen viele Partner dies ab. Websites, die Syndikation nutzen, müssen mit möglichem Verlust von Discover-Traffic rechnen.

Bisher gab es Discover nur auf den Mobilgeräten. Möglicherweise ändert sich das bald, wie ein Test vermuten lässt. Wäre definitiv spannend, da die Integration direkt im Chrome Browser unter dem Suchschlitz getestet wurde.

Die für mich wichtigste Botschaft aus Lily's Artikel:

"Google Discover is, by nature, extremely volatile and unpredictable."

Man kann sich über den Traffic freuen, sollte aber nicht mit ihm planen wie mit organischem Traffic aus der klassischen Suche...

|

|

| Wildes Wochenende wegen wichtiger Wegbereiter wechselwirkender Wissensdatenbanken 🎢 |

OpenAI hat ein turbulentes Wochenende hinter sich. Jetzt sieht es so aus, als hätte der Staub sich gelegt und der neue Status quo stünde. Aber ich garantiere Dir explizit nicht, dass sich zwischen dem Redaktionsschluss und dem Zeitpunkt, an dem Du dies liest, sich nicht noch etwas Neues ergeben hat.

Was ist passiert?

Am Freitag hat Open AI unvermittelt den CEO Sam Altman rausgeworfen, da er (laut Vorstand) nicht immer ehrlich gegenüber dem Vorstand war. Natürlich wurden keine Details genannt und insgesamt kam es für Außenstehende unerwartet.

Auch intern war das wohl nicht durchdacht und noch während des Wochenendes starteten Verhandlungen zu seiner Rückkehr. Dabei war Sam Altman selbstbewusst und hatte prophezeit, dass es das erste und letzte Mal sein wird, dass er mit einem Besucherausweis ins OpenAI-Office geht. Seine Forderung für eine Rückkehr knüpfte er an die Forderung, dass der Vorstand, der ihn rausgeworfen hatte, selbst zurücktritt.

Microsoft kündigte zwar an, weiter mit OpenAI zusammenzuarbeiten, aber in der Zwischenzeit hatten einige wichtige Mitarbeiter ihren Hut genommen.

Der Druck auf den Vorstand war aber nicht stark genug. Und so kündigte OpenAI am Sonntag Emmett Shear (ehemals CEO von Twitch) als neuen CEO an.

Microsoft schien Sorge zu haben, dass Altman ihnen mit einem neuen Startup Konkurrenz macht (oder schlimmer noch bei Google). Daher haben sie ihn und andere Mitglieder des Teams schnell selbst unter Vertrag genommen. Es liegt nahe, dass er in der Zusammenarbeit zwischen Microsoft und OpenAI weiterhin eine wichtige Rolle spielen wird. Das könnte sicherlich eine interessante Zusammenarbeit werden... Sofern bei OpenAI überhaupt jemand übrig bleibt, mit dem Altmann zusammenarbeiten könnte.

So droht inzwischen der Großteil der Mitarbeiter, inklusive eines Vorstandsmitglieds, das für die Entlassung zumindest mitverantwortlich war, mit ihrer Kündigung. Während Microsoft scheinbar allen OpenAI-Mitarbeitern angeboten hat, Altman zu folgen.

Warum ist es passiert?

Sicheres Wissen gibt es hierzu noch nicht. Selbst wenn wir uns nur auf das Verhalten und die Motivation Altmans konzentrieren, schießen die Optionen ins Kraut:

Sam Altman hat sich persönliches Fehlverhalten zuschulden kommen lassen (Unwahrscheinlich, dann wären nicht der Großteil der Firma mit ihm gegangen) Sam Altman hat mit weiteren Startups und Nebenprojekten zu sehr von Geschäftsgeheimnissen von OpenAI profitiert und den Vorstand hierzu hinters Licht geführt (Plausibel) Sam Altman lag entweder zu sehr auf der Seite der Profitabilität zu Ungunsten der Sicherheit (Der Durchbruch von ChatGPT war auch OpenAI-intern eine große Überraschung, vielleicht hatte er jetzt zu große Dollar-Zeichen in den Augen, um diese einmalige Gelegenheit zu nutzen) Oder Sam Altman stand zu sehr auf der Seite der Sicherheit, um die Zivilisation nicht mit Generative AI zu vernichten (Dem Vorstand könnten angelegte Handbremsen kommerziell missfallen haben)

Die Auswirkungen dürften sich erst in den nächsten Wochen und Monaten final abzeichnen.

Wir greifen dennoch zum vorweihnachtlichen Spekulations-Spekulatius:

Die Ankündigung von Microsoft, weiter OpenAI zu unterstützen, dürfte nicht viel wert sein. Die Möglichkeit, jetzt die spannendsten Personen aus dem Umfeld ins eigene Team zu holen, ist eine gute Möglichkeit, die anderen Investoren auszubooten. Wichtige Player und wichtiges Knowhow gehören jetzt Microsoft. Damit wird es möglich, die eigenen Applikationen unabhängiger von OpenAI zu entwickeln (für die Office-Suite und Bing-Suche). Das Interesse, OpenAI zu unterstützen, sinkt. Damit dürften die Kosten für OpenAI steigen. Microsofts Interesse ist jetzt eher die Verluste zu minimieren. Als strategische Kooperation ist der Wert von OpenAI massiv gesunken. Für die Wettbewerber (Antrophic, Bard, etc.) ist es ein günstiges Zeitfenster aufzuholen und den Markt spannender zu machen. OpenAIs Innovationsgeschwindigkeit dürfte in den nächsten Wochen nachlassen, weil die Mitarbeiterinnen und Mitarbeiter erstmal damit beschäftigt sind zu schauen, wer gegangen und wer geblieben ist und wie sich die Teams und Prios unter dem neuen CEO neu finden. Oder sie sind dabei, sich in den neuen Strukturen bei Microsoft einzufinden. So oder so muss Emmett Shear die Scherben aufkehren, die das Wochenende hinterlassen hat.

Schön aber zu sehen, wie das Unternehmen, das das Online Marketing dieses Jahr stärker geprägt hat als jedes andere, auch die Grundlage legt, dass 2024 nicht langweilig wird.

|

|

| Richtig respektabler robots.txt Report mit Recrawl-Knopf 🤖🕷 |

Na, hast Du den neuen robots.txt-Report in der Google Search Console schon entdeckt? Seit letzter Woche ist dieser neue Bericht in der GSC verfügbar. Er löst den alten robots.txt-Tester ab, den Du vielleicht noch aus früheren Instanzen der GSC kennst.

Johan hat den robots.txt-Report noch vor der offiziellen Info entdeckt und freut sich:

"Hurra, ein Recrawl-Button. Jetzt muss man mit dem alten Bericht keine komischen Verrenkungen mehr machen!"

Okay, Moment, nochmal einen Schritt zurück! Falls Du Dich fragst, was das für ein Report sein soll: Mit seiner Hilfe erhältst Du Aufschluss darüber, ob Google Deine robots.txt-Dateien verarbeiten kann – und wenn nicht, wieso es Probleme gibt. Außerdem kannst Du bei Bedarf ganz unkompliziert einen Recrawl anstoßen.

Achtung! Den Report gibt es nur für Properties auf Domain-Level (also Domain-Properties oder URL-Prefix-Properties ohne Pfad). Aber logisch, die robots.txt-Datei liegt ja bekanntlich auch im Root der Domain.

Über diesen Link kannst Du ganz einfach zum robots.txt-Report in der GSC hüpfen, nachdem Du eine Property ausgewählt hast.

Du findest den Report aber auch, indem Du links unten in der GSC-Navigation auf "Settings" klickst. Da findest Du dann im Bereich "Crawling" einen "Open Report"-Button.

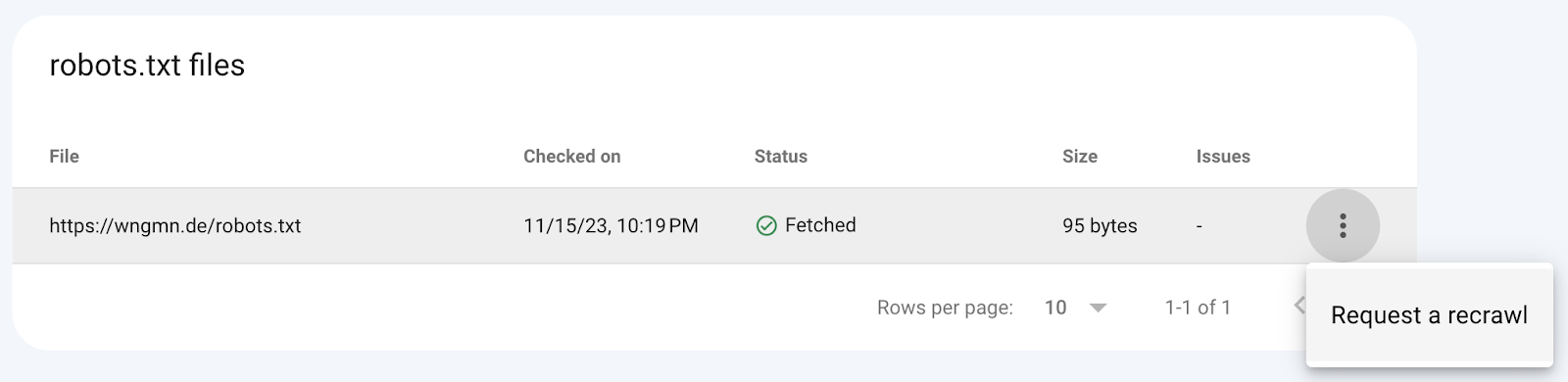

Bei uns sieht das Ganze überschaubar aus: Neben der URL werden der Zeitpunkt des letzten Checks sowie der Status (grüner Haken = alles paletti) und die Größe der Datei vermerkt. Wenn es Probleme gibt, werden diese hier ebenfalls aufgeführt. Am Ende der Zeile gibt es dann das Feature, das Johans Augen leuchten lässt: Hinter den drei kleinen Punkten verbirgt sich die "Request a recrawl"-Funktion.

Für den Fall, dass etwas nicht OK ist, kann der Status anstelle des grünen Hakens auch ein rotes Ausrufezeichen haben und beispielsweise so lauten:

"Not Fetched – Blocked due to unauthorized request (401)"

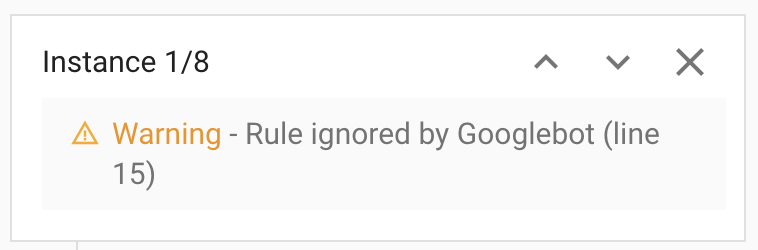

Es kann aber auch sein, dass es beim Fetchen keine Probleme gab, mit der robots.txt-Datei aber schon. Dann liefert Google zu jedem Punkt, mit dem es Schwierigkeiten gibt, einen Hinweis. Im Beispiel gibt es eine Reihe von Regeln, die Google ignoriert. Zu jeder Instanz findest Du auch eine Zeilenangabe und ein Highlight im Code.

In den meisten Properties, die ich mir gerade in unserer GSC angeschaut habe, gibt es nur eine robots.txt-Datei. Insbesondere natürlich bei URL-Prefix-Properties ist das nicht überraschend.

In einigen Domain-Properties gibt es pro Subdomain (www und non-www zum Beispiel) und teilweise auch für HTTP und HTTPS eine robots.txt-Datei.

Probleme scheinen eher selten zu sein. Was ich aber spannend finde, ist die große Varianz in der Größe der Datei – zweistellig, dreistellig, vierstellig – alles ist dabei. No surprise, insbesondere in den größeren Dateien gibt es tendenziell eher Fehler.

Interessante Hinweise aus der Doku zum Report:

Wenn Google keine robots.txt-Datei finden kann, geht Google davon aus, das alles gecrawlt werden darf ohne Einschränkungen Wenn Google eine robots.txt-Datei findet, diese aber nicht abrufen kann, wird das Crawling erstmal pausiert und für 12 Stunden versucht, die robots.txt-Datei zu erreichen und ansonsten auf die zuletzt verfügbare Version zurückgegriffen Das gilt aber nur für maximal 30 Tage, danach passt Google das Verhalten nochmals an

Mehr Fun Facts zur robots.txt findest Du übrigens in diesem sehr ausführlichen Wissensartikel von Johan.

Interessanterweise scheint es den früher verfügbaren robots.txt Tester nicht mehr zu geben. Stattdessen empfiehlt Google, doch einfach nach einem Third Party robots.txt-Tester zu googlen oder (in Form von einer Empfehlung von John Mu auf Linkedin) den Screaming Frog zu nutzen.

|

|

| Ads Gone Wild 🐗 und Programmatic Spam 🥫🥩 |

Nach den großen Vorwürfen, wir SEOs würden das Internet schlecht machen, hier ein paar Tipps, wie man eine gute User Experience ermöglicht – oder eine schlechte vermeidet. Vor einigen Wochen habe ich über Helpful Content Update (HCU), Ads & Co. geschrieben. Dies ist Teil 2, der sich hauptsächlich auf diesen Artikel bei Search Engine Land (SEL) bezieht.

Werbeanbieter sind NICHT Dein Freund

Der Artikel von SEL beschreibt die unglaublichen Ratschläge, die gegeben werden, um Werbung auf der eigenen Website zu platzieren. Hier einige Beispiele:

Auto-Play Video Ads, die mitscrollen Längere Artikel, um mehr Werbung unterzubringen Ad Density (= Verhältnis von Werbung zu Inhalt) von +30%

Es gibt keine optimale Textlänge, um für ein Keyword zu ranken? Sehr gut, dann packen wir mehr Werbung rein, indem wir den Artikel künstlich strecken. 😂

Wie wäre es mit Jump Links, um die Navigation zu erleichtern? Sehr gut, die Nutzer*innen springen zu den Ads, anstatt zum Content. 😂

Wie wäre es mit Auto-Play Videos, um vom eigentlichen Inhalt abzulenken? Sehr gut, die lieben wir alle. 😂

Helpful Content bedeutet nicht, dass der Content länger ist. Es bedeutet auch nicht, dass jemand einen ultimativen Guide schreibt. Helpful Content ist Content, der auf echter Expertise beruht, und die kann nur von denen vermittelt werden, die eigene Erfahrungen haben. Ansonsten handelt es sich oft nur um eine Illusion von Wissen und Weisheit.

Nein, nein, nein, lass den Spam sein

Auch die Frage, ob Google etwas gegen KI-Inhalte hat, wird oft diskutiert. Kurz: Nein. Lang: Es gibt Nuancen. Wenn KI mit dem primären Ziel eingesetzt wird, gut zu ranken, dann mag Google das nicht. Aber das ist unabhängig von KI. Der genaue Wortlaut von Google:

"If you use automation, including AI-generation, to produce content for the primary purpose of manipulating search rankings, that's a violation of our spam policies."

Programmatic SEO wird von John Müller unter anderem deshalb als Spam bezeichnet, weil sie darauf abzielt: Gute Rankings in der Suchmaschine. Eigentlich ist es ganz einfach: Wenn Deine Website keinen Mehrwert bietet und nur bereits vorhandene Inhalte wiederkäut, dann sind die Inhalte nicht hilfreich.

Es geht also auch um das Konzept des Informationsgewinns (oder Information Gain). Bietet mein Ergebnis zur Suchanfrage einen einzigartigen Mehrwert im Vergleich zu anderen Suchanfragen? Als Merkformel: Kein Mehrwert = nicht hilfreich.

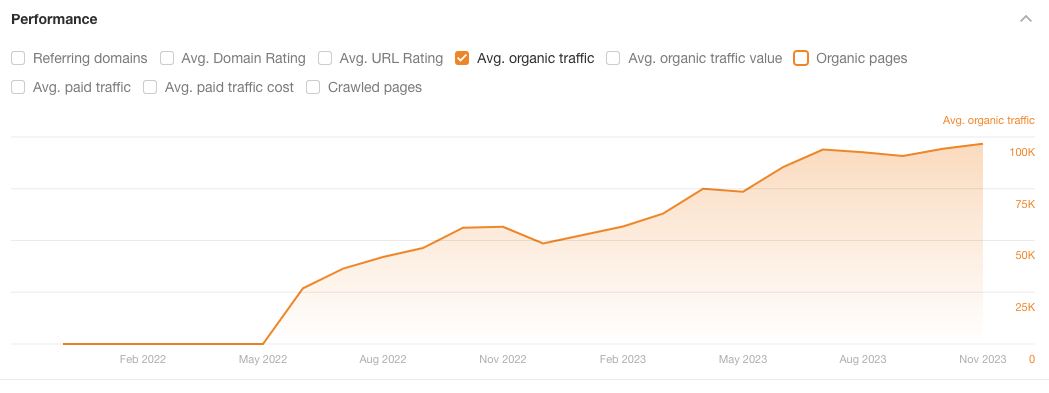

Dass man Programmatic SEO auch anders machen kann, beschreibt Ryan Law in einem Artikel von Ahrefs. Wenn Du die Möglichkeit hast, auf eigene Daten zurückzugreifen, dann bietet Dein Programmatic SEO Content einen einzigartigen Mehrwert:

"Proprietary data: original data that is unique to you, your company, or your product. This is the most desirable data type: you can provide information no one else has."

Eines der von Ryan genannten Beispiele ist "Made in Webflow".

Performance des Verzeichnisses von https://webflow.com/made-in-webflow in Ahrefs\

Ich habe in der Vergangenheit mit Webflow gearbeitet und Seiten für verschiedene Kunden erstellt. Ich bin fest davon überzeugt, dass jeder Nutzerin diese Inhalte als hilfreich empfindet. Und dann ist es auch richtig, dass dies in der Suchmaschine belohnt wird.

|

|

| Traust Du Dich eigentlich auf die Bühne? 💪🗣️🎭 |

Ich habe vorletzte Woche meine erste Talkrunde moderiert als Teil des dreitägigen Online Events Stage Queens Unite.

Zu Gast waren Nina Roser, Sara Schwartz sowie Sarah Sunderbrink und ich habe sie dazu befragt, wie sie es auf die Bühnen geschafft, welche Hindernisse sie dabei überwunden haben und wie sie etwaige Hürden meistern.

Warum das Ganze? Ich habe das Gefühl, dass wir Frauen uns zu oft zu viele Gedanken machen:

Diese Steine, die viele von uns sich selbst in den Weg legen, wollten Vivienne Goizet, Alicja Wajs und ich beiseite räumen.

Wie sieht es mit Dir aus? Gehst Du auf Konferenzen? Hörst Du zu oder sprichst Du schon selbst? Fehlt Dir noch die Auswahl eines Themas?

Du musst das Rad nicht neu erfinden... Hast Du vielleicht eine tolle Analyse gemacht – ob erfolgreich oder nicht – sicherlich kannst Du wertvolle Insights zu Erfolgen oder Misserfolgen mit anderen teilen.

Auch wir Wingmenschen sind immer wieder auf der Suche nach Themen und spannenden Use Cases, zu denen wir sprechen könnten, denn es macht uns (wie Du als fleißige/r Leser/in unseres Newsletters sicherlich schon gemerkt hast) einfach Spaß, unser Wissen zu teilen und so (zumindest ein Stück weit) einen positiven Einfluss auf die Online-Suche zu nehmen.

Die wertvollsten Tipps, die ich Dir mitgeben kann, sind:

⭐ Nur Du kannst ein bestimmtes Thema aus Deiner Perspektive beleuchten. Also wird es immer ein Mehrwert sein und sich von anderen Vorträgen zu dem Thema unterscheiden

⭐ Such Dir ein Thema, für das Du brennst und nutze Linkedin für Eigenwerbung! Danke Britta Behrens 💡 für Deinen wertvollen Input dazu

⭐ Geh auf die Bühne und hab Spaß 🤩

⭐ Bevor du auf die Bühne gehst, übe die Power Pose – streck Dich, mach Dich groß, Kopf nach oben → Du packst das! 🚀

⭐ Mach Pausen! Erlaube Dir und Deinem Publikum durchzuatmen

⭐ Ein bekanntes oder freundliches Gesicht im Publikum kann helfen

➡️ Hier also mein Aufruf an Dich: Wenn Du in einem Vortrag sitzt, dann lächel dem/der Vortragenden zu und nicke auch gern mal. So kann sich die Person auf der Bühne ein bisschen mehr entspannen und beim nächsten Mal bist es vielleicht Du auf der Bühne.

|

|

|

|

|

Fragen? Immer gerne fragen!

|

Wir sind für Dich da.

Schreib uns gern jederzeit

eine E-Mail an [email protected] oder

ruf uns einfach kurz an: +49 40 22868040

Bis bald,

Deine Wingmenschen

|

|

Anckelmannsplatz 1, 20537 Hamburg, Germany

|

|