|

Wirklich wahres Wingmen SEO Wissen für wache Webmarketer #98

|

|

|

🍞 🍍🍖 Toast Hawaii fühlt sich immer ein wenig an wie aufgeben

|

|

Mit dieser Weisheit aus unserem Freitagabend-Call möchten wir Dich herzlich zu diesem Newsletter willkommen heißen.

Geäußert hat Behrend das, nachdem Saskia fragte, ob Schinken-Ananas als Kombination grundsätzlich zulässig sei.

Die Mehrheit* meinte, dass die Kombination ginge und es letztlich egal sei, ob man das auf Toast, Croque oder Pizza packt. Neu für uns, aber irgendwie passend: Der Toast Hawaii geht angeblich auf das

amerikanische Grilled Spamwich zurück

.

Mit diesem kontroversen Intro rein ins Menü der Woche:

-

Jolle hat als Gruß aus der Küche eine kleine Tool-Vorstellung vorbereitet

-

Caro filetiert fieses Filter-Verhalten in der GSC zur For- äh Vorspeise

-

Behrends Zwischengang kommt mit geheimnisvollen GA4 Dimensionen daher

-

Hannahs Hauptgang macht Dich zum Local-Hero im Lokal

-

Anita serviert zum Dessert eine Portion Durchblick für den Coverage Report der GSC

Bon appétit!

* Dies ist keine offizielle Meinung der Wingmen Online Marketing GmbH, sondern Meinung des Autoren dieser Einleitung und einzelner Teammitglieder. Wingmen Online Marketing gibt prinzipiell keine kulinarischen Empfehlungen. Kulinarisches Oberhaupt der Firma ist übrigens

unser Chef Koch

.

|

|

|

Answer The Public vs. AlsoAsked

|

|

Für die Themen- und Keywordrecherche gibt es jede Menge Tools, die sich für ein erstes Brainstorming kostenlos nutzen lassen, um auf Themen für Landingpages oder Blogposts zu kommen. Vielen fällt direkt die alte Animation von

answerthepublic.com

ein, bei der ein Typ "grimmiger Seebär" ungeduldig auf die Eingabe wartete, bevor er zig Permutationen Deiner Abfrage ausspuckt. Heute tritt einem ein putziger Roboter entgegen.

Mark Williams-Cook

, Consultant bei den UK-Kollegen von

Candour

, hat mit

alsoasked.com

ein weiteres nützliches Tool entwickelt. Was sind die Parallelen, was die Unterschiede zwischen beiden?

Answer The Public

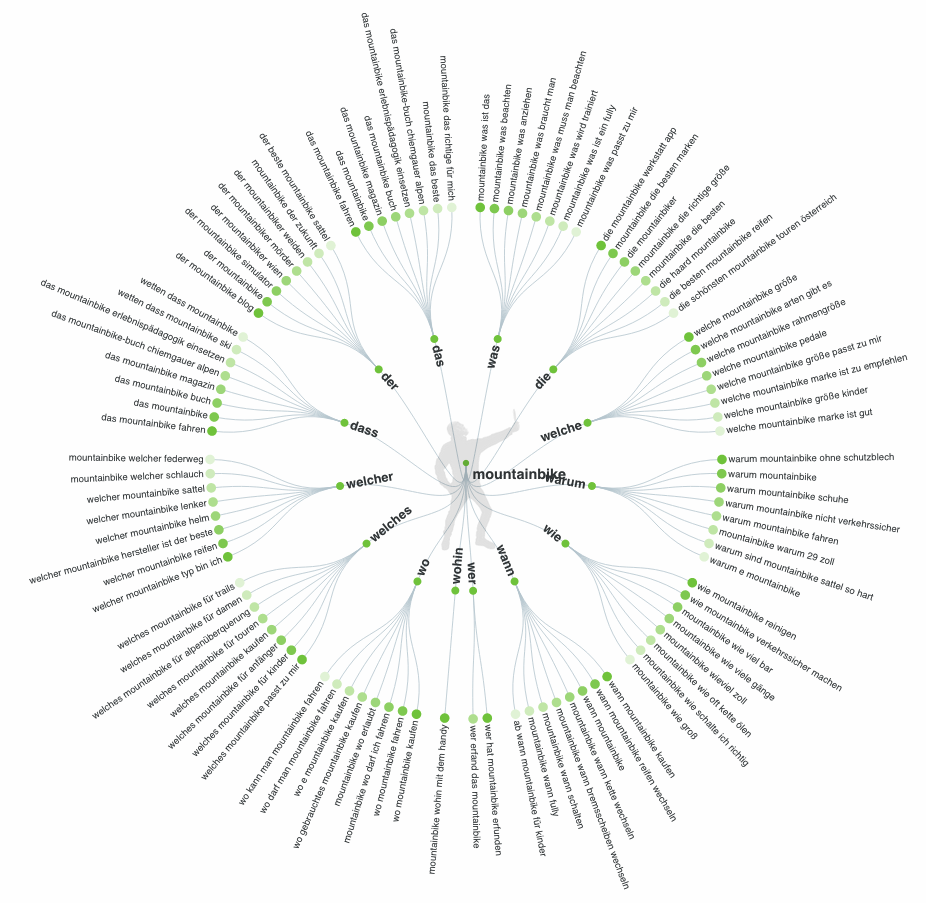

Answer The Public greift auf Google-Suggest-Daten zu – also die Vorschläge, die einem Google direkt am Suchschlitz macht, noch während man seine Suchanfrage eingibt.

Das Tool rät deshalb dazu, nur 1-2 Wörter einzugeben, also mit einem Seed-Keyword zu starten, um dann vor und nach dem Begriff alle möglichen Buchstabenkombinationen und Fragewörter zu ergänzen.

Was Seed-Keywords sind, und wie man sie recherchiert, hat

ahrefs kürzlich hier aufgeschrieben

. Der Output für "mountainbike" für Deutsch in Deutschland sieht zum Beispiel so aus:

AlsoAsked

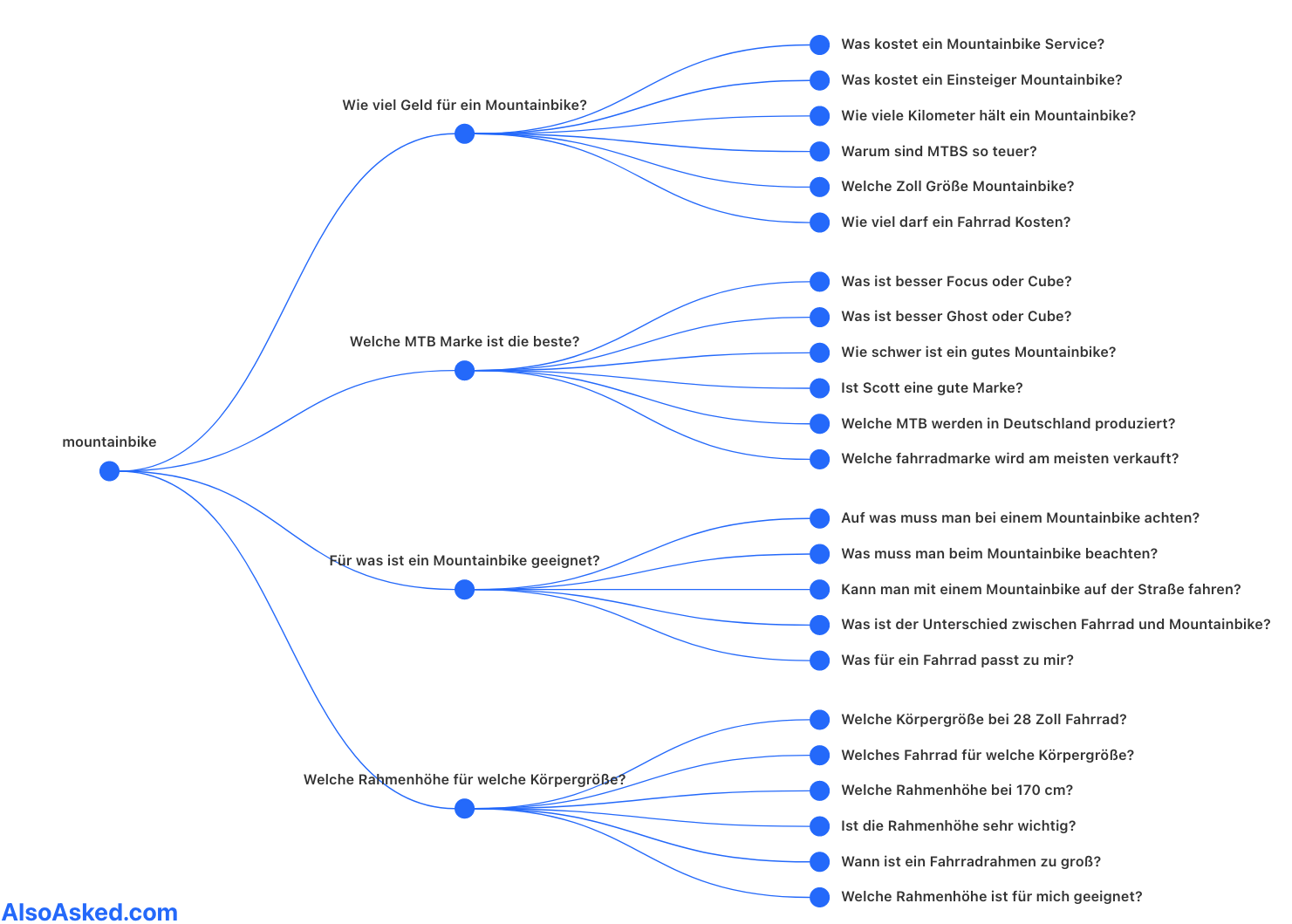

AlsoAsked zieht dagegen den Inhalt aus den "Ähnliche Fragen"-Boxen – Englisch PAA für "People Also Asked" aus den Suchergebnisseiten und sortiert sie nicht nur nach Fragewörtern, sondern nach Sinnzusammenhängen. Das Ergebnis für die identische Abfrage:

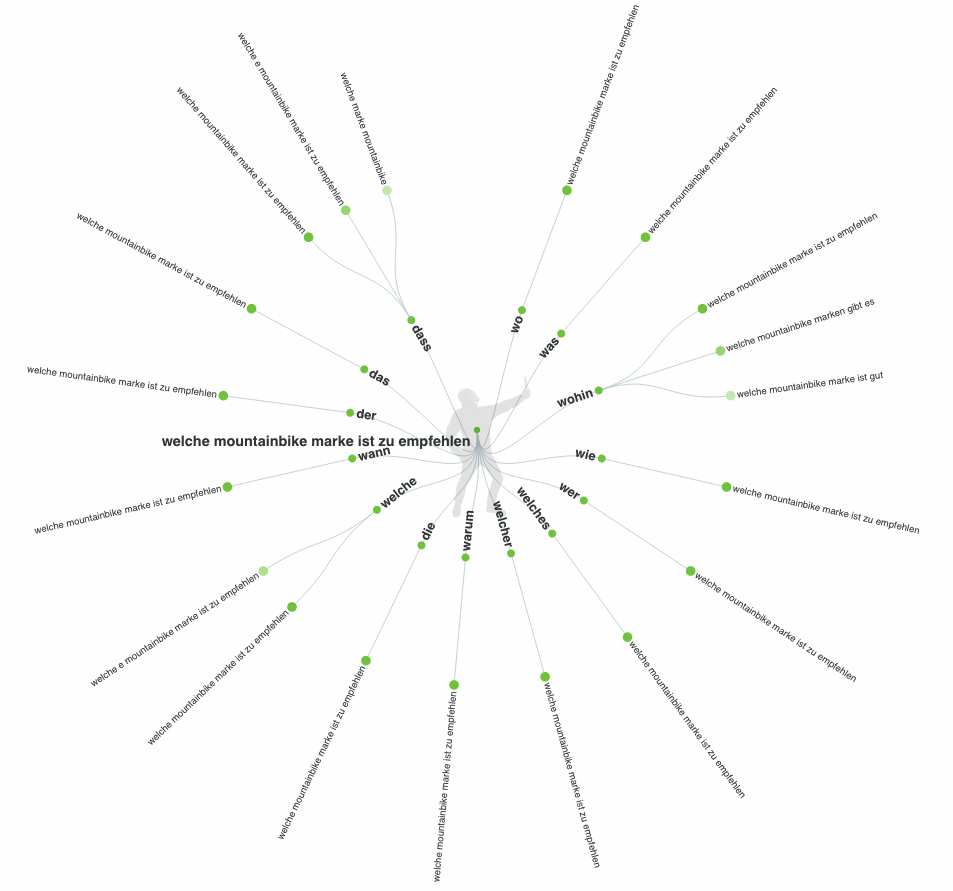

Pickt man sich ein Longtail-Ergebnis mit mehreren Begriffen von Answer The Public raus – zum Beispiel "welche mountainbike marke ist zu empfehlen" und fragt es erneut bei Answer The Public ab, gibt es keine sinnvollen Ergebnisse mehr. Input und Output sind fast identisch.

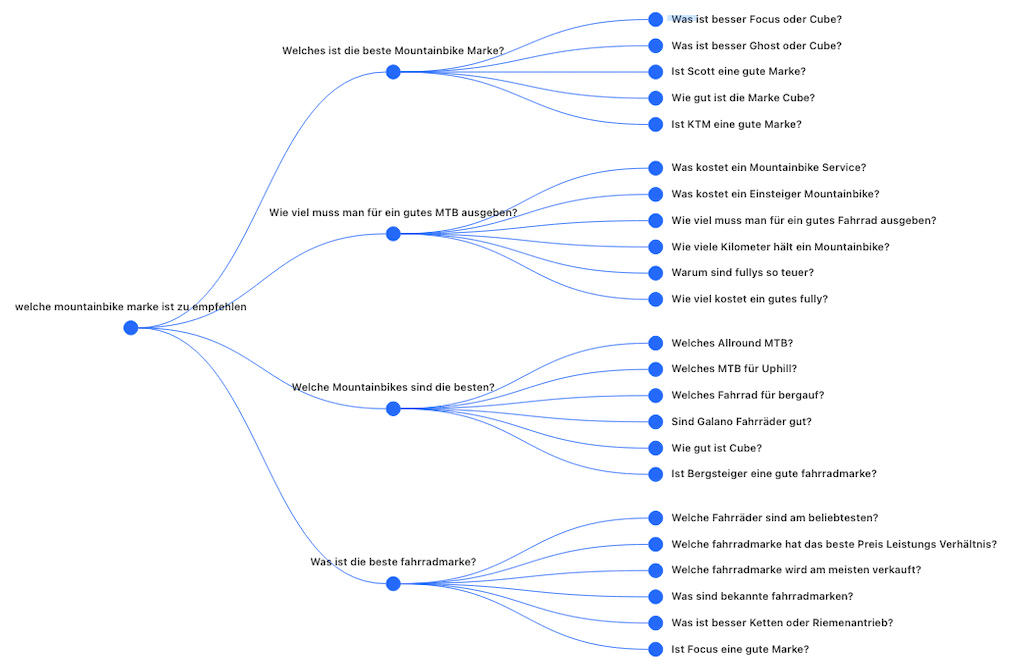

Bei AlsoAsked sind dagegen auch die Longtail-Anfragen zu gebrauchen:

Wer ein kurzes Intro und die Hintergrundgeschichte zur Entstehung von AlsoAsked erfahren möchte, kann sich

Episode 10 der zweiten Staffel

des ohnehin empfehlenswerten

Podcasts "Search with Candour"

anhören.

Auf Youtube erklärt Mark die Unterschiede zwischen AlsoAsked und Answer The Public kurz und knapp am Beispiel "bitcoin"

.

Noch Fragen?

|

|

|

Tricky täuschende GSC-Daten

|

|

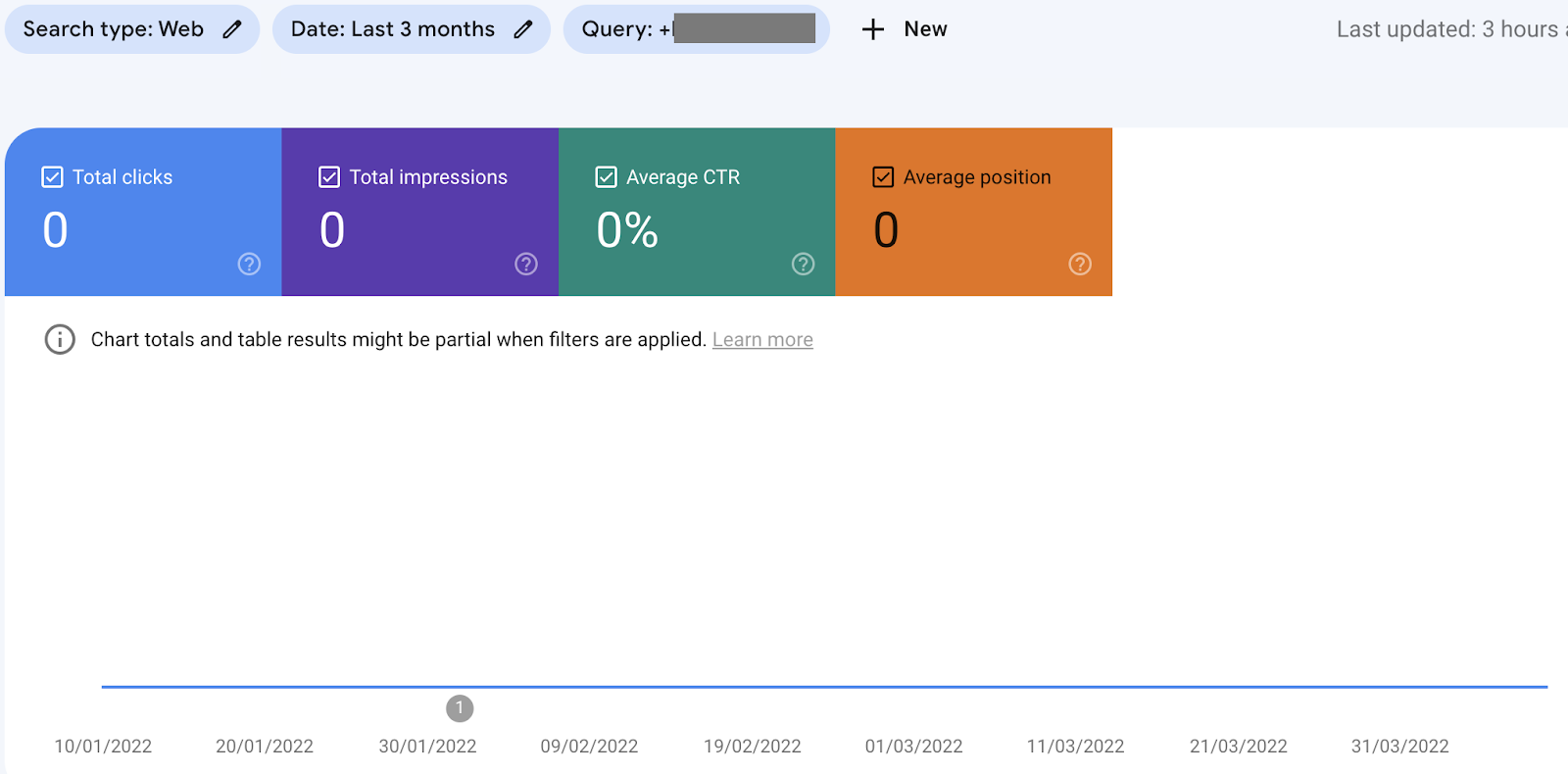

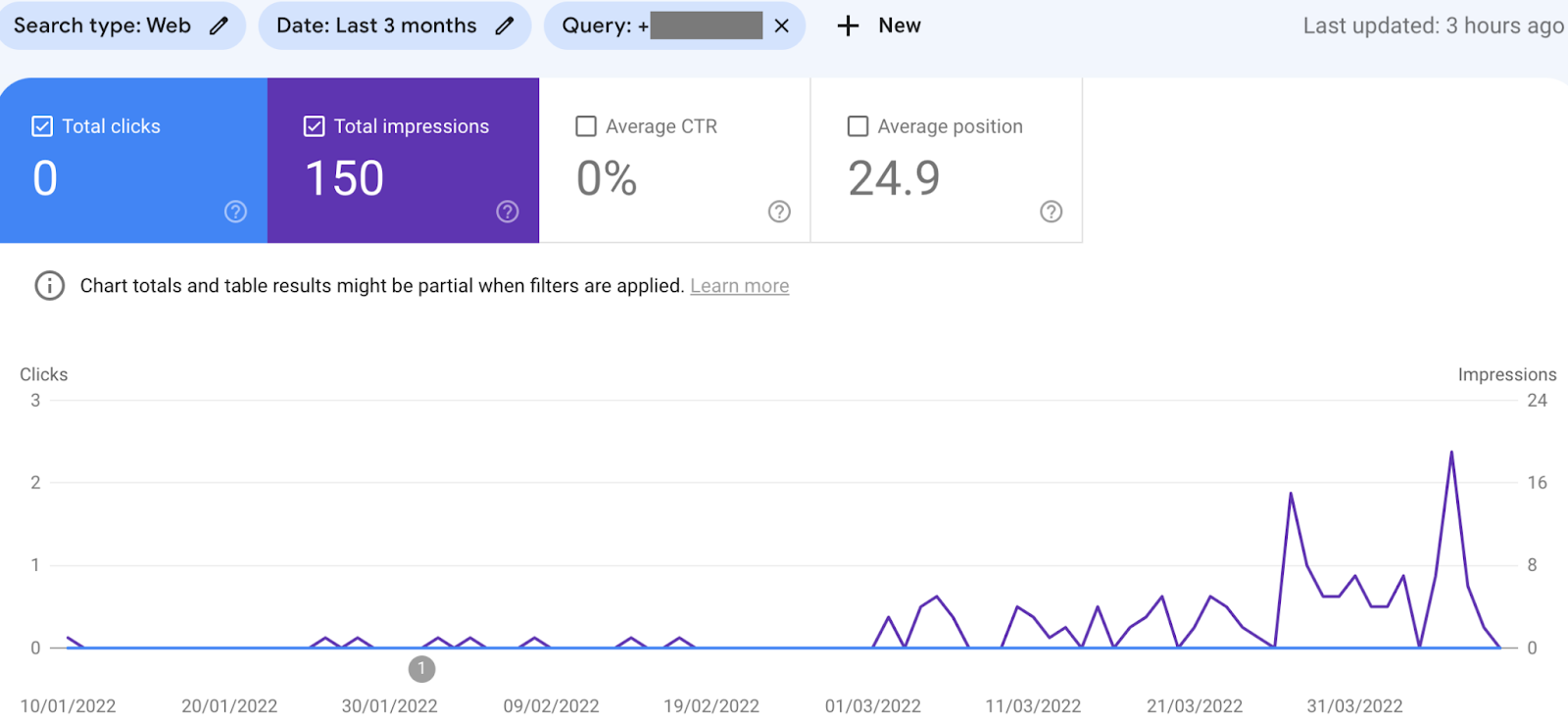

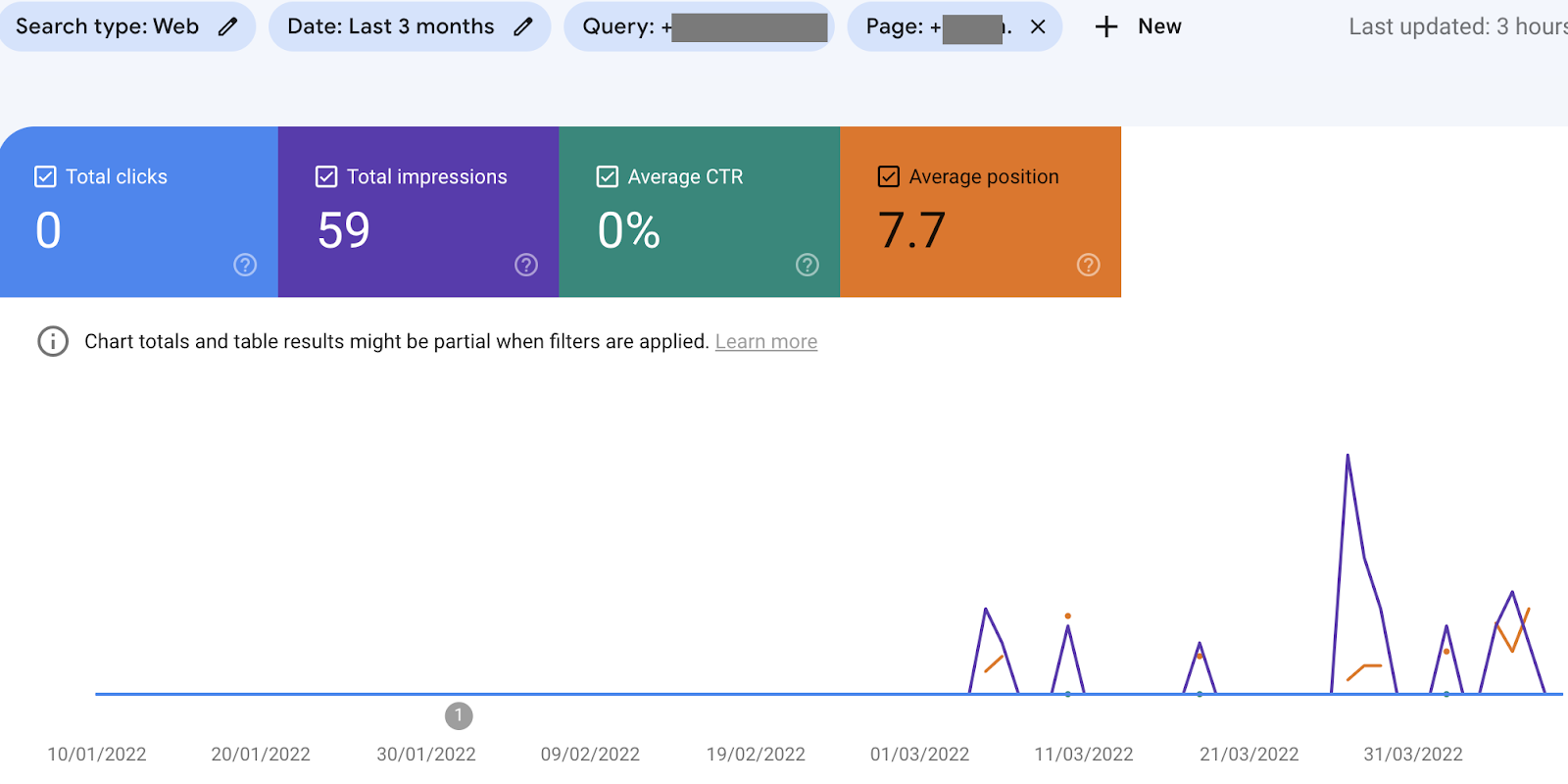

GSC-Daten täuschen manchmal. Oder öfter als Du vielleicht denkst oder es Dir erhoffst.

Ich bin auf ungleiche Daten gestoßen, die das ganze Nicht-in-die-Falle-treten-Spiel noch lustiger machen:

Die Daten werden nicht nur anders dargestellt je nach Anwendung des Filters im Performance-Bericht, sondern sie variieren auch je nach Art der angelegten Property (Domain, Subdomain oder Folder).

Aufgefallen ist mir das bei einem größeren Online-Shop, denn dies passiert wohl nur mit einer bestimmten Datenmenge. Ab einer bestimmten Domaingröße kannst Du also folgende Unterschiede in den Daten beobachten:

-

Daten in einer Domain-Property (beispiel.de) mit einem gesetzten Query-Filter, der Keywords von einer Subdomain einschließt → keine Daten werden angezeigt.

-

Daten in der URL-Property der Subdomain (https://beispielsubdomain.beipiel.de) mit gleichem Query-Filter → Es sind Daten zu sehen, wenn auch nur wenige.

-

Wenn dann bei der Domain-Property zusätzlich zum Query-Filter der Page-Filter "beispielsubdomain." gesetzt wird, werden doch ein paar Daten angezeigt – aber immer noch nicht die gleichen wie in der Property für die Subdomain.

→ Google spart also ab einer bestimmten Datengröße bei der Darstellung in den übergreifenden Domain-Properties und zeigt die Daten nur in den spezifischen Properties. Das gilt nicht nur für Subdomains, sondern auch für Folder-Properties: Auch dort bekommt man mehr Daten angezeigt als beim Filtern auf einer darüber liegenden Property.

→ Du solltest Dich bei der Anwendung eines Filters im Performance-Bericht also immer fragen, ob sich die Filterung auf einen bestimmten Seitenbereich Deiner Domain beläuft und ob Du noch genauere Daten in spezifischen GSC-Properties statt der Domain-Property erhalten könntest.

Es kann also Vorteile haben, bei größeren Domains mehr Properties in der GSC als nur für die Domain einzurichten, sprich URL-Prefix-Properties für relevante Folder und Subdomains.

Noch mehr fiese GSC-Daten-Fallen, in die Du besser nicht reintrittst,

hat Behrend Dir in einem Wissensartikel zur Google Search Console mit Beispielen dargelegt

.

|

|

|

Die geheimen Dimensionen von GA4 👻

|

|

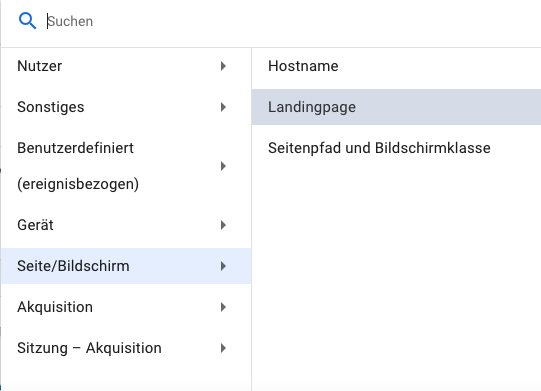

Universal Analytics wird bald in den Ruhestand geschickt. Währenddessen wurde GA4 in den letzten Wochen durch einige neue Features erweitert. Somit erlangt das Produkt wenigstens für einige Webanalyse-Fragestellungen einen gewissen Grad an Marktreife. Und das schon 1,5 Jahre nach Ende der Beta-Phase.

Wer sein GA4-Setup bereits live gestellt hat, ist bislang noch ernüchtert. In vielen Fällen hilft der Zugriff auf die Rohdaten, aber dafür muss man erstmal die Zeit und das Know-How haben.

Charles Farina

erklärt, dass die ein oder andere vermisste Metrik oder Dimension eigentlich schon vorhanden ist und verweist auf den

Dimensions & Metrics Explorer (Achtung: aus Gründen muss man für den GA4 Dimensions & Metrics Explorer in Google eingeloggt sein ¯\_(ツ)_/¯)

. Viele davon lassen sich bislang nur per URL-Manipulation im Frontend nutzen.

Hier erklärt am Beispiel der Landingpage

, die allerdings glücklicherweise inzwischen auch im Frontend direkt erreichbar ist.

Ein Zombie, der nun auch wieder aufgetaucht ist:

Bounce Rate

. Sie stimmt in der Definition nicht mit der Universal Analytics Bounce Rate überein (also Sitzungen, die nur einen einzelnen Pageview hatten), sondern bildet das Gegenstück zur Engagement Rate (

einer etwas komplexer definierten Metrik aus GA4

). Letzteres ist in Zeiten von Consent Management aber meiner Meinung nach die sinnvollere Metrik, da die echten Bouncer schon vor dem Consent verschwunden sind. Also lass den Zombie ruhig in seinem Grab und gewöhn Dich an die Engagement Rate.

So langsam wird GA4 benutzbarer, auch wenn die Schwelle sicherlich höher bleibt als für UA. Was fehlt Dir noch an GA4 um gut mit ihr arbeiten zu können? Oder hast Du GA4 inzwischen aufgegeben und Dich für eine andere Webanalyse entschieden?

|

|

|

How to become a Local SEO Superhero 🦸 – ein SMX Rückblick mit Greg Gifford

|

|

Greg Gifford

hat mit seinen Präsentationen zu Local SEO und Google Business Profile sehr viel Aufsehen erregt bei der SMX – nicht nur wegen der Informationen, sondern auch wegen der außergewöhnlichen Slides. Diese waren geprägt von seiner Liebe zum Film – so hatte jede Slide ein Bild eines Superheldenfilmes im Hintergrund. Wie auch Du ein Local Superhelden wirst mit Deiner Seite, erfährst Du jetzt 🚀

Greg sagt, dass Corona die Welt verändert hat – das ist uns nicht neu – aber er erklärt dann, was sich daraus für Local SEO ergibt. Die wichtigsten Punkte habe ich einmal für Dich zusammengefasst:

🔎 Das Nutzerverhalten hat sich verändert!

-

Suchanfragen mit einer lokalen Suchintention sind so häufig wie noch nie

-

Click & Collect erfreut sich großer Beliebtheit und Kunden geben an, dieses auch nach der Pandemie nutzen zu wollen

-

Die Lieferung in den Shop ist für 50% der Nutzer ein Entscheidungsmerkmal (amerikanische Studie)

→ Das ergibt meiner Meinung nach durchaus Sinn und ist mir auch wichtig, denn

-

Aus Kundensicht ist es von Vorteil, wenn ich dann mein bestelltes Kleid direkt im Laden anprobieren und bei Nichtgefallen direkt dort wieder abgeben kann, anstatt mich noch bei der Post anstellen zu müssen

-

Aus Verkäufersicht gesehen ergibt es Sinn, denn wahrscheinlich suche ich mir zum neuen Kleid (wenn es mir gefällt und passt) auch noch eine passende Jacke, eine Handtasche, ein Tuch,... naja was man eben so "braucht" und zwar direkt vor Ort im Geschäft

-

56% der Nutzer vertrauen auf Kundenbewertungen. Wenn Du also noch keine Bewertungen in Deinem Shop hast, fang an zu sammeln!

-

Die meisten lokalen Suchen werden auf dem Smartphone getätigt. Also checke Deine Seite immer, ob diese für Mobile optimiert ist. Das ist uns natürlich nicht neu, aber immer wieder gut, zu erwähnen ;)

Aber wer sollte denn eigentlich Local SEO machen?

Greg sagt: Mindestens jeder, der direkten Kundenkontakt hat!

Und was sind die wichtigsten Punkte, die Du beachten solltest? Content, Links, Bewertungen und Dein Google Business Profile (besser bekannt als Google My Business).

📝 Content:

-

Achte darauf, dass Dein Content lokal bezogen ist. Ergänze Deine Stadt und das Keyword im Title, in der H1-Überschrift, im Text, in der URL, in den Alt-Attributen der Bilder, in der Meta Description

-

Wenn Du noch kein Blog hast (und Kapazitäten dafür), dann erstelle eins, sagt Greg

-

Fülle Dein Blog um lokalen Content. Das können Themen sein wie "Die tollsten Parks in Hamburg mit Hund" oder "Spazieren an der Alster – das Must Have für Dein Outfit"

🔗 Links:

Vergiss alles, was Du über Linkbuilding weist, sagt Greg.

-

Links von kleinen lokalen Seiten sind hier Gold wert!

-

Links von kleinen lokalen Seiten können nur schwierig gefaked werden

-

follow / nofollow spielt keine Rolle

⭐ Bewertungen:

-

Bewertungen beeinflussen nicht nur den Nutzer, sie werden auch im Local Algorithmus berücksichtigt

-

Erstelle einen Review-Prozess und nutze die Chance, Deine Kunden zu animieren, Deine Produkte und Services zu bewerten

-

Erstelle eine Seite für die Kundenbewertungen

-

Beantworte ALLE Bewertungen

-

Achte bei der Beantwortung von negativen Bewertungen darauf, dass Du nicht nur den möglicherweise schlecht gelaunten Troll ansprichst, sondern mit Deiner Antwort alle möglichen Nutzer ansprichst, denn die lesen sich Deine Antwort auch durch!

-

Mach Dir keine Sorgen, wenn Du keine 5 Sterne im Durchschnitt hast. Niemand ist perfekt und das wissen auch Google und Deine Nutzer

🗺 Google Business Profile:

-

Nutze Deinen echten Firmennamen. Erweitere ihn nicht und versuche nicht, Keywords zu ergänzen!

-

Gebe alle Deine relevanten Kategorien an

-

Wähle Deine Hauptkategorie sinnvoll

-

Ergänze Dein Profil um Bilder und lade hier regelmäßig aktuelle Bilder hoch

-

Beachte die Fragen & Antworten. Achtung: diese kann JEDER Nutzer editieren

-

Erstelle eigene FAQs

-

Nutze Google Posts

-

Nutze Paid Ads → Denke hierbei auch an Microsoft und Bing Ads (25% der Suchen in Deutschland kommen darüber). Und mit Ads überholst Du Deine Mitbewerber, die näher am Nutzer dran sind und erscheinst trotzdem ganz oben in der Liste!

Und? Nutzt Du schon die wichtigsten Hebel, um im Local SEO erfolgreich mitzuspielen oder hast Du Dir jetzt eine kleine To Do Liste nebenher angelegt?

FunFact – ich bin übrigens LocalGuide Level 5 mit ca. 500 Bewertungen – und Du?

|

|

|

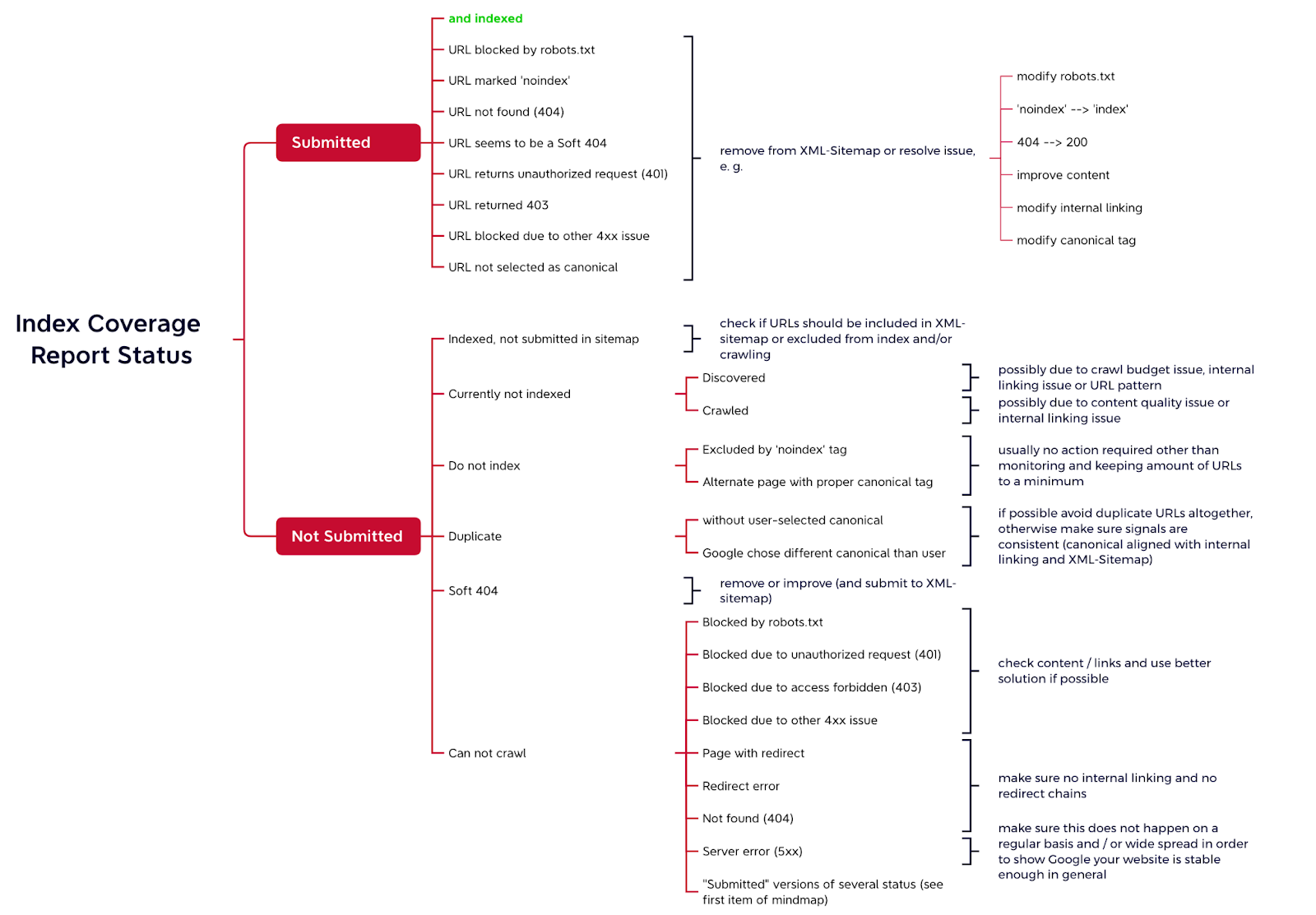

Mehr Durchblick im GSC Coverage Report

|

|

Vor

ein paar Wochen

hatte ich bereits über den Status "Crawled - currently not indexed" im Coverage Report der Google Search Console geschrieben.

Eine super Ergänzung dazu ist

dieser Artikel

– ebenfalls von Tomek Rudzki von Onely – zu sämtlichen mal mehr mal weniger hilfreichen Status, die der Index Coverage Report so ausspuckt. Mir hat er tatsächlich dabei sehr geholfen, die Meldungen noch einmal strukturiert zu verstehen.

Dass die

Google-Doku

leider nicht immer aufschlussreich ist (vor allem, wenn man eine übersetzte Variante wie die deutsche nutzt) wissen wir ja. Tomek beleuchtet daher auch, was mögliche Auslöser und Lösungen sind. Teilweise gibt es ein Issue, das in verschiedenen Kategorien aufschlagen kann.

Grundsätzlich lassen sich die Status in folgende Gruppen clustern:

-

"Submitted" URLs, also die URLs, die via XML-Sitemap von Dir mehr oder weniger bewusst und beabsichtigt an Google übermittelt wurden

-

Crawled oder Discovered – currently not indexed, also alle URLs, die Google zwar irgendwie kennt, aber aus Gründen nicht frisst

-

Duplicate Content umfasst unterschiedlich behandelte Fälle nicht uniquer Inhalte

-

Bitte nicht indexieren, also URLs, die wir mit harten (noindex) oder soften (canonical) Verweisen versehen, um Google davon abzuhalten, sie in den Index zu packen

-

Kann nicht gecrawlt werden, also alles, was aufgrund der robots.txt oder von 200 abweichenden Status Codes nicht crawlbar ist

-

Soft 404, also URLs, deren Inhalte auf Google so wirken, als ob diese Seite wohl eher einen Status Code 404 haben sollte

Unerwähnt bleiben die URLs, die indexiert sind, aber nicht über die XML-Sitemap übermittelt werden. Die solltest Du aber auch im Auge haben. Daher habe ich sie auch in die kleine Übersicht, die ich inspiriert von Tomeks Artikel gebastelt habe, aufgenommen.

Eigentlich reicht das schon für den Überblick. Wenn Du tiefer ins Detail einsteigen magst, dann lies einfach weiter. Und wenn das noch nicht tief genug ging, dann wirf am besten noch einen Blick in den Artikel von Tomek, der oben verlinkt ist!

"Submitted" URLs

Einen Aspekt, den Tomek herausstellt, sind jene Sub-Reports, die "Submitted" URLs beinhalten. Also solche URLs, die in einer XML-Sitemap gelistet werden. Das sind die URLs, die wir – im Idealfall beabsichtigt und aus guten Gründen – an Google und andere Suchmaschinen übermitteln wollen, weil sie uns wichtig sind.

If your page reports a status with the word "Submitted", you have two options: resolve the issue or remove the URL from your sitemap.

Denn je nachdem, wie groß Deine Seite ist, musst Du möglicherweise mit dem Crawl Budget haushalten. Und es wäre schade, Google mittels XML-Sitemap auf URLs zu schicken, die da vielleicht mangels Relevanz doch nicht reingehören.

Crawled oder Discovered – currently not indexed

Was genau hinter dem Status "Crawled – currently not indexed" steckt, hatten wir ja bereits Anfang März thematisiert.

Ähnlich dazu gibt es den Status "Discovered – currently not indexed". Der Effekt ist derselbe: Die betroffenen URLs sind nicht indexiert. Die Auslöser unterscheiden sich jedoch. Während bei den "Crawled" URLs Google schon mal vorbeigeschaut hat, ist dies bei den "Discovered" URLs nicht der Fall.

Wenn Google sich also die Seite angeschaut hat, sich aber dazu entscheidet, sie nicht zu indexieren, kann das mit der Qualität der Inhalte oder Seitenstruktur zusammenhängen. Details hatte Tomek ja bereits in seinem

Guide

beschrieben.

Wenn Google sich die Seite allerdings noch nicht angeschaut hat, hat das andere Gründe. Zum Beispiel das Crawl Budget oder eine unzureichende interne Verlinkung.

Duplicate Content

Auch für diesen Fall gibt es 2 Status:

Hier packt die URL es jeweils nicht in den Index, da es noch weitere Varianten gibt. Einmal ohne dass es Canonicals gibt, einmal obwohl die Seite als Original referenziert wurde.

Das Canonical ist ja im Grunde nur ein Hinweis, für Google aber nicht verbindlich. Wenn sich die Suchmaschine also für eine andere Variante entscheidet, dann liegt das oft an mehrdeutigen Signalen – Canonical sagt so, interne Verlinkung und XML-Sitemap sagen so.

Umso spannender, wenn es vermeintliche Duplikate ohne Canonical gibt. Da hat man dann wohl grob was übersehen oder vergessen.

So oder so: Im Best Case kommst Du gar nicht erst in Verlegenheit, da Deine Struktur so sauber und konsistent ist, dass es gar nicht erst zu Duplicate Content kommt.

Bitte nicht indexieren

Die Status "Excluded by 'noindex' tag" und "Alternate page with proper canonical tag" beziehen sich auf alles, was intentional nicht indexiert wird. Daher gibt es hier auch nicht viel zu tun, außer sicherzustellen, dass hier wirklich nur URLs dabei sind, die dabei sein sollen.

Im Idealfall sollte hier keine enorme Masse anfallen, da der überwiegende Teil der URLs ja für Google und den Index relevant sein sollten. Denn je weniger sinnlose bzw. nicht indexierbare URLs Google crawlen muss, umso mehr Zeit und Aufmerksamkeit kann auf relevante Inhalte entfallen.

Kann nicht gecrawlt werden

Es gibt viele Gründe, weswegen Google eine URL nicht crawlen kann. Zum einen kann es simpel an der robots.txt liegen, die den Zugriff verwehrt. Oder daran, dass die betroffene URL einen anderen Status Code als 200 hat, sei es durch Weiterleitungen, 401, 403, 404 oder andere 4xx-Fehler oder einen 5xx-Server-Error.

Diese ganzen Probleme werden sowohl für URLs allgemein gelistet, als auch für solche, die über die XML-Sitemap eingereicht werden.

Dass es Weiterleitungen gibt, wirst Du nicht verhindern können. Google folgt ihnen im Normalfall auch und wird die Zielseite indexieren. Du musst nur sicherstellen, dass Du diese URLs möglichst aus Deiner internen Verlinkung und Deinen XML-Sitemaps rauswirfst.

Soft 404

Um Inhalte aufzuspüren, die vielleicht eigentlich eher einen Status Code 404 verdient hätten, hat Google seinen Soft 404 Detektor im Einsatz. Der ist aber nicht unfehlbar und mäkelt gerne auch mal Dinge an, die eigentlich komplett in Ordnung sind. Ein Klassiker: Der Blogpost mit den 397 lustigsten 404-Seiten ever, der dann aufgrund des Wordings so wirkt, als ob es sich um eine 404-Seite handelt. Schon eher ein passendes Problem: Weiterleitungen auf Zielseiten, die eigentlich nicht relevant sind oder Seiten, die mit dem Rendering Probleme haben.

|

|

|

|

|

Fragen? Immer gerne fragen!

|

Wir sind für Dich da.

Schreib uns gern jederzeit

eine E-Mail an

[email protected]

oder

ruf uns einfach kurz an:

+49 40 22868040

Bis bald,

Deine Wingmen

|

|

Anckelmannsplatz 1, 20537 Hamburg, Germany

|

|