Auf LinkedIn und in den Medien liest man häufig: "Google hinkt im KI-Bereich hinterher".

Auch in Gesprächen kommt das Thema immer wieder auf. Ob das wirklich so ist, oder nur so wirkt und Google sehr vorsichtig ist, kann man von außen nur mutmaßen. Da Google bereits in einige Fettnäpfchen getreten ist, möchte man natürlich das Risiko minimieren, erneut grobe Fehler zu machen.

Klar ist auch, dass KI bleibt und ein wichtiges strategisches Geschäftsfeld ist. Google hat sich bereits vor einigen Jahren als "AI-first company" bezeichnet und muss die eigene Stellung etablieren und behaupten.

Aber bisher haben die KI-Produkte (noch) nicht gezündet:

- Bard hat nichts getaugt und wurde umgetauft,

- die SGE ist bisher nur eine Beta und

- Gemini (vorher Bard) konnte sich bisher nicht eindeutig gegen GPT4 & Co. durchsetzen.

Die Position, der anerkannte Marktführer im Bereich KI zu sein, fehlt Google also.

Warum ist das ein Problem für Google?

Microsoft hat mit Bing zwar keine großen Marktanteile in den Suchmaschinen gewonnen, aber Google zum Tanzen gebracht. Es geht um Disruption und darum, Google angreifbar zu machen. Google muss sich bewegen und wagt sich aus der Deckung.

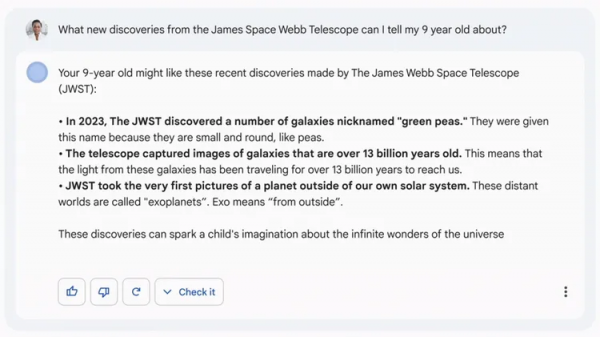

Dass die SGE bereits so früh gezeigt wurde, war vermutlich eine Reaktion auf die Bewegungen im KI-Markt, um zu zeigen "hey, das was wir haben ist viel cooler" oder "wir haben hier auch was im Ofen".

Dazu gesellen sich Fehler in der Außendarstellung. Bereits zur Ankündigung von Bard, kurz nach der Ankündigung zum BingBot, gab es einen Schnitzer im Promomaterial mit Falschinformationen:

Als Google Gemini vorgestellt hat, kam heraus, dass mit eins der beeindruckendsten Videos "fake" war bzw. bearbeitet wurde. Es ist in der Außenwahrnehmung egal, wie nah oder weit davon entfernt das Ergebnis von der Gemini-Realität ist:

"Andere nennen es normalerweise Marketing, bei Google ist es Fake, weil Google der Große ist."

– Johan von Hülsen

Was interessant ist: Niemand interessiert sich für die Fehltritte von Bing, außer es kommt zu Totalausfällen, in denen Bing z. B. die CSU als rechtsextreme Partei bezeichnet. Da ist dann auch für Bing der Bogen überspannt.

Google muss gefühlt doppelt so gut sein, um nicht (in der Wahrnehmung) überholt zu werden.

Solche Patzer und die Aktionen der Konkurrenz (z. B. Bing, ChatGPT und Perplexity AI) führen bei einer so großen Zielscheibe dazu, dass sich Druck und Schwachstellen auftun. OpenAI arbeitet laut Gerüchten mittlerweile auch an einer eigenen Websuche.

Im ersten Teil von Google Under Pressure "Darum muss Google zur Shopping Engine werden" ging es vor allem um die Entwicklungen im E-Commerce und den ewigen Kampf gegen Amazon was Shopping-Suchen angeht.

Passend dazu hat Amazon den guten Rufus – Amazon's KI-Shopping-Assistenten – angekündigt. Johan ist noch nicht überzeugt, ob das eine große Gefahr ist, weil unklar ist, ob User Rufus statt der Google Suche nutzen. Ich stimme Johan zu, schätze das Risiko aber als größer ein.

Prinzipiell bin ich auch kein Fan davon, den Teufel an die Wand zu malen, aber wir tun Dinge, wenn sie einfach "einfach sind". Und wenn sowieso schon nach Produkten häufig(er) auf Amazon gesucht wird, dann wäre ein Shopping-Assistent auf Basis der Daten von Amazon (inklusive Reviews) komfortabel und hilfreich.

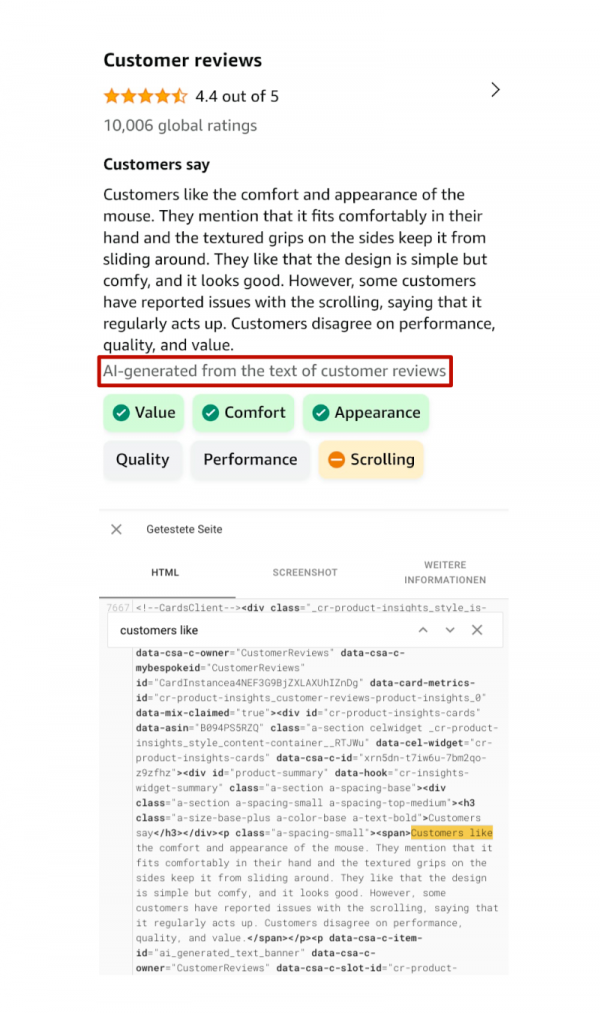

Amazon nutzt bereits jetzt KI in ihrem Produkt, um beispielsweise Reviews zusammenfassen zu lassen. Diese wurden mir nur mobile angezeigt, sind aber für Google definitiv crawlbar:

Last but not least: Arc, die "Browser Company" hat ihren Masterplan angekündigt, Suchmaschinen und damit SEO (und Websites) obsolet zu machen. Alles auf den Kopf stellen und visionär denken – das mag ich. Aber ich habe zum jetzigen Zeitpunkt viele Fragen und für das beschriebene Vorhaben gab es auch Kritik.

Google ist der Löwe im Kampf gegen eine Gruppe von Hyänen (= Wettbewerber wie Microsoft mit Bing, OpenAI mit ChatGPT, Perplexity AI & Co.). Meistens gewinnt der Löwe, aber nicht immer. Diese Wahrnehmung kostet gute Leute, die abwandern und schmälert die Zukunftsaussichten für Google.

Was kann Google dagegen tun?

Um hier für Verbesserung zu sorgen, dürfen Google keine Fehler passieren. Die "Anderen" nehmen sich in kleinen Teilen, was sie kriegen können. Die KI-Produkte von Google müssen sitzen. Zur SGE habe ich schon einiges geschrieben und in der täglichen Dosis SEO oder dem SEOSenf Podcast gesprochen.

Was für mich mit zunehmender Zeit klar wird, vor allem wenn man an den Earnings Call aus dem vierten Quartal 2023 denkt:

Wenn die SGE dazu führt, dass die Umsätze aus den Suchanzeigen langsamer wachsen, dann ist das Korsett ganz schön eng.

Google versucht es so aussehen zu lassen, als sei alles in Ordnung. Für mich klingt das aber mehr nach einer PR-Aktion, um die Aktionäre zu beruhigen.

Was wir noch gar nicht thematisiert haben:

Was ist mit der großen Menge an KI-generiertem Müll, der nicht hilfreich, nur mittelmäßig gut oder ein Wiederkäuen bereits existierender Inhalte ist?

Das Crawling dieser Inhalte kostet zusätzlich Geld. Es ist aber wichtig, dass hochwertige Inhalte in der Suche von Google auftauchen, damit wir die Suche gerne nutzen. Das lässt zwei Möglichkeiten offen:

- Google indexiert mehr Inhalte und schiebt die schlechten Inhalte weiter nach hinten oder

- Google hält den Index in einer ähnlichen Größe wie bisher und muss stärker aussieben.

Wenn mehr Mittelmaß oder Müll produziert wird, dann ist es einfacher zu sagen "Google wird schlechter" anstatt "die durchschnittliche Qualität der veröffentlichten Inhalte wird schlechter".

Ein paar Bewegungen gegen AI-Content konnten wir in den vergangenen Wochen und Monaten immer wieder beobachten.

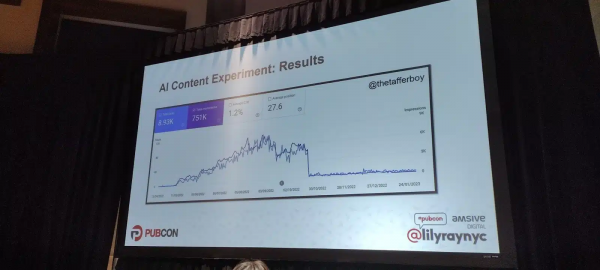

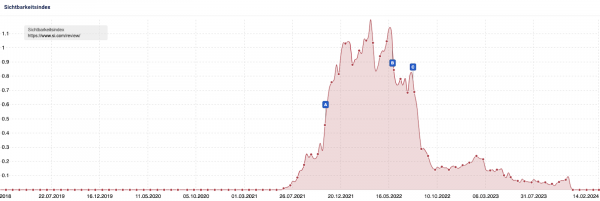

Ein unbekanntes Projekt vor ChatGPT (mit einem Tool auf Basis von GPT3 von Mark Williams Cook):

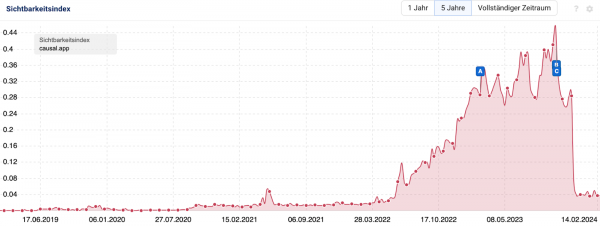

Der berühmte SEO Heist von Causal:

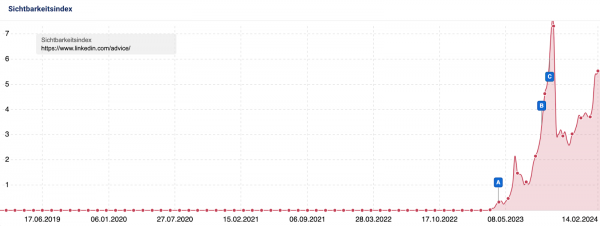

LinkedIn mit den kollaborativen Artikeln:

Hier scheint sich das Blatt allerdings zu wenden, was die reine Sichtbarkeit angeht. Interessant, da die Inhalte teilweise mit Falschinformationen gespickt sind und Menschen eingeladen werden, sich zu beteiligen, die mit einigen Themen keine Erfahrung oder Expertise haben. Für mich das Gegenteil von guten & hilfreichen Inhalten.

Einen weiteren Aufreger gab es bei der Sports Illustrated, die Affiliate Reviews mit Fake-Autoren veröffentlicht haben. Nach einem Shitstorm gingen die Inhalte offline.

Um sich vor den Content-Fluten zu schützen, braucht Google entsprechende Systeme, die zum einen erkennen, wenn Websites gegen die Richtlinien für die Content-Erstellung widersprechen. Danny Sullivan hat sich gerade kürzlich nochmal dazu in einem Tweet geäußert (Hervorhebung von mir):

"Using automation —including AI—to generate content with the primary purpose of manipulating ranking in search results is a violation of our spam policies" is something we thought was pretty clear from our post last year: https://developers.google.com/search/blog/2023/02/google-search-and-ai-content.

People who read that and somehow interpret it as a "free pass" should seriously be rethinking. I'm sure you'll also see us look at ways to make this even clearer."

Zum anderen ist für Google aus meiner Sicht deutlich wichtiger, dass Nutzern und Nutzerinnen hilfreiche Inhalte ausgespielt werden. Dabei helfen Initiativen wie Helpful Content, E-E-A-T, SpamBrain und die hohe Gewichtung von Nutzersignalen. Letzteres führt aber vermutlich teilweise zu dem Problem der Qualitätswahrnehmung.

Was bedeutet das für Dich als SEO?

Eine Sache, die man aus dem SEO Heist mitnehmen muss:

"Never make Google look bad."

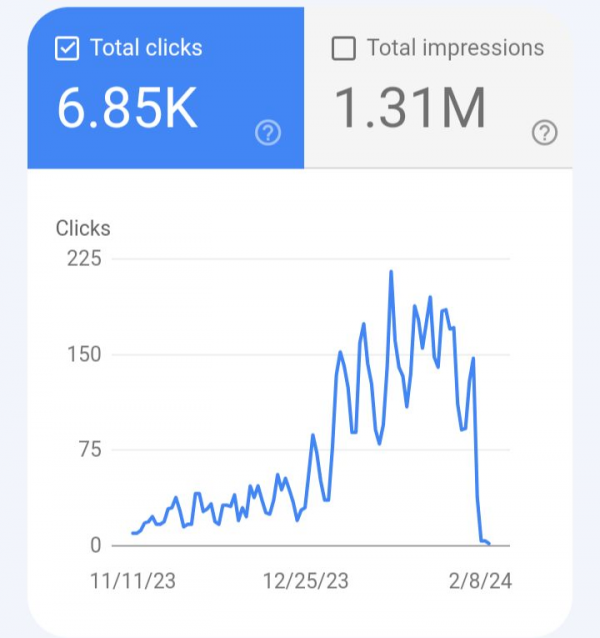

Bei dem Thema KI-Content wäre ich sehr vorsichtig. Programmatische Ansätze scheinen relativ gut zu funktionieren, was die Erstellung angeht. Probleme mit Google kann es aber trotzdem geben, wie dieser Fall von Chris Lever zeigt:

Reiner KI-Content kann ranken, ja. Es gibt auch einige Beispiele, in denen es über einen längeren Zeitraum gut geht. Aber sind das hochwertige Inhalte, die die Wahrnehmung der eigenen Marke in ein positives Licht rücken?

Ein zweiter Gedanke: Wir sehen deutlich häufiger Beispiele, die gut funktionieren, als Beispiele, die nicht gut funktionieren. Im Buch "Fooled by Randomness" schreibt Nassim Taleb:

"In a nutshell, the survivorship bias implies that the highest performing realization will be the most visible. Why? Because the losers do not show up."

Natürlich gibt es auch Fails, über die wird aber seltener gesprochen oder nachgedacht.

Die große Schwierigkeit ist die Erstellung von gutem Editorial Content. KI kann hier helfen, aber nicht jeden Schritt der Prozesskette vollständig übernehmen. Was gut funktioniert:

- Ideenfindung

- "Brainstorming" für Headlines, etc.

- (Ansätze für) Eine Outline erstellen entsprechend von Vorgaben

- Einzelne Textblöcke klarer und einfacher formulieren lassen

Die KI ist also ein Sparringspartner, kein heroischer Weltmeister.

Die KI-Content-Beispiele wirken auf den ersten Blick beeindruckend, keine Frage. Aber selbst wenn die Rankings und der Traffic am Ende stimmen und Google die Inhalte erstmal gut findet, geht es im Kern nicht um Traffic (außer das ist Dein Geschäftsmodell), sondern Umsatz und Conversions.

Wenn Du gute Inhalte mit KI erstellen kannst, die Deine Nutzer und Nutzerinnen lieben, dann wird Google Dich langfristig auch lieben.

Zum ersten Teil von "Google Under Pressure – Darum muss Google zur Shopping Engine werden"

Zum zweiten Teil von "Google Under Pressure – Mehr Meinung, mehr Video und mehr Inspiration"

Zum dritten Teil von "Google Under Pressure – Google wird schlechter und "ohne Reddit finde ich nix mehr"

|