| Wirklich wahres Wingmen SEO Wissen für wache Webmarketer #195 |

|

| 🎾 Der Tennisball ist mächtiger als die Feder |

Nach einfacher Gleichung muss der Tennisball also mächtiger sein als das Schwert. Ich weiß nicht, ob Du in letzter Zeit versucht hast, ein Fußballspiel in der ersten oder zweiten Bundesliga zu verfolgen. Falls ja, weißt Du auch schon, worum es geht. Falls nicht: Es kam bei so gut wie jedem Spiel der letzten Wochen zu Protestaktionen.

Der Protest richtete sich gegen einen Investoreneinstieg in die Ligen und siehe da: Tatsächlich wurden die Verhandlungen abgebrochen. Bei den Protesten wurden Spielunterbrechungen durch die Fans erzwungen, in dem zunächst Tennisbälle auf das Spielfeld geworfen wurden. Doch es ging noch weiter: Fahrradschlösser um Torpfosten, ferngesteuerte Autos.

Was lernen wir daraus? Dass Einsatz, Durchhaltevermögen und etwas Kreativität sich auszahlen können? Eine Message, mit der auch wir als SEOs gut beraten wären. Damit das auch Dir gelingt, haben wir wieder ein paar SEO-Takes mitgebracht:

Den Aufschlag macht Matt mit tollen Title Tag Tipps Im zweiten Satz geht es bei Hannah um neue Auszeichnungen der Produktvarianten Einen Return von Philipp zum Thema Druck, der auf Google lastet Ich spiele eine Rückhand der HouseFresh-Kritik an den Google-Rankings Johan ist mit einem BigQuery-Ass dabei

Wir wünschen Dir viel Spaß beim Lesen!

|

|

| 5 tolle Title Tag Tipps To Go |

Mit SEO ist es ein bisschen wie auf einem Schiff. Mal befindet man sich im Wellental, mal auf dem Wellenkamm und hin und wieder zerschellst Du mit Deinem Schiff an der nächsten Klippe.

Damit zumindest Deine Titles und CTRs ein sicherer Hafen im hin und wieder so turbulenten SEO-Gewässer sind, bekommst Du von mir heute 5 einfache Tipps, um Deine Titles 2024 (noch) besser zu gestalten. Welche das sind, erfährst Du jetzt:

Listicles

Der erste Tipp lautet: Verwende Listicles. Nutzerinnen und Nutzer wollen nämlich nicht einfach nur Tipps, sie wollen 5 Tipps. Oder 7 Tipps. Oder 10 Strände, die sie in Asien unbedingt besucht haben müssen. Konkrete Zahlen mit einer klaren Struktur also. Dadurch wirkt ein Artikel übersichtlicher und vollständiger. Darum gib Suchenden genau das: Listicles.

Adjektive für Effizienz

Sind wir doch mal ehrlich: Niemand will zwei Jahre auf erste Fortschritte in irgendeinem Bereich warten. Und keiner von uns will einen neuen Skill auf die komplizierteste, nur denkbare Weise erlernen. Stattdessen lautet die Devise: Je schneller und leichter, desto besser. Am besten, wenn ich dabei nebenbei noch eine Tüte Chips knabbern kann. Darum verwende Adjektive, die genau das signalisieren: Schnell, einfach, effektiv, unkompliziert. Dann sind die Leute auch an Bord.

Aktualität signalisieren

Würdest Du gerne einen Artikel aus dem Jahr 2005 zu den coolsten und besten Smartphones auf dem Markt lesen? Die meisten Nutzerinnen und Nutzer von Google und anderen Suchmaschinen auch nicht. Sie wollen aktuelle Artikel, idealerweise frisch aus der Druckerpresse. Mit neuen Erkenntnissen und aktuellen Trends, die sonst noch niemand kennt. Wenn Du also einen neuen Artikel veröffentlichst oder einen alten aktualisierst, packe gerne eine aktuelle Jahreszahl in den Title. Es wirkt, wie Saskia schon vor einer Weile in eine Artikel in unserem Newsletter näher beschrieben hat.

Sei anders

Nichts ist für Nutzerinnen und Nutzer langweiliger als auf der SERP immer wieder immer die gleichen immer wieder wiederholt wiederkehrenden Snippets lesen zu müssen. Ermüdend. Also schau Dir die Top 10 Ergebnisse einmal etwas genauer an und dann: Mach es anders. Nutze vielleicht einen Emoji (oder eben keinen), wenn es bisher noch keine dort gibt und es zu Deiner Marke passt. Oder setze einen Teil Deines Titles bewusst in Klammern. Übertreib es aber nicht, sonst sieht es schnell wie Spam aus oder Google schreibt den Title einfach um.

FOMO

Bist Du schon einmal auf eine Party oder ein Event gegangen, weil Du Sorge hattest, sonst etwas zu verpassen? Dann ist Dir die "Fear of missing out" (kurz FOMO), also die Angst, etwas zu verpassen, nicht fremd. Dieses Phänomen kannst Du natürlich auch in Deinem Title nutzen. Pass aber auf, dass er dadurch nicht zu stark in Richtung Clickbait geht. Das funktioniert zwar auch, allerdings eher auf kurze Sicht. Mehr zum FOMO-Phänomen findest Du übrigens in einem Artikel von Philipp in der Newsletter-Ausgabe #190.

Die berüchtigten Worte zum Schluss

Das waren sie: Meine 5 einfachen Tipps, um Deine Titles 2024 (noch) besser zu machen.

Wichtig ist natürlich, dass die Versprechen in den Titles auch mit der Zielseite übereinstimmen. Logisch. Wenn Du auf der SERP mit einem brandaktuellen Artikel zu den neuesten Handys aus dem Jahre 2024 wirbst, sollte Dein Artikel auch genau das halten und nicht aus dem Jahr 2008 stammen und über die unglaublichen Verbesserungen des neuen Apple iPhone 3G berichten. Gleiches gilt für die anderen Tipps.

Aber abgesehen davon, kannst Du Deine CTR mit diesen Tipps nach oben schrauben. Probiere sie gerne einmal aus, teste, experimentiere und sieh dabei zu, wie die CTR nach oben klettert.

|

|

| Endlich: Produktvarianten in die Tasche stecken |

Es gibt wieder neue strukturierte Auszeichnungen – juhu! Darüber muss ich natürlich berichten.

Und zwar können wir jetzt endlich Produktvarianten auszeichnen. Also genau genommen konnten wir das auch schon vorher und wir nutzen die Attribute "hasVariant", "isVariantOf", "isRelatedTo", etc. auch schon länger. Aber jetzt kam auch von Google endlich die Bestätigung, dass es verstanden wird und es sogar ein Rich Result dazu gibt. Nora und ich lieben ja "sexy snippets" und funkelnde Sternchen 😉

Das Ganze unterteilt sich auf zwei verschiedene Optionen.

Option 1 - Alle Varianten auf einer URL

Alle Varianten sind auf einer URL erreichbar, Stichwort "single-page website". Hier handelt es sich um eine URL, die nicht neu lädt, wenn eine Variante ausgewählt wird. Preis, Maße oder andere Unterscheidungsmerkmale werden angepasst.

In dem Beispiel der Google Dokumentation ist das Hauptprodukt auf der URL https://www.example.com/coat zu erreichen, die ausgewählten Farben und Größen hängen lediglich Parameter an die URL an:

https://www.example.com/coat?size=small&color=green https://www.example.com/coat?size=small&color=lightblue https://www.example.com/coat?size=large&color=lightblue

Auf diesen Seiten kann nun das ProductGroup Markup ergänzt werden, welches per hasVariant die einzelnen Variantenprodukte referenziert.

<script type="application/ld+json">

[

{

"@context": "https://schema.org/",

"@type": "ProductGroup",

"name": "Beispielname",

"description": ".....",

"url": "https://www.example.com/Beispiel",

"brand": {

"@type": "Brand",

"name": "Good brand"

},\

"productGroupID": "44E01",

"hasVariant": [

{

"@type": "Product",

..... }

Alle gleichbleibenden Attribute, wie beispielsweise die Marke, werden bei der ProductGroup angegeben. Diese erhält auch eine entsprechende ID.

Die unterschiedlichen Attribute, beispielsweise Maße, Farbe, Material oder Muster, werden bei den einzelnen Produkten angegeben. Bestandteil des Markups der ProductGroup ist entsprechend die Angabe, in welchen Aspekten sich die Varianten unterscheiden:

"variesBy": [

"https://schema.org/size",

"https://schema.org/color"

],

Option 2: Varianten auf unterschiedlichen URLs

Wenn Du Varianten eines Produkts auf unterschiedlichen URLs hast, dann kannst Du ähnlich vorgehen. Die Varianten der verwandten Gruppe werden dann ebenfalls im Markup referenziert, jedoch nur per url-Attribut, nicht mit dem kompletten Product Markup.

An einem Beispiel wird dies deutlich

Ich habe in meinem Shop zwei Handtaschen, die Varianten voneinander sind.

Es gibt die Tasche A in gelb in 3 verschiedenen Größen auf der URL1, /tasche-gelb.

Hier ergänze ich das ProductGroup Markup wie oben beschrieben und liste die verschiedenen Größen als Product innerhalb der hasVariant-Liste auf.

Die Tasche gibt es nicht nur in gelb, sondern auch in pink. Auch diese ist in den verschiedenen Größen verfügbar. Die Tasche liegt auf einer anderen URL: /tasche-pink.

Diese referenziere ich ebenfalls innerhalb der hasVariant-Liste der URL1 /tasche-gelb, jedoch nur per Angabe der URL, ohne Product-Markup:"url":".../tasche-pink". Auf der URL der pinken Tasche gehe ich genauso vor und liste die Varianten der gelben Tasche lediglich als URL auf. Die pinken Varianten werden als Product innerhalb der hasVariant-Liste angegeben.

Bisher habe ich noch keine Visualisierungen des Rich Results gesehen, auch in der Doku von Google sind keine ergänzt. Wir halten die Augen offen. Aber selbst ohne Rich Result ist es immer sinnvoll, optimierte structured data Markups zu nutzen und so sicherzustellen, dass Google Deine Inhalte versteht.

|

|

| Google Under Pressure – Misstrauens-Eisberg voraus! |

Lange ist es her, dass die "coolen und smarten Jungs" von Google in der Garage saßen und etwas Gutes für die Welt tun wollten. "Don't be evil" war eigentlich ein schöner Ansatz. Heute heißt es vor allem in Europa, dass Google eine gierige Datenkrake ist.

Was relativ harmlos anfing mit "bitte bei Street View mein Haus verpixeln, damit man meinen Garten nicht sieht", ist in den letzten Jahren ausgeufert in Kartellbeschwerden, Monopolvorwürfen und ein großes Trial, über das wir an anderer Stelle berichtet haben.

In der EU ist Google mittlerweile gezwungen, bei Preisvergleichen für mehr Varianz in den eigenen Suchergebnissen zu sorgen (inkl. neuer SERP Features) und den Lichtkegel der Aufmerksamkeit mit anderen zu teilen.

Wer hat außerdem einiges an Aufmerksamkeit in den Suchergebnissen bekommen? Reddit.

Erst kürzlich hat Glen Allsopp passend dazu einen guten Artikel inkl. Analyse zu der Überpräsenz von Reddit in den Suchergebnissen geschrieben. Es ging um Keywords, die Produkttests und -empfehlungen abdecken:

"The Reddit.com domain was present in 7,509 results and featured 14,263 times. This means that if the SERP feature was present, Reddit not only had an 97.5% chance of showing up, but on average had 1.9 of three possible listings."

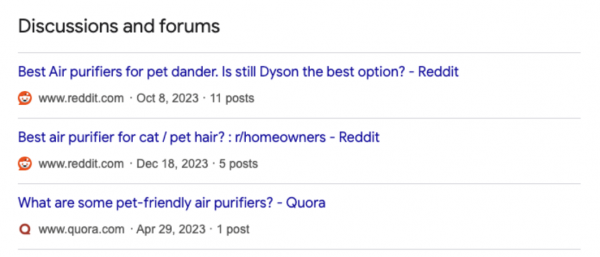

Das genannte SERP Feature ist "Discussions and forums":

Unglaubliche Zahlen. Glen setzt das noch in Relation zu den anderen Quellen, die in diesem Feature vorkommen:

"Reddit and Quora were listed 18,095 times. Every other domain appeared 4,989 times in total. In other words, these two domains have more than 3X the presence of every other site combined."

Jetzt platzte letzte Woche die Bombe – Google und Reddit machen gemeinsame Sache: Google darf mit den Daten von Reddit ihre KI trainieren:

"With the Reddit Data API, Google will now have efficient and structured access to fresher information, as well as enhanced signals that will help us better understand Reddit content and display, train on, and otherwise use it in the most accurate and relevant ways."

Krasse News und das wird bei der Kritik der letzten Tage, Wochen und Monate sicherlich nicht helfen, Vertrauen aufzubauen.

Warum ist das ein Problem?

Vertrauen ist der wichtigste Nährboden für gute Beziehungen.

"Kann man Google noch vertrauen? [...] Ja, zumindest solange Sie kein Wettbewerber, Werbetreibender oder Verbraucher sind."

– Mike Elgan (Autor der Computerwoche – Link zur Quelle)

Die Kernaussage: Niemand kann Google vertrauen. Es gibt viele Überschriften dieser Art:

We still trust in Google, but less than 10 years ago Vertrauen und tiefes Misstrauen: 20 Jahre Google Deutschland Justice Department Sues Google for Advertising Technologies EU droht Google mit Aufspaltung

Es geht aber nicht ausschließlich um die Außenwahrnehmung, sondern auch die Stimmen aus dem Unternehmen. Die großen Layoffs führen zu Unsicherheit bei den Mitarbeitenden.

Letzte Woche ging es um Google im KI-Wettrennen und ich schrieb:

"Google muss gefühlt doppelt so gut sein, um nicht (in der Wahrnehmung) überholt zu werden."

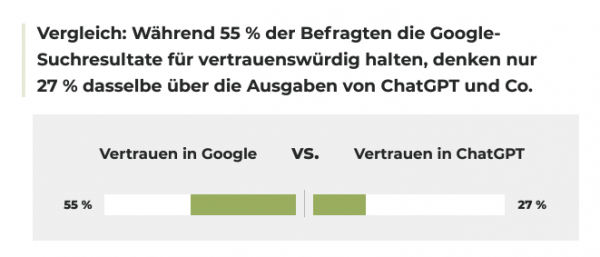

Was das Thema Vertrauen angeht, ist Google hier im Vergleich zu OpenAI an einem kritischen Punkt angekommen, wie die aktuelle KI-Studie von Evergreen Media zeigt:

Auch hier gibt es ein Narrativ:

Google ist nicht oder weniger vertrauenswürdig als vorher.

Das gefährdet den Default-Status als DIE Suchmaschine wie auch die anderen Themen, zu denen ich mich mit Johan ausgetauscht und in den letzten Wochen berichtet habe.

Was kann Google dagegen tun?

Viel kann Google hier glaube ich nicht machen.

Einen wichtigen Schritt beobachten wir gerade mit dem Wegfall der Third Party Cookies. Google hat die besten First-Party-Daten, daher ist das verkraftbar. Das eigene Werbeprodukt wird schlechter, aber die anderen werden noch schlechter.

Selbstsabotage ist in diesem Fall ein kluger Schachzug. Valide Alternativen gibt es nicht, also denkt sich Google vermutlich "Augen zu und durch".

Wenn man sich die Auswirkungen auf Apple anschaut, nachdem sie das App Tracking Transparency Thema durchgezogen haben (April 2021), dann wird schnell klar, wie mächtig First-Party Daten sind:

Leidtragend zu der Zeit vor allem Meta (Facebook).

Noch hat Google den massiven Vorteil, dass Chrome der mit Abstand meistgenutzte Browser ist und zahlreiche, erfolgreiche Produkte bedient, die alle zusammen arbeiten. Das ist ein großer Burggraben an First-Party-Daten, den die anderen nicht haben.

Was bedeutet das für Dich als SEO?

SEO braucht keine Third Party Cookies. Da, wo andere Channel ins Straucheln geraten und von dunklen Wolken umgeben sind, leuchtet SEO auf und gewinnt an Bedeutsamkeit.

SEO ist ein sehr nachhaltiger Kanal, denn anfängliche Investitionen erarbeiten über die Zeit gewöhnlich höhere ROIs. 2024 und die folgenden Jahre könnten für uns dazu führen, dass wir mehr Ressourcen bekommen – ein Moment der Freude.

Gleichzeitig empfehle ich Dir, den Markt genau im Auge zu behalten, denn Google ist in den letzten 12+ Monaten angreifbarer geworden.

OpenAI arbeitet laut Gerüchten an einer Websuche, Perplexity AI hat starke Befürworter im Rücken, TikTok und andere Suchsysteme schauen, welchen Teil vom Kuchen sie kriegen können und Amazon tut alles, um die einzige Instanz im E-Commerce zu werden.

Wenn wir unseren Blick nur auf Google richten, beschneiden wir uns unserer organischen Reichweite. Das Schiff zu fahren, bis es untergeht – falls das passiert – ergibt Sinn. Aber niemand möchte mit dem Schiff untergehen und das klappt nur, wenn wir bis dahin ein neues Schiff finden.

Das war vorerst der letzte Teil der Serie "Google Under Pressure". Was hältst Du von diesem Format? Mich interessiert brennend Deine Meinung, also schreib mir gerne eine Mail oder Nachricht bei LinkedIn. Falls Du die anderen Episoden noch nicht gelesen hast, findest Du hier die passenden Links:

Zum ersten Teil von "Google Under Pressure – Darum muss Google zur Shopping Engine werden"

Zum zweiten Teil von "Google Under Pressure – Mehr Meinung, mehr Video und mehr Inspiration"

Zum dritten Teil von "Google Under Pressure – Google wird schlechter und "ohne Reddit finde ich nix mehr"

Zum vierten Teil von "Google Under Pressure – Verliert Google das KI-Wettrennen?"

|

|

| Ranking-Ironie und Inception 🎞️ |

Hätte ich, als ich in Ausgabe 193 über Enshittification schrieb, geahnt, dass jetzt ein noch besserer Aufhänger wie die Sau durch das SEO-Twitter-Dorf getrieben wird, hätte ich mir das Thema eventuell aufgespart. Aber einen Schritt zurück: Was war passiert?

Am letzten Montag (19.02.2024) hatte HouseFresh, ein Testportal für Luftreiniger, einen Artikel veröffentlicht. HouseFresh verdient sein Geld eigentlich als Affiliate, wenn Nutzer aufgrund ihrer Empfehlung Produkte kaufen. Die Seite hat auch einen Blog, dieser ist in der Regel aber mit fachnahem Content bevölkert, nicht mit Kritik an Google.

Zunächst also überraschend wird aber sehr konkret Kritik am Ranking Verhalten von Google geübt. Hauptkritikpunkt ist, dass große Publisher ihre Stellung missbrauchen können, um mit minderwertigem Content insbesondere bei Produktvergleichen trotzdem erfolgreich zu sein. Wenn Dich ein wenig Englisch nicht abschreckt, empfehle ich den Artikel einmal in Gänze zu lesen. Er trägt den Titel "How Google is killing independent sites like ours".

Vor dem Hintergrund des allgemeinen Diskurses hat es wenig überraschend nicht lange gedauert, bis der Artikel in die Finger der SEOs geriet. An und für sich wäre das auch nicht außergewöhnlich, eben eine weiterer Thread auf X / Twitter oder LinkedIn. Allerdings wurde scheinbar nicht nur den geteilten Links gefolgt. Und Nutzer der navigationalen Suche erhielten für die Suche "How Google is killing independent sites" das folgende Ergebnis:

Quelle: Barry Schwartz, SearchEngineLand

Der ironische Umstand, dass ein Artikel über die unfairen Verhältnisse und Vorteile größerer Plattformen zur Suche nach seinem eigenen Titel hinter einer solchen Plattform landet, hat natürlich ebenfalls die Runde gemacht. Unter anderem, weil Reddit selbst im Artikel genannt wird.

Zum Zeitpunkt der Erstellung dieses Artikels konnte ich das Ergebnis nicht reproduzieren, allerdings scheint der Artikel von HouseFresh auch geupdated worden zu sein. Eigentlich fehlt es jetzt nur noch, dass der SearchEngineLand-Artikel über die Ironie der Suchergebnisse zum Artikel-Titel vor dem ursprünglichen Artikel rankt.

Sollte das passieren, sind wir vermutlich gefährlich nah an der Singularität. Oder wir wachen alle auf und am Ende war es eine Inception. Heute schonmal nach Deinem Totem geguckt? ;)

|

|

| 93% mehr Daten mit BigQuery |

Ich bin ja immer wieder erstaunt, wie viele Unternehmen ihre GSC-Daten nicht nach BigQuery exportieren.

Ja, auch nicht alle unsere Kunden. Wir arbeiten aber daran. Manchmal ist es ja auch nervig. Da gibt es keinen BigQuery-Account. Das Data-Team setzt auf eine andere Infrastruktur. Vielleicht wurde auch schon Energie investiert, die Daten über die API zu ziehen. Oder es fehlt einfach an der Berechtigung für die Kreditkarte. Alles nervige Details. Nur um am Ende die Daten in einem Speicher zu haben, bei dem man nicht genau weiß, wie man damit umgehen soll. Verstehe ich alles.

Aber: Trotzdem möchte ich noch mal Werbung für den Export machen. Und als Beispiel möchte ich Dir ein paar Zahlen zeigen, die aus einem aktuellen Kundenprojekt herausgefallen sind.

Unser Kunde (ein mittelgroßer News-Publisher) hat (nur für die organische Suche, 1 Tag):

Laut Search Console API (gefiltert auf WEB, query+url):

Im Vergleich mit BigQuery:

Über die Search Console API bekommen wir den Großteil der (nicht anonymisierten) Klicks.

Aber:

Das sind nur die Unterschiede für einen Tag. Für längere Zeiträume wird der Fehler größer.

Das bedeutet, dass wir über den BigQuery-Export 93% mehr Keywords finden. 90% mehr URLs. Und je longtailiger Dein Business / Deine Strategie funktioniert, desto größer ist der Impact.

Das Problem ist, dass Du mit der API (noch schlimmer mit dem Interface) falsche Entscheidungen triffst:

Du wirst das Impression-Potenzial bestimmter Themen unterschätzen Du wirst den Brand Traffic überschätzen Du wirst Inhalte im Content-Pruning löschen, die nicht gelöscht werden sollten Du wirst die Traffic-Verteilung Deiner Seiten falsch bewerten

Gegen all das kann man sich ein wenig versichern, indem man für jeden Export aus API und Interface immer mit auswertet, wie viel % der Daten damit erklärbar sind. Aber damit weißt Du auch nur, wie viel Du nicht weißt. Wirklich schließen kannst Du die Lücke nur mit einem BigQuery-Export.

Dazu kommt, dass Du teilweise Dinge auswerten kannst, die im Interface nicht so (einfach) zugänglich sind oder über die API nicht filterbar. Beispielsweise die Anzahl der Clicks / Impressions in Event- oder Job-Integrationen. Natürlich nicht die wirklich spannenden Fragen, wie:

Handelt es sich um einen Klick in einer Universal Search Box (bspw.: Bilder, Video, News), oder um einen Klick in den normalen organischen Treffern? Welche Features hatte der Ergebnis-Treffer? Handelt es sich um ein Featured Snippet?

Aber die Möglichkeiten sind schon mal massiv viel besser als über die API. Und Du hast nicht mehr mit Bloom-Filtern zu kämpfen.

Die Anleitung zum GSC-Export ist wirklich gut. Der kann man auch gut folgen, wenn man noch nie etwas mit BigQuery gemacht hat.

Und wenn Du die Daten erstmal hast, dann frag doch Deine Wingmenschen oder nimm Dir diesen Beitrag von Myriam Jessier, um mit der Arbeit mit den Daten zu beginnen.

|

|

|

|

|

Fragen? Immer gerne fragen!

|

Wir sind für Dich da.

Schreib uns gern jederzeit

eine E-Mail an [email protected] oder

ruf uns einfach kurz an: +49 40 22868040

Bis bald,

Deine Wingmenschen

|

|

Anckelmannsplatz 1, 20537 Hamburg, Germany

|

|