| Wirklich wahres Wingmen SEO Wissen für wache Webmarketer #131 |

|

| 🕯️Komm mit mir ins Advents-Feuerland: Der Pur-SEO-Mix |

Draußen wird es immer kälter und grauer. Wir haben es uns beim sanften Bildschirmleuchten unserer Laptops mit Kuscheldecke und Apfelpunsch gemütlich gemacht und fleißig an unseren Newsletter gestrickt.

Auf unserem bunten SEO-Plätzchenteller findest Du

Ein mit Puderzucker bestäubtes Recap zu Nina Rosers Relaunch-Vortrag von Nora Einen zuckerstreuselverzierten Bericht über umweltfreundliches Crawling und Indexing von Hannah Eine nach weihnachtlichen Gewürzen duftende Auseinandersetzung mit KI-generiertem Content von Matt Eine kleine Robots.txt vs Parameter Analyse mit Schokoguss von Johan Eine vanillige Tool-Vorstellung von Nora

Greif zu! 🍪

Deine Wingmenschen

|

|

| Wetten, dass? So laufen Relaunches wirklich 🤪 |

In ihrem Vortrag "Relaunch mit 3 SEO Wetten. Wie klug ist der Google Algorithmus wirklich?" hat Nina Roser auf der SEOkomm in Salzburg spannende Insights aus dem Relaunch mit einem Kunden mitgebracht.

Dabei wurde die Anzahl der URLs von 45.000 Seiten im Index auf 4.500 Seiten reduziert. Drei Erkenntnisse aus Ninas Vortrag habe ich heute für Dich mitgebracht:

Ein Relaunch braucht Zeit

Wie der Titel von Ninas Vortrag verrät, hat sie ihre Erkenntnisse in 3 SEO Wetten verpackt. Das Ergebnis der dritten Wette konnte sie allerdings noch nicht mitbringen, weil sich der Relaunch im Zuge des Projektverlaufs verzögert hat. Das passiert. Mach Dir also keinen Kopf, wenn eventuell auch bei Dir der Projektverlauf nicht so läuft, wie geplant!

Sichtbarkeit ist nicht alles

Im Zuge des Relaunches hat sich die Sichtbarkeit fast halbiert. Da bleibt einem im ersten Moment natürlich kurz das SEO-Herz stehen. War in diesem Fall aber nicht wirklich schlimm und zu erwarten. Die verlorenen Rankings haben nicht die Ziel-Keywords betroffen, sondern nicht passende Thematiken, die für den Kunden ohnehin keine Relevanz haben und durch das Schärfen des Themenfokuses weggefallen sind. Das wurde vorher Bedacht und mit dem Kunden abgestimmt. Hier hilft Dir ein gutes Keyword-Monitoring, um im Falle eines Sichtbarkeitsverlusts zu prüfen, ob die für Dich wichtigen Keywords überhaupt betroffen sind und zu schauen, wie sich die Sichtbarkeit Deines Projekts wirklich entwickelt.

Stecke Liebe in Details

Nina hat außerdem berichtet, dass holistische Landingpages mehr Rankings erzielen als einzelne Landingpages. Allerdings bekommst Du keine Top-Rankings ohne individuelle Analyse und Optimierung Deiner Seiten. Auch reicht es nicht, Exact-Match-Keywords in einem Abschnitt einer holistischen Landingpage zu nutzen. Du musst deutlich machen, dass die Seite das konkrete Thema auch bedient!

Am Ende braucht SEO Liebe. Nur weil etwas einmal gut funktioniert, muss dieser Erfolg nicht langfristig von Bestand sein. Planung, Tests, Monitoring, Analyse und Optimierung sollten fester Bestandteil Deiner SEO-Strategie sein. Um es mit Ninas Worten zu sagen:

"Content mit Mehrwert bietet die Chance, mehr relevanten Traffic zu gewinnen"

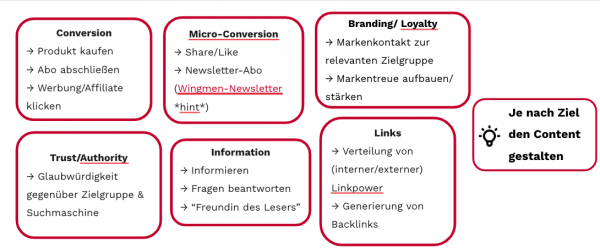

Am Ende möchtest Du, dass Deine Zielgruppe Deine Inhalte mag und konvertiert. Dazu muss Dein Content einen Mehrwert bieten und auf Dein Ziel einzahlen. Deine SEO-Ziele können dabei ganz unterschiedlich sein:

Johan sagt immer so schön: "Kein Content ohne Strategie". Johan hat übrigens einen tollen Artikel zum Thema SEO-Strategie geschrieben. Am Ende solltest Du für Dich mitnehmen, dass Relaunches und die aufgestellte Strategie aufgehen kann, aber nicht muss. Ein Relaunch birgt einfach Tücken, die manchmal nur schwer vorhersehbar sind. Hab Mut und teste! Falls Du nun mehr von Ninas spannenden SEO-Wetten hören möchtest, kannst Du Dich für den Webcast am 8. Dezember von 15 bis 16 Uhr anmelden.

|

|

| Über e-waste und was wir dagegen tun können |

Im Vortrag zum Thema Crawl-Management von Darius Erdt und Jan-Peter Ruhso auf der SEOkomm ging es darum, wie die Effizienz des Crawlings gesteigert werden kann.

Besonders gut haben mir dabei zwei Dinge gefallen:

Anhand von praxisnahen Beispielen und Tipps haben Darius und Jan aufgezeigt, wie Du erkennen kannst, dass Du das Crawling Deiner Website verbessern kannst. Dabei haben sie mehrmals betont, weshalb das unter anderem so wichtig ist, denn unnötiges Crawlen ist nicht nur aus SEO Sicht doof.

Nachhaltigkeit ist in aller Munde und die Awareness bereits groß. Wir ergreifen fleißig Maßnahmen in verschiedenen Bereichen: es wird vermehrt Second-Hand und/oder unverpackt und regional eingekauft, Müll wird getrennt & so gut es geht vermieden und Vieles mehr.

Was viele oft nicht berücksichtigen, ist der ganze Müll, den wir durch das ständige Online sein entstehen lassen. Darius und Jan sprechen hierbei von e-waste.

Immer wieder hören wir SEOs, dass es ja nicht so schlimm sei, wenn Google Seiten unnötig crawlt.

Darius und Jan haben ein Rechenbeispiel gezeigt, was toll verdeutlicht, wie viel Ressourcen eigentlich gespart werden können, wenn nur das gecrawlt wird, was auch wirklich wichtig ist, denn:

"Jeder einzelne Visit einer Webseite, auch der des Googlebots, verbraucht Bandbreite, RAM & CPU und somit Energie."

Unnötig mehr Energie wird zusätzlich verbraucht durch ineffizient ladende Seiten, fehlendes Caching, nicht erforderliches JavaScript oder auch nicht komprimierte Bilder.

Merke: Wenn Deine Seite schnell lädt, dann ist das also nicht nur gut für Deinen Core Web Vitals Score, sondern auch für die Umwelt 🙂 Und wenn keine unnötigen Seiten gecrawlt werden, hat Google natürlich auch mehr Kapazität, Deine wirklich wichtigen und neuen Inhalte zu crawlen und prüfen. Das wiederum bringt Dein Indexierungsmanagement nach vorn.

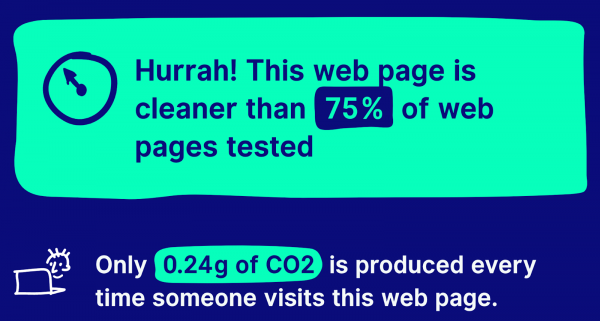

Auf websitecarbon.com kannst Du den Verbrauch Deiner Seite prüfen.

Für unsere Wingmen-Seite kann ich stolz sagen, wir sind im grünen Bereich.

Jan und Darius haben für ihre Rechnung

den Durchschnittswert einer Seite ermittelt, dann Caching eingeführt und anschließend erneut den Durchschnittswert ermittelt.

So konnten sie feststellen, wie viel CO2 Einsparungen pro Visit zusammenkommen.

Dann haben sie

Die Anzahl haben sie dann mit den CO2-Einsparungen multipliziert und kamen für die Beispiel-Website auf 1,2 Tonnen!

Was kannst Du also tun, um Dein Crawl-Management effizient(er) zu gestalten? Nachfolgend ein paar Tipps:

Prüfe zunächst die Crawling-Statistiken in der GSC (etwas versteckt zu finden unten links bei den Einstellungen) und verschaffe Dir einen Überblick über das Crawling Deiner Seite und das Verhältnis zwischen erforderlichem und überflüssigem Crawling. Vermeide Duplicate Content - nutze 404 oder 410 um Seiten zu konsolidieren oder leite sie per 301 weiter. Vermeide das Crawling von unnötigen Parameter-URLs, die beispielsweise durch Login-URLs entstehen, durch Filterung, Sortierung oder sogar Session-IDs. Bringe Deine Seite technisch auf Kurs und optimiere Dein Caching und die Ressourcen-Nutzung. Achte auf Deine Server-Kapazitäten. Optimiere Deine interne Verlinkung und vermeide Crawling von Weiterleitungen und 4xx-er Seiten Weiterhin empfehlen Darius und Jan den Einsatz von Linkmaskierung

Ich denke das Ganze nun noch ein wenig weiter und forsche, wie wir auch im Vorfeld schon einmal abwägen können, wie viel CO2 Einsparungen erlangt werden können durch verschiedene Maßnahmen - sobald ich dazu mehr habe, melde ich mich wieder ;)

|

|

| Einmal Content zum Mitnehmen, bitte! |

In der vorletzten Newsletter-Ausgabe hat Flo Dir ja schon einmal das Thema AI Content nähergebracht. Letzte Woche hat Hannah Dir dann etwas über die verblüffende Ähnlichkeit von künstlich generierten und von Menschen verfassten Texten erzählt.

Passend dazu gibt es jetzt von mir auch noch einen Artikel über Künstliche Intelligenz. Denn wie heißt es doch so schön: Aller guten Dinge sind drei. In diesem Sinne: Enjoy!

Hast Du schon einmal darüber nachgedacht, Deine Inhalte von einer Künstlichen Intelligenz erstellen zu lassen? Wertvoller Content in Sekundenschnelle, ganz einfach auf Knopfdruck. Hört sich doch verführerisch, nicht wahr?

Klar, eigentlich mag Google keine automatisiert erstellten Inhalte, aber hey! Google muss ja nicht herausfinden, dass den Text in Wirklichkeit kein Mensch, sondern eine KI geschrieben hat. Denn was die Suchmaschine nicht weiß... Um sicherzugehen, dass das Ganze nicht auffällt, nachträglich einfach hier noch ein paar kleine Schreibfehler einfügen und dort ein paar Füllwörter verwenden und voilà: Fertig ist die perfekte Täuschung!

Ja, das klingt dann trotzdem etwas zu einfach. Und das ist es auch, denn auch wenn das im ersten Moment wie ein super Plan erscheint... Ein wichtiger Punkt wird dabei dann doch vergessen (wenn nicht sogar der wichtigste): Der Mehrwert für den Nutzer! Surprise, surprise!

Natürlich kann Dir eine Maschine mittlerweile einen Text liefern, der verblüffend ähnlich dem eines Menschen gleicht. Der Mehrwert und das Verständnis für den Nutzer bleiben dabei allerdings auf der Strecke.

Dass das nachträgliche Anpassen von KI-generiertem Content nicht der richtige Weg ist, unterstreicht auch Danny Sullivan noch einmal bei Twitter. Dort schreibt er:

"If someone is asking themselves how to make content more human-like, then they're missing the point about creating content for people."

Es spricht ja nichts dagegen, sich von einer KI auf verschiedenen Wegen helfen zu lassen. Wenn Du allerdings gerade darüber nachdenkst, auf die dunkle Seite der Macht zu wechseln und Deine Blogbeiträge oder Kategorietexte künftig ausschließlich von einer Künstlichen Intelligenz schreiben zu lassen. Think again. And again. And again.

|

|

| 5 Minuten Shop-Robots.txt |

Im WUX-Discord gab es die Frage: Gibt es eigentlich Shops, die ihre Paginierung per Robots.txt sperren, anstatt sie zu noindexen.

Ich musste direkt an diese wunderschöne Robots.txt-Studie denken, hatte aber nicht ganz so viel Zeit, aber Interesse war geweckt.

Aus einer anderen Analyse hatte ich noch eine Liste mit 500 Shop-Domains herumliegen. Mit einem einfachen Terminal-Befehl habe ich mir dann die Robots.txt der 500 Domains geholt. Eventuelle Weiterleitungen haben wir dabei ignoriert:

for i in `cat ../shops.txt`; do curl https://www.${i}/robots.txt > $i;done

Danach haben wir 500 Robots.txt in einem Ordner liegen. Diese Dateien können wir jetzt mit grep nach einfachen Paginierungsmustern untersuchen:

grep -E "page|p=|pnum|seite" *

Natürlich durchsuchen wir so nicht nur Anweisungen mit User-Agent: Googlebot, sondern alle Anweisungen, aber eine kurze Liste, welche Robots.txt einen zweiten Blick bekommen könnten, erhalten wir sofort in unserem 500 Shops Sample:

Dazu kommen noch besonders schöne Einträge von conrad.de (Verbot doppelter Paginierungsparameter) und geschenkidee.de (haben die Sperrung aller Parameter auskommentiert).

Inwieweit die Muster in den einzelnen Fällen tatsächlich zur Problemlösung geeignet sind, lässt sich von außen natürlich schwer sagen, weil wir weder bei der Problemdefinition, noch bei der Abwägung der Lösungsoptionen dabei waren. Außerdem haben wir nicht geprüft, ob die Muster tatsächlich die Paginierungsmuster im Shop sind.

Dennoch fällt auf, dass

nur wenige Shops die Paginierungsmuster ausschließen viele zwar alle Paginierungen sperren, die ersten 5 Seiten aber wieder ausnehmen.

Mit letzterer Idee hab' ich meine Probleme, insbesondere weil sie recht pauschal angewandt zu werden scheint.

Wenn wir uns die Funktion der Paginierung für SEO anschauen, dann dient die Paginierung:

der internen Verlinkung der Discovery neuer Seiten

Für die Discovery brauchen wir die Paginierung nicht (sofern wir vernünftige Sitemaps und wertvolle Produktseiten haben).

Und für interne Verlinkung ist die Paginierung ungeeignet, weil die verlinkende Seite wenig Wert hat.

Idealerweise ist die Paginierung für die Stärkung der Seiten nicht notwendig, sondern über entsprechend detaillierte Übersichtsseiten gewährleistet. Spannend aber zu sehen, wie unterschiedlich die Paginierung schon in der Robots.txt gelöst ist.

Die Robots.txt-Anweisungen unterscheiden sich massiv. Was würdest Du gern über die Robots.txt der größten deutschen Shops wissen?

|

|

| Ein blindes Huhn findet auch mal einen Biber 🦫 |

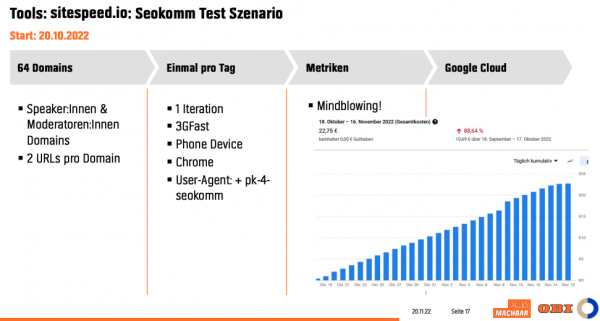

Verrückt! Wir haben mit unserer Website etwas gewonnen, und zwar den Performance-Biber von OBI. Patrick Krebs hat für seinen SEOkomm-Vortrag "Webseiten-Performance-Monitoring und -Optimierung bei OBI" einen Test mit sitespeed.io durchgeführt.

Getestet wurden 64 Domains der Speaker und Moderatoren der Online Expert Days:

Dabei wurden folgende Kriterien berücksichtigt:

Und siehe da - wir haben gewonnen! 🎉 Kleiner Disclaimer: Es gibt wahrscheinlich wenig Test-Szenarien, in denen unsere Seite gewinnen würde - aber hey...diesmal hat es geklappt 😉

Neben dem Test-Szenario hat Patrick außerdem gezeigt, wie man mithilfe von Grafana und sitespeed.io ein richtig cooles Monitoring aufsetzen kann, um die Performance einer Website zu verbessern. Warum Du das tun solltest? Das zeigt Dir der OBI A/B-Test:

„Unser Ergebnis: 100 ms schnellere Webseite führt zu 1% mehr Conversion"

Deshalb solltest Du Dir sitespeed.io anschauen:

Es ist schnell aufgesetzt (mit etwas Programmiererfahrung) und bietet mit dem schon bereitgestellten Dashboard gute Analysemöglichkeiten. Es können mehrere Domains und/oder URLs gleichzeitig überwacht werden. Die Erhebung der Daten ist automatisch zu bestimmten Zeitpunkten möglich. Es gibt viele weitere Metriken im Vergleich zum Pagespeed-Insight-Report. Du kannst auch historische Daten vergleichen.

Kanntest Du schon sitespeed.io oder hast Du schonmal etwas gewonnen? Lass es mich wissen. 📩

|

|

|

|

|

Fragen? Immer gerne fragen!

|

Wir sind für Dich da.

Schreib uns gern jederzeit

eine E-Mail an [email protected] oder

ruf uns einfach kurz an: +49 40 22868040

Bis bald,

Deine Wingmen

|

|

Anckelmannsplatz 1, 20537 Hamburg, Germany

|

|