| Wirklich wahres Wingmen SEO Wissen für wache Webmarketer #130 |

|

| 🔪 Wissensschnitzel von der SEOkomm |

Mit vollgefressenen Mägen und druckbetankten Köpfen sitzen wir am Samstag im Zug zurück von Salzburg nach Hause. Glücklicherweise hat uns die Deutsche Bahn mehr Reflexionszeit und ein Fahrgastrechte-Formular geschenkt, so dass wir noch intensiver über die Erlebnisse auf OMX und SEOkomm nachdenken und sprechen konnten.

In dieser Ausgabe kommen wir unserer Chronistenpflicht nach und dokumentieren die wichtigsten Dinge zu ausgewählten Vorträgen:

Caro hat sich gleich mehrere Vorträge zu Strategie und Content angesehen und für Dich Erkenntnisse aggregiert Jolle hat Sophie Baumbachs Vortrag über Suchintentionen zusammengefasst Hannah hat einen handgeschriebenen Artikel über Bastian Grimms „AI-Content" Keynote für Dich Andreas hat ein paar schnelle WissensSPLITTer aus der JavaScript-Session von Martin für Dich Ich habe ein paar Notizen bei Stephan Czysch über das Zusammenarbeiten von Kanälen gemacht. Und Behrend erinnert freundlich daran, dass auch während Konferenzzeiten die Uhren weiterticken… zum Beispiel für Google Universal Analytics

Falls Du noch nie auf der SEOkomm warst: Denk mal drüber nach: Die Speaker geben sich alle reichlich Mühe und das merkt man der Qualität der Vorträge auch an. Salzburg ist super und die Verpflegung auf Champions League Niveau.

Genug Werbung. Jetzt kommen Fakten. Vorher aber noch ganz kurz: Warst Du Speaker auf der SEOkomm? Dann auch noch mal hier ein fettes Dankeschön an Dich! Du hast diese Konferenz herausragend gemacht!

Und jetzt los!

|

|

| Content und Strategie Takeaways von der OMX und SEOkomm |

Beim Content gilt das allseits Bekannte: Gute Inhalte für den User, dann wird es Google auch als gut erachten. Aber wie genau? Welche Themen ergeben wirklich Sinn? Welche Formate? Welcher Fokus?

Auf der OMX und SEOKomm konnte ich ein paar coole Ideen und Tipps von Stephan Czysch, Robin Heinze und Nina Roser für genau diese Fragen mitnehmen, welche ich ab nun verstärkt bei Projekten mitdenken möchte:

Tipps für Ziele und Fokus

Ziele nicht nur setzen, sondern auch im Laufe des Projektes im Auge behalten, immer wieder mit dem Status Quo abgleichen und besonders am Ende des Projektes gesetzte Ziele und Projekt-Ergebnis reflektieren Nicht nur entscheiden, wo Du Deinen Fokus legen wirst, sondern vor allem auch entscheiden, was Du nicht tun wirst

Tipps für Bedarfs-Ermittlung Landingpages

Immer mitdenken: Auf welche Seiten sollen die meisten Besucher über SEO einsteigen und wohin sollen sie dann gehen? Mit Webanalyse ermitteln, welche Seiten für Seiteneinsteiger wichtig sind und vor allem welche nicht (obwohl Du vielleicht immer dachtest, dass sie wichtig seien) Traffic-Ströme Deiner wichtigen Affiliate-Partner, Content-Partnerschaften oder andere Kooperationen analysieren: Wo bekommen sie ihren Traffic her? Hast Du für diese Keywords bereits entsprechende Landingpages, um deren Klicks abzugreifen? Aufbau und Gestaltung des Textes auf die Phase der Customer Journey abstimmen

Tipps für Zusammenarbeit mit dem Einkauf, Vertrieb und Kundenservice

Die Kaufgründe und Wahrnehmungen der eigenen Wunsch-Bestandskunden detaillierter betrachten (zum Beispiel mit dem Vertrieb und Kundenservice sprechen) und dann rückwärts gehen: Was haben diese Menschen ursprünglich mal gesucht? Abstimmung mit dem Einkauf: Produkte auf Nachfrage abstimmen

Welche Methoden nutzt Du bei der Planung und Erstellung Deines Contents und was beachtest Du am meisten?

|

|

| Suchintention > Suchvolumen. Isso. |

Im Vortrag "Suchintention verstehen und für SEO nutzen -- Eine Erklärung anhand anschaulicher Beispiele" brachte Sophie Baumbach auf der SEOkomm in Salzburg für mich ein paar fundamentale Wahrheiten nochmal klipp und klar auf den Punkt:

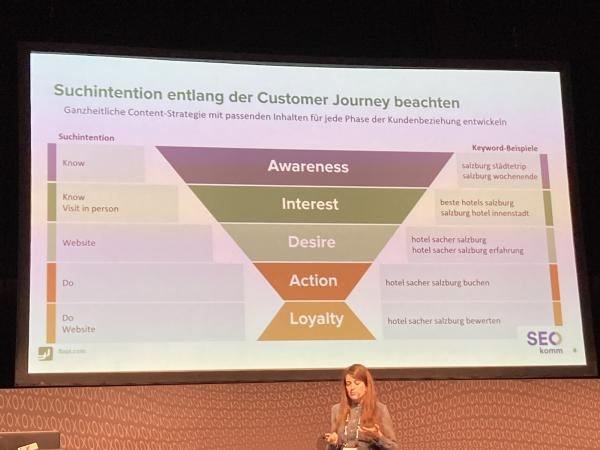

Alt-Text: Sophie Baumbach vor ihrer Folie "Suchintention entlang der Customer Journey betrachten" auf der SEOkomm 2022

An der Suchintention vorbei macht die Optimierung von Seiten überhaupt keinen Sinn. Wenn die Suchergebnisseite für "buch übersetzung" lauter Wörterbuch-Inhalte anzeigt, die Dir für den Begriff "Buch" die passende Vokabel einer anderen Sprache ausgeben, dann sollte Dein Verlag, der die Übersetzung ganzer Bücher als Dienstleistung anbietet, nicht auf dieses Keyword optimieren, sondern ein passenderes finden. Und das Passende ("bücher übersetzen") hat womöglich ein viel kleineres Suchvolumen, ist aber trotzdem das Richtige! Denn es spricht die richtige Zielgruppe an, die das Potenzial mitbringt, auf Deiner Website zu konvertieren. SERP-Features (PAA → Know, Local Pack/Google Maps → Visit in Person etc.) sind eine riesige Hilfe, um die Suchintention korrekt zu interpretieren, aber sie sind nicht eindeutig. Ganz grobschlächtig lassen sich Suchintentionen entlang der Customer Journey abbilden, aber auch hier haben wir keine Eindeutigkeit. Die Punkte oben zeigen: Es gibt viel mehr als "Know", "Know Simple", "Do", "Website" und "Visit in Person", so wie Sistrix die gängigen Suchintentionen beispielsweise gut erklärt. Hier kommt es wirklich auf den konkreten Blick in die SERPs am Einzelbeispiel an, wenn man verstehen möchte, welche Suchintention Google hinter einer Suchanfrage bei den Suchenden vermutet.

Daraus folgt auch: Noch skaliert das Mapping von Keywords auf die passende Suchintention für große Keyword-Sets nicht und ist für die meisten SEOs Handarbeit. Tools können diesen Prozess unterstützen. Sistrix gibt selbst anhand der SERP-Features eine Einschätzung ab; Keyword Insights zählt die Anzahl von Wissensartikeln vs. Ecommerce-Seiten der Top-Ergebnisse und leitet daraus die Intention ab.

Doch spätestens, wenn es ans Briefing bzw. an das Schreiben der Texte geht, musst Du Dir die einzelnen Keywords plus deren SERPs nochmal genauer ansehen. Sonst geht beim Datendengeln im Spreadsheet leicht unter, dass der "headhunter bremen" im Gegensatz zum "headhunter münchen" oder dem "headhunter köln" keine Recruiting-Services in der genannten Stadt anbietet, sondern ein weiteres Exemplar für schier atemberaubend großartige Wortspiele in der Welt der Friseure abgibt.

Der gesunde Menschenverstand, mit dem wir alle versuchen, an die Sache ranzugehen, führt uns eben hin und wieder gehörig in die Irre.

|

|

| Was Bastian Grimm über KI erzählt |

Bastians Keynote auf der SEOkomm in Salzburg begann mit einem schönen Experiment: Jeder im Saal hat zwei Texte zu lesen bekommen und sollte abstimmen, welcher besser ist. Jeweils einer von einer KI geschrieben und der andere redaktionell erstellt. Grund hierfür: er hatte eine Studie gelesen, in der es hieß, dass von KI geschriebene Texte besser abschnitten, einen besseren Flesh-Index hatten und im Vergleich als die "echte" Variante gewählt wurden. WHAT?!

Resultat: Die mit GPT3 generierten Texte und die von Autor:innen geschriebenen Texte wurden fast gleich bewertet, overall haben die Texte der künstlichen Intelligenz allerdings sogar knapp gewonnen.

Das war ein plakatives Beispiel für den aktuellen Stand der AI. Und dabei war die Eingabe weder optimiert noch das Modell speziell auf die Aufgabe trainiert. Verrückt, dabei predigen wir doch immer, dass alle ihre Texte bitte selbst schreiben und nicht maschinell erstellen lassen sollen.

Dazu muss nun allerdings gesagt werden, dass die Zwischenüberschriften bei den Texten der KI nachträglich noch manuell gepflegt wurden. Macht das den Unterschied? Auch Bilder hatte Bastian dabei, echte und künstlich erstellte und auch hier fiel es uns im Publikum schwer, eindeutig zu sagen, welches das echte Bild war.

Was heißt das für uns und Dich für den Bereich SEO? Kann Google Texte von KI sicher erkennen? Und wenn ja, wie werden diese bewertet? Das Erkennen wird immer schwieriger, auch für die Maschinen, denn die Trainingsdaten werden immer größer und besser. Das Erkennen wird also immer komplizierter, aufwändiger und kostenintensiver. Ist es Google den Aufwand und die Ressourcen wert? Um Texte besser erkennen zu können, müssen woanders Ressourcen gespart werden. Das heißt für Dich also, dass Crawl Management umso wichtiger wird.

Wenn wir AI Content für SEO nutzen wollen, dann müssen wir testen und uns Zeit nehmen. Tools wie Jasper & Co. funktionieren erst dann richtig gut, wenn wir sie mit unseren individuellen Daten-Sets trainieren und nicht einfach aus der Tüte nutzen. Wir wollen ja trotzdem einzigartigen Content mit unserem persönlichen Touch, Texte, die unsere Werte widerspiegeln und so weiter.

Auch wenn wir die Texte nicht ungefiltert rausgeben wollen, kann die Nutzung von KI-Texten eine massive Zeitersparnis sein. Die Empfehlung von uns und von Bastian lautet ganz klar: mindestens eine QS sollten alle Texte einmal haben (Faktencheck!), bevor sie auf Deiner Seite online gehen. Besser noch: die individuelle Note der Redaktion ergänzen.

|

|

| Javascript-Debugging mit Martin Splitt oder warum Landwirtschaft auch sehr schön sein soll |

Was soll man machen, wenn Google Inhalte nicht indexiert, die nicht im Quellcode enthalten sind, zu einem späteren Zeitpunkt via Javascript in die Seite gepusht werden sollte und man sich die Frage stellt: Wieso ranken die Inhalte bzw. die URLs nicht mit den Inhalten? Das war der Punkt, an dem Martin Splitt für SEOs auf der SEOkomm den alternativen Karriereweg in der Landwirtschaft ins Spiel brachte und direkt vor zeigte, wie man im Saal eine ordentliche Ernte nervös-vergnügtes Gelächters einfährt.

Doch warum ist es nicht genug, als SEOs einfach nur zu rufen: "Ist halt Javascript, geht halt nicht"? Webseiten mit Javascript sind aus der heutigen Zeit nicht mehr wegzudenken. Deshalb versucht Google, jede URL zu rendern, die sie auch gecrawlt haben. Die Frage ist nur, ob und wann das der Fall ist. In Einzelfällen würde Google doch vom Rendering absehen, wenn der HTML-Quellcode einer Seite Google nicht überzeugen würde, denn Rendering ist teuer.

An dieser Stelle kommentierte Martin auch die Studie von Ziemek Bućko & Marcin Gorczyca von Onely, nach der Google 9x länger braucht, um JS im Vergleich zu HTML zu crawlen. Martin meinte dazu, dass dies nicht unbedingt auf eine Zeitverzögerung im Web Rendering Service (WRS) zurückzuführen sei. Dass Googlebot zu einem späteren Zeitpunkt auf die Ressource zugreift, bedeutet nicht, dass Google es nicht schneller könnte.

Wie es zu den Verzögerungen im WRS kommt, schaut sich Martin nach eigenen Angaben selbst gerade an. Seine Argumentation, dass es am Aufbau / der Qualität des HTML liegen könnte, ist allerdings wenig wahrscheinlich, da Onely zwei Seiten-Sets mit sehr ähnlichem Aufbau für den Test erstellt hat.

Tipps aus Martins Vortrag

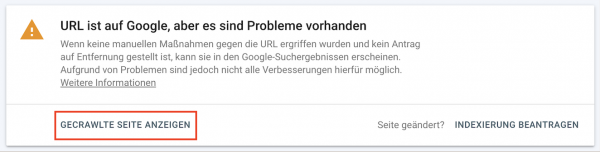

Jede URL, die gecrawlt wird, wird auch irgendwann gerendert. Es sei denn, Google findet das HTML davor zu unspannend. Wenn Du herausfinden möchtest, warum etwas nicht rankt, schau in der GSC in den HTML-Code, den Google zur Indexierung genutzt hat (Gecrawlte Seite anzeigen):\

Nutze in so einem Fall nicht die "Live-URL testen"-Funktion, da gegebenenfalls nicht alle Subsysteme fürs Crawling und Indexing zur Verfügung stehen und hier alle Daten frisch von Deinem Server abgerufen werden. Es werden daher nicht unbedingt die Daten genutzt, die zu den Entscheidungen von Google geführt haben. Dies kann Dir ggf. ein falsches Bild geben, warum Google Inhalte nicht rankt.

Verwende in der Javascript-Programmierung Standardbibliotheken. Hier ist die Chance viel größer, dass Inhalte wirklich korrekt in den DOM integriert werden und vom Google-Bot auch gefunden werden können. Fehler beim Ausführen von Javascripten sind normal und passieren. Dem Bot ist dies egal, solange die wesentlichen und wichtigen Inhalte nach dem Ausführen im DOM stehen. Google nutzt den HTML-Code des DOMs für die Indexierung der Inhalte, die bis dahin gerendert werden konnten. Consens-Banner versteckst Du vor Google am besten, indem Du den Consens-Banner in einer Javascript-Datei kapselst und diese via robots.txt vor dem Rendering blockierst.

|

|

| Stephan Czysch: „Warum nicht mal gemeinsam“ |

In seinem Vortrag auf der SEOkomm stellt Stephan grundsätzliche Fragen: Sind unsere Methoden eigentlich geeignet, die Probleme der User oder unseres Unternehmens zu lösen?

Er beobachtet, dass Ziele fehlen und in Silos gedacht wird. So wird Planung dann häufig über Ausgaben gesteuert (Du darfst/sollst X Euro für Kanal Y ausgeben). Dabei wäre es doch sinnvoll zu sagen: „So lange die Kampagnen positiv laufen schieben wir Geld nach, bis die Kennzahlen schlechter werden."

Das führt dazu, dass wir oft über die Aussteuerung der Werbebotschaft diskutieren, aber weniger über den Inhalt der Botschaft. Es sei viel wichtiger, dass wir uns das Ziel der Werbebotschaften anschauen und vor allem auch die Website als Landeplatz der Botschaft.

Denn die Verteilung der Botschaft sei ein gut einkaufbares Produkt und eigentlich gelöstes Problem.

Aber was sind die Inhalte und Themen und wie werden sie exzellent, damit sie einen Nutzen stiften?

Meistens schaue jeder Kanal für sich auf die Zielgruppe. Dabei müssen wir Hand in Hand arbeiten, um Nutzen zu stiften.

Zu oft nähmen sich Kanäle gegenseitig die Butter vom Brot.

Zusätzlich wird die Datenqualität schlechter und Attribution schwieriger.

Erreichen wir als alle Kanäle zusammen das Unternehmensziel und wie können wir das im Zusammenspiel der Kanäle in gemeinsamen Maßnahmen umsetzen?

Fragen waren beispielsweise:

Wie kommt der Affiliate zu seinem Traffic? Wie kann ich das nachbauen? Kann mich eine Nischenseite in den Newsletter aufnehmen? SEO/SEA aussteuern: Haben wir unterschiedliche Zielseiten für ein Keyword? Was können wir voneinander lernen?

Vor allem aber müssten wir die Frage beantworten:

„Worin sind wir als Unternehmen richtig gut?"

Wenn wir das in Themen aufschlüsseln, geeignete Kanäle identifizieren und einen CPC für dieses Thema definieren anhand des Deckungsbeitrags, dann arbeiten wir gemeinsam an den Zielen.

|

|

| Die Universal Analytics-Uhr tickt ⏰ |

Wenn Du noch eine Universal Analytics Property betreibst, hast Du vermutlich in den letzten Wochen auch eine Mail von Google bekommen, die Dich darauf hinweist, dass Universal Analytics am 1. Juli 2023 eingestampft wird und Dich bittet, eine Google Analytics 4 Property einzurichten.

Solltest Du das auch tun?

Gute Frage. Wenn Du Max Schrems (bekannt aus den Klassikern der EU-Datenschutz-Rechtsprechung Schrems I und Schrems II) fragst (oder einen anderen Datenschützer Deines Vertrauens), bekommst Du ein klares "Nein". Wenn Du Deine Google Ads Manager fragst, ein klares "Ja"...

Wenn Du es datenschutzkonform machen willst, wie es die französische Datenschutzbehörde CNIL empfiehlt, dann wird Dein Ads Team auch nicht glücklich werden, denn all die Daten, die es für seine Zielgruppen einsetzen will, sind nicht mehr da. Wohlgemerkt auch mit Consent...

Du kannst natürlich hoffen, dass die nächste Iteration den Privacy Shields da wieder ein Pflaster draufgeklebt, bis Schrems IIVXMDDD es wieder runterreißt.

Währenddessen sind Abmahnanwälte noch dabei, ihre Prozesse zu optimieren. Ich denke es ist ohne Zweifel möglich, den nicht rechtskonformen Einsatz von Google Analytics zumindest teil-automatisiert zu erkennen und Beweismittel zu sichern. Insofern bleibt eine ernsthafte Abmahnwelle eine Frage der Zeit.

Was sind nun die Alternativen? Wie ich schon einmal gesagt habe, ist die Liste lang. Meine aktuelle Einschätzung ist auch noch immer die gleiche, aber es gibt Ergänzungen:

etracker => Laufende Kosten, aber ähnlicher Funktionsumfang wie Universal Analytics (wenn man von der direkten Verknüpfung zu Google Ads absieht.) Matomo => Open source. Self hosted. Sehr eingeschränkt, reicht aber um zu messen, wie viel Traffic Du letzte Woche auf Deinem Blog hattest. Und dann auch ohne Datenschutzprobleme. Snowplow => Wenn Du die Ressourcen hast, um 1-2 Data Analysten zu beschäftigen, dann ist Snowplow vermutlich der beste Weg. Aber um das einzurichten, solltest Du zügig loslegen, wenn Du bis zum UA Sunset Dein Snowplow Setup live haben willst. Fathom => Ebenfalls ein kostenpflichtiges Analytics Tool, das eine sinnvolle EU-basierte Alternative ist

Also, die Tage Deines Universal Analytics Setups sind gezählt. Kümmer Dich um ein neues Tracking Setup. Und schreib Dir schon mal für den Juli in den Kalender, dass Universal Analytics auch aus Deiner Seite ausgebaut wird.

|

|

|

|

|

Fragen? Immer gerne fragen!

|

Wir sind für Dich da.

Schreib uns gern jederzeit

eine E-Mail an [email protected] oder

ruf uns einfach kurz an: +49 40 22868040

Bis bald,

Deine Wingmen

|

|

Anckelmannsplatz 1, 20537 Hamburg, Germany

|

|