| Wirklich wahres Wingmen SEO Wissen für wache Webmarketer #278 |

|

|

|

| 🔥 SEO, Kerzenlicht und andere Dinge, die Geduld brauchen |

Manche Dinge sollte man einfach nicht hetzen:

Kerzen, die langsam runterbrennen.

Tee, der in aller Ruhe zieht.

Mich.

Und SEO natürlich!

Alles braucht Zeit, bevor’s richtig warm wird. Wer zu früh pustet, löscht die Flamme. Wer zu früh refreshed, sieht nur: nichts passiert. Aber irgendwann, ganz ohne großes Tamtam, lodert’s, und plötzlich ist Licht da.

Unsere Autoren haben in dieser Woche ihre Geduld in Daten, News und Neuerungen investiert und bringen Dir wärmende Erkenntnisse für die dunkler werdenden Tage:

- Jogginghosen-Johan analysiert den neuen AI Mode

- Langsam-Lars sortiert Hreflang und internationale Verlinkungen

- Durchatmungs-Darius schlägt bei GEO-Updates lautstark Alarm

- Behaglichkeits-Behrend widmet sich gelassen Kaliforniens globalem Tracking-Opt-Out

- Ich widme mich der Prokrastination

Viel Spaß beim Lesen!

Deine Wingmenschen

|

|

| AI Mode all over the place? |

Google hat den AI Mode in Deutschland freigeschaltet. Wahrscheinlich hast Du ihn heute schon, auch wenn der Rollout erst schleppend verlief. 2 Tage nach der Ankündigung war noch nicht mal die Doku umgestellt. Und nur wenige User hatten zügig Zugriff.

Das passt irgendwie ins Bild einer unklaren Haltung zu AI Themen und Regulierung, das Google in letzter Zeit abgibt.

Schließlich hat Google noch eine Woche vorher im Zusammenhang mit dem DMA erklärt (Behrend berichtete):

Regulatory burdens and uncertainty are delaying our launch of new products, like our latest AI features, by up to a year after they launch in the rest of the world.

Dabei ist der AI Mode in den USA auch erst seit Juni 2025 für alle verfügbar.

Doch natürlich stellen wir uns jetzt alle Fragen:

- Wie viel Traffic kostet mich der AI Mode?

- Könnte der AI Mode mir möglicherweise Traffic bringen?

- Kann ich AI Mode Traffic messen?

- Wird der AI Mode jetzt der Default der Suche?

Natürlich bleiben Vorhersagen schwierig, wenn sie die Zukunft betreffen. Aber ein paar Hypothesen dürfen wir haben:

Wie viel Traffic kostet mich der AI Mode?

Wir können das nicht benennen. Schon bei den AI Overviews war das schwierig. Aber ein paar einfache Hypothesen sind möglich:

- Je informationaler Dein Traffic ist, desto öfter werden User im AI Mode landen

- Je jünger / explorativer Deine User-/Zielgruppe ist, desto eher werden User den AI Mode nutzen

- Je beratungsintensiver Deine Produkte sind, desto eher werden User am Ende trotz AI Mode bei Dir landen

- Je newslastiger Dein Traffic ist, desto geringer ist das (kurzfristige) AI-Mode-Risiko

Der Blick in die USA zeigt, dass US-User das Feature eher zögerlich annehmen und Google die Nutzung sehr aktiv bewerben muss. Schon beim AI Overview hatten wir das Thema, dass viele User sich Gedanken gemacht haben, wie sie die unterdrücken können. Die Erwartung an Google ist offensichtlich eine andere als die, die an OpenAI gestellt wird.

Trotzdem sind die Zahlen mit Vorsicht zu genießen. Alle Studien werfen hier Navigational Searches (Youtube, MCDonald's, pornhub) oder Suchen mit Short Answers (Einwohner Berlin, Wetter Hamburg) in einen Topf mit Fragen, bei denen der AI Mode tatsächlich einen Mehrwert erzeugen könnte.

Könnte der AI Mode mir möglicherweise Traffic bringen?

Umso schöner, dass Kevin letzte Woche eine qualitative Studie zur AI Mode-Nutzung herausgeben konnte. Sein Fazit: Wenn User den AI Mode nutzen, dann klicken sie selten auf einen anderen Link.

Spannender als die Frage, ob die User aus dem AI Mode auf Deine Seite finden, ist die Frage, ob der AI Mode angenommen wird.

Dennoch kann der AI Mode Dir zusätzlichen Traffic bringen. Insbesondere dann, wenn Du Angreifer bist. Wenn Du weniger Traffic hast, aber guten Content. Wenn Platzhirsche Dir den Weg zum User auf Seite 1 versperren und Du bereits überlegst, wie Du Image-Einblendung, Video und andere Verticals nutzen kannst, um Deinen Branding-Nachteil auszugleichen.

Das wird aber in sehr geringem Ausmaß gelingen. Möglicherweise aber mit einer hohen Conversion oder Warenkorbwerten.

Können wir AI Mode Traffic messen?

Nein!

All diejenigen, die gerade reguläre Ausdrücke für die GSC auf LinkedIn posten, haben die GSC nicht verstanden.

Die Ausdrücke sehen etwa so aus

(?:\[0-9a-zäöüß\]+\[- \]){9,}

(Ich hab auch wesentlich dümmere Varianten gesehen. Im Endeffekt geht es um Suchanfragen mit 9 oder mehr Worten).

Und es ist richtig: Diese Ausdrücke filtern Keywords in der GSC mit diesem Muster.

Aber es gibt zwei Probleme mit diesem Ansatz:

Ein technisches und ein grundsätzliches:

Warum der Filter technisch nicht funktioniert:

Im Interface schlägt das Limit von 50.000 Zeilen zu. Bei größeren Domains / Longtail werden daher eine Menge Queries nicht mit erfasst. Das kannst Du natürlich heilen, wenn Du die RegEx in BigQuery anwendest.

Warum der Filter inhaltlich nicht funktioniert:

Mit dem Filter misst Du kein User-Verhalten.

Google Search Console anonymisiert Queries:

Anonymized queries are those that aren't issued by more than a few dozen users over a two-to-three month period. To protect privacy, the actual queries won't be shown in the Search performance data.

Das bedeutet, dass wir nur Queries erfassen und auswerten können, die mehrfach eingegeben werden.

Je länger die Suchanfrage ist, desto unwahrscheinlicher ist es, dass 2 User die exakt gleich eingeben (inklusive Typos, Wortreihenfolge etc.).

Wenn wir also Queries mit der RegEx erfassen, dann sind das Queries, die oft eingegeben werden. Das machen Scraping-Tools, die seit der Aktivierung von JavaScript, als Bedingung für die Auslieferung der Google Suchergebnisse, vermehrt in der Search Console Impressions erzeugen.

Es gibt keine Möglichkeit AI Mode-Traffic in der GSC auszuwerten, bis Google uns einen entsprechenden Filter bereitstellt.

Und damit ist leider nicht zu rechnen. Schließlich warten wir schon seit Ewigkeiten auf einen Filter für News-Boxen, Images, Featured Snippets, etc.

Der Filter würde ja auch mit den anonymized Queries wenig Informationen bieten.

Wir können mit dem Filter aber natürlich einen Eindruck über das Tracking des Wettbewerbs gewinnen. Eine Auswertung des User-Traffics ist es nicht.

Was kannst Du tun?

Das Wichtigste: Erfahrungen sammeln. Dabei geht es nicht um möglichst viele Daten, sondern wie beim AI Mode auch darum, das Feature kennenzulernen.

Wie baut Google in Deinem Umfeld Antworten auf?

Welche Quellen werden häufig genutzt? Wo liegt ein Fokus bei den Antworten?

Wenn wir das wissen, dann können wir versuchen, diese Fragen gezielt zu optimieren. Mit klaren, eindeutig formulierten und zitierfähigen Aussagen.

Der größte Hebel bleibt aber exzellente SEO-Arbeit.

Der AI Mode startet für jede Suchanfrage/Prompt einen Query Fan Out. Also mehrere Anfragen an die Google-Suche mit Keywords, die unterschiedliche Facetten der Antwort bedienen. Wie strukturiert Google diese Fragen in Deinem Bereich? Welche Seiten werden dann oft zurückgegeben?

Für den AI Mode ist es wichtig in möglichst vielen der Query Fan Out Queries in den Top100 zu stehen.

Die Google Fastsearch, die Google dafür benutzt, hat die meisten Re-Ranking Algorithmen ausgeschaltet.

Es kommt also stark auf klassische Suchmaschinenoptimierung an:

- Sind meine Inhalte indexiert?

- Werden die Inhalte korrekt extrahiert?

- Bin ich in der Posting List zu den relevanten Themen weit genug oben?

- Habe ich die relevanten verwandten Begriffe und Synonyme ausreichend hervorgehoben?

- Nutze ich Ankertexte der internen Verlinkung gezielt, um Schwächen im Content auszugleichen?

- Erkennt Google die richtigen Entitäten in meinem Content, damit ich in der Posting List zur Entität möglichst weit oben stehe?

- Vertraut Google mir und meinem Content? Und vertrauen die User mir?

|

|

| Wie prüfe ich, ob die richtige Version meines Inhaltes rankt? |

Es passiert immer wieder, dass Kunden an uns herantreten und Hilfe einfordern, weil sie gesehen haben, dass in der Google Search Console gemeldet wird, dass Google bestimmte Inhalte als Duplikat erkannt hat und diese “deindexiert” wurden.

Im jüngsten Fall ging es um eine .com-Domain, welche mit drei Foldern:

ausgestattet war und folglich für den DACH-Raum bestimmt ist. Hreflang war wie folgt implementiert:

<link rel="canonical" href="https://www.beispiel.com/de/xyz">

<link rel="alternate" href="https://www.beispiel.com/ch/xyz" hreflang="de-CH">

<link rel="alternate" href="https://www.beispiel.com/de/xyz" hreflang="de-DE">

<link rel="alternate" href="https://www.beispiel.com/at/xyz" hreflang="de-AT">

<link rel="alternate" href="https://www.beispiel.com/de/xyz" hreflang="de">

<link rel="alternate"

href="https://www.beispiel.com/de/" hreflang="x-default">

In unserem Fall würdes es reichen, wenn das Hreflang wie folgt aufgebaut ist:

<link rel="canonical" href="https://www.wngmn.com/de/xyz">

<link rel="alternate" href="https://www.wngmn.com/ch/xyz" hreflang="de-CH">

<link rel="alternate" href="https://www.wngmn.de.com/at/xyz" hreflang="de-AT">

<link rel="alternate" href="https://www.wngmn.com/de/xyz" hreflang="de">

Mit hreflang="de" haben wir eine Catch-all Variante, die alle deutschsprachigen User abholt, die nicht aus der Schweiz oder Österreich kommen. In dem Fall können wir auch auf hreflang="x-default verzichten.

Google sagt dazu:

“If you have several alternate URLs targeted at users with the same language but in different locales, it's a good idea to also provide a catchall URL for geographically unspecified users of that language. For example, if you have specific URLs for English speakers in Ireland (en-ie), Canada (en-ca), and Australia (en-au), provide a generic English (en) page for searchers in the US, UK, and all other English-speaking locations. It can be one of the specific pages, if you choose.”

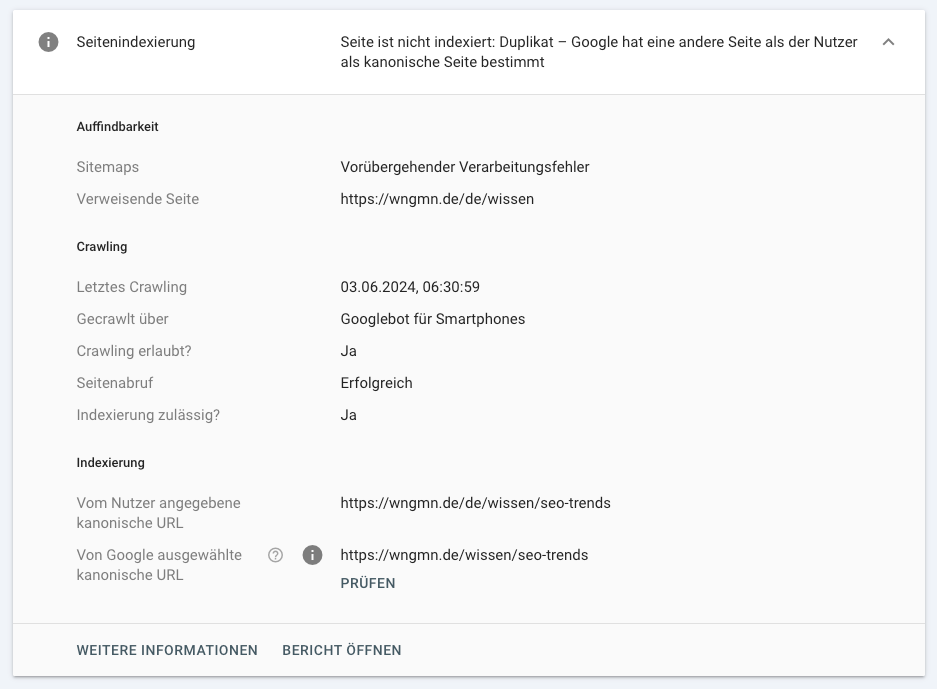

Aufgefallen sind die URLs durch den Google Search Console Bericht “Duplikat – Google hat eine andere Seite als der Nutzer als kanonische Seite bestimmt”.

Da alle drei Varianten inhaltlich exakt gleich sind, aber ein selbstreferenzierendes Canonical haben, tauchen in diesem Bericht natürlich häufig zwei von drei unserer URLs auf. Das hängt davon ab, welche Variante Google aufgrund der eingehenden Signale als Kanonisch ausgewählt hat. Für unseren Kunden war dies kritisch, da er Sorge hatte, dass seine URLs nicht indexiert sind. Diese Sorge ist auch absolut nachvollziehbar. Die URL Inspection sagt ja auch, die Seite ist nicht indexiert.

Hier ist es gar nicht so einfach zu erklären, dass wir genau dieses Szenario als SEOs bevorzugen, da Google alle URLs bekannt sind, aber die Signale auf eine, die kanonische Variante, vereint sind. Auch wenn diese URLs als “nicht-indexiert” im Bericht stehen, sind sie dem Index bekannt. Wir haben es als sekundäre URLs, die der Canonical-Gruppe zugeordnet sind, bezeichnet. Hreflang funktioniert und dass sie ranken, können wir aufgrund der Canonical-Consolidation in der GSC zwar nicht erkennen, aber leicht mit Sistrix visualisieren. Wir geben die unterschiedlichen URLs mit /de/, /at/ und /ch/ bei Sistrix ein und schalten die Länder durch. Nun sehen wir, dass die /de/ Rankings in DE rankt, die /at/ in AT und so weiter. Natürlich nur, wenn Hreflang funktioniert. Sollten wir auch Rankings der URLs auf anderen Märkten sehen, dann sollten wir auf Spurensuche gehen. In unserem Fall mussten wir das nicht.

Manchmal kam es dennoch vor, dass nur zwei URLs in einer Canonical-Gruppe waren, zum Beispiel /de/ und /at/, aber nicht /ch/. Das ist aus Performance-Sicht nicht perfekt, aber der User bekommt immer noch die richtigen URLs ausgespielt. Was meint, dass:

- Canonicals sind immer eine eins zu n-Beziehung: Google merkt sich einen Inhalt und viele URLs, die diesen Inhalt für Nutzer darstellen. Das von Google gewählte Canonical ist die bevorzugte URL dieses Inhalts.

- Hreflang ist immer eine eins zu eins Beziehung: Es sind immer zwei URLs, die sich gegenseitig für bestimmte Sprachen/Sprach-Land-Kombinationen referenzieren. Wenn Google eine URL ausspielen will, prüft es, ob es für Sprache (und Land) eine gültige Hreflang-Alternative gibt. Jede URL kann natürlich mehrere dieser eins zu eins Beziehungen für unterschiedliche Sprachen und Länder haben.

Sofern im Hreflang die /de/ und die /ch/ Variante jeweils miteinander verknüpft sind, wird dem User in CH vermutlich auch die /ch/-Variante ausgespielt, auch wenn ohne Hreflang die /de/-Variante ausgespielt werden würde, da sie die stärkeren Signale hat..

Würde das Hreflang nicht funktionieren, dann kann es passieren, dass die beiden Varianten in Konkurrenz stehen. Hier könnte es im schlimmsten Fall passieren, dass der User die "falsche" Variante ausgespielt bekommt. Es ist aber auch möglich, dass Google aufgrund von passender Länderzuordnung über Länder-Folder oder Top-Level-Domain trotzdem die korrekte Variante bevorzugt.

Kritisch wäre es, wenn das Hreflang nicht funktioniert und Google alle drei URLs in einer Canonical-Gruppe zusammenfasst. Dann wird tatsächlich nur noch eine Variante für alle Märkte ausgespielt und dies mit einer geringeren Performance, abgesehen vom Zielmarkt. Hier kommt es dann auf den Inhalt und die eingehenden Signale an. In so einem Fall sollte das Hreflang-Setup dringend korrigiert werden.

Lass Dich nicht verunsichern, wenn Deine URLs in diesem Bericht auftauchen. Wenn es Sprachversionen sind und Dein Hreflang funktioniert, ist alles fein. Das bescheinigt uns auch Martin Splitt noch mal in diesem Abschnitt seines Videos “How to Avoid Duplicate Content”. Viele andere Gründe, warum Google sich für ein anderes Canonical entscheidet, sind auch legitim, oder ein Hinweis auf Verbesserungspotenzial in der internen Verlinkung oder der inhaltlichen Differenzierung Deiner Inhalte. Wenn die Inhalte nicht zusammengehören, und das von Google gewählte Canonical wirklich nicht zu der URL passt, kann dieser Bericht auch ein wichtiger Hinweis auf Rendering- oder Crawling-Probleme sein.

|

|

| GEO: Ich muss jetzt mal laut schreien! 😱 |

Ich bin ja nicht mehr so stark als SEO-Berater aktiv. Nicht, weil ich das Thema nicht mehr spannend finde. Im Gegenteil. Aber wenn man lange genug dabei ist, merkt man: Die Grundprinzipien im Online Marketing verändern sich kaum.

Klar, in den Details tut sich was. Da ist natürlich Bewegung drin. Auch durch KI. Und hier liebe ich es zu sehen, wie unsere Wingmenschen mit Leidenschaft und Forschergeist reingehen. Ich stehe da mittlerweile ein bisschen an der Seitenlinie und hab mich eher in die beobachtende Position begeben.

Und ich muss ganz ehrlich sagen: Ich versteh grad unsere Szene nicht.

Johan hat dazu in diesem Jahr ja seine Meinung auch schon gesagt (siehe seine Gedanken zu SEO im Panikmodus und zur Namensgebung der “neuen” SEO), aber in den letzten Wochen ging mir selbst auch nochmal richtig der Puls hoch.

Warum? Weil ich mich verarscht fühle.

Verarscht von diesem ganzen GEO-Gelaber.

Ich frag mich langsam: Bin ich eigentlich blöd, oder sind es die anderen?

Da werden auf Konferenzen Vorträge gehalten, in denen im Kern einfach nur SEO-Basics präsentiert werden, was aber als der neue heiße Scheiß verkauft wird.

„Eine komplette KI-SEO-Strategie“ will man uns vorstellen. Und dann spricht man über Strategie, ohne nur ein einziges Mal über Ziele, Zielgruppe und sowas zu sprechen. Unter der Rubrik „Wie GEO & KI die Spielregeln ändern“ wird einfach die SEO Basis-Präsentation von vor 10 Jahren rausgekramt, ein paar kleine Veränderungen vorgenommen und von einer großen Entzauberung der Geheimnisse der neuen KI-Welt berichtet. Und das Publikum klatscht.

Im Ernst jetzt!?

Ich gehe im Folgenden mal auf ein paar Aussagen ein, die mir in den letzten Wochen bei LinkedIn oder auf Konferenzen begegnet sind, die ich einfach nicht verstehe.

„GEO ist nicht einfach SEO 2.0: GEO denkt über die Website hinaus. Es geht nun um eine Breite an Touchpoints, Brand Mentions und Citations.“

Den Punkt verstehe ich nicht. Ging es nicht schon immer darum, dass man seine Marke über alle relevanten Touchpoints hinweg sichtbar macht? Genau prüft, wo und über welchen Kanal bzw. welche Suchmaschinen o.ä. ich meine Zielgruppe erreiche?

Und dafür war und ist es nötig, dass ich nicht nur Onpage meine Hausaufgaben mache, sondern über den Tellerrand hinweg schaue. Den SEO-Teil davon haben wir Offpage oder Linkaufbau genannt.

Gut, ob jetzt Offpage eine dezidierte SEO-Disziplin ist oder das nicht besser in die Hände von PR- und Branding gehört, darüber könnte man streiten. Aber warum tun wir jetzt so, als sei das etwas Neues?

„GEO funktioniert nur interdisziplinär: SEO, PR, Social, Content müssen zusammenarbeiten.“

Ach was! Interdisziplinäre Zusammenarbeit war schon immer die beste Lösung, um eine konsistente Markenbotschaft über alle Kanäle hinweg zu etablieren. Aber anstatt 15 Jahre diese Sau durchs Dorf zu treiben, frage ich mich: Warum kriegen wir das eigentlich nicht hin? Warum gibt’s keine Vorträge darüber, wie Teams das endlich mal hinbekommen?

Das wär mal spannend.

„KI-Systeme funktionieren anders als herkömmliche Suchmaschinen.“

Schön! Aber was heißt das praktisch?

Also nach meinem Verständnis gibt es zwei Optimierungshebel, um in LLMs und LLM-Suchmaschinen gut aufgestellt zu sein:

- Du musst im Grunddatensatz vorkommen, also schon vorher gute Arbeit gemacht haben. Sonst kannst Du da eigentlich gar nicht so viel mehr beeinflussen.

- Du musst sichtbar sein, wenn ein RAG (Retrieval Augmented Generation) ausgelöst wird. Anders ausgedrückt: wenn das LLM nach aktuellen Informationen sucht. In Suchmaschinen!

Und was muss ich tun, um in Suchmaschinen gut aufgestellt zu sein? Yes baby, das nennt sich Suchmaschinenoptimierung. Ja, es gibt hier ein paar kleine Unterschiede. Die sollte man auch kennen und benennen dürfen. Alles gut. Aber ich frage mich, wo ist denn hier der besagte Paradigmenwechsel? Was ist hier denn wirklich so neu? Mir fallen da immer wieder Empfehlungen auf, die mir irgendwie bekannt vorkommen.

Beispiel gefällig?

Da wird empfohlen, Texte mit Zusammenfassungen zu versehen: „Das Wichtigste in Kürze“. Oder Inhalte stärker an Fragen auszurichten, weil Menschen in LLMs eher Fragen stellen.

Also ich weiß nicht, was die GEOs in den letzten Jahren nicht mitbekommen haben, aber ich erinnere mich zumindest an den Hype um Voice Search, die Integration von „People Also Asked“ und die große Welle der FAQs-Markups. Hat uns das nicht bereits dahin geführt, dass wir Inhalte mehr in Richtung "Fragen und Antworten" strukturieren?

„Neue Messgrößen, neue Strategien – Brand Mentions, Sentiment, Prompt-Strategie.“

Klar, die Metriken verändern sich. Traffic wird weniger wichtig, weil Suchmaschinen immer mehr Antworten direkt liefern. Das stimmt. Und ja, LLMs beschleunigen das nochmal.

Am Ende ging es bei SEO aber auch immer schon darum, relevanten Traffic zu erhalten. Einer, der konvertiert und am Ende Umsatz bringt. Daran wird sich gar nichts ändern.

Ob Du’s jetzt über Keywords, Prompts oder Mentions misst, ist eigentlich zweitrangig. Das Prinzip bleibt gleich. Es geht um den Effekt, nicht ums Etikett.

Nennt es, wie ihr wollt, aber verkauft es nicht als Revolution.

Wenn der Begriff „GEO“ hilft, das Thema in Unternehmen zu verankern, dann nutzen wir ihn halt. Vermutlich müssen wir hier als Wingmen auch lernen, noch mehr über unseren eigenen Schatten zu springen. Keine Ahnung. Für mich steht GEO eigentlich immer noch für Geologie. Aber gut, die Welt dreht sich weiter und das bringen wir dem Erdt als auch Kunde(n) schon noch bei.

Aber einen Wunsch hab ich dennoch: Lasst uns zumindest auf Konferenzen, wenn wir schon unter uns SEOs sind, ehrlich miteinander sein und nicht alten Wein in neuen Schläuchen präsentieren! Ganz ehrlich: es gibt in der Tiefe noch so geilen Scheiß in unserem Feld zu entdecken und zu erforschen, da können wir uns dieses Marketing-Mätzchen echt sparen.

So, grad hat’s geklingelt. Die nächste Unterrichtsstunde geht schon wieder los. Ich muss los. Viel Spaß mit dem nächsten Artikel…

|

|

| Kalifornien arbeitet am globalen Tracking-Opt-Out |

Kalifornien verpflichtet Hersteller von Browsern und Mobilgeräten, Tracking-Opt-out-Einstellungen für alle Nutzer leicht zugänglich zu machen. Gemeint ist damit der Nachfolger der DNT-Headers: Global Privacy Control (GPC).

Warum finde ich das spannend?

Als Kalifornien sein Pendant zur Datenschutzgrundverordnung, den CCPA (California Consumer Privacy Act), verfasst hat, hat man scheinbar aus den Fehlern der DSGVO gelernt.

Um Nutzer nicht mit unpopulären “Cookie-Bannern” zu nerven, wurde ein anderer Ansatz gewählt: Der CCPA ist im Vergleich zur DSGVO weniger streng und basiert auf einem Opt-out-Modell statt auf einem Opt-in. Unternehmen dürfen also tracken, sind jedoch verpflichtet, den Nutzern eine Widerspruchsmöglichkeit anzubieten.

Das ist toll, denn in Kalifornien sind keine nervigen Consent-Banner nötig, deren Dark Patterns und Nudging-Methoden nach und nach durch die Instanzen weggeklagt werden müssen.

Das ist doof, denn in dem Moment, in dem ein Nutzer auf den Widerspruch-Link klickt, sind im Zweifel bereits die ersten Real-Time-Bidding-Verfahren durchgelaufen. Dabei wurden genügend Informationen gesammelt, verwertet und an Hunderte dubiose Adtech-Unternehmen weltweit verteilt, um den Nutzer identifizierbar zu machen. Der Widerspruch schützt die Privatsphäre also nur dann effektiv, wenn er bereits beim initialen Seitenaufruf mitgesendet wird.

Daher hat die CCPA (California Privacy Protection Agency) (und auch andere Bundesstaaten) das GPC als rechtlich bindend anerkannt und setzt die Vorgabe auch aktiv durch.

Wie DNT ist GPC einfacher HTTP-Header. Wenn Sec-GPC: 1 dann kein Tracking, fertig. In Firefox genügt dafür ein Klick in den Browser-Einstellungen, in Browsern wie Brave ist GPC sogar standardmäßig aktiviert.

Anders sieht es bei den großen Browsern und Smartphone-Apps aus. Google und Co. würden eine breite Aktivierung der GPC-Funktion direkt im Geschäftsmodell treffen…

Zwar gibt es GPC-Extension für Chrome, Safari und Edge, doch Google, Apple und Microsoft weigern sich bislang erfolgreich, GPC nativ in ihre Browser zu integrieren. Ganz zu schweigen von Android oder iOS: In der US-Privacy-by-Opt-out-Welt ist es bisher kaum möglich, Apps zu installieren, ohne dass diese zunächst alles Erfassbare nach Hause funken dürfen.

Für uns in der EU hat das zunächst keine direkten Auswirkungen. Hier ist für jedes Tracking ein individueller Opt-in erforderlich. Daran ändert sich auch nichts, wenn Browser und Betriebssysteme GPC-Einstellungen anbieten. Vermutlich wird auch weiterhin das Wegklicken eines Consent-Banners als „informierte Entscheidung“ gewertet und damit als gültiger Opt-in behandelt.

Trotzdem ein Sieg für die Privatsphäre:

Google und Co. sind nun verpflichtet, GPC in Browser, Android und iOS zu integrieren. Sie haben sechs Monate Zeit…

|

|

| Von der Prokrastination zur Produktivität: Was unser Gehirn wirklich davon abhält, anzufangen |

Kennst Du das? Du weißt genau, was Du tun solltest, aber stattdessen räumst Du den Schreibtisch auf, checkst noch mal Mails oder machst… einfach gar nichts. Willkommen in der Welt der Prokrastination. Ein Phänomen, das weit verbreitet ist, aber oft falsch verstanden wird.

In diesem Artikel schauen wir uns an, was hinter dem Aufschieben steckt, was in unserem Gehirn dabei passiert und wie man die inneren Blockaden gezielt austricksen kann.

Warum wir prokrastinieren: Ein psychologischer Blick

Prokrastination ist keine Faulheit, sondern ein emotionales Problem der Selbstregulation. Unser Gehirn hat einen inneren Konflikt:

Das bedeutet: Wenn eine Aufgabe mit negativen Gefühlen wie Stress, Unsicherheit oder Langeweile verbunden ist, schaltet das Gehirn auf Vermeidung und zwar unbewusst. Deshalb greifen wir dann zu angenehmeren Tätigkeiten wie Social Media oder Kaffeekochen. Kurzfristig bringt das Erleichterung, langfristig aber Frust.

Kurzfristiges Belohnungssystem vs. langfristige Ziele

Ein weiteres Problem: Unser Gehirn liebt sofortige Belohnung. Dinge, die uns jetzt ein gutes Gefühl geben (z. B. das Checken einer Nachricht), werden bevorzugt gegenüber Zielen, die in der Zukunft liegen (z. B. der fertig geschriebene Report nächste Woche).

Die Folge: Wir werden Opfer des sogenannten „Present Bias“: Unsere Gegenwartsperson sabotiert unsere Zukunftsperson.

Was hilft wirklich gegen Prokrastination?

Hier einige Strategien, die Du sofort ausprobieren kannst:

1. Die 5-Minuten-Regel

Sag Dir: „Ich mache das nur 5 Minuten.“

Oft ist der Anfang die größte Hürde. Wenn Du einmal drin bist, läuft es weiter. Psychologisch nennt man das den „Commitment-Effekt“.

2. Aufgaben kleinteilig machen

Das Gehirn schiebt oft auf, weil es die Aufgabe als zu groß empfindet. Besser: Statt „Präsentation erstellen“ → „Folienstruktur grob skizzieren“.

3. Emotionale Ebene ansprechen

Stell Dir nicht nur vor, was Du tun musst, sondern warum Du es tun willst. Positive Emotionen aktivieren das Belohnungssystem und motivieren mehr als reine Pflichterfüllung.

4. Ablenkungen bewusst entfernen

Klingt banal, ist aber wirksam: Tabs schließen, Handy in den Flugmodus, klare Zeitfenster setzen. Schon kleine Reize reichen, um die Konzentration zu sprengen.

5. Selbstmitgefühl statt Selbstkritik

Menschen, die sich selbst bei Fehlern liebevoll statt hart behandeln, prokrastinieren langfristig weniger. Schuldgefühle führen dagegen oft zu noch mehr Aufschieben.

Fazit

Prokrastination ist kein Zeichen von Faulheit, sondern ein Signal Deines Gehirns, dass etwas im Argen liegt – oft auf emotionaler Ebene. Wer sich selbst besser versteht, kann sich wirksam selbst führen. Mit kleinen mentalen Tricks und einem realistischeren Umgang mit sich selbst gelingt es, vom Aufschieben ins Tun zu kommen.

|

|

|

|

|

Fragen? Immer gerne fragen!

|

Wir sind für Dich da.

Schreib uns gern jederzeit

eine E-Mail an [email protected] oder

ruf uns einfach kurz an: +49 40 22868040

Bis bald,

Deine Wingmenschen

|

|

Anckelmannsplatz 1, 20537 Hamburg, Germany

|

|