| Wirklich wahres Wingmen SEO Wissen für wache Webmarketer #234 |

|

|

| ❄️ Winter überrascht SEO-Landschaft – und Wingmenschen erobern Salzburg! |

Der Winter hat in dieser Woche mit überraschendem Schneefall einige Städte verzaubert, doch unsere Wingmenschen haben sich davon nicht aufhalten lassen! Am 21. und 22.11. fanden in Salzburg die Online Expert Days (SEOkomm+OMX) statt, und wir waren mit spannenden Vorträgen mitten im Geschehen:

🎤Johan hat die Menge mit seinem Abenteuer rund um den Dokumentenelf Doki begeistert, während 🎤 Darius auf der OMX mit einem inspirierenden Vortrag zum Thema Leadership im Online Marketing für neue Impulse sorgte.

Die SEO-Community hat sich in Salzburg vernetzt, ausgetauscht und jede Menge frische Ideen mitgebracht. Für alle, die nicht vor Ort sein konnten, haben wir in diesem Newsletter ein paar spannende Insights parat.

Auf die Piste fertig los!

- Skispringer Philipp, der sich LLMO nähert

- Snowboarder Florian, der einen Backflip zum Thema SEO Basics und KI zeigt

- Biathletin Jolle, die in einem Recap auf die Highlights der Online Expert Days zielt

- Hundeschlittenfahrer Behrend, der an einem Update in der Google Search Console vorbeigerodelt ist

- Schneepflug Nils, der in seinem Artikel den Weg für die Produktdetailseiten (PDPs) freimacht und erklärt, wie du sie auf die Google-Shopping-Piste bringst

Viel Spaß beim Lesen!

Deine Wingmenschen

|

|

| Durch LLMs ändert sich alles (oder nichts?) |

Wenn SEO tot ist, dann lebt wenigstens die Large Language Model Optimization (kurz LLMO).

Spoiler: LLMO und SEO haben viel gemeinsam. Im Prinzip ist SEO das Fundament für KI-Suchmaschinen.

In diesem Sinne habe ich letztens Malte Landwehr im SEOPresso Podcast bei Sistrix gelauscht.

Etwa eine Stunde für Dich kondensiert auf das Wesentliche und gespickt mit meinem Gedankensalat (= weniger als 6 Minuten Lesezeit). Lass’ uns keine Zeit verlieren. ⬇️

LLMs und LLMO in a nutshell

Ein Large Language Model (LLM) ist ein großes Sprachmodell, das das nächste Wort mit der größten Wahrscheinlichkeit, welches auf eine Wortkette oder einzelne Worte folgt, vorhersagt. Was rauskommt wirkt wie eine (fast) menschliche Konversation, die man mit ChatGPT, Claude & Co. haben kann.

LLMO ist die Optimierung und der Aufbau von Sichtbarkeit und Traffic in diesen Modellen und entsprechenden LLM-Suchmaschinen.

Diese Ansätze müssen wir unterscheiden: Foundational Models und Retrieval Augmented Generation

1. Foundational Models und deren Grunddatensätze

Hat ein LLM keine Möglichkeit, das Internet als Quelle zu verwenden, dann gibt es ein abgeschlossenes Training. Alles, was nach diesem Zeitpunkt kommt, kann das LLM nicht wissen, auch wenn es Dir das gerne vorgaukelt.

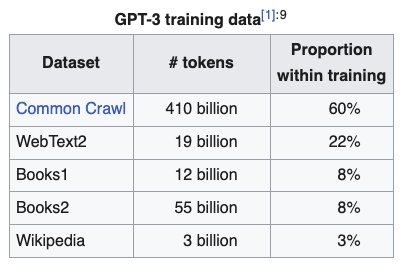

GPT-3 wurde bspw. mit Common Crawl, WebText2 (Reddit Threads in denen es Kommentare, mind. 3 Upvotes und ausgehende Links gibt) und Büchern trainiert:

Bildquelle: Wikipedia

Wenn Du in derartigen Antworten auftauchen möchtest, musst Du die zugrundeliegenden Grunddatensätze beeinflussen (oder manipulieren).

Malte denkt, dass das (= einen großen Grunddatensatz eines zukünftigen Foundational Models zu beeinflussen) theoretisch auch heute möglich, aber praktisch kaum umsetzbar ist. Kein (einzelnes) Unternehmen hat die notwendigen Ressourcen, um das im großen Stil zu machen.

Aber: Dass es Interesse an Manipulation gibt, wissen nicht nur wir, sondern auch die Unternehmen, die diese Modelle trainieren. Hinterher ist man immer schlauer und “vorausschauender”.

In die Antworten kommst Du nur langfristig und mit vernünftigen Maßnahmen rein, wenn Du Menschen dazu bringst, positiv über Dich und Deine Marke zu sprechen (= gutes Reputationsmanagement).

Man kann nicht viel anderes machen, außer für einen langen Zeitraum gute Arbeit zu leisten – zuverlässige Hacks, Cheat Codes und Abkürzungen, die langfristig funktionieren, gibt es (wie immer) nicht.

2. Retrieval Augmented Generation (= RAG)

Hat das LLM keine Daten, kann es das Ass im Ärmel ziehen. Anstatt nur auf bestehende Daten zurückzugreifen, zapft es das Internet für aktuelle Quellen an. Auf der Basis funktionieren auch AI Overviews, Perplexity AI, ChatGPT Search, etc.

Wie kommt man da rein?

Was auf jeden Fall hilft, sind gute Rankings bei Bing und Google. Es gibt zwar Studien, die unterschiedliche Erkenntnisse gewinnen, aber man muss immer auf die Quelle achten.

SGE Readiness Checks, SGE Traffic Loss Prevention, AI Overview Reportings…alles Quatsch. Schon vor mehr als einem Jahr habe ich geschrieben, dass viele Studien & Co. dazu da sind, Angst zu schüren und wir uns nicht verunsichern lassen dürfen.

Agenturen und Tool-Anbieter haben Anreize, ihre Produkte zu verkaufen. Malte hat es brillant formuliert:

“Zufälligerweise, kommen die immer zu dem Schluss, dass da alles ganz anders ist, als in den organischen Rankings.”

Sistrix hat eine gute Studie zum Thema AI in der Suche veröffentlicht, die zeigt, dass die Unterschiede zwischen normalen Rankings und AI Overviews weniger groß sind, als die Angstmacher behaupten.

Was kannst Du ansonsten tun?

Kookkurrenzen steigern. Damit ist gemeint, dass Du die Erwähnung Deiner Marke im Kontext mit für Dich relevanten Themen steigerst. Im Prinzip also gute, digitale PR und Markenaufbau. Kostet Geld, ist viel Arbeit.

Eine richtig gute Marke zu sein, kann man sich nicht “einfach” kaufen, extrem beschleunigen oder hinterhältig klauen.

Ansonsten braucht man natürlich relevante Inhalte, ein sauberes technisches Fundament und muss es (Maschinen) so einfach wie möglich machen:

- Eine schnelle, performante Seite

- Wenig JS-Abhängigkeit bei Inhalten

- Zusammenfassungen des Inhaltes

- Ausführliche strukturierte Daten

- Vernünftig auslesbare, unstrukturierte Daten

Brauchst Du LLMO und musst Du bei Reddit aktiv sein?

Nein, nicht alle Marken brauchen LLMO. Die Bäckerei um die Ecke, auch wenn sie einen Webauftritt hat, muss vermutlich kein Geld in die Hand nehmen.

Das gilt aber auch für jede Marke, deren Zielgruppe LLMs und -Suchmaschinen nicht oder nur wenig nutzt. Es muss auch nicht jede Marke auf Reddit aktiv sein. Vor allem dann nicht, wenn Deine Community dort nicht aktiv ist.

Malte hat unter anderem den Hinweis gegeben, dass deutsche Subreddits oft antikapitalistisch und Anti-Unternehmen sind. Das heißt, Du wirst es mit einem Unternehmensaccount eher schwierig haben. Und was (wie immer) nicht funktioniert ist, wenn Du nur vorgaukelst Teil der Community zu sein.

Wie Du LLM Traffic und Deine LLM-Sichtbarkeit messen kannst

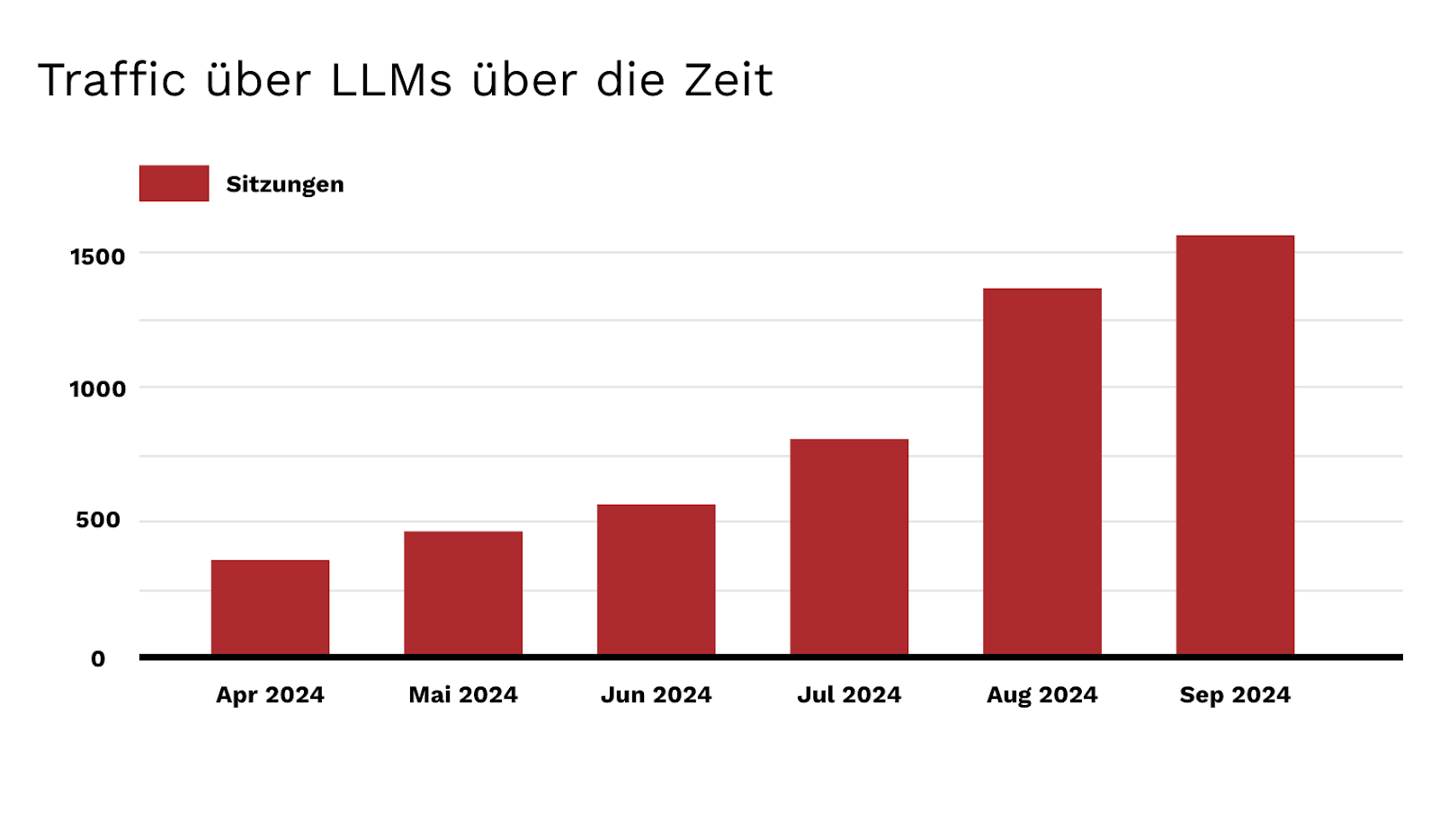

Für den Anfang tut es ein einfaches GA4 Monitoring. Jes Scholz hat dazu vor ein paar Monaten eine einfache Anleitung bereitgestellt.

So kann das am Ende in einem Chart aussehen:

Im Oktober und November müsste es für unterschiedliche Domains durch ChatGPT Search erwartungsgemäß einen Schub geben. Ivan Palii hat dazu kürzlich Zahlen geteilt.

Sistrix, ahrefs, Semrush & Co. tracken AI Overviews – aber nicht im Detail wie ziptie – auch wenn das Tool vor einigen Monaten bei uns eindeutig durch die Qualitätskontrolle gefallen ist (don’t get me started).

Es wird auch fleißig an Tools, die die allgemeine LLM-Sichtbarkeit messen, geschraubt. Ahrefs hat das auf der Evolve Konferenz und in einem neuen Artikel kurz gezeigt:

Richtigerweise hat Malte darauf hingewiesen, dass ein Monitoring nur Sinn macht, wenn man nicht nur eine Abfrage pro Tag oder Woche macht. Die Antworten in LLMs variieren.

Selbst wenn Du 100x am Tag abfragst, sind die Ergebnisse oft nicht stichfest genug, um die 10 sichtbarsten Domains/Marken zu erheben. Man möchte auch nicht nur eine Abfrage, sondern viele unterschiedliche machen.

Das vernünftig zu monitoren kostet viel Geld. Wenn man daraus keine Handlungen ableitet, dann nützt einem das Reporting nichts.

Merke Dir: Ein Reporting, was niemand liest und als Resultat daraus handelt, ist ein Reporting, das niemand braucht.

Die große Gefahr der Manipulationen

SEO kommt wieder in Verruf, weil “wir” uns weigern, unsere Arbeit “richtig zu machen”. Wobei “wir” eigentlich falsch ist, denn Markenaufbau und digitale PR haben andere Profis am besten in der Hand.

SEO kann (und sollte) mitspielen, aber nicht alleine das Zepter tragen.

Zu Reddit gab es schon genug News-Meldungen von Spam und Handbüchern zur Manipulation. Ich halte davon nichts (meine Position zum Thema Manipulationen).

Wenn Du eine Marke bist: Finger weg von dem Manipulationsschmutz.

Arbeite hart und vergiss kurzfristige Abschöpfungsstrategien, die Dich in Teufelsküche bringen.

Black Hats kommen natürlich wieder auf tolle Ideen. Hier mal ein paar Beispiele:

- Ein Bot, der die eigene Marke immer positiv und andere Marken negativ kommentiert

- Ein Bot, der die eigene Marke upvotet und andere downvotet

- Ein eigenes Subreddit, was durch Fake-Interaktionen hochgezogen ist

- Nachträgliche Änderung von Kommentaren, wenn niemand schaut

Das zu schreiben und darüber nachzudenken ist für mich schon absurd. Was eine Zeitverschwendung für etwas, was offensichtlich falsch, kurzsichtig und (zumindest für mich) moralisch nicht vertretbar ist. Alles, weil ich unfähig oder unwillig bin, es richtig zu machen.

Wie ein kleines Kind, das sich weigert, nach den Regeln zu spielen.

Merke Dir: Vertrauen entsteht über Jahre. Zerstören kannst Du es in Sekunden.

Die goldene Frage, die man sich in Zusammenhang mit LLMs stellen muss

Was sind die Inhalte und Formate, bei denen meine Zielgruppe immer noch klicken muss, selbst wenn sie eine Antwort bekommen hat?

Möchte jemand ein Produkt kaufen, landet dieser Traffic bei mir, wie auch bei Dienstleistungen, dem Wunsch ein Video zu schauen, etc.

“A lot of websites focus on things that have informational intent. As an example, Home Depot. If you’re trying to fix something in your house, you find Home Depot. [...] SGE AI will tell you how to fix something, but you still have to buy it from Home Depot. [...] The whole internet is changing, but the money spent is not changing.”

– Eli Schwartz (Strategic SEO & Growth Advisor)

Informationale Inhalte verlieren an Wert, wenn es beim Konsum nur um die Information an sich geht. Aber wir konsumieren Inhalte nicht nur wegen Informationen, sondern auch,

- um Insights zu generieren (geht über Informationen hinaus),

- Meinungen anderer in Erfahrung zu bringen,

- an bestimmten Persönlichkeiten Interesse haben und

- weil manche Inhalte unglaublich gut geschrieben und die Konsumerfahrung besonders sind.

Ein paar Beispiele:

- Built for Mars Case Studies

- How Google Perfected The Web

- Thought Leadership Content

- “Why Great Marketing is Risky as Hell”

- “Zero Click Content”

- “The Law of Shitty Clickthroughs”

- “In Defense of Strategy”

Worum es am Ende geht um in LLMs erfolgreich zu sein

Zusammengefasst ändert sich nicht viel, auch wenn Trickbetrüger etwas anderes behaupten.

TL;DR:

- Habe eine gute SEO = gutes Ranking bei Google und Bing

- Baue ein sauberes, stabiles und schnelles technisches Fundament

- Mache es Maschinen (und Usern) so einfach wie möglich

- Sei eine gute Marke

Ich muss es in diesem Artikel bei Weasel Words belassen. Zu Thema 1-3 liest Du hier jede Woche 5 Artikel. Eine gute Marke zu sein ist nichts, was SEO alleine verantworten sollte.

P.S. Du kannst mit Punkt 4 anfangen, indem Du “How Brands Grow” von Byron Sharp liest.

|

|

| SEO-Erfolg durch Grundlagen und KI |

Mit Bada Boom Bada Bang ist nicht nur Björn Darkos Rap auf der SEOkomm eingeschlagen, sondern auch das geballte Fachwissen der Speaker:innen. So wie einige meiner Kolleg:innen, möchte ich Dir heute ein wenig davon mitgeben.

Stephan Czysch hielt einen Vortrag “Einfach einfach", in dem er an SEOs appellierte, sich wieder auf die Basics zu besinnen. Eines dieser Basics ist zum Beispiel eine vollwertige Analyse, wie viel Deines Themenbereichs Du bereits abdeckst. Hast Du für Deine wichtigsten Keywords passende Landingpages? Und deckst Du auch bereits alle Variationen ab?

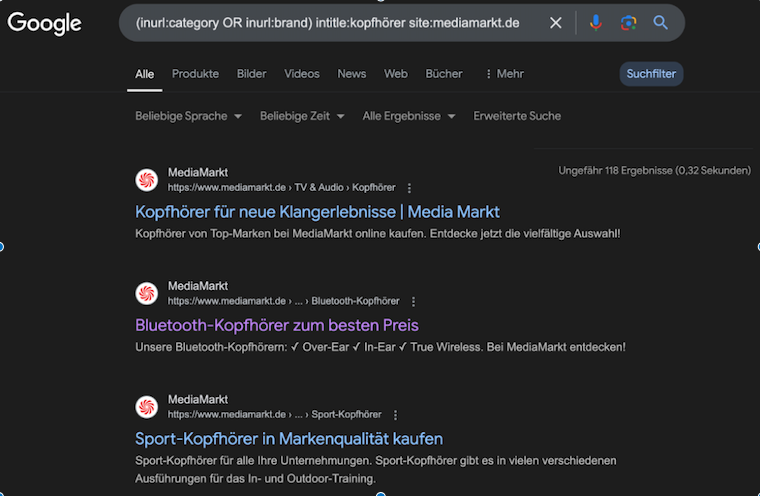

Beleuchtet hat er das für das Beispielthema “Kopfhörer” für Media Markt. Mit einer Site-Abfrage sieht man, dass Media Markt bereits etwa 120 Seiten für das Thema hat.

Disclaimer: Das ist nur eine grobe Schätzung von Google, es könnten auch mehr oder weniger sein.

Überlegt man sich jedoch einmal, wie viele Keyword-Variationen es gibt, reicht das lange nicht. Stellt man sich zum Beispiel nur die Kombinationen von Marken, Farben und Eigenschaften wie “wasserfest” oder “kabellos” vor, könnte MediaMarkt laut Stephan wahrscheinlich recht realistisch das fünffache bedienen.

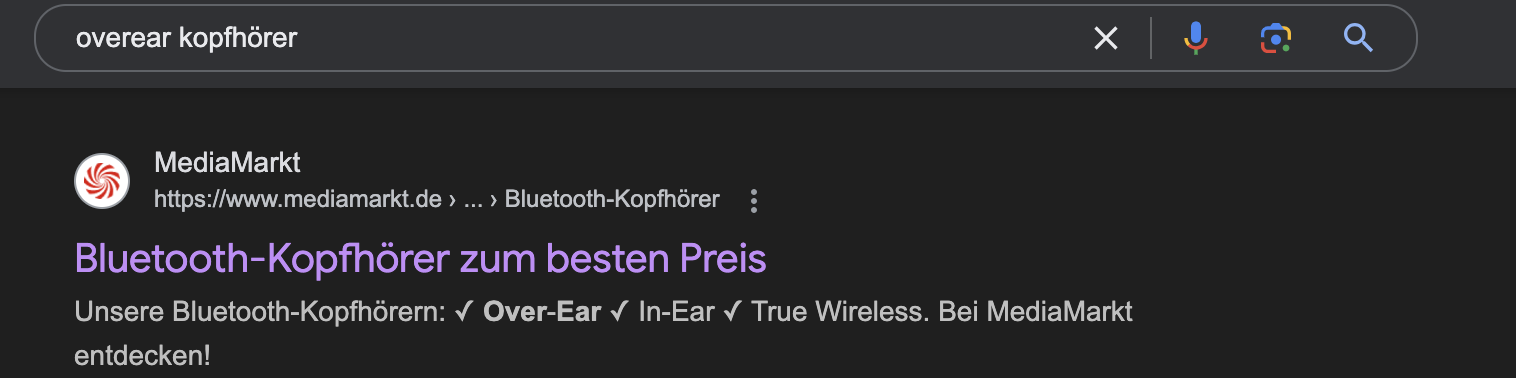

Einen Beleg dafür, dass MediaMarkt tatsächlich noch nicht für jede Kategorie die passende Landingpage hat, findet man schnell, z.B. durch eine Suche mit dem Keyword “Overear Kopfhörer”:

Bluetooth-Kopfhörer sind für Menschen, die nach “Overear Kopfhörern” suchen, wahrscheinlich nicht die relevantesten Produkte.

Eigentlich ist so eine Recherche nichts neues, aber wir SEOs tendieren dazu, uns von dem neuesten, glitzernden Trend der Szene ablenken zu lassen. An dem Beispiel erkennt man, was für ein großer Hebel Basics sein können. Anhand dieses Beispiels kann man aber auch gut das wahrscheinlich größte Thema der gesamten Konferenz beleuchten.

Denn wie setzt man diese Mehrcontent-Kreation am besten um? Natürlich mit KI.

Auf dem Abschlusspanel haben sich Bastian Grimm, Irina Hey und Kevin Indig relativ einstimmig für den Nutzen von Programmatic-SEO ausgesprochen. Also dem Nutzen von KI für SEO, um großflächig Landingpages zu erstellen.

Aber halt, “Das ist doch Spam!” denkst Du Dir dabei vielleicht.

Und ja, ganz leugnen kann man diese Aussage nicht. Der Content, der dabei herauskommt, bewegt sich dicht an der Grenze zu Spam. Allerdings ist der "Spam", den eine gut eingestellte und mit vernünftigen Daten gefütterte KI für dich schafft, nicht der gleiche Spam, den wir von Standard-KI gewohnt sind.

Gute Programmatic-SEO führt zu “mittelmäßigem Content”. Der Content ist in den meisten Fällen nicht komplett unbrauchbar, es ist allerdings auch kein großartiger Content. Die Qualität reicht nicht, um diese Texte auf Deinen wichtigsten Seiten für Deine wichtigsten Themen einzubinden. Mittelmäßiger Content ist allerdings besser als gar kein Content. Vor allem für große Unternehmen.

Spielen wir den Gedanken einmal am Beispiel von MediaMarkt weiter. Gehen wir davon aus, dass sich aus der Themenrecherche 400 potenzielle neue Kategorien auftun. Kapazitäten sind aber schneller weg als Klopapier während der Corona-Zeit. Statt diese Kategorien gar nicht umzusetzen, könnte man ebenfalls anfangen, KI-Texte einzubinden.

Nochmal: KI-Texte sind bisher noch nicht auf dem Level, dass sie wirklich auf Deine wichtigsten Hauptseiten integriert werden sollten. Da waren sich die Speaker:innen der SEOkomm einig. Um schnell und ohne viel Aufwand viele neue Themen zu bedienen, funktioniert es allerdings.

Spätestens an dieser Stelle könntest Du jetzt Deinen zweiten “Halt, warte mal!”-Moment haben. Das Erstellen von haufenweise mittelmäßigem Content kann doch nicht gut für die Gesamtqualität meiner Seite sein? Was ist denn mit Content Prunning?

Das war ebenfalls ein Thema, welches auf der SEOkomm des Öfteren aufgegriffen wurde. Lustigerweise sogar mitunter in Stephans Vortrag. Ähnlich wie Du es von Deiner Domain kennst, sind meist nur wenige Seiten für den Großteil deines Traffics verantwortlich. Zusätzlich dazu erhöht das Entfernen von Seiten mit niedriger Qualität meist die Gesamtqualität Deiner Domain und somit das Ranking Deiner wichtigsten Seiten.

Wie passen also die Thesen “Mittelmäßiger Content ist besser als gar kein Content” und “Weniger ist mehr” zusammen?

Die Antwort ist quasi die SEO-Version von 42: It depends.

In einer idealen Welt gehst Du beide Prozesse zusammen an. Du deindexierst all deine Schrott-Seiten um deinen anderen Seiten einen Uplift zu geben. Gleichzeitig erstellst Du neuen Content um Dein volles Themen-Potenzial auszuschöpfen. Allerdings ist hier Kontrolle und Beobachtung wichtig.

Wenn Deine ganzen neu erschlossenen Themenseiten ebenfalls anfangen, in den leblosen Teil Deiner indexierten Seiten zu rutschen, bleiben auch diese nicht von Säuberungsmaßnahmen verschont. Wenn sie auf der anderen Seite allerdings anfangen sich zu beweisen, kannst Du versuchen, diese mittels händischer Optimierung in die Reihen Deiner Traffic-Treiber einzugliedern.

Allerdings solltest Du Themen wie Programmatic-SEO erst angehen, nachdem Du Deine Basics abgedeckt hast. Sonst lenken Trends Dich nur von dem, was wirklich wichtig ist, ab. Quasi die Quintessenz von Stephans Vortrag.

Je nach Fall kann es sich zum Beispiel mehr lohnen, die Zeit, welche Du in die Erstellung der 400 Seiten steckst, lieber in eine vernünftige Seite zu stecken. Was bringen dir 400 Rankings auf Seite 2, für Keywords mit mäßigem Suchvolumen, wenn du auch ein Top 3 Ranking für einen für Dich sehr relevanten Begriff haben kannst?

Fazit ist also, dass Du nicht einfach blind mit ChatGPT massenhaft neue Inhalte erstellen solltest. Manchmal mag es Sinn machen. Manchmal lohnt sich die alte Methode mehr. Allerdings ist die Tatsache, dass es mittlerweile möglich ist, Programmatic-SEO erfolgreich zu nutzen, etwas, dessen Du Dir bei Deiner Strategiesetzung bewusst sein solltest.

Ebenso solltest Du Dir allerdings auch folgende Punkte bei Deiner Strategieentwicklung im Hinterkopf halten:

- Basics sind nie verkehrt

- KI ist kein Allheilmittel

- Du solltest KI nutzen um Deine Prozesse zu beschleunigen

Weitere Einsichten in die SEOkomm gibt Dir Nils in seinem Artikel.

|

|

| OMXOXDSEOKOMMSALZBURG RECAP No. 9347 |

Und wieder sitze ich übernächtigt, emotional aufgeladen und fachlich inspiriert an meinem Rechner und sortiere die Impulsblitze, die Uschi und Oliver Hauser in Salzburg auf mich eingeschossen haben.

Skippe diese Zeilen, Du lernst hier nichts:

- Eine zentrale Location in der Innenstadt macht wirklich alles einfacher und sorgt für kürzere Kloschlangen 🎯

- Den wilden Mix aus den Hashtags #OMX, #SEOkomm, #OXD kriegt mein System mit Mühe entknotet, aber mehr Branding Power sehe ich in einer zentralen Marke für alles 🍝

- Sabine Langmann, mein Augenbrauen Picasso und biggest conference crush of all time, Danke für die Lacher (sorry Rox) 🎨

- Respekt Olaf Pleines für Deinen genialen Vortrag. Danke, dass Du und Annika Muus uns so herzlich in Eurer Runde aufgenommen habt ♥️

- Anna Kruse, beste Gesellschaft 👯

- Hey Björn Darko, ich hab nie behauptet, gute Musik zu produzieren 🎶

- Danke für den Austausch auf halber Treppe Kevin Indig, time to insight immer erfrischend niedrig bei Dir

- Shoutout an die Triangel Salzburg: Die Kellner wissen vermutlich heute immer noch nicht, was sie da überfahren hat 🪰

- Hallo Hotel: Finnische Sauna und dann nur 70 Grad gilt nicht 🧊

- Danke an Afterwork Salzburg, die den Eimer immer wieder vollgegossen haben, nachdem uns ein liebenswürdiges älteres Ehepaar Zugang zu ihrem Event verschafft hat 🍾

- Posaunen vom Turm in der Altstadt. Fantastisch 🎺

- Große Wingmenschen-Liebe. Sowieso 🪽

So, jetzt aber Inhalt. Es gab wirklich richtig viele gute Vorträge. Von jedem Konferenztag hab ich Dir mal jeweils einen besonders schönen mitgebracht:

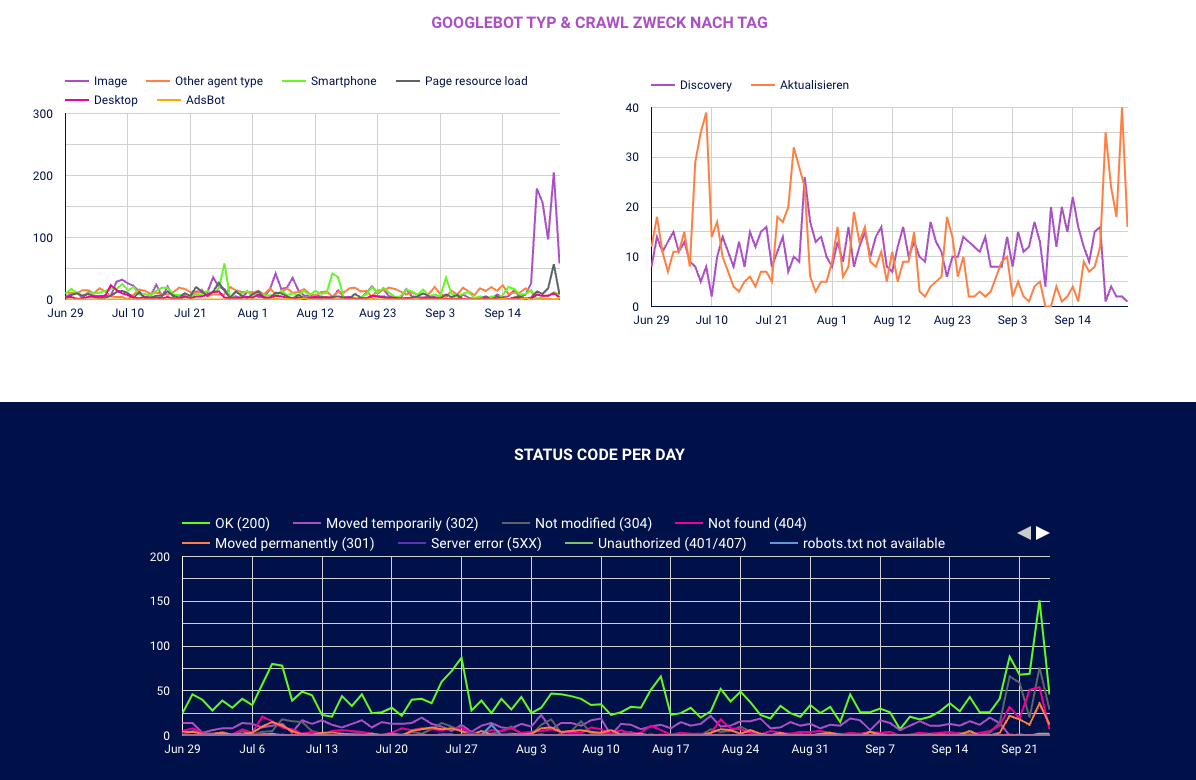

Automatisiertes GSC-Crawl-Stats-Reporting mundgerecht von Juliane Bettinga

Die wenigsten Marketer kommen an echte Logfiles. Noch weniger wissen, wie diese auszuwerten sind. Bei den Wingmen oder Joachim Nickel kannst Du natürlich immer anfragen. Aber Juliane hat Recht: Die Crawl Stats in der Google Search Console bieten Dir eine super Möglichkeit, systematische Probleme im Setup Deiner Domain festzustellen.

Die GSC hat so ihre Einschränkungen. Zum Beispiel lassen sich die Crawl Stats nicht über die API runterladen und erfordern händisches Datengedengel. Außerdem gibt es für Beispiel-URLs das 1.000er Zeilenlimit. Aber Juliane hat keine Mühen gescheut und Dir einen richtig guten Workflow erstellt, wie Du die Daten auch Dank Valentin Pletzers GSC crawl stats downloader einfach runterladen, mit oder ohne Knime verarbeiten und mit dem Looker Studio visualisieren kannst.

Und dann hat Dir Juliane auch noch den perfekten How-to-Artikel geschrieben, mit dem Du selbst in die Umsetzung kommst. Ich hab das Ganze schon einmal durchgetanzt und zack, funktioniert. Ein paar Knime Extensions musste ich noch besorgen und über Pie Charts müssen wir vielleicht nochmal mit Behrend streiten, aber jetzt läuft das wie geschmiert.

Danke, bei dem Vortrag hat wirklich alles gestimmt: Thema, Präsentation, Persönlichkeit auf der Bühne, Template-Geschenke für die eigene Anwendung. Erstklassig.

Probabilistische Attribution von Franz Sauerstein

Franz hat den Vortrag “1 Ansatz + 1 Tabelle = Marketing-Controlling auch ohne Third-Party-Cookies und Attributionssoftware” mitgebracht. Pluspunkte fürs Storytelling, die schönen Wortbilder und natürlich die Fliege!

Attribution, also die Zuordnung, welche Leute über welchen Kanal aufgrund welcher Marketingmaßnahme jetzt wie zu mir gekommen sind, ist vielleicht nicht pure Fiktion, aber extrem schwer (findet auch Rand Fishkin).

Dazu kommt: Ich mag es auch so gar nicht, mich mit Leuten darüber zu streiten, warum die zweite Nachkommastelle in Tool 1 eins eine andere Ziffer anzeigt als in Tool 2, wenn wir die Visits über einen bestimmten Kanal messen wollen.

Nächstes Problem: Die lokalen Optima der einzelnen Verantwortlichkeiten: Nur weil eine Instagram-Anzeige aufhört, Käufe zu triggern, heißt es nicht, dass das Geld nicht gut investiert ist. Häufig fördert sie parallel oder im Nachgang Direct Traffic oder organische Brand Searches.

Franz Sauerstein spricht mir also aus der Seele, wenn er sagt, lasst uns die internen Metriken der Marketingabteilung beiseite schieben. Stattdessen brauchen wir ein Marketing Changelog, also eine fortlaufend gepflegte Liste, die festhält, wann welche Maßnahmen unternommen wurden. Lasst uns hier auch nicht zu viel parallel machen. Und dann schauen wir regelmäßig auf betriebswirtschaftliche Kennzahlen wie den Deckungsbeitrag I und den Deckungsbeitrag II.

So fokussieren wir uns auf die großen Hebel und machen mehr von dem, was wirklich funktioniert.

Ich freu mich auf die Folien samt Vorlage.

|

|

| So long, and thanks for all the FIDs – Kurze Meldung aus der Google Search Console: |

Der Page Experience Übersichts-Report wurde entfernt. Damit ist nicht der eigentliche CoreWebVital-Report gemeint, sondern nur die Übersicht mit dem Abgleich der Impressions, die auf URLs mit guter Page Experience-Wertung gingen.

Für mich ist das kein Verlust, ich kann mich kaum erinnern, wann ich diese Übersicht mal genutzt habe. Die GSC-Reports für HTTPS und CWV, die häufiger Anwendung finden, bleiben erhalten.

Google sagt außerdem, dass Page Experience weiterhin relevant bleibt.

Lass Dich dabei nicht davon irritieren, dass John Mu und andere Googler immer mal wieder betonen, dass der Einfluss der Page Experience als Rankingfaktor nicht überbewertet werden sollte.

Page Experience finden wir nicht wegen des direkten Einflusses als Rankingfaktor wichtig, sondern wegen der zwei folgenden Aspekte:

- Nutzersignale: Nutzer mögen Seiten mit guter Page Experience. Ich bin gerade zu faul, eine konkrete Statistik rauszusuchen, aber hier ist ein Servicelink zur Google Suche mit der Query “pagespeed conversion rate”. Google misst zwar für die Rankings nicht direkt Conversion, aber ich denke, es ist ein legitimer Schluss, dass Nutzer, die besser konvertieren, auch in anderen messbaren Nutzersignalen besser abschneiden.

- Crawl-Budget: Wenn deine Seite schneller lädt, verbraucht Google weniger Ressourcen, um sie zu crawlen; kann also mit dem gleichen Crawl-Budget mehr Deiner URLs crawlen. Wenn Du einen One-Pager hast, ist das wenig relevant, aber wenn Dir in der GSC “Discovered, but not indexed” ein Dorn im Auge ist, dann schon.

Lange Rede, kurzer Sinn:

Der Report aus der GSC ist kein Verlust, aber Themen wie CoreWebVitals und HTTPS (sofern das bei Dir noch ein Thema ist) sind weiterhin relevant.

|

|

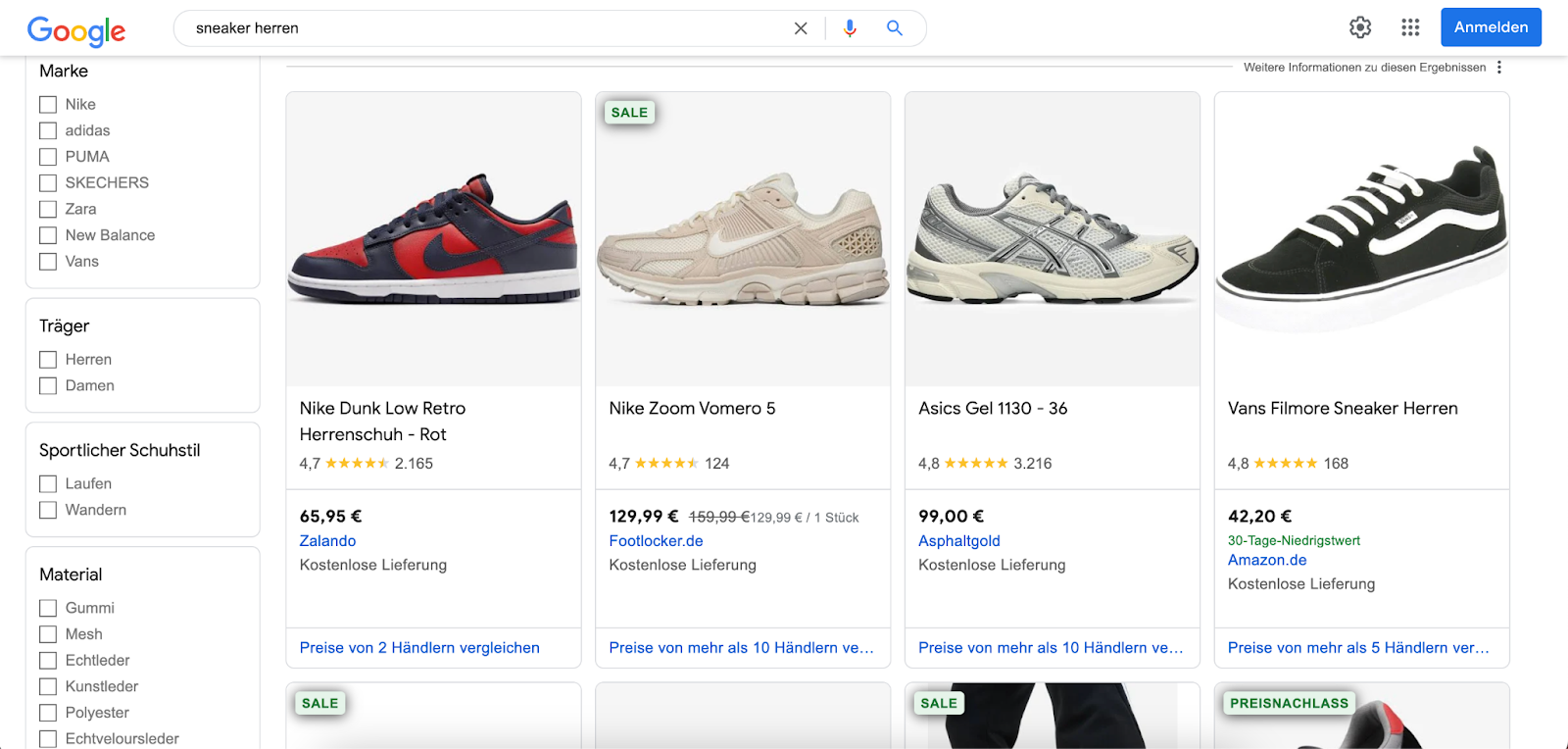

| The rise of the PDP |

War schön gewesen, Salzburg. Trotz einiger Anreiseschwierigkeiten (Thank you for traveling with Deutsche Bahn) hat sich die SEOkomm auf jeden Fall wieder gelohnt. Wie so oft auf Konferenzen gab es auch dieses Jahr Themen, ohne die ein Großteil der Vorträge nicht auskam: KI. Daneben war aber auch die weitere Entwicklung auf den SERPs ein prominentes Thema.

Eine öfter anklingende Facette davon war, dass es einen Wechsel des Fokus in der Optimierung weg von den Kategorieseiten hin zu Produktdetailseiten geben wird. Die neue Wichtigkeit ergibt sich daraus, dass Google insbesondere im Bereich Shopping (aber auch Rezepte – siehe K. Indig) Traffic in Zukunft nicht mehr an Kategorieseiten von Websites weitergeben möchte, sondern die Kategorien in Zukunft im eigenen Ökosystem abbildet.

Ohne die starke Lobby in Europa, wie sie etwa die Verleger für News haben, ist es realistisch, dass diese Form der Suche sich stärker ausweitet. Insbesondere, wenn Seitenfunktionen wie Filter oder Sortierung gleichwertig oder sogar besser sein können.

Die Entwicklung ist aus Sicht von Google gut nachvollziehbar, um (wie hier von Philipp beschrieben) im Bereich der Produktsuchen nicht noch mehr Boden an beispielsweise Amazon zu verlieren. Aus Sicht der Websitebetreiber ist das ganze eher ein mixed Bag, abhängig davon, was die Website anbietet:

- Für Affiliate wird’s dünn, wenn Google das Geschäftsmodel selbst abbildet

- Zwischenhändler / Aggregatoren brauchen klare Vorteile gegenüber Herstellern

- Für Hersteller ist es ggf. nur ein Klick weniger auf der eigenen Seite

Um bei Google Shopping nicht im Nachteil zu sein, sind gute PDPs unabdingbar. Wenn Du Deine PDPs optimal auf die “neue Welt” vorbereiten willst, hängt Dein Aufwand davon ab, was du bisher damit angestellt hast.

- Stimmen die Basics?

- Aussagekräftige Produktbezeichnung / H1

- Meta Daten

- Hilfreiche Produktbeschreibung

- Relevante strukturierte Daten vorhanden?

- UX

Gerade letzteres ist wahrscheinlich einer der Punkte, die für uns als SEOs durch einen Shift zu Google Shopping relevanter wird. Am Ende ist das Ziel von uns allen, mehr Umsatz zu erzielen. Dabei ist der einzelne Klick nur ein Teilziel, dass ohne den Kauf am Ende wenig bringt. Einen potenziellen Kunden, der aus Google Shopping kommt, möglichst effizient zur Conversion zu bringen und das Erlebnis mit der Marke positiv zu prägen, wird PDPs noch wichtiger machen.

Auf der Kehrseite der Medaille: Sind Kategorieseiten dadurch jetzt irrelevant? Jetzt sowieso noch nicht, wie uns Stefan Vorwerk in seinem Vortrag gezeigt hat. Wir warten gerade noch auf die Slides der SEOKomm, daher kann ich leider noch keinen Screenshot zeigen. Aber darin war bisher lediglich ein kleiner Rückgang der Sichtbarkeit von Kategorien der größten Shops zu sehen.

Mittelfristig wird diese Zahl möglicherweise ansteigen. Aber Produkte werden weiterhin gefunden und priorisiert werden müssen, wobei die Kategorieseiten weiter das Mittel der Wahl sind. Deswegen ist mein Appell: Putz Deine PDPs ordentlich raus und nutze das Merchant Center, lass aber die Kategorien nicht komplett brach liegen. Das eine tun, muss nicht das andere sein lassen heißen.

Und wie immer gilt: Angst ist kein guter Berater. Irgendetwas tun, nur weil gerade alle etwas tun, bringt Dich nicht zielgerichtet vorwärts. Schau auf Deine Website, dein Businessmodell und was sich daraus an Maßnahmen für Dich ableitet.

|

|

|

|

|

Fragen? Immer gerne fragen!

|

Wir sind für Dich da.

Schreib uns gern jederzeit

eine E-Mail an [email protected] oder

ruf uns einfach kurz an: +49 40 22868040

Bis bald,

Deine Wingmenschen

|

|

Anckelmannsplatz 1, 20537 Hamburg, Germany

|

|