| Wirklich wahres Wingmen SEO Wissen für wache Webmarketer #162 |

|

| 🍾 Die große Sause ist vorbei |

10 Jahre Wingmen und wir haben immer noch Spaß an unserer Arbeit. Obwohl ich jetzt erst knapp 2 Jahre ein Wingmensch bin, fühlt sich das Ganze irgendwie aber schon viel länger an. Und, oh Gott, es fühlt sich immer noch gut an! :-D

Am Freitag durften wir mit Kunden, Freunden und Familien die 10 wundervollen Jahre Revue passieren lassen, fachsimpeln, feiern, essen und einfach Spaß haben. Dafür haben sich Flo und Johan einiges einfallen lassen. Ein riesen fettes Dankeschön geht hier an Kaddy für die großartige Orga. ❤️

Jedoch hat uns in der Woche auch fachlich einiges beschäftigt und das möchten wir Dir natürlich nicht vorenthalten:

Anita erklärt Dir, warum Google keinen Bock mehr auf Ping Pong hat Johan berichtet über Fachsimpelei mit Fischerländer & Co. über die Suchmaschine Neeva Nora zeigt Dir, was Du aus Hackerangriffen auf Websites lernen kannst Jolle schreibt über das leidige Thema, wie lange Redirects bestehen bleiben sollten Anita berichtet, warum Google damit droht, kanadische Publisher aus dem Index zu kegeln

Viel Spaß beim Lesen

Deine Wingmenschen

|

|

| Google hat keinen Bock mehr |

...auf Sitemap Ping Spam und setzt stattdessen lieber auf ordentlich und gewissenhaft gepflegte lastmod Angaben.

Ähm Moment - Worum geht's?

Das Sitemap Protocol existiert schon ne ganze Weile. Seit 2005, um genau zu sein. Es wurde damals mit dem Ziel, Suchmaschinen bei der Discovery neuer URLs zu unterstützen, eingeführt. Auf der Basis stellte es ebenfalls eine Hilfe beim Scheduling von Crawls entdeckter URLs dar. Der große Erfolg des Sitemap Protocols zeigt sich auch dadurch, dass über lange Jahre hinweg keine Änderungen notwendig waren.

Nun tut sich aber was:

"While the general idea is still useful, some aspects have become less practical in today's internet."

Sayonara, Sitemap Ping

Google wird auch direkt konkret in der Ankündigung vom 26. Juni 2023:

"To that end, we're announcing deprecation of the sitemaps "ping" endpoint and providing additional recommendations for the use of the lastmod element."

"You can still submit your sitemaps through robots.txt and Search Console, but the HTTP requests ("pings") to the deprecated REST endpoint will result in a 404 error."

Also Klartext: Die Möglichkeit, Sitemaps an Google zu pingen, wird es nicht mehr lange geben. Sie wird in den nächsten 6 Monaten abgeschaltet. Also können wir grob davon ausgehen, dass Sitemap Ping ab 2024 Geschichte ist.

Bing hat Sitemap Ping übrigens schon im Mai 2022 ad acta gelegt:

"Despite its promise, recent evaluations have shown that it was often subject to misuse by spammers. As a result, we will be deprecating the ability for anonymous sitemap submissions starting today."

Google begründet die Abschaffung ähnlich:

"Our internal studies – and also other search engines such as Bing – tell us that at this point these unauthenticated sitemap submissions are not very useful.

In fact, in the case of Google Search, the vast majority of the submissions lead to spam."

Also: Aus die Maus. Sitemap Ping ist nicht das erste (und sicherlich auch nicht das letzte) Feature, das aufgrund von Missbrauch abgeschaltet wurde. Schon schade, wenn das Fehlverhalten einiger weniger solche Maßnahmen zur Folge hat, die am Ende uns alle treffen.

Die Reaktionen auf das Ende von Sitemap Ping sind auch eher verhalten:

"i can't tell you how many times the google sitemaps ping URL came to the rescue (client didn't want GSC, client wouldn't give me GSC access and didn't know how to use the sitemap tool, etc.). another googlefail for the books"

– Ian Cappeletti auf Twitter

(Wobei der Wegfall von Sitemap Ping in solchen "spaßigen" Fällen vermutlich eher das geringste Problem ist...)

"Not great the sitemap ping endpoint is going away...

...but the good news is that the Google team confirmed the lastmod has more weight when it comes to crawling and scheduling."

– Adam Gent auf Twitter

(Immer positiv denken!)

Auch Johan kommentiert diese Neuigkeit in unserem Slack mit begrenzter Begeisterung:

"Das ist bitter: Sitemap Ping ist die einzige Variante, teilweise tote Sitemaps zu aktivieren und hat hervorragend funktioniert, auch in den zahlreichen Fällen von widerspenstigen Sitemaps."

Ach ja, wenn Du Sitemap Ping irgendwo als Feature verbaut hat, musst Du Dir keine Gedanken machen und auch nicht zwingend aktiv werden:

"Any existing code or plugins which use this endpoint will not cause problems for Google Search; you don't need to make any changes (but using the endpoint will also not do anything useful)."

Sowohl Google als auch Bing weisen in ihren Meldungen auf die weiterhin bestehenden Möglichkeiten hin, die Sitemaps

Darüber hinaus dropt Bing auch noch einen Hinweis auf IndexNow:

"Additionally, we encourage all webmasters to adopt https://www.indexnow.org to inform Bing and other search engines real time of latest content changes on their websites."

Dazu hatten Jolle in Ausgabe 147 (➡️ Wirksames Crawling- und Indexierungsmanagement) und Johan in Ausgabe 74 (➡️ Ein MiniWow für IndexNow) etwas geschrieben, falls Du da nochmal reinlesen magst.

Lang lebe lastmod

Während die Ära des Sitemap Ping zu Ende geht, bekennt sich Google klar zu lastmod:

"...nowadays lastmod is indeed useful in many cases and we're using it as a signal for scheduling crawls to URLs that we previously discovered."

Die Angaben müssen im richtigen Datenformat vorliegen, ist klar. Und den Tatsachen entsprechen.

"Second, it needs to consistently match reality: if your page changed 7 years ago, but you're telling us in the lastmod element that it changed yesterday, eventually we're not going to believe you anymore when it comes to the last modified date of your pages."

Zudem handelt es sich bei lastmod um eine optionale Angabe. Also wenn Du Dir bei manchen URLs nicht ganz sicher bist, lass es lieber weg. Denn unwahrheitsgemäße Angaben an dieser Stelle kommen bei Google nicht so gut an und können im Ernstfall sogar dazu führen, dass Google dem lastmod domainweit keine Bedeutung mehr schenkt.

"And when we say "last modification", we actually mean "last significant modification".

If your CMS changed an insignificant piece of text in the sidebar or footer, you don't have to update the lastmod value for that page.

However if you changed the primary text, added or changed structured data, or updated some links, do update the lastmod value."

Also:

An der Stelle noch als kleiner Reminder: Die Angaben von changefreq und priority in der Sitemap sind Google nach wie vor komplett Wurst.

"Google still doesn't use the changefreq or priority elements at all."

Wenn Du Dich hier selbst nochmal tiefer reingraben möchtest, gibt es hier die Sitemap-Doku von Google oder dort einen seeehr ausführlichen Wissensartikel von Johan.

|

|

| A SEO will Neeva walk alone |

Auf der Campixx traf ich Stefan Fischerländer (kurz vor meinem Strategie-Vortrag). Stefan meinte, dass er sich sehr über meine Anmerkungen zu Neeva gefreut hat. Und dass er mir eigentlich schreiben wollte (um mir Recht zu geben ;) ). Das haben wir jetzt nachgeholt und ich habe mich sehr über die weiterführenden Gedanken eines Kollegen gefreut, der im Bauen von Suchmaschinen wesentlich mehr Erfahrung hat als ich:

Ich schrieb:

"User sind nicht auf der Suche nach einer Alternative zu Google. Man muss den Menschen beibringen, dass sie eigentlich eine bessere Suche haben könnten. Das ist richtig aufwändig."

Stefan ergänzt:

Das war natürlich auch damals unsere zentrale Fragestellung. Die Opportunitätskosten für User sind nahe null. Er muss keine Daten mitnehmen, braucht keine neue Software. Er muss nur einmal eine Einstellung im Browser ändern. Trotzdem gibt's IMHO eine riesige Hürde: FOMOFNUG = "Fear of missing out for not using Google" –nämlich die Angst, wenn ich woanders suche, dass ich dann das Top-Ergebnis bei Google nicht sehe, das aber alle anderen sehen. Das ist für mich das zentrale Hindernis für alle Nicht-Google-Web-Recherche-Anbieter. Das könnte sich nun vielleicht mit den LLM-getriebenen Suchen ändern, denn da steht ja nicht mehr das einzelne Webergebnis im Vordergrund.

Aus der Meldung von Neeva:

"convincing users to pay for a better experience was actually a less difficult problem compared to getting them to try a new search engine in the first place"

Stefan ergänzt:

Wir hatten damals auch ein Bezahlmodell für Neomo diskutiert. Und ich war mir damals sicher, früher oder später wird jemand kommen, der das macht. Es war klar, dass das nichts für die breite Masse wäre. Aber ein völlig werbefreies Suchumfeld, bei dem du als Profinutzer viel mehr Parameter selbst steuern könntest, sollte doch ein Bezahlmodell ermöglichen. Bei Neeva habe ich aber keine solcher Profifeatures gesehen. (Was natürlich mit dem folgenden Punkt zu tun haben dürfte ...)

Ich schrieb:

"Neeva hat keinen eigenen Index gehabt, sondern die Ergebnisse von Bing lizenziert. Im Februar kam raus, dass die Lizenzierung der Ergebnisse von Bing massiv teurer wird."

Stefan ergänzt:

Ich finde das interessant, weil in den letzten 10 bis 15 Jahren die Lizenzierung der Suchergebnisse in meiner Wahrnehmung recht günstig war. Wir hatten bei Neomo diskutiert, ob wir nicht als Indexlieferant Geld verdienen könnten. Das aber verworfen, weil schon absehbar war, dass Indexdaten zu günstig werden würden. Klingt jetzt aber so, als würde sich das drehen.

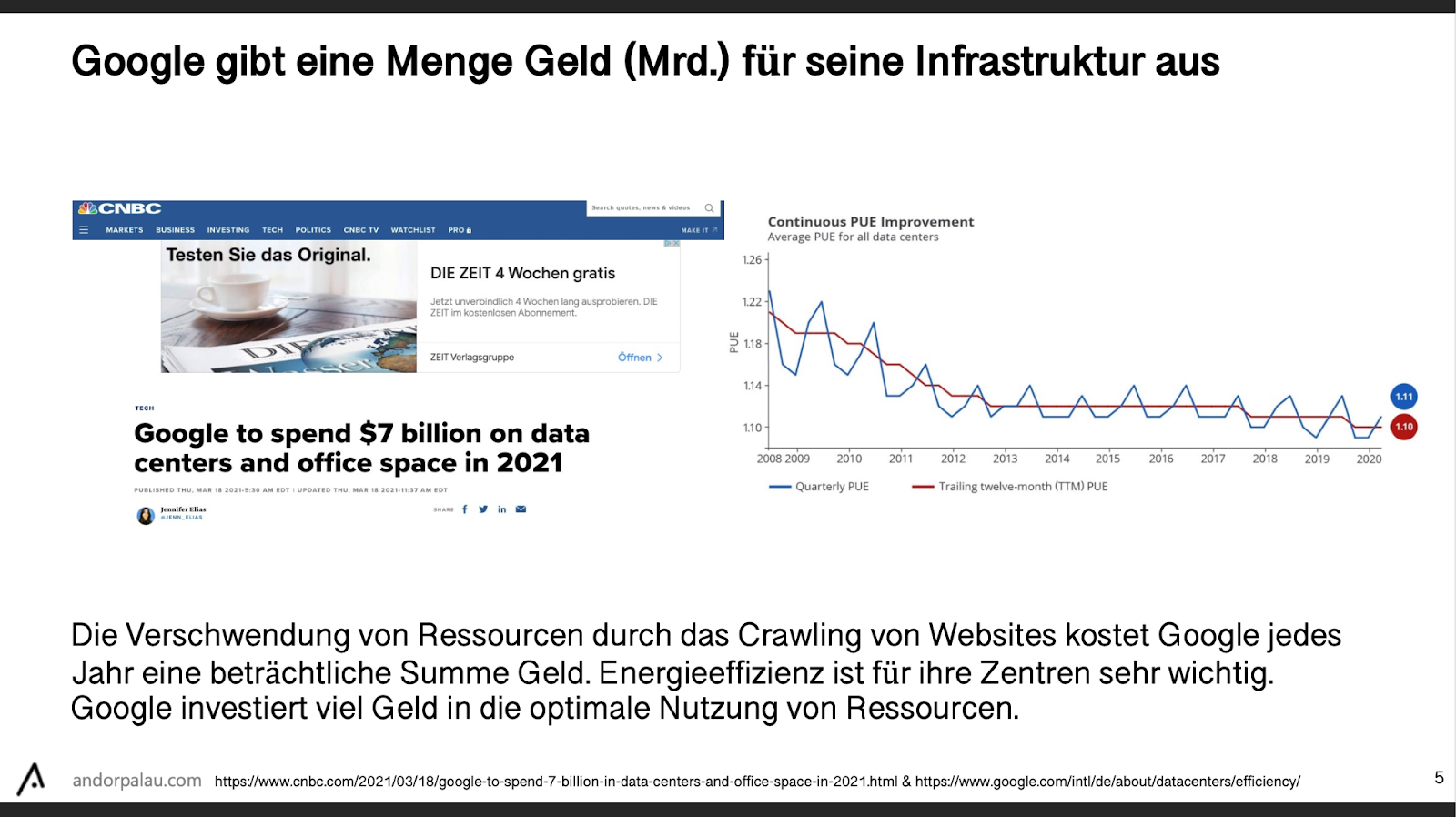

Ich ergänze dazu noch mal einen Slide von Andor Palau aus seiner Präsentation zu Logfile-Analyse und warum es wichtig ist Crawling-Effizienz herzustellen, der Index ist gar nicht so teuer, aber das Crawling, um ihn aktuell zu halten:

Ich schrieb:

"(...) dass Du den Kern Deines Produktes selbst in der Hand haben und nicht von Dritten einkaufen solltest"

Stefan ergänzt:

Neben der Abhängigkeit von Dritten kommt noch ein weiterer Aspekt dazu: Ohne eigenen Index sind viele Dinge nicht möglich! Du hast keinen Zugriff auf die Rohtexte. Du hast keinen Zugriff auf den Linkgraph. Du hast keine Kontrolle über die Filterlisten. Und vor allem: Du kannst nichts ausprobieren. Kein Wunder, dass man so keinen ordentlichen USP aufbauen kann.

Ich finde das wertvolle und spannende Ergänzungen. Du auch?

|

|

| Was kannst Du aus Hackerangriffen lernen? 💣 |

Ich habe kürzlich auf LinkedIn über den Sichtbarkeitsverlust von ATU berichtet, die Mitte Mai von einer Cyberattacke betroffen waren (Danke für die Info, Stefan).

ATU hat sich zwar nicht geäußert, aber der SEO der Neuen Pressegesellschaft, welche ebenfalls von dem Hackerangriff betroffen war. Dominik Kühner meldete sich mit folgenden Worten:

"Wir waren auch betroffen, wie der verlinkte ZDF-Artikel von Stefan Vorwerk erläutert. Allerdings ging unsere Strategie im Gegensatz voll auf 😉"

Moment? Wie haben die das denn geschafft? Um genau diese Frage zu beantworten, habe ich Dominik für Dich um ein kleines Interview gebeten:

Euch hat die gleiche Cyberattacke getroffen wie ATU. Was waren als SEO-Team Eure ersten Gedanken, als Ihr von dem Hackerangriff erfahren habt?

Dominik: "Als uns klar wurde, dass unser Hoster auf unbestimmte Zeit nicht erreichbar sein wird, sind wir sehr schnell in den Krisenmodus gewechselt. In einer großen Runde mit allen Fachabteilungen und der Geschäftsleitung haben wir klar kommuniziert, was für SEO wichtig wird und dass jetzt ein Wettlauf gegen die Zeit beginnt, um nicht aus dem Index zu fliegen und den Schaden zu begrenzen."

Wie habt Ihr herausgefunden, dass Ihr von einem Hackerangriff betroffen seid?

Dominik: "Zunächst einmal gar nicht, da wir von einer einfachen technischen Störung bei unserem Hoster ausgegangen sind. Diese hatten wir bereits in der Vergangenheit und bisher konnten sie auch in kurzer Zeit behoben werden. Das Problem war, dass der Dienst um 3 Uhr nachts an einem Feiertag und vor einem Brückentag, ausfiel. Dazu kam dann noch, dass kaum Kommunikation seitens des Dienstleisters stattfand und wir letztlich selbst darauf kommen mussten, was die Ursache für den Ausfall war. Unsere IT-Abteilung war sich sehr schnell sicher, dass es sich um einen Angriff und damit eine Downtime von unbestimmter Zeit handeln muss."

Im Gegensatz zu ATU ist Eure Sichtbarkeit nicht in den Keller gerauscht – Welche Strategie hattet Ihr?

Dominik:

"Die größte Herausforderung für alle Beteiligten war der Empfehlung des SEO-Teams zu folgen und „nichts zu tun" – wie so oft 😉

Nichts tun meint in unserem Fall, für alle Seiten einen 503 Statuscode auszuspielen, möglichst schnell die robots.txt wieder live zu bekommen und keine alternative Startseite oder einen 302-Redirect unserer Startseite auf eine externe Plattform einzurichten.

Hilfreich war auch, dass wir sehr schnell gute Prognosen erstellen konnten, wie lange es dauern würde, bis wir wieder erreichbar sind. Beim Datum des „Retry-After"-Headers haben wir uns nur um eine Stunde verschätzt. Unsere generelle Strategie war, möglichst viel Zeit zu gewinnen und jede verfügbare Ressource in einen sofortigen Hoster-Wechsel unserer drei Nachrichtenportale zu stecken.

Es war schnell absehbar, dass wir in wenigen Tagen wieder live sein könnten. Wir haben gemeinsam mit allen Geschäftsbereichen die Risiken abgewogen, einen Plan entwickelt und diesen ohne Kompromisse und Zeitverluste umgesetzt. Das hat beispielsweise zu einer filmreifen Übergabe einer Festplatte auf einem Parkplatz zwischen Ulm und Frankfurt geführt, weil wir errechnet hatten, dass das Kopieren und die Fahrzeit schneller sein würden, als der parallel laufende Datentransfer über unsere Leitung.

Und es hat funktioniert: Nach 58 Stunden waren wir wieder erreichbar und ein bis zwei Tage später hatten wir das neue Setup so stabilisiert, dass beispielsweise unsere Indexierungsgeschwindigkeit von neuen Artikeln, die Crawling-Frequenz der Sitemaps oder die Zeit bis Artikel-Updates in die SERPs durchschlagen, sich wieder auf dem Stand von vor der Attacke einpendelten."

Habt Ihr einen Notfall-Plan für zukünftige Cyberattacken? Wie sieht der aus?

Dominik: "Wir entwickeln gerade das Setup für eine kontrollierte Downtime, um bei Bedarf sehr schnell darauf umstellen zu können. Also eine parallele Instanz mit robots.txt und der richtigen Konfiguration für die entsprechenden http-Header. Außerdem arbeiten wir an einer statischen Version der wichtigsten Seiten, die wir bei Bedarf zur Verfügung stellen können.

Der Empfehlung von John Müller konnten wir leider in der Kürze der Zeit nicht folgen beziehungsweise haben die Ressourcen für eine schnellere Migration verwendet. Meiner Einschätzung nach ist genauso wichtig, vorab zu prüfen, ob das Unternehmen im Ernstfall schnell entscheidungsfähig ist. Ich bin mir sicher, dass wir nur fast unbeschadet davongekommen sind, weil wir unmittelbar Interessen und Risiken abwägen konnten und zu jedem Zeitpunkt klar war, wer Entscheidungen für die Umsetzung trifft. Dadurch haben wir kaum Zeit verloren. Die Strategie der rp-online.de war sehr ähnlich und auf den ersten Blick sieht es so aus, als hätten sie trotz ihrer langen Downtime auch sehr wenig Sichtbarkeit verloren."

Was rätst Du anderen: Wie können sie sich vor Cyberattacken schützen? Und wie sollten sie reagieren, wenn sie von einem Hackerangriff betroffen sind?

Dominik: "Der vielleicht größte Schutz ist, sich bewusst zu werden, dass die Frage nicht lautet, ob man Opfer einer Cyberattacke wird, sondern wann und in welchem Umfang. Auf der letzten Weihnachtsfeier hat uns unser Geschäftsführer genau diesen Satz gesagt – und leider Recht behalten.

Ausgehend von dieser Haltung kann man Risiken einschätzen und bewerten und damit einhergehend auch, wie viel Aufwand man in die Entwicklung eines Notfall-Systems stecken möchte. Parallel arbeiten wir daran, das Risiko zu minimieren und investieren viel in das Training und die Sensibilisierung aller Kolleginnen und Kollegen. Aus meiner Sicht ist das für digitale Unternehmen genauso wichtig, wie früher die Brandschutzübung im Büro."

Ich finde Dominiks Input auf jeden Fall mega spannend und denke, wir sollten alle einen Notfallplan für den Fall der Fälle parat haben. Ein paar hilfreiche Tipps findest Du in unserem Wissensartikel "Website-Monitoring für SEO". Hast Du eigentlich einen Notfallplan? 👀

|

|

| Rewinding the Redirect: Messfehler im Raum-Zeit-Kontinuum |

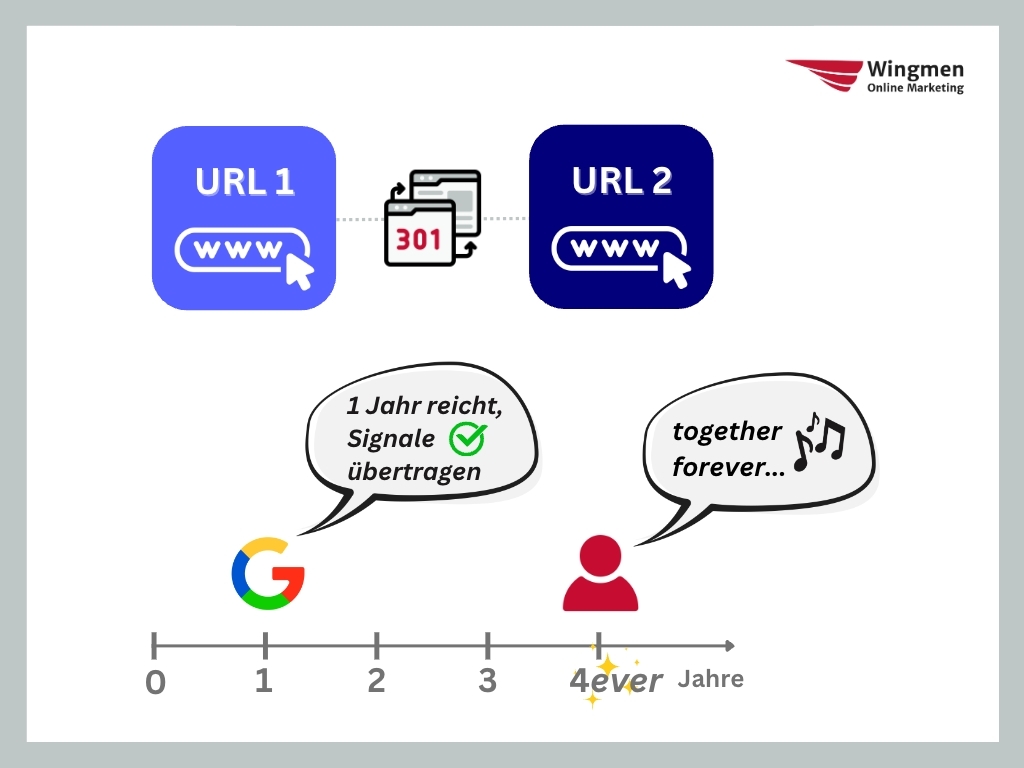

Letztes Jahr hat Google-Sprecher Gary Illyes auf Twitter etwas über die Verarbeitung von 301-Redirects klargestellt, dessen tiefere Bedeutung in der SEO-Bubble nur verhalten diskutiert wurde. Inzwischen hat Patrick Stox das Thema in seinem Artikel "Is It OK to Remove 301 Redirects After a Year? We Tested It" nochmal aufgegriffen und über die Konsequenzen müssen wir nochmal reden.

301-Redirects sollten mindestens ein Jahr Bestand haben

Die ursprüngliche Aussage, dass wir 301-Redirects mindestens ein Jahr lang aktiv halten sollten, um sicher zu gehen, dass Google sämtliche Signale verarbeitet und von der url-1.html auf url-2.html übertragen hat, dürften die meisten unter "Ja, OK, alles klar, mach ich, Dankeee" abgeheftet haben. Gary gibt dazu den nützlichen Hinweis, dass es für User natürlich komfortabel ist, wenn die Links noch länger als ein Jahr funktionieren.

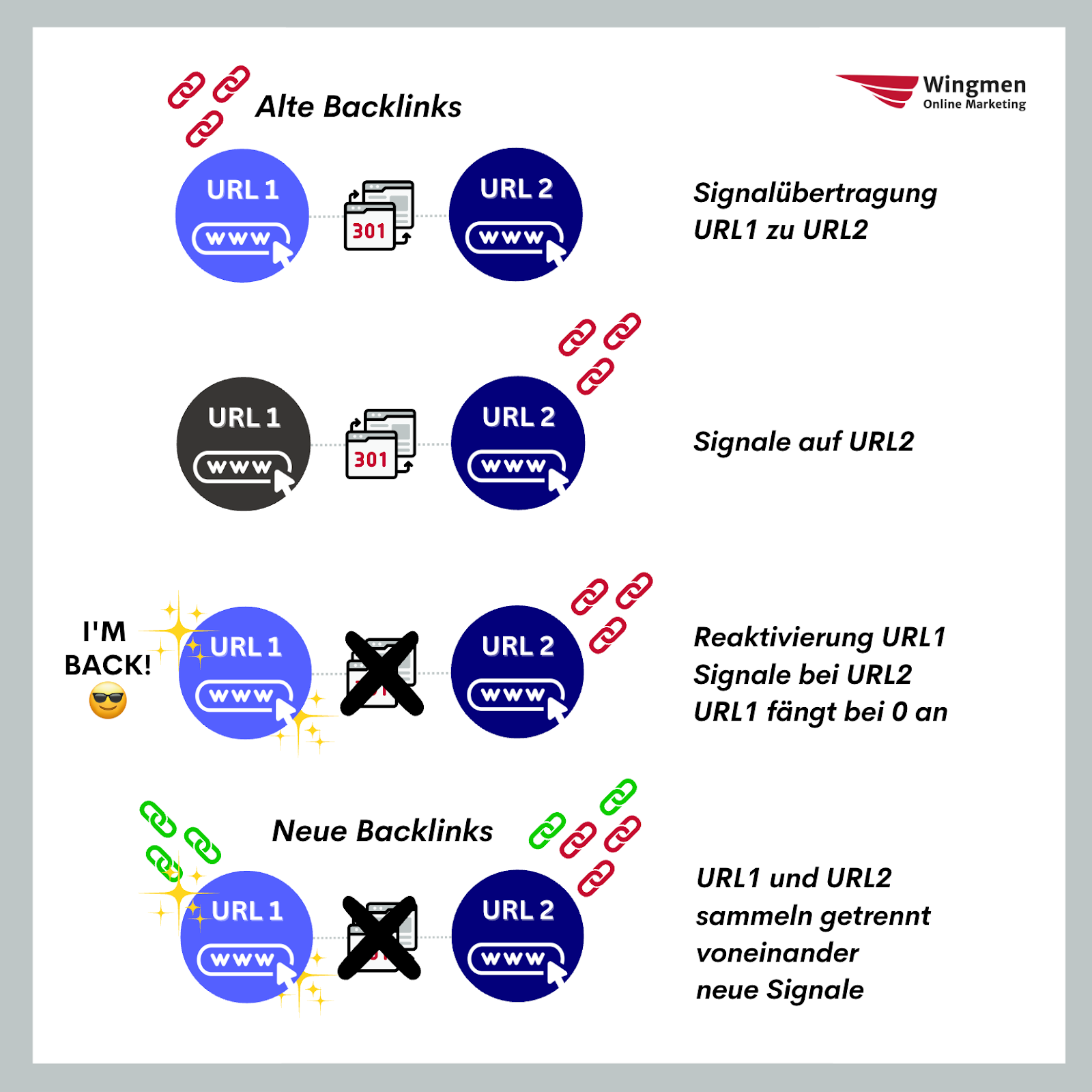

Auf welche URL zahlen Backlinks ein, wenn der Redirect nach 12+ Monaten entfernt wird?

Doch angenommen eine alte Domain oder auch nur ein alter Artikel (url-1.html) wird wieder reaktiviert. Es zeigen weiterhin alte Backlinks dorthin. Weil aber neue Menschen auf den Inhalt gestoßen sind oder der Inhalt verändert wurde und ein neues Publikum anzieht, gibt es nun neue Backlinks auf url-1.html. Wie verarbeitet Google die Signale?

Die intuitive Annahme in der SEO-Branche war: Google wird ein bisschen brauchen, um die Veränderungen wahrzunehmen (Discovery, Crawling) und nochmal länger, um sie zu verarbeiten (Indexing, Verzeihung, "Indexation" laut John Mu bei 1:20). Vielleicht dauert auch dieser Prozess grob bis zu einem Jahr, aber dann sollten doch alle Links auf url-1.html für url-1.html zählen, egal, wann sie gesetzt wurden.

Doch genau so ist es nicht.

Google splittet die Zeit in vor und nach dem 12+ Monate aktiven Redirect

Die alten Backlinks zählen, wenn die 301-Redirect-Verarbeitung nach einem Jahr von Google abgeschlossen ist, auf url-2.html ein. Das gilt auch dann, wenn url-1.html wieder aktiv ist. Die alten Backlinks bekommt die alte Seite nicht zurück. Sie startet bei Null und muss sich ein neues Backlinkprofil aufbauen.

Darth Autocrat hat explizit nachgefragt und die Bestätigung von Gary bekommen.

Widersprüche in einzelnen Experimenten

Und auch das von Patrick oben verlinkte Experiment bestätigt dieses Vorgehen von Google. Als er für eine Reihe von mit Backlinks bestückten Artikeln die Redirects aufgehoben hat, sprang Ahrefs zwar beim Zählen der Backlinks auf diese Veränderung an, an den Rankings der nun ohne Weiterleitung da stehenden Zielseiten (also die "url-2.html"s nach unserem Muster) hat dies keinen Abbruch getan.

Sean Markey hat einen weiteren Datenpunkt für uns dazu, den er in seinem Newsletter beschreibt:

"I acquired an EMD (exact match domain) with a killer links profile, and put a site on it + one 4,000 word AI-generated not-at-all human-edited piece of content and nothing else.

(I couldn't even get an eye-busting rocket ship graph because the site started ranking in the top 10 when I took over this domain and installed WP AND NOTHING ELSE). It's been at the #2 spot for over a month now."

Er deutet es so: Wenn die alten Backlinks tatsächlich für immer auf die Zielseiten der 301-Weiterleitungen einzahlen würden, hätte er nicht in so kurzer Zeit so gute Ergebnisse mit der reaktivierten Domain haben können.

Der Logik stimme ich zu. Wenn Google die alten Backlinks wirklich langfristig den "url-2.html"s zuordnet, dürfte keine weitere Neubewertung notwendig sein, nicht mal ein kurzfristiges Aufflackern der wiedererweckten Domain.

Es lohnt sich wirklich, das nochmal selbst durchtesten. Aber es ist nicht leicht, ein relevantes URL-Set inklusive Backlinks und jahrelangen Redirects auf den Weg zu bringen. Solltest Du eins haben, starte unbedingt und halte uns auf dem Laufenden!

Was bedeutet das für SEO?

Wie gehen wir damit um, wenn Garys Darstellung korrekt ist? Wer Domains handelt wie olle Import-/Export-Sepp, darf überlegen, ob er für ein gutes Backlinkprofil bezahlt, wenn die Domain schon mehr als ein Jahr weitergeleitet wird. Auch wenn wir für Kundenprojekte nach tauglichen Expired Domains Ausschau halten, müssen wir nicht nur darauf achten, dass die nicht mal für Casino- und Pornoinhalte im Einsatz waren. Ein "super Backlinkprofil" sollte uns in der Kosten-Nutzen-Abwägung nun weniger wert sein.

Wie man bei Patrick, der aus dem Hause Ahrefs kommt, schon beobachten kann, sollte auch ein Ruck durch die SEO-Tool-Industrie gehen. Wird vermutlich nicht passieren, denn schon jetzt gehen diese mit Metriken wie Domain Authority, Authority Score und Domain Rating zu Werke, während wir SEOs dann permanent erklären müssen, dass diese Werte nicht deckungsgleich mit dem sind, was Google misst und verwendet (siehe dazu Johannes Beus oder höre Jens Fauldrath im Gespräch mit Lisa Stober).

Solange wir aber selbst nicht permanent das Web crawlen, gibt es für uns keinen Weg, um skalierbar den Überblick zu behalten, wann welche Redirects scharfgeschaltet waren. Hier könnten die oben genannten Tools nachziehen und diese Historie tracken, um sie dann gegen Geld auswertbar zu machen.

Für uns intern ist besonders die Analyse der internen Verlinkung und PageRank-Berechnung betroffen, wenn wir nun die zeitliche Dimension berücksichtigen müssen, allerdings ist intern leichter Wind zu bekommen von der Weiterleitungshistorie.

Man könnte sagen, die Blackbox ist schwärzer geworden, aber das ist Quatsch. Denn wir wissen jetzt besser Bescheid, was passiert, als wir zuvor meinten zu wissen. Es zeigt sich nur wieder: Beim Einsatz von externen Tools, die vermeintlich nachempfinden, was Google macht, liegen wir notwendigerweise häufig daneben. Das macht die Tools und Heuristiken nicht wertlos. Daumenregeln, die uns in 80 Prozent der Fälle (oder 60 oder 90) ein gutes Ebenbild der Realität geben, geben uns weiterhin gute Handlungsempfehlungen.

|

|

| Google kickt Kanada |

...oder zumindest kanadische News Publisher aus dem Index.

Äh, bitte, was ist los?!

Das ist los: In Kanada ist ein neues Gesetz namens Bill C-18 (oder auch "Online News Act") beschlossen worden. Dieses sieht vor, dass Unternehmen künftig dafür bezahlen müssen, um auf die Websites von News Publishern zu verlinken. Auch Google ist davon betroffen. Und das gleich dreifach: Durch die organische Suche sowie Google News und Google Discover. Wenig überraschend hat Google auf solche Faxen nicht wirklich Bock und sagt klipp und klar, dass es als Konsequenz alle kanadischen News Websites rauswerfen wird, sobald das Gesetz so in Kraft tritt.

"I'm not quite sure this was the intended outcome of this law."

mutmaßt Lily Ray bei LinkdIn und ich kann ihr da nur zustimmen.

Der Kanadier Hugh Burnham versucht in den Kommentaren unter Lilys Post, diesen für uns eher fragwürdig wirkenden Schritt zu erläutern:

"Rather than building robust ad servers on their own publishing sites that generate revenue, they are trying to force sites that link to Canadian news agencies to make the money for them."

Monetarisierung im News Bereich ist ja auch bei uns so ein Thema. Ads und Abos sind die Mittel der Wahl, haben aber durchaus ihre Schwierigkeiten. Aber ob eine "link tax", wie Kanada das nun plant, da die beste Alternative ist... fragwürdig.

Dabei sollten wir nicht unterschätzen, wie wichtig es gesellschaftspolitisch ist, dass Menschen (auch) über Suchmaschinen einen Zugang zu vertrauenswürdigen Nachrichten erhalten.

"The removal of links to Canadian news sites will undoubtedly impact the reach and visibility of these publications.

It might also interfere with people's ability to access reliable and diverse sources of news."

– Kommentar von SurgeZ bei LinkedIn

Aus der Stellungnahme von Google zu Bill C-18 ist der Frust deutlich herauszulesen:

"The unprecedented decision to put a price on links (a so-called "link tax") creates uncertainty for our products and exposes us to uncapped financial liability simply for facilitating Canadians' access to news from Canadian publishers.

We have been saying for over a year that this is the wrong approach to supporting journalism in Canada and may result in significant changes to our products.

We have now informed the Government that when the law takes effect, we unfortunately will have to remove links to Canadian news from our Search, News and Discover products in Canada (...).

We're disappointed it has come to this."

Die Enttäuschung ist wohl auch deshalb so groß, weil Google von Anfang an seit der Vorstellung von Bill C-18 Erfahrungen, Feedback und Lösungsvorschläge mit eingebracht hat (Details dazu sind in der Stellungnahme verlinkt) und sich als Unterstützer des kanadischen Journalismus präsentiert:

"Last year alone, we linked to Canadian news publications more than 3.6 billion times – at no charge – helping publishers make money through ads and new subscriptions."

Und jetzt?

Trotzdem ist Google entschlossen, weiter am Ball zu bleiben und hofft, dass die Regierung nochmal einlenkt, um einen besseren Weg zu finden.

Denn:

"Otherwise, we remain concerned that Bill C-18 will make it harder for Canadians to find news online, make it harder for journalists to reach their audiences, and reduce valuable free web traffic to Canadian publishers."

Auf dem Google News in Kanada Blog stellt Google übrigens auch eine umfassende FAQ bereit. Dort werden unter anderem folgende Fragen geklärt:

Wie genau wirkt sich das neue Gesetz auf die Suche und andere Produkte aus? Wann treten die Änderungen in Kraft? Wie können die Menschen in Kanada auch weiterhin zeitnahen Zugang zu lokalen News und Inhalten kanadischer Publisher erhalten? Wie wird ermittelt, welche Websites betroffen sind?

Es ist nicht unwahrscheinlich, dass andere Suchmaschinen und Plattformen gleichziehen und dann halt lieber gar nicht mehr auf kanadische News Publisher verlinken. Zumindest Meta hat sich diesbezüglich wohl schon entsprechend geäußert.

Ähnlich wie beim Leistungsschutzrecht spielt Google hier mit harten Bandagen. Große Publisher können davon vielleicht sogar profitieren: Eine News-Marke, die den kanadischen Nutzern auch ohne Google schon bekannt ist, ist für diese die nächste Anlaufstelle, nachdem sie bei Google keine News mehr finden.

Kleinere Publisher können das schlechter kompensieren. Netto ist das für die großen Publisher natürlich immer noch weniger Traffic, aber sie könnten diesen Streit (den sie nicht mal selbst vom Zaun gebrochen haben) mit Google wahrscheinlich länger durchhalten als kleine Konkurrenten.

|

|

|

|

|

Fragen? Immer gerne fragen!

|

Wir sind für Dich da.

Schreib uns gern jederzeit

eine E-Mail an [email protected] oder

ruf uns einfach kurz an: +49 40 22868040

Bis bald,

Deine Wingmen

|

|

Anckelmannsplatz 1, 20537 Hamburg, Germany

|

|