| Wirklich wahres Wingmen SEO Wissen für wache Webmarketer #212 |

|

| ⏳Der Warte-Cursor ist rund und der Crawl dauert mehr als 90 Minuten |

War Sepp Herberger ein Vordenker der heutigen SEOs? Vermutlich nicht, denn das ihm zugeschriebene Zitat mit dem runden Ball bezog sich doch recht sicher auf Fußball. Solltest Du nur für den Schwank zum Google Update hier sein, bitte direkt zu Matts Artikel springen.

Aber was soll das jetzt mit dem Warte-Cursor und der Crawl-Zeit? Wenn Du schonmal versucht hast, große Domains zu crawlen, kennst Du sicher folgendes Problem: Gefühlt hast Du Stunden im Maschinenraum des Screaming Frog verbracht, um den Crawl zu optimieren, alles optimal auszusteuern und jede unnötige URL zu vermeiden.

Trotzdem läuft der Crawl jetzt den dritten Tag und als Du ihn das letzte Mal angeklickt hast, hat dich der Warte-Cursor (auf einem Mac auch der Volleyball des Todes) empfangen. Das Programm reagiert nicht (Kein Rückmeldung). Ein Hoch auf den Datenbank-Modus, dass wir den Crawl einfach wieder öffnen und neu starten können.

Dieses Gefühl der Erleichterung wünschen wir Dir auch beim Lesen des dieswöchigen Newsletters. Wir haben am Start:

Matt, der Dich über das Juni Spam Update von Google informiert. Jolle, die für dich Hanns Kronenbergs großartigen Vortrag auf der Campixx recapt. Philipp, der dir Backlinks ohne zweifelhafte Methoden garantiert. Sandra, die erklärt, was es mit der Robustheit in der Barrierefreiheit auf sich hat. Johan, der Dir das Soft-404-System von Google vorstellt.

Viel Spaß beim Lesen!

|

|

| Stop! Update Time! |

Es ist mal wieder so weit: Update Time! Seit dem 20. Juni rollt Google das June 2024 Spam Update aus.

Da stehen uns SEOs sicher wieder ein paar unruhige Nächte bevor. Mit Freudentränen auf der einen und Tränen des Leids auf der anderen Seite.

Wir sind zumindest schon sehr gespannt, was sich in den kommenden Tagen auf den SERPs tun wird, wer bei diesem Update profitiert und fleißig an Rankings und Traffic zulegen kann. Und wer nicht.

Das Update soll rund eine Woche dauern.

Besonders interessant ist dabei natürlich auch immer der Blick auf Websites, die zuletzt verstärkt auf KI-Inhalte setzen.

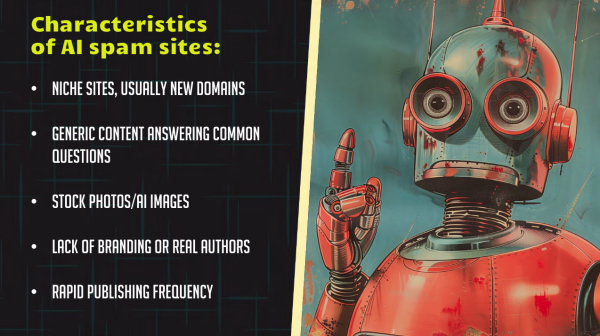

Passend zu der Frage, was denn eine klassische KI-Spam Seite ausmacht, hat Lily Ray auf der CAMPIXX ja auch ein paar Worte verloren (Nils hat zu dem Vortrag in der letzten Ausgabe ein Review geschrieben). Und eine schicke Folie geteilt, die ich Dir natürlich nicht vorenthalten will:

Dann schauen wir mal, was mit den Websites passiert, die all diese Kriterien erfüllen!

Das letzte Spam Update gab es im März diesen Jahres, wurde zusammen mit dem Google Core Update ausgerollt und hat da schon fleißig "Angst und Schrecken" verbreitet. Mal sehen, wie sich das Ganze diesmal entwickelt.

Passend dazu hat Google gerade auch mit einem Problem bei der Indexierung zu kämpfen (das zum Veröffentlichen des Newsletters idealerweise schon gelöst sein sollte).

Was ist mit Dir: Schlottern Dir schon die Knie oder siehst Du dem Update eher zuversichtlich entgegen?

|

|

| Hanns Kronenberg auf der Campixx: Mit einer Prise Nutzersignalen zum perfekten Suchmenü |

Hanns Kronenberg, bei Chefkoch für SEO verantwortlich, hat für mich den besten Vortrag auf der Campixx 2024 abgeliefert. Relevanz, Informationsdichte, eigene/proprietäre Daten, Präsentation/Unterhaltung. Einfach volle Punktzahl auf jeder Skala.

Als SEOs haben wir ein riesiges Interesse daran, herauszufinden, wie Suchmaschinen funktionieren, um Empfehlungen ableiten zu können, die uns und unsere Kunden voranbringen. Durch Leaks und Gerichtsverfahren ist eine gehörige Portion mehr Transparenz in den Prozess gekommen.

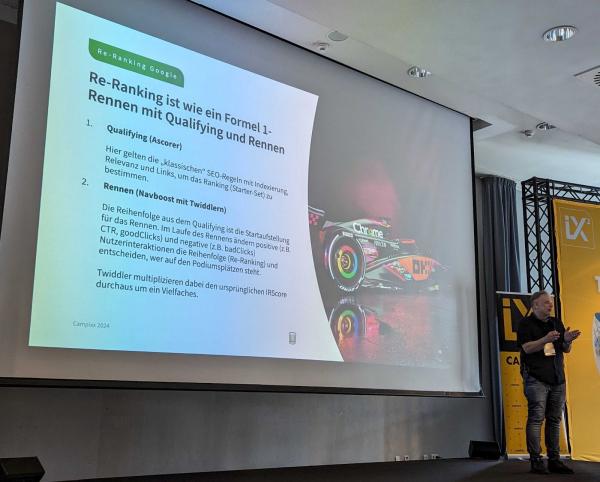

Johan hat in verschiedenen Formaten Licht in diesen Prozess gebracht (Slides vom SEO Meetup Hamburg, Tägliche Dosis SEO, Wingmen Newsletter). Hanns greift sich nun einen Aspekt heraus und legt den Fokus komplett aufs Re-Ranking. Und das nicht mit Mutmaßungen, sondern mit eigenen Daten. Lecker!

Erfahrungen aus dem Umbau der internen Suche von Chefkoch

Hanns und sein Team hatten das Ziel, die interne Suche zu verbessern. Chefkoch arbeitet nicht mit Kategorieseiten, sondern mit internen Suchergebnisseiten als PLPs. Dafür wollten sie möglichst nicht mit kruden Techniken wie Exact Match vorgehen, sondern ähnliche Magie nutzen, wie Google das tut – und Nutzerdaten verwenden.

🏎️ Das SEO-Qualifying: SEO-Basics für den Ascorer

Wer sich Gedanken darüber macht, welche Kriterien helfen, um für die Suche nach [erdbeerkuchen] das beste Ergebnis zu liefern, landet schnell bei den SEO-Basics:

Technische Basis muss stehen Title und H-Tags müssen von Erdbeerkuchen und dessen Synonymen handeln Auf den Bildern ist ein Erdbeerkuchen zu sehen Verlinkung samt Ankertexten stärkt die relevanten Dokumente etc.

Aber wie finden wir jetzt das beste Erdbeerkuchenrezept? Allein die Site-Search von Google liefert knapp 30.000 Chefkoch-Ergebnisse.

🏁 Das SEO-Rennen: Nutzersignale für Navboost und Twiddler

Jetzt kommen User Signals ins Spiel. Das sind laut Hanns nicht die vergebenen Sterne (Bewertungen) und Herzen (Favoriten/Lesezeichen). Die Magic kommt über das Einbeziehen von:

CTR aus Impressions und Clicks Conversion Rate zu Aktionen, die darauf hinweisen, dass tatsächlich gekocht wurde (z. B. ausgedruckt) Verweildauer Traffic

Übertragen auf Google sieht Hanns folgende Faktoren, die sich positiv aufs Re-Ranking auswirken, weil sie "gute Clicks" bewirken:

Um in der Formel-1-Analogie zu bleiben: Zunächst kämpft jede URL für sich allein und kann ohne Interaktion mit anderen Wettbewerbern gegen die Uhr fahren bzw. ein Relevanz-Scoring bekommen.

Steht die URL mit den Termen, die hier laut Suchanfrage relevant sind, in den entsprechenden Posting Lists von Google (= hat Google das Dokument zu diesen Tokens indexiert) und wird zu den Termen auch entsprechend hoch gewichtet?

Schon hier wird ein erstes Ranking der Dokumente im "Starterset" berechnet. Googles Ascorer liefert nicht nur 100, sondern eher 1000 Ergebnisse zurück. Die Reihenfolge bemisst sich an der gewichteten Relevanz. Wie häufig kommen die nachgefragten Terme vor, in der Nähe welcher anderen Terme stehen sie, etc.

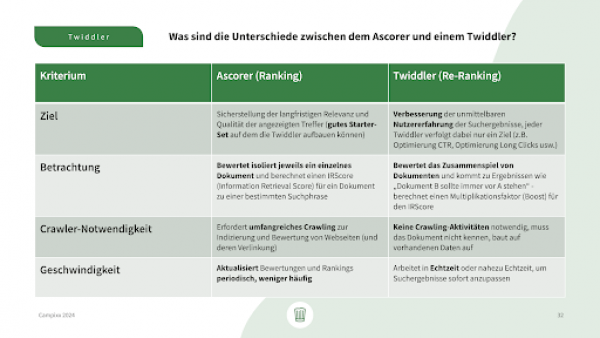

Twiddler: Die Multiplikatoren für verschiedenste Boosting-Ziele

Mit diesem Ranking kennen wir die Startpositionen der URLs für das eigentliche Rennen. Und im echten Race fahren die qualifizierten Kandidaten gegeneinander. Jetzt kommen bei Google Twiddler ins Spiel.

Twiddler haben verschiedene Ziele, zum Beispiel:

Diversität der Suchergebnisse: Nicht 20 Shops nacheinander, sondern auch mal einen Ratgeber beimischen URLs mit guter CTR nach vorn URLs mit "goodClicks", "longClicks" nach vorn Passendes Land, passende Sprache nach vorn Passendes Format für passendes Gerät nach vorn

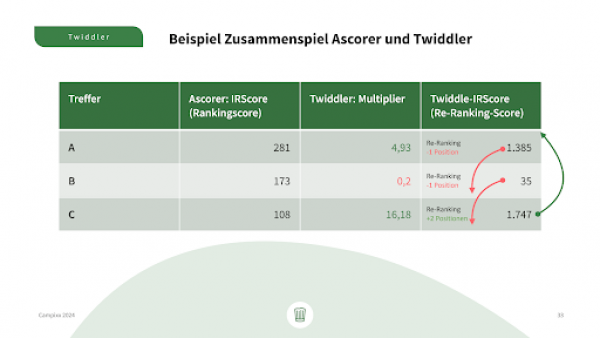

Twiddler sollen das Ausgangsranking zwar nicht komplett über den Haufen werfen, haben aber einen viel größeren Einfluss als Maßnahmen, die ich für die Indexierung mache. Die verschiedenen Twiddler sollen in Summe über alle Ergebnisse hinweg maximal einen Multiplikationsfaktor von im Schnitt 5-10 beisteuern.

Hanns hat bei der internen Suche massive Umsortierungen gesehen. Einzelne Rezepte konnten durch das Re-Ranking Sprünge von plus 20 Positionen machen und sind so an Seiten vorbeigezogen, die nach der (stumpfen) Ascorer-Reihenfolge viel besser waren.

Abgleich Google und Chefkoch-SERPs: It's a Match

Was lässt sich nun von Chefkochs internen Forschungsergebnissen auf Google übertragen? Laut Hanns korrelieren die Google-Ergebnisse stark mit den Top-Ergebnissen der internen Suche, seit Chefkoch die User Signals als Kriterien eingebaut hat. Zudem sehen sie in der Search Console von Google eine vergleichbare CTR wie in den eigenen Daten.

Ein ziemlich überzeugendes Argument dafür, dass das prinzipiell genauso auch bei Google funktioniert.

Ein weiterer spannender Aspekt von Chefkoch: Früher wurden neue Rezepte und neue Bewertungen eher ausgebremst, damit Spam nicht die Ergebnisse manipuliert. Inzwischen versucht Chefkoch möglichst schnell Nutzersignale zu bekommen. So kann es auch für Google Sinn machen, neuen Content anfangs mal in die Top-Ergebnisse zu werfen, um herauszufinden, was wir Menschen denn davon halten. Eine These, die wir SEOs ja auch schon viele Jahre haben.

Was lernen wir daraus für unsere tägliche SEO-Arbeit?

Wenn die SEO-Basics beim Content stehen, ist weitere Basic-Arbeit (TF/IDF) ein relativ kleiner Hebel Twiddler sind Multiplikatoren und somit der wesentlich größere Hebel, bei dem wir ansetzen wollen Snippets und – im Fall von Rezepten – Bilder können für einen gigantischen Boost sorgen Bezahlschranken, Werbung, lange Ladezeiten, wenig ansprechendes Design (= nervige und hässliche Seiten) drücken auf die Nutzersignale Wenn während der Feiertage, wo Menschen ein gänzlich anderes Nutzerverhalten an den Tag legen, die Rank Tracker wieder viel Dynamik anzeigen, hat Google vermutlich kein "geheimes Update" gefahren – sondern die User Signals boosten in Echtzeit andere Ergebnisse, weil sich die Suchintentionen und Verhalten mit Blick auf Geräte, Zeiten, Suchanfragen etc. ändert Unter den runter priorisierten Ergebnissen waren auch solche mit vielen positiven Bewertungen, an irgendetwas aber störten sich die Nutzerinnen und Nutzer: Im Fall von Omas Rezept für grüne Soße waren es vermutlich die 19 benötigten Zutaten → Die Diskrepanz hilft bei der Entwicklung von Testhypothesen

Die Slides und weitere Quellen hat Dir Hanns hier zusammengestellt.

Vielen Dank an Hanns für diesen großartigen Vortrag!

|

|

| So generierst Du garantiert hochwertige Backlinks (ohne Linkkauf, -tausch und fragwürdige Treffen auf Hinterhöfen) |

"Real creativity is coming up with a solution by changing the problem."

– Carrie Rose

Zum Reframing habe ich vor einigen Wochen geschrieben und persönlich einige gute Gedanken aus dem Buch "The Obstacle is the Way" von Ryan Holiday gezogen.

Denn Probleme sind immer auch eine Chance – auch in der SEO und den vielen Veränderungen, denen wir in letzter Zeit ausgesetzt sind.

Was wie ein Problem wirkt – die Aufspaltung des Suchverhaltens der User – ist gleichzeitig eine große Chance. Wie Du diese Chance nutzen kannst, um hochwertige Backlinks aufzubauen, erzähle ich Dir in diesem Artikel zu Carries Vortrag beim Digital Olympus.

SEO ist Teamsport

"Das Ganze ist mehr als die Summe seiner Teile"

– Aristoteles

Was wir im Marketing oft falsch machen ist, in Silos zu denken. Wir sehen nur uns, unsere Sichtweise und unser Budget. Teilweise sind die Strukturen, wie wir in Unternehmen arbeiten, daran Schuld, teilweise hat aber auch jede und jeder von uns zumindest eine kleine Teilschuld, sich nicht aktiv für Veränderung einzusetzen.

Was wir brauchen sind ineinander greifende Zahnräder, um mehr miteinander als gegeneinander zu arbeiten, Synergieeffekte zu hebeln und den Kuchen für alle größer zu machen.

Carrie hat das schön aufgegriffen: Damit SEO funktioniert, braucht es Nachfrage. Diese kann entweder bereits vorhanden sein oder erzeugt werden. Ohne vorhandene Nachfrage ist SEO als Kanal wertlos, also warum sprechen wir nicht mehr mit den Kollegen und Kolleginnen aus klassischen Marketing, PR, Social, & Co.?

Gerade in letzter Zeit haben wir oft gelesen, dass (vor allem in den USA) große Publisher die SERPs dominieren und unabhängige kleine Brands keine Chance haben sich zu positionieren.

Anstatt jetzt aber "rumzuweinen" denken wir daran zurück, dass jedes Problem auch eine Chance darstellt.

"Setbacks or problems are always expected and never permanent. Making certain that what impedes us can empower us."

– Ryan Holiday

If you can't beat them, join them

Wenn Du die anderen nicht überholen kannst, musst Du ihre Inhalte wie ein trojanisches Pferd von innen kapern. Ganz so böswillig ist es nicht, denn um den Plan durchzubringen, wirst Du eingeladen, weil Du einen echten Mehrwert lieferst.

Publisher wollen

Dabei kannst Du ihnen helfen. Wie so oft zeigt sich, dass der beste Weg andere zu beeinflussen, der ist, dass Du dabei hilfst, ihre Ziele zu erreichen.

Idealerweise möchtest Du am Ende in den Top Stories bei Google reinkommen, da das Links sind, die viel Traffic liefern und Autorität vererben. Außerdem sind "Breaking News" auf der Startseite platziert, was den Link in der Regel noch stärker macht.

Diese Wege helfen Dir, Trends möglichst schnell zu erkennen

Oft unterschätzt und in der Regel eine Goldmine: Die interne Suche. Eigentlich würde man denken "ist doch total offensichtlich", aber die Realität ist oft eine andere meiner Erfahrung nach.

Carrie hat basierend auf den Kunden, die sie betreut unter anderem folgendes gesagt:

30 % der User nutzen die interne Suche und konvertieren besser, als die, die nicht suchen.

Wie oft User die interne Suche verwenden, ist natürlich unterschiedlich. Dass es aber bei der Nutzung der internen Suche öfter zu einer Conversion kommt, ist logisch, da diese User bereits wissen, was sie wollen.

Was ich an Deiner Stelle tun würde:

Wenn es kein Tracking der internen Suche bei dem Shop, den Du betreust, gibt, dann würde ich es einrichten (lassen). Wenn es keine interne Suche gibt, würde ich evaluieren, ob es sinnvoll sein könnte, das in den Shop einzubauen – beispielsweise weil das Inventar groß (genug) ist und/oder der Bedarf vorhanden ist (z. B. evaluiert durch User-Befragungen oder eingehendes Feedback). Benachrichtigungen im Tracking-Tool einstellen, wenn bestimmte interne Suchen Ausschläge haben, die über einen Grenzwert hinausgehen.

Dadurch gibt es erste Anhaltspunkte, dass gerade ein Trend entsteht. Du kannst die Daten mit Google Trends abgleichen, um zu verifizieren, dass es nicht nur den eigenen Shop betrifft. Mit Buzzsumo kannst Du herausfinden, was die plötzliche Explosion in der Nachfrage ausgelöst hat.

Das Beispiel von Carrie: Explosionsartig mehr Suchvolumen nach "white vans". Normalerweise würde es dauern, bis man herausfindet, warum danach so viel intern gesucht wird, wenn man überhaupt einen Alarm eingestellt hat.

Alle Teilnehmer und Teilnehmerinnen in Squid Game – einer extrem populären Netflix-Serie – haben weiße Vans getragen. Anstatt dass Stunden, Tage, Wochen und Monate vergangen sind, bis man überhaupt davon gehört hat, hat Carrie mit ihrem Team innerhalb von 40 Minuten Kontakt zu Publishern aufgenommen.

Das Ergebnis: Innerhalb von 24 Stunden hat sie mit ihrem Kunden hunderte organische Links aufgebaut und für fast 20k Seitenaufrufe gesorgt.

Neben den ganzen Links gab es auch starkes Engagement in den sozialen Medien und selbst Netflix hat es retweeted.

Keine interne Suche? Kein Problem.

Carrie empfiehlt Glimpse. Damit kannst Du Trends in Kombination mit Suchvolumen beobachten und Dich benachrichtigen lassen, wenn es Ausschläge nach oben gibt.

"Was ist, wenn ich nicht weiß, was die potenziellen Keywords sind?" Gute Frage, für die Carrie Rose Exploding Topics empfiehlt.

Erneut ein tolles Beispiel: 2014 hatte "airport outfits" ca. 1,4k Suchen im Monat. 2019 waren es ca. 3k und jetzt 11k. Die einzige Seite, die dazu gerankt hat, war Pinterest. Menschen haben an Flughäfen ihre Outfits aufgenommen und in den sozialen Medien geteilt.

Mit ihrem Kunden hat Carrie alle passenden Artikel in eine Kategorie gepackt, diese auf das Keyword "airport outfits" optimiert, durch Outreach zu Publishern zusätzlich für organische Nachfrage gesorgt und alles mit dem passenden Inhalt in der Suche abgeholt.

Lass kein Potenzial auf der Straße liegen – wie Zara (schon wieder)

Zara schafft es immer wieder, auf Social Media für Trends zu sorgen. Anstatt dass man diese Nachfrage in der Suche abfängt, läuft man aber oft ins Leere. Ich habe im Newsletter auch schon mal über Zara gemeckert, die an einigen Stellen Geld auf der Straße liegen lassen.

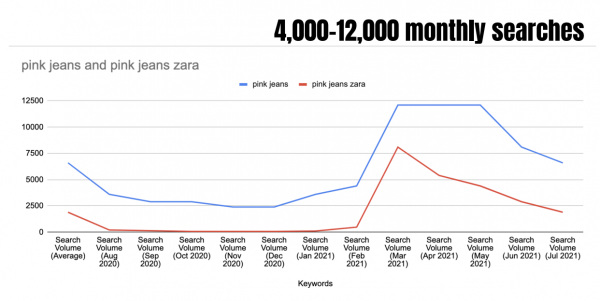

Einige Publisher haben über in den sozialen Medien populäre pinke Zara Jeans geschrieben. Die Entwicklung des Suchvolumen zeigt, dass Zara den Trend vermutlich angestoßen hat:

Nachfrage vorhanden, nur das passende Angebot von Zara in den SERPs hat man damals vergeblich gesucht. Das Beispiel zeigt perfekt, wie es nicht laufen darf. Das passiert, wenn man nicht miteinander redet.

"When we learn how to work together versus against each other things might start getting better".

– Alex Elle

Warte nicht auf Trends, sondern starte sie selbst

Agieren > Reagieren. Daher schlägt Carrie vor, Trends selbst zu schaffen und die entstehende Nachfrage per SEO einzufangen.

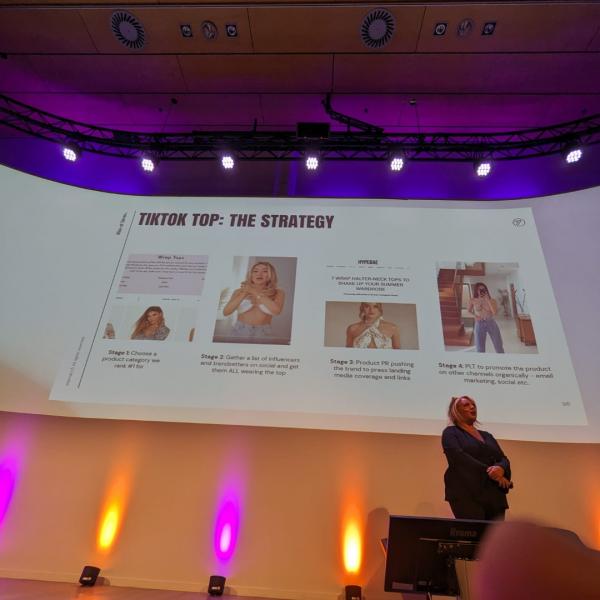

Hier ein Beispiel in wenigen Schritten:

Finde heraus, für welche Produktkategorien Du auf Platz 1 rankst, wie hoch SV ist und wie viele Produkte Du auf Lager hast – denn ein Trend ohne viel Ware hilft Dir nicht weiter, wenn das viral geht. Wähle eine passende Produktkategorie aus, es können ruhig neue, unkonventionelle Produkte sein. Sammle eine Liste von Influencern auf Social Media und sorge dafür, dass sie Dein Produkt tragen/zeigen. Das muss nicht immer bezahlt sein! Bereite Outreach für Publisher vor, sodass Du direkt was Passendes mitgeben kannst. Promote das Produkt organisch auf anderen Kanälen (z. B. E-Mail Marketing).

Es ist der gleiche Kunde wie aus dem vorherigen Beispiel mit den Airport Outfits. Das, was Carrie da mit ihrem Team macht, ist wiederholbar und hat für

Alles aus einer Kampagne. Und dazu kommen noch Zahlen aus TikTok. Sie gab an, dass es mehr als 10m Views waren und fast 47k User die Seite des Produkts angesteuert haben.

SEO-Daten = Daten zu realer Nachfrage, also nutze sie richtig

"Advertising puts brands and products in front of people not knowing if it's even what they want.

But we work in search. We know exactly what people want. And where they're looking for it."

– Carrie Rose

Starkes Zitat zum Abschluss.

Für mich war das neben dem Vortrag von Kevin Indig (den ich in Ausgabe #210 für Dich aufbereitet habe) der beste Vortrag vom Digital Olympus.

Jetzt frage ich mich: Hast Du bei Euch im Unternehmen sowas schon mal umgesetzt?

|

|

| Robust - 4. Grundprinzip der Barrierefreiheit nach WCAG |

Mein letzter Artikel für diesen Newsletter ist schon eine Weile her. Und das, obwohl ich doch versprochen habe, über alle 4 Grundprinzipien der Web Content Accessibility Guidelines zu schreiben (kurz: WCAG).

Umso erfreulicher ist es, dass das Thema Barrierefreiheit auch immer mehr bei uns SEOs ankommt. So gab es auf der letzten Campixx direkt zwei Vorträge zur Barrierefreiheit:

Nadine Wolff mit einer allgemeinen Einführung in das Thema. Schwerpunkte waren hier die gute Vereinbarkeit von SEO und Barrierefreiheit sowie Farbnutzung auf Webseiten. Maike Schultze-Rhonhof mit einem Vortrag über die Grundprinzipien der Barrierefreiheit. Wobei ihr Fokus auf den ersten 3 lag (Wahrnehmbarkeit, Bedienbarkeit, Verständlichkeit).

Maikes Cliffhanger nutze ich daher jetzt sehr gern und gehe heute auf Grundprinzip 4 "Robust" ein.

Was bedeutet "Robust"?

In den WCAG steht dazu:

"Content must be robust enough that it can be interpreted by a wide variety of user agents, including assistive technologies."

("Inhalte müssen so robust sein, dass sie von zahlreichen User-Agents inkl. Assistiven Technologien interpretiert werden können.")

3 Erfolgskriterien von "Robust"

Nun soll man ja aber nicht robust mit robust erklären. Daher ist es sinnvoll, direkt einen Blick auf die Erfolgskriterien zu werfen:

Parsing

Beim Parsing ging es vor allem um korrekte Syntax. Also: Sind alle erforderlichen Start- und End-Tags vorhanden? Sind Spezifikationen korrekt verschachtelt? Da assistive Technologien aber mittlerweile HTML nicht mehr direkt parsen müssen, gibt es das Problem nicht mehr. Entsprechend wurde das Erfolgskriterium in den WCAG 2.2. entfernt.

Name, Role, Value

Im Gegensatz zum Parsing von HTML sind assistive Technologien aber darauf angewiesen, dass Komponenten korrekte Namen, Rollen und Werte haben. Deswegen heißt es im 2. Erfolgskriterium von "Robust":

"For all user interface components (including but not limited to: form elements, links and components generated by scripts), the name and role can be programmatically determined; states, properties, and values that can be set by the user can be programmatically set; and notification of changes to these items is available to user agents, including assistive technologies."

(In deutsch übersetzte Richtlinien von Aktion Mensch e.V.: "Für alle Bestandteile der Benutzerschnittstelle (einschließlich, aber nicht beschränkt auf: Formularelemente, Links und durch Skripte generierte Komponenten) können Name und Rolle durch Software bestimmt werden; Zustände, Eigenschaften und Werte, die vom Benutzer festgelegt werden können, können durch Software festgelegt sein; und die Benachrichtigung über Änderungen an diesen Elementen steht den Benutzeragenten zur Verfügung, einschließlich assistierender Techniken.")

Dieses Erfolgskriterium zielt darauf ab, dass assistive Technologien wie Screenreader semantische Informationen erhalten. Native HTML-Elemente, wie <button>, <ul>, <nav> etc., sind von Haus aus semantisch. Andere wie <div> oder <span> sind es hingegen nicht.

Mithilfe von WAI-ARIA (Web Accessibility Initiative - Accessible Rich Internet Application) (Link zu developer.mozilla.org) kannst Du die fehlende Semantik aber ergänzen.

Falls Du dich jetzt fragst, was das mit SEO zu tun hat, habe ich ein paar Gegenfragen für Dich:

Haben die SVGs auf Deiner Website immer einen alternativen Text? Haben Deine Links immer einen Ankertext? Auch Deine Social Icons?

Angenommen, Du verlinkst zum Beispiel im Footer Deine Social Media Profile mit einem SVG-Icon:

<a href="[Beispiel-URL]">

<svg [...]>[...]</svg>

</a>

Das ist nicht barrierefrei. Um das zu verbessern, kannst Du zum Beispiel <title> als erstes Child-Element in Deinem SVG ergänzen. Damit dieser dann auch Deinem SVG zugeordnet wird, musst Du im <svg>-Tag noch role="img" einfügen.

<a href="[Beispiel-URL]">

<svg [...] role="img">[...]

<title>[...]</title>

</svg>

</a>

Das ist ein Lösungsweg. Es gibt aber auch andere Varianten, um SVGs barrierefrei zu gestalten. Mehr dazu kannst Du zum Beispiel bei css-tricks.com nachlesen.

Status Messages

Das Role-Attribut kannst Du auch nutzen, um das Erfolgskriterium "Status Messages" zu erfüllen. Das wird dann wichtig, wenn sich auf Deiner Webseite Inhalte verändern, die nicht direkt Fokus bekommen. Das kann beispielsweise der Fall sein, wenn ein User etwas über Deine interne Suchseite sucht und dann "18 Treffer gefunden" angezeigt wird.

Wie schon in meinen letzten Artikeln folgt auch hier nochmal ein kurzer Disclaimer: Das oben Beschriebene sind alles nur Beispiele und nicht zwingend der richtige Lösungsweg für Deine Webseite.

Und auch, wenn ich dieses Mal alle Erfolgskriterien von "Robust" beschrieben habe, sind diese doch genauso umfangreich wie die anderen, bei denen ich nur auf ausgewählte Kriterien eingegangen bin.

Falls Du Dich also bis jetzt noch nicht mit Barrierefreiheit befasst hast, dann empfehle ich Dir loszulegen. Schließlich ist es nur noch knapp 1 Jahr, bis Webseiten barrierefrei sein müssen (Ausnahmen ausgenommen). Ab 28. Juni 2025 wird das Barrierefreiheitsstärkungsgesetz (BFSG) angewendet.

Wenn Du Dich einlesen möchtest, dann habe ich hier auch nochmal meine vorherigen Artikel für Dich:

|

|

| Der Collapsor braucht ne softe Cola-Bier-Mische mit 4,04% |

Die letzten Jahre habe ich mich intensiv mit Indexierung auseinandergesetzt. Ich finde das faszinierend: Wie speichere ich einmal Internet so, dass es in Bruchteilen von Sekunden durchsuchbar ist.

Die Mengen und Dimensionen, in denen hier gearbeitet werden muss, sind einfach Mindblowing. Kein Wunder, dass das Indexing-System bei Google nach der Bibliothek von Alexandria benannt wurde.

Aber darum soll es gar nicht gehen.

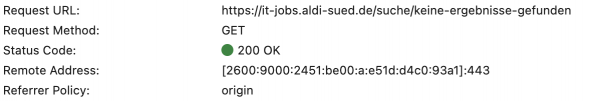

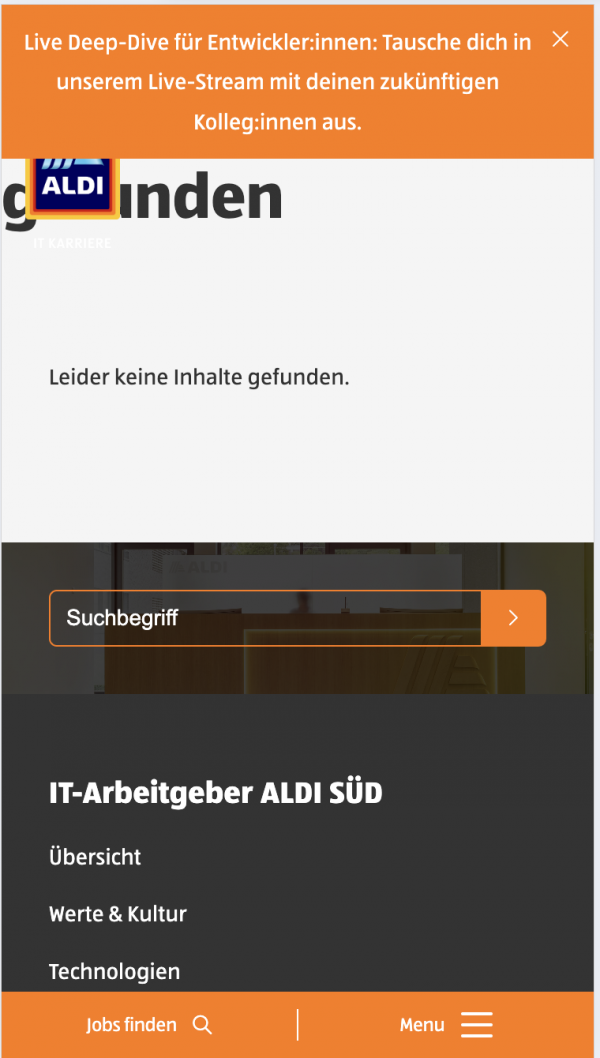

Im Indexierungsprozess werden Dokumente nicht berücksichtigt, die nicht indexierungswürdig sind. 404-Seiten oder Dokumente, die als Noindex gekennzeichnet sind beispielsweise. Es gibt aber viele Seiten, die liefern ein sinnloses Ergebnis, das eigentlich nicht verfügbar sein sollte, als indexierbare Seite mit dem Status Code 200 aus. Ein Beispiel wären leere Suchergebnisseiten.

Das sieht dann etwa so aus:

Während eines Routine-Rundgangs durch die Search Console kann man jetzt gut sehen, wie ein Teil der Heuristik zur Erkennung und Aussortierung solcher Seiten aussieht. Denn logischerweise möchte Google solche Seiten eigentlich nicht indexieren. Sie lassen Google schlecht dastehen, denn ein Klick aus den Google-Suchergebnissen auf ein Ergebnis sollte mich immer näher an das Ziel führen.

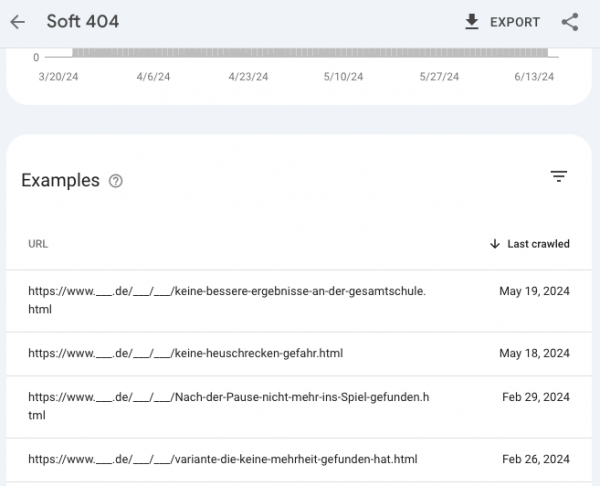

Im Screenshot aus der GSC ist gut zu erkennen, dass Google die Fehler vor allem auch an URL und Überschrift fest macht. Bei den Seiten handelt es sich um Nachrichten-Artikel:

Keine bessere[sic!] Ergebnisse an der Gesamtschule Keine Heuschrecken-Gefahr Nach der Pause nicht mehr ins Spiel gefunden Variante die keine Mehrheit gefunden hat

Gut zu sehen, wie der Collapsor (so heißt der Prozess / das System bei Google, das die Analyse auf Soft-404 vornimmt) arbeitet. Gary hat das System vor ein paar Jahren im Search Off the Record-Podcast vorgestellt.

Vor allem auf die Worte „Keine" und „Nicht" reagiert das System sehr deutlich. Wenn Du also sichergehen willst, dass Google Deine Inhalte indexiert und nicht als Soft-404 behandelt. Dann solltest Du gelegentlich schauen, dass Du Verneinungen in den Headlines vermeidest. Meistens funktioniert die Indexierung trotzdem. Aber hier ist Machine Learning am Werk und das kann dann auch mal schief gehen.

|

|

|

|

|

Fragen? Immer gerne fragen!

|

Wir sind für Dich da.

Schreib uns gern jederzeit

eine E-Mail an [email protected] oder

ruf uns einfach kurz an: +49 40 22868040

Bis bald,

Deine Wingmenschen

|

|

Anckelmannsplatz 1, 20537 Hamburg, Germany

|

|