| Wirklich wahres Wingmen SEO Wissen für wache Webmarketer #164 |

|

| 🫵 Ene mene bu, der SEO der bist Du! |

Sommer, Sonne, Sonnenschein... Man sollte denken, das ist die beste Jahreszeit, die Temperaturen endlich wieder im Bereich, in dem wir (selbst in Hamburg) mal keine Jacke mehr benötigen, wenn wir das Haus verlassen. Doch oft vergessen wir die Urlaube und krankheitsbedingten Ausfälle unserer Kollegen und dann fallen die offenen Aufgaben auf einmal auf 🫵 Dich zurück.

Geht es Dir ähnlich? Wie gehst Du damit um? Selbst nach meiner schon recht langen Karriere besitze ich immer noch die "Ärmel hoch"-Mentalität. Und das finde ich, macht ein gesundes Miteinander unter Kollegen aus. Das ist vielleicht einer der Gründe, weshalb ich so gerne ein Wingmensch bin. Denn ich weiß, dass meine Kollegen genauso für mich einspringen.

Aber nun machen wir den Sprung zu unseren heutigen Themen:

Philipp b(l)ockt mit der robots.txt Matt erklärt Dir, wie Du ohne Panik die CWVs bis März 2024 rockst Johan zeigt Dir mittelmäßige Matrizen Behrend klärt Dich auf, was Du ggf. bei Deinem Consent Management prüfen bzw. beachten solltest Und ich habe mir einmal das Thema "Personalisierte Inhalte" vorgenommen

Und damit: Wünschen wir Dir eine wunderbare Woche!

Deine Wingmenschen

|

|

| Blocked by robots.txt: No information is available for this article |

Na, bist Du da aufmerksam geworden?

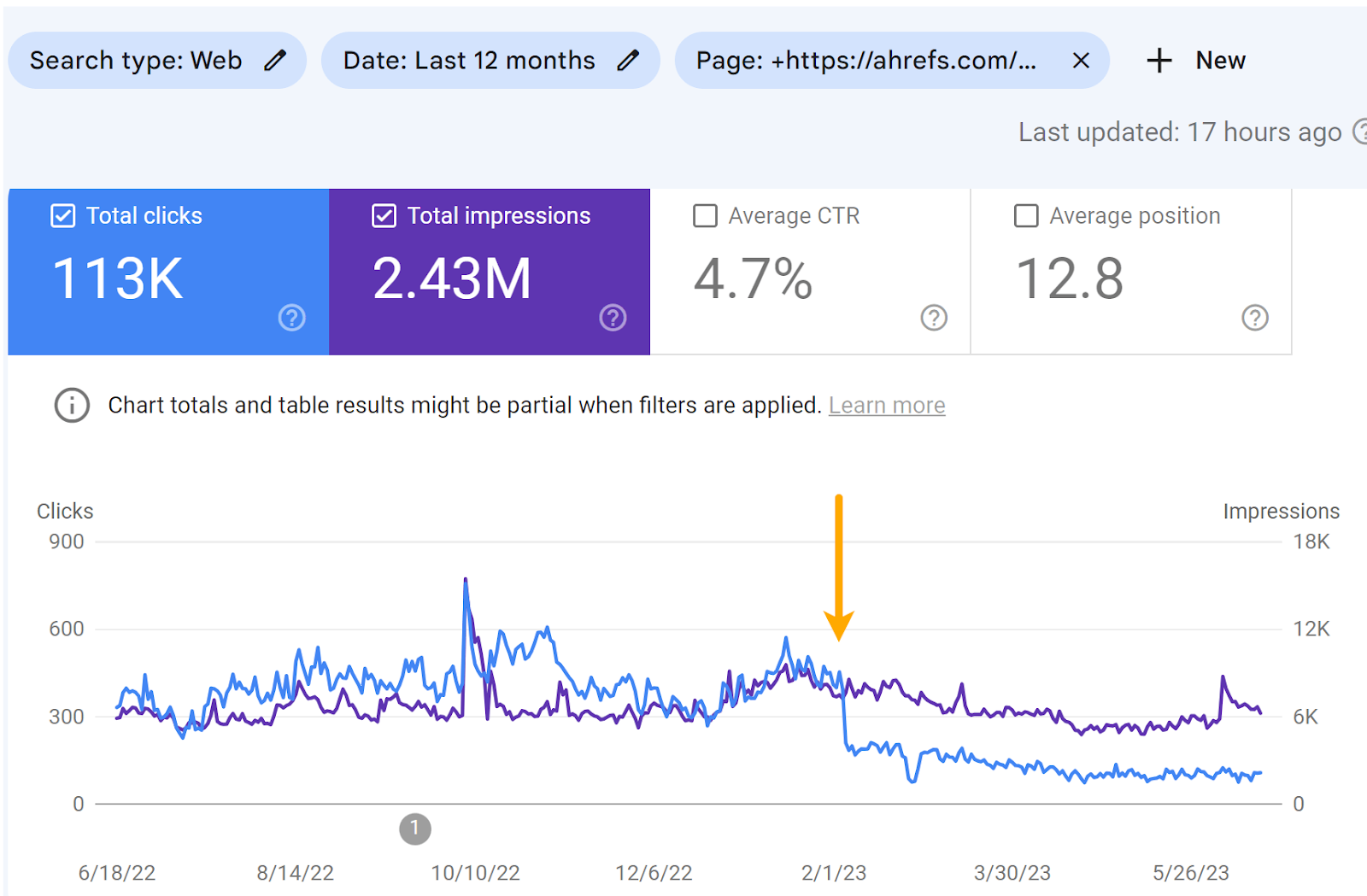

Ich bin auf diesen Artikel "The Story of Blocking 2 High-Ranking Pages With Robots.txt" von Ahrefs gestoßen. Hier hat Patrick Stox getestet, was passiert, wenn ein paar URLs „versehentlich" in der robots.txt blockiert werden.

Vor ein paar Jahren hat sich auch John Müller zu einem eng verwandten Thema auf Twitter geäußert. Er schrieb, dass Google auch, nachdem ein Inhalt nicht mehr auf einer Seite zu finden ist, diese trotzdem für besagten Inhalt in den Suchergebnissen anzeigen kann. Google weiß also in einigen Fällen auch nach dem Entfernen von Inhalten noch, worum es auf dieser Seite geht.

Wenn eine URL aber durch die robots.txt blockiert ist, sieht Google den (entfernten) Inhalt nicht und diese Hypothese wurde getestet:

"Was passiert mit meinen Rankings und dem Traffic, wenn Google meine Inhalte nicht crawlen kann/darf?"

Auswirkungen auf die Rankings und Traffic

In dem Experiment von Ahrefs ranken beide URLs nach 5 Monaten immer noch für viele Begriffe inklusive neuer Rankings, die in der Zeit hinzugekommen sind. Insgesamt wurde deutlich weniger Traffic eingebüßt, als vorher gedacht.

Wie zu erwarten, wurden die URLs in den Suchergebnissen ohne Title und Meta Description angezeigt. Die Google Search Console hat den "Fehler" natürlich mit dem Hinweis berichtet, dass die URLs indexiert, aber durch die robots.txt blockiert seien.

Was auch erkennbar ist: Die Impressions haben nicht deutlich verloren, die Klicks hingegen schon.

Dadurch, dass kein richtiges Snippet mehr angezeigt wurde, ist das auch logisch. Wer klickt schon gerne auf ein nacktes Suchergebnis.

Was wir daraus lernen können und bedenken sollten

Es ist ein kleiner Test von einer autoritären Seite aus der SEO-Branche. Die Erkenntnisse lassen sich daher auf keinen Fall verallgemeinern. Eine spannende Frage wäre zudem:

Wie verändert sich das Crawlverhalten nachdem die Sperre aufgehoben wurde?

Eine Legende besagt, dass Google dann besonders gierig sei, sobald die Blockierung aufgelöst wird. Eine andere Legende wiederum behauptet, dass eine (kurzzeitige) Blockierung in der robots.txt helfen könne, um Indexierungsprobleme zu beheben.

So etwas auszuprobieren ist aber mit gewissen Risiken verbunden und sollte daher abgewogen werden. Johan hat hier berichtet, wie Du den Wert eines Risikos oder einer Chance bestimmen kannst.

Beim Thema SEO spielt außerdem das Snippet eine weniger wichtige Rolle, als es in anderen Branchen der Fall ist. Merkt man vielleicht auch daran, dass Du den Artikel bis hierhin gelesen hast, obwohl die Überschrift keinen richtigen Inhalt hatte und ihre Aufgabe doch vor allem ist, zum Lesen zu motivieren.

Der Impact auf die Klick-Performance kann in anderen Fällen deutlich größer sein. Beispielsweise im E-Commerce sind bei so etwas größere Auswirkungen zu erwarten, da hier ein richtiges Snippet inklusive Bild große Wirkung auf die CTR hat.

Der Test war also interessant, die Aussagekraft darf aber nicht überbewertet werden.

|

|

| CWVs-Panik v2.0 in 3… 2… 1… |

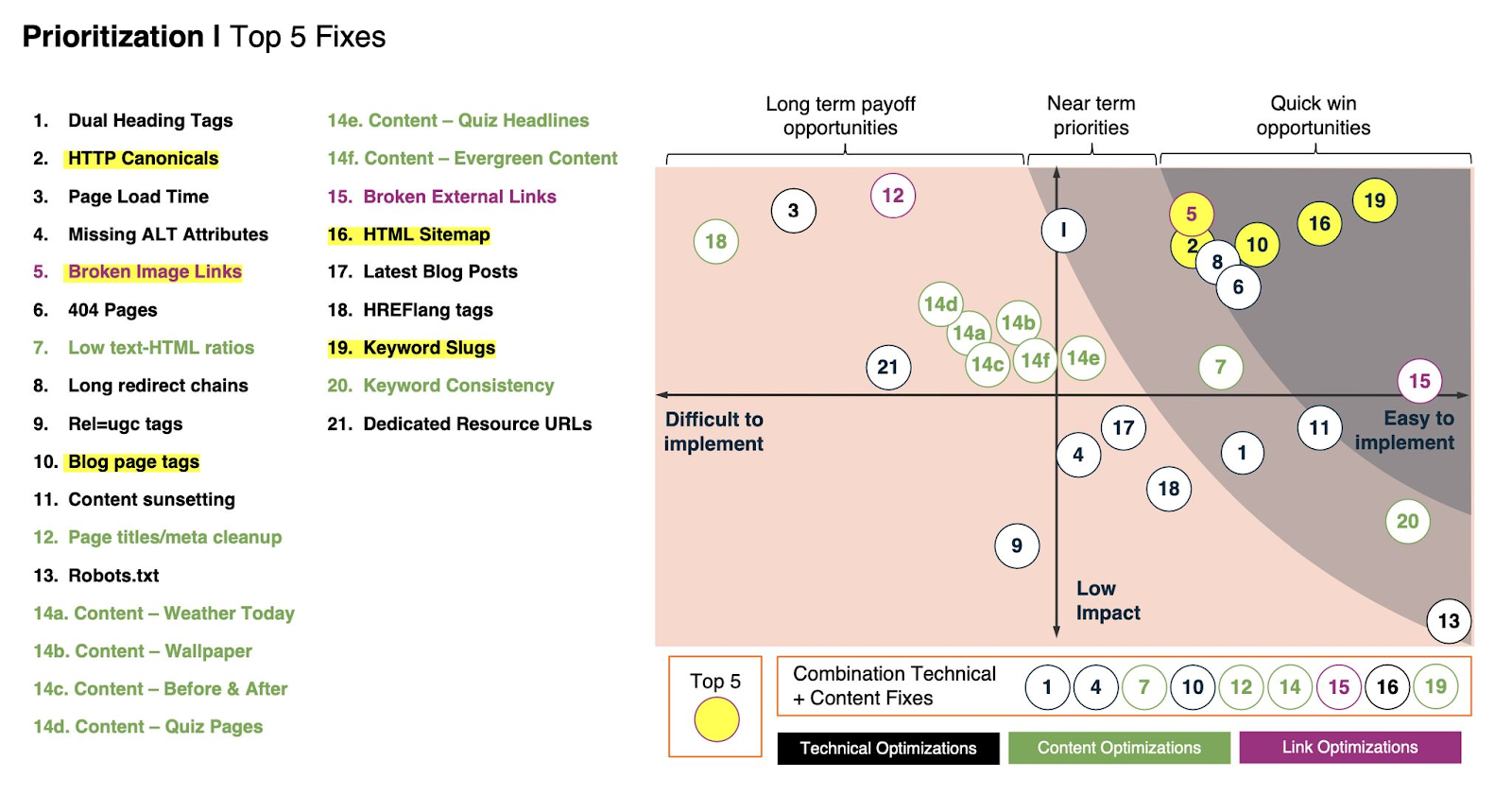

Google hat vor einer Weile angekündigt, dass die Metrik FID (First Input Delay) zum März 2024 durch die Metrik INP (Interaction to Next Paint) ersetzt wird.

Eine nachvollziehbare Entscheidung, denn im Gegensatz zum FID, der lediglich die erste Interaktion auf einer Seite misst, bezieht INP alle Interaktionen während des Besuchs einer Website mit ein (Mehr dazu in Flos Artikel "Core Web Vital Daumenschrauben werden noch enger gezogen" in der Newsletter-Ausgabe SEO-Wonnemonat Mai).

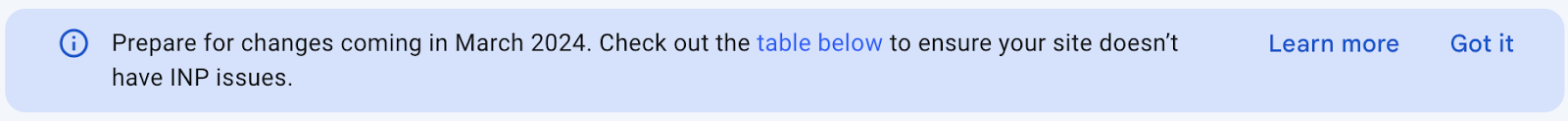

Seitdem findet sich in der Google Search Console beim Klick auf die Core Web Vitals der mahnende Hinweis

"Im März 2024 wird FID von INP als Teil von Core Web Vitals ersetzt. Informiere dich mit der neuen Tabelle mit INP-Problemen über die Leistungen deiner Website"

oder

"Prepare for changes coming in March 2024. Check out the table below to ensure your site doesn't have INP issues":

März 2024 also... Na gut, das schien bislang weit weg. Ein Datum in ferner Zukunft. Nichts, worüber man sich unbedingt jetzt schon Gedanken machen muss... Und somit schnell wieder aus den Köpfen verschwunden – bis vor ein paar Tagen E-Mails mit erkannten Problemen aus der GSC in viele Postfächer flatterten. Die Folge (um meine Kollegin Saskia zu zitieren, wenn auch in anderem Zusammenhang):

Core Web Vitals INP issues detected on your sites

So sieht diese furchteinflößende E-Mail aus:

Inhaltlich steht dort Folgendes geschrieben:

Hey Du, Deine INP-Werte sehen aktuell noch nicht aus, wie sie idealerweise sein sollten. Wir möchten Dich einfach einmal nett daran erinnern, das im Auge zu behalten und Dich bald um das Thema zu kümmern, denn Du weißt ja: Ab März 2024 ersetzt INP die Metrik FID. Betroffene URLs findest Du bei uns in der Search Console.

Was jedoch die meisten lesen:

Oh mein Gott! Du musst Dich unbedingt sofort um Deinen INP-Wert kümmern, denn wenn Du es nicht tust, wird Google Deine Seite auf der Stelle packen und kopfüber in den Boden rammen. Organischen Traffic oder ein halbwegs brauchbares Ranking kannst Du dann vergessen – für immer! Ahhhhhhhhhhhhhhhhhhh!

Was Du jetzt tun solltest (oder auch nicht)

Unser Tipp an dieser Stelle:

Erst einmal tief durchatmen... Ja, ein guter INP-Wert ist schön und es ist durchaus sinnvoll, das Thema lieber früher als zu spät anzugehen. Trotzdem solltest Du jetzt nicht in Panik verfallen. Du hast noch über ein halbes Jahr Zeit und auch dann wird Dich Google nicht ins Niemandsland schießen, nur weil Dein INP-Wert nicht perfekt ist. Andere Faktoren wie Relevanz und hochwertiger Content sind nach wie vor wichtiger als die Core Web Vitals.

Falls Du Dich jedoch trotzdem jetzt schon auf die anstehende INP-Einführung vorbereiten oder Deine Core Web Vitals ohnehin schon länger aufpolieren und in den grünen Bereich bringen wolltest, melde Dich gerne bei uns. Wir helfen Dir dabei!

Denn auch wenn die Core Web Vitals aus SEO-Sicht eher das Zünglein an der Waage sind: Schlechte Ladezeiten nerven und haben außerdem einen nachweislich negativen Einfluss auf Deine Conversations. Also wenn das kein Grund ist, die Performance etwas nach oben zu schrauben!

|

|

| Mittelmäßige Matrizen |

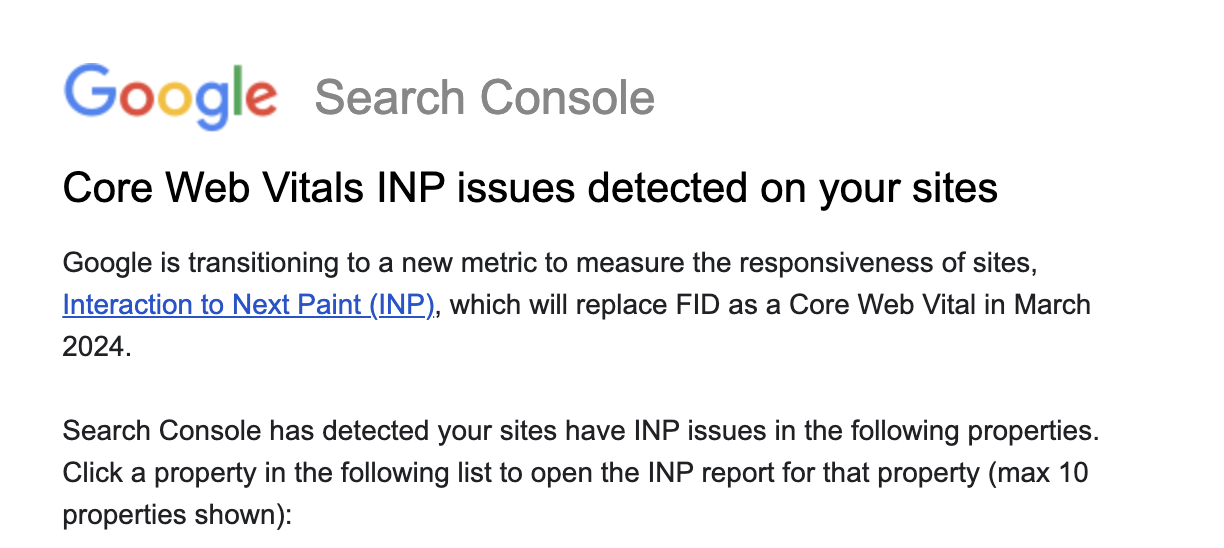

Auf LinkedIn ging eine kleine Matrix von Rodrigo S. herum.

Und ich mag es ja, Informationen in eine Matrix zu verpacken (und bin damit nicht allein bei uns). Mehr als zwei Dimensionen kriege ich immer schwer verarbeitet. Aber das Beispiel ist zum Glück auch nur eine 4-Felder Matrix + Farbcode. Komplexität ist also noch verarbeitbar.

Daher hab ich mir das näher angeschaut:

Wir bewerten die Todos also nach Impact und Aufwand. Das ist naheliegend und weit verbreitet. Und dann suchen wir uns diejenigen heraus, die wir als Quick Win oder Long Win umsetzen wollen.

Ein paar Dinge müssen wir im Kopf jonglieren. Beispielsweise mögliche Abhängigkeiten.

Grundsätzlich stört mich nur eine Kleinigkeit: Man ignoriert schnell Low Impact, easy to implement. Die 13 wäre so ein Ding: Warum der Impact der Robots.txt hier Low ist, erschließt sich mir nicht. Das ist auch nicht mein Punkt: Aber diese Dinge addieren sich häufig zu einem insgesamt relativ hohen Impact bei geringem Aufwand.

Vielmehr fand ich allerdings die Details im Beispiel bemerkenswert. Denn hier sehen wir, dass die Bewertungen massiv abhängig von den eigenen Einschätzungen sind. Matrizen wie diese suggerieren Objektivität. Sie sind aber weit davon entfernt.

Frag doch mal bei Deiner IT, ob Low text-HTML ratios wirklich easy to implement sind. Ich kenne kein Team, dass das mal eben hinbekommen würde (und es dann noch nicht gemacht hat).

Und dann kannst Du auch gleich noch mal 10 SEOs fragen und mal schauen, ob einer sagen würde, dass Low text-HTML ratios einen höheren Impact als Missing ALT Attributes oder Dual Headings hat.

Wenn Du Dir die Positionierung der einzelnen Punkte ansiehst, dann findest Du sicher auch noch mal mehr Punkte, die Dich wundern.

Und wenn wir damit fertig sind, dann achten wir nochmal kurz auf die Farbgebung: Die suggeriert, dass wir alle Punkte im dunkelgrauen Bereich umsetzen wollen. Und das wiederum bedeutet: Lasst uns Short-Win nach Short-Win nach Short-Win umsetzen. Das lässt keinen Raum für strategische Initiativen, langfristige Orientierung und Umsetzung einer Strategie.

Wenn wir uns die Top-5 ansehen, dann würde ich davon – unter der Annahme, dass es sich um eine mittelgroße Seite handelt – lediglich die Broken Images unterschreiben. Für sprechende URLs (Keyword Slugs) würde ich nur in Ausnahmefällen URLs anpassen. Blog tag pages als Low Effort haben schon lange keinen High Impact mehr. Die HTML Sitemap kann helfen, aber ist oft nur ein Workaround für strukturell schlechte interne Verlinkung.

Wie also könnte die Matrix bei der Priorisierung helfen?

Impact und Aufwand objektivieren Entscheiden, was das Ziel ist: Maximaler Impact? Minimaler Aufwand? Maximale Effizienz der eingesetzten Ressourcen? Kurzfristige oder langfristige Ziele? Ressourcen-Limits unterscheiden sich vermutlich zwischen Technik, Content, etc. Daher ist die Unterscheidung wertvoll, sollte aber auch mit eigenen Prioritäten einhergehen

Wir müssen Aufgaben nach Aufwand und Ertrag priorisieren, aber die Lösung ist dann doch nicht ganz so eindimensional, wie in der Grafik dargestellt.

|

|

| Consent Management Consolidation incoming |

Bislang haben viele Datenkraken das Thema Consent Management weitgehend ignoriert. Abgesehen von Empfehlungen zur Implementierung und halbherzigen Forderungen danach, das Consent bitteschön zu beachten sei, haben sowohl Marktrisiken wie Google und Meta, als auch kleinere Anbieter für Online-Werbung, wie Criteo, sich darauf ausgeruht, dass die Webseitenbetreiber sich um das Consent Management kümmern müssen. Frei nach dem Motto "Natürlich halten sich alle unsere Partner daran, uns nur Daten zusenden, wenn die Zustimmung des Nutzers vorliegt 😉". Außerdem hofft man auf das European Union-U.S. Data Privacy Framework (die Neuauflage von Privacy Shield (die Neuauflage von Safe Harbour)), das langsam tatsächlich Form annimmt.

Nach Beschwerden durch NOYB ("None of Your Business", das ist die NGO von Max Schrems (ja, der aus Schrems I und Schrems II (das sind die Urteile die Privacy Harbour und Safe Shield gekippt haben (ich mein Safe Harbour und Privacy Shield))) hat die französische Datenschutzbehörde nun ein Exempel statuiert: Criteo darf eine Strafe in Höhe von 40.000.000 € zahlen und sich in Zukunft nicht mehr einfach so darauf verlassen, dass schon irgendwer Consent eingeholt haben wird, bevor Nutzerdaten an Criteo gesendet werden. Das bedeutet aber nicht, dass Criteo etwas an der Datenerfassung selbst ändert. Es sind vielmehr vertragliche Anpassungen, die die Verantwortung für das Consent Management den Partnern wieder zuschieben.

Google hat vorauseilend damit begonnen sicherzustellen, dass man ihnen Ähnliches nicht so leicht vorwerfen kann: Für einzelne Tracking-Requests nachzuweisen, dass es Consent gab, ist technisch kaum abbildbar. Aber in Zukunft müssen Publisher, die Werbeanzeigen via Google Ads ausspielen, ein Consent Management System nutzen, das von Google lizenziert wurde.

Googles Entscheidung hat Dank seiner Marktmacht möglicherweise große Auswirkungen:

Domains, die von (Google-)Ads leben, müssen sich an Googles Liste orientieren. Kleinere CMP-Anbieter oder gar Eigenentwicklungen sind (und haben) damit ein Problem. Consent Management Plattformen müssen sich quasi bei Google um einen Platz auf der Liste bewerben. Diese Abhängigkeit könnte Google nutzen, um die eigene Marktposition weiter zu stärken. Zyniker könnten sogar vermuten, dass auf lizenzierungswillige CMPs Druck ausgeübt wird, ihren Code nicht Privatsphäre-freundlicher, sondern Google-freundlicher zu gestalten. Was genau da vermutet wird, hängt davon ab, wie zynisch der jeweilige Zyniker gegenüber Google und der Online Werbebranche ist...

Das TCF der IAB wird dadurch noch weiter gestärkt und von Google als Voraussetzung für Google Ads etabliert. Ja genau, das TCF, das von der belgischen Datenschutzbehörde dafür abgewatscht wurde, dass es personenbezogene Daten überträgt, die es eigentlich schützen soll...

|

|

| Personalisierte Inhalte, aber richtig |

Ich möchte Dir gerne über einige Tipps zur Personalisierung von Inhalten auf Webseiten berichten, die von John Müller gegeben wurden. Es geht darum, dass der Googlebot die gleichen Inhalte sehen sollte wie die Nutzer aus der Region, aus der Google crawlt.

Personalisierte Inhalte auf Webseiten können den Besuchern einen Mehrwert bieten, besonders wenn sie bereits die Seite besucht haben und passende Angebote sehen. Ich finde es immer nützlich, wenn mir beim erneuten Besuch einer Webseite relevante Informationen präsentiert werden.

Allerdings kann die Personalisierung von Inhalten in Bezug auf SEO problematisch sein. Wenn manche Besucher andere Inhalte sehen als der Googlebot, könnte dies von Google als Cloaking angesehen werden. Dies kann dazu führen, dass bestimmte Inhalte von Google nicht erfasst und indexiert werden. Oder die Website weitere "Manuelle Maßnahmen" erfährt. Das ist natürlich etwas, das wir unbedingt vermeiden müssen. Sollte Deine Website also personalisierte Inhalte auf öffentlich zugänglichen Seiten ausspielen, so prüfe auf jeden Fall, welche Inhalte ein Googlebot sieht und nach welchen Kriterien.

John Müller hat auf Twitter einige wichtige Punkte genannt, die wir bei der Personalisierung von Inhalten in Bezug auf SEO beachten sollten. Der Googlebot sollte grundsätzlich die gleichen Inhalte sehen wie Besucher aus der Region, aus der er kommt. In den meisten Fällen sind das die USA. Es ist also wichtig sicherzustellen, dass der Googlebot die Inhalte sieht, die für diese Besucher relevant sind. Dazu hat Google eine Liste der aktuell verwendeten IP-Adressen publiziert, die automatisch aktualisiert und im JSON-Format bereitgestellt werden. Diese Liste können wir natürlich automatisch und regelmäßig abgleichen. Dabei dürfen wir die IPv6-Adressen nicht vergessen, wenn unser Server auch mit einer solchen IPv6-Adresse arbeitet. Wie Du das testen kannst, habe ich in diesem Newsletter-Artikel schon einmal beschrieben.

Ein weiterer wichtiger Punkt ist, dass personalisierte Inhalte für eingeloggte Nutzer für Google keine Rolle spielen, da Google sich nicht einloggt. Das bedeutet, dass wir uns bei der Personalisierung auf die Besucher konzentrieren sollten, die nicht eingeloggt sind. Ein weiterer wichtiger Punkt sind Cookies: Google-Bots akzeptieren und senden keine Cookie-Informationen. Achte also darauf, wie Deine Website ohne Cookies funktioniert und welche Inhalte ausgespielt werden.

John Müller von Google hat außerdem empfohlen, personalisierte Inhalte nicht auf zusätzlichen URLs anzuzeigen, um die Komplexität zu reduzieren. Es ist wichtig, dass die Inhalte auf den Landing Pages für die Suchergebnisse gleichwertig sind. Das bedeutet, dass der Inhalt auf den verschiedenen URLs nicht zu unterschiedlich sein sollte.

Diese Tipps von John Müller sind sehr hilfreich, um sicherzustellen, dass personalisierte Inhalte sowohl den Besuchern als auch den Suchmaschinen gerecht werden. Es ist wichtig, die Balance zu finden, um sowohl ein gutes Nutzererlebnis zu bieten als auch die SEO-Anforderungen zu erfüllen.

|

|

|

|

|

Fragen? Immer gerne fragen!

|

Wir sind für Dich da.

Schreib uns gern jederzeit

eine E-Mail an [email protected] oder

ruf uns einfach kurz an: +49 40 22868040

Bis bald,

Deine Wingmen

|

|

Anckelmannsplatz 1, 20537 Hamburg, Germany

|

|