| Wirklich wahres Wingmen SEO Wissen für wache Webmarketer #229 |

|

| 🎡 Ischa Freimaak! SEO-Insights und Freimarkt-Faszination |

Seit fast 1.000 Jahren wird in den letzten beiden Oktoberwochen die „fünfte Bremer Jahreszeit" gefeiert. Wieder etwas, das ich über meine neue Wahlheimat lernen durfte!

Am vergangenen Wochenende wurde der Bremer Freimarkt feierlich eröffnet, und die Bewohner sowie Besucher der Stadt machten sich auf, um die aufregendsten Fahrgeschäfte und köstlichsten Leckereien zu finden.

Was begeistert, funktioniert nicht nur in der realen Welt, sondern wie wir wissen auch in der digitalen.

So wie die Bremer bei Fahrgeschäften und Leckereien ihre Favoriten wählen, entscheiden sich Nutzer online für die besten Inhalte und Angebote.

Auch wir haben diese Woche wieder eine spannende Auswahl für dich:

- Darius, der beim Achterbahnfahren interessante Einblicke zur erfolgreichen Kundenkommunikation gibt

- Johan, der im Hansezelt kurz den Alu-Hut aufsetzt und die Thesen von Cindy Krum hinterfragt

- Hannah, die beim Dosenwerfen SEO und SEA miteinander kombiniert

- Florian, der in der Geisterbahn die robots.txt näher beleuchtet

- Philipp, der dir verrät, wie du mit deinem Content das beliebteste Fahrgeschäft wirst

|

|

| Mit T.R.U.S.T. zum Erfolg: Kundenkommunikation meistern 🗣️ |

Eigentlich sollten wir ja wissen, wie es geht. Schließlich ist Kundenberatung unser täglich Brot und Kommunikation das Messer, mit dem wir unser SEO-Knowhow unseren Kunden aufs Brot schmieren. Doch auch wir müssen ab und zu "Butter bei die Fische" geben und unsere Skills aufpolieren. Genau das haben wir beim Offsite gemacht. In einem 1,5-tägigen Workshop mit der Verhandlungs- und Kommunikationsexpertin Fatou Wane haben wir uns intensiv mit dem von ihr entwickelten T.R.U.S.T.-Modell beschäftigt.

Dieses fünfstufige Modell bringt Struktur in die Kundenkommunikation: von der Erkennung des Kommunikationstyps bis hin zur Festlegung der nächsten Schritte. Dabei ist der Input nicht nur für uns als Berater und Beraterinnen interessant, sondern lässt sich auf jede Form der Kommunikation übertragen – sei es im beruflichen Kontext, im Team oder sogar im Alltag. Schauen wir uns doch einmal genauer an, wie T.R.U.S.T. dabei hilft, nicht nur Kunden, sondern auch uns selbst zu überzeugen!

T wie Type Recognition: Den Kundentyp erkennen

Im ersten Schritt von T.R.U.S.T. geht es darum, den Kommunikationstyp des Kunden zu identifizieren, um den passenden Ansatz zu wählen. Denn wie bei einem guten Gespräch gilt: Der Ton macht die Musik – und der ist bei jedem unterschiedlich. Hier kommt ein einfaches, aber effektives Modell ins Spiel: die vier Kommunikationstypen, basierend auf dem DISC-Modell.

Dieses Modell unterscheidet zwischen introvertiert und extrovertiert sowie sachorientiert und beziehungsorientiert. Daraus ergeben sich die folgenden Typen:

Analytisch: introvertiert und sachorientiert – legt Wert auf Details, Fakten und eine durchdachte Herangehensweise. Durchsetzungsstark: extrovertiert und sachorientiert – fokussiert auf Ergebnisse und schnelle Entscheidungen, spricht klar und direkt. Empathisch: introvertiert und beziehungsorientiert – legt Wert auf Harmonie und eine persönliche Beziehung, ist oft zurückhaltender. Kommunikativ: extrovertiert und beziehungsorientiert – liebt den Austausch, zeigt Interesse an anderen und ist offen für Dialog.

Die Kunst besteht darin, den Typen des Gegenübers möglichst schnell einzuschätzen, indem man auf nonverbale Signale, die Wortwahl und die allgemeine Kommunikationsweise achtet. Das hilft, "die Sprache des Kunden zu sprechen" – also den richtigen Ton und den passenden Gesprächsstil zu finden.

Wichtig ist dabei, die Typen nicht schwarz-weiß zu sehen, sondern eher als Tendenzen zu verstehen. Die Einordnung kann je nach Kontext variieren, und es geht weniger darum, sich selbst korrekt einzustufen, als vielmehr darum, die Bedürfnisse und Präferenzen des Gegenübers zu erkennen. Denn nur so gelingt es, das Gespräch auf Augenhöhe zu führen und den Kunden gezielt abzuholen – sei es durch Fakten und Zahlen oder durch den Aufbau einer persönlichen Beziehung.

R wie Requesting Feedback: Offene Fragen stellen

Der zweite Schritt im T.R.U.S.T.-Modell dreht sich um die Kunst, durch gezieltes Fragen die Bedürfnisse und Bedenken des Gegenübers zu ergründen. Dabei geht es nicht darum, sofort Lösungen oder Antworten zu präsentieren – auch wenn wir Berater und Beraterinnen oft dazu neigen, genau das zu tun. Stattdessen steht das Stellen offener Fragen im Fokus, um den Gesprächspartner zum Nachdenken anzuregen und wertvolle Einblicke zu gewinnen.

Offene Fragen beginnen in der Regel mit "Was", "Wie" oder "Warum" und laden den Kunden dazu ein, ausführlicher zu antworten. Ein Beispiel wäre: "Welche langfristigen Ziele verfolgen Sie mit dieser Entscheidung?" Diese Art der Fragestellung schafft Raum für wichtige Informationen, die oft über das hinausgehen, was auf den ersten Blick erkennbar ist.

Ebenso wichtig ist es, dem Gegenüber Zeit zu geben, seine Gedanken zu äußern. Schweigen kann dabei ein wertvolles Werkzeug sein, denn es gibt dem Gesprächspartner die Gelegenheit, sich zu äußern, ohne sich unterbrochen zu fühlen. Manchmal bringt das bewusste Aushalten von Stille sogar tiefere Einsichten hervor, weil der Kunde gezwungen ist, seine Gedanken zu strukturieren und auszusprechen.

Diese Technik stärkt nicht nur das Verständnis für die Anliegen des Kunden, sondern signalisiert auch, dass seine Meinung wertgeschätzt wird. Dadurch entsteht eine offenere Atmosphäre, in der beide Seiten miteinander statt gegeneinander arbeiten – und das ist der Schlüssel zu einer erfolgreichen Beratung.

U wie Understanding Interests: Interessen empathisch ansprechen

Der dritte Schritt des T.R.U.S.T.-Modells betont, wie wichtig es ist, nicht nur zu hören, was der Kunde sagt, sondern auch zu verstehen, welche Bedürfnisse und Motive dahinterstehen. Oft geht es dabei weniger um die offensichtlichen Unternehmensziele, sondern um die zugrunde liegenden persönlichen Interessen, wie beispielsweise das Erreichen eines Bonusziels, die Anerkennung durch Vorgesetzte oder die Vermeidung unangenehmer Situationen.

Hier kommt die Fähigkeit des aktiven Zuhörens ins Spiel. Es reicht nicht aus, die Aussagen des Kunden einfach zu registrieren – es ist entscheidend, sie aufzugreifen, zusammenzufassen und gegebenenfalls zu spiegeln, um sicherzustellen, dass man die zugrunde liegenden Interessen wirklich verstanden hat. Ein hilfreiches Beispiel wäre: "Ich verstehe, dass Sie sich Sorgen machen, ob die Lösung wirklich funktioniert." Solche Aussagen zeigen dem Gegenüber, dass man dessen Bedenken wahrnimmt und ernst nimmt.

Die Herausforderung besteht darin, die "Zwischenzeilen" zu lesen und den Kern der Bedürfnisse herauszufiltern, die nicht immer explizit geäußert werden. Denn nur wenn man die echten Interessen des Kunden erkennt, kann man gezielt darauf eingehen und das Gespräch in eine Richtung lenken, die sowohl den Kunden als auch die eigenen Ziele voranbringt. Empathie ist hier der Schlüssel, um eine vertrauensvolle Basis zu schaffen und die Kommunikation auf Augenhöhe zu halten.

Das aktive Ansprechen von Interessen stärkt die Bindung zum Kunden und erhöht die Chance, gemeinsam zu einer Lösung zu gelangen, die für beide Seiten sinnvoll ist.

S wie Showing Benefits: Nutzen klar formulieren

Im vierten Schritt des T.R.U.S.T.-Modells dreht sich alles um die Kunst, den Nutzen einer Lösung so zu präsentieren, dass die Bedürfnisse des Kunden direkt angesprochen werden. Hier gilt es, klar und überzeugend zu kommunizieren, wie die angebotene Lösung dem Kunden tatsächlich hilft und welche Vorteile er daraus ziehen kann.

Ein effektiver Ansatz besteht darin, den Nutzen in zwei Kategorien zu unterteilen: sofortige Nutzen und nachhaltige Vorteile. Sofortige Nutzen sind die direkten, kurzfristigen Vorteile, die der Kunde unmittelbar erwarten kann, während nachhaltige Vorteile langfristige positive Effekte beschreiben, die über den Moment hinausgehen. Ein Beispiel könnte lauten: "Diese Funktion spart Ihnen Zeit, sodass Sie sich auf Ihre Kernaufgaben konzentrieren können" (sofortiger Nutzen) und "Langfristig ermöglicht Ihnen diese Lösung, effizienter zu arbeiten und bessere Ergebnisse zu erzielen" (nachhaltiger Vorteil).

Wichtig ist, den Nutzen stets in Verbindung mit den Interessen des Kunden zu bringen. Nicht jedes Argument ist für jeden Kunden relevant, daher sollte man die Argumentation immer an den individuellen Bedürfnissen des Gegenübers ausrichten. Wenn der Kunde beispielsweise Wert auf Effizienz legt, sollte man hervorheben, wie die Lösung die Arbeitsabläufe optimiert. Wenn die Beziehungsebene wichtig ist, kann betont werden, wie die Lösung die Zusammenarbeit im Team fördert.

Durch eine klare und zielgerichtete Nutzenformulierung schafft man Vertrauen und zeigt dem Kunden, dass man seine Bedürfnisse ernst nimmt. Indem man die Vorteile konkret anspricht, erleichtert man dem Kunden die Entscheidungsfindung und fördert eine positive Grundhaltung gegenüber der vorgeschlagenen Lösung.

T wie Taking Steps: Nächste Schritte festlegen

Im letzten Schritt des T.R.U.S.T.-Modells geht es darum, einen klaren Plan für die nächsten Schritte zu erstellen und dem Kunden Sicherheit zu geben. Nachdem man die Interessen und Bedürfnisse des Kunden erfasst und den Nutzen der angebotenen Lösung überzeugend kommuniziert hat, ist es entscheidend, gemeinsam festzulegen, wie es weitergeht.

Der Schlüssel zu diesem Schritt liegt in der Flexibilität. Es ist hilfreich, dem Kunden verschiedene Handlungsoptionen anzubieten und zu fragen, was für ihn am besten klingt. Ein einfaches Beispiel könnte lauten: "Wie klingt das für Sie? Würde es Ihnen helfen, wenn wir einen Zeitplan erstellen?" Diese Art der Formulierung gibt dem Kunden die Möglichkeit, aktiv in den Entscheidungsprozess einzutreten und sich an der Gestaltung des nächsten Schrittes zu beteiligen.

Das Festlegen von konkreten nächsten Schritten gibt dem Kunden nicht nur ein Gefühl der Kontrolle, sondern zeigt auch, dass man bereit ist, die Verantwortung zu übernehmen und gemeinsam an der Umsetzung zu arbeiten. Es stärkt das Vertrauen und fördert die Zusammenarbeit – schließlich geht es nicht nur darum, eine Lösung zu verkaufen, sondern auch darum, einen Partner an der Seite des Kunden zu sein, der ihn auf dem Weg begleitet.

Indem man die nächsten Schritte klar kommuniziert und einen Zeitrahmen festlegt, verringert man Unsicherheiten und schafft eine positive Grundlage für die weitere Zusammenarbeit. So wird der Kunde nicht nur überzeugt, sondern auch motiviert, gemeinsam voranzuschreiten – und das ist der Schlüssel zu einer langfristigen, erfolgreichen Kundenbeziehung.

|

|

| Einmal Alukappen für alle (schickt Dein Browser Inhalte in den Index?)! |

Ich weiß. Seit Covid finden wir alle Verschwörungstheorien weniger lustig. Ist ja auch erschreckend.

Aber das hier ist nicht lustig, sondern beruflich.

Cindy Krum hat vor 2 Wochen ein Video rausgehauen. Nutzt Google unsere Browser, um das Rendering der Seiten für den Index durchzuführen?

Ich habe den Talk live auf dem G50 Summit gesehen. Und ich war beeindruckt. Cindy hat das fantastisch vorgetragen und das Kopfkino in Gang gesetzt. Das ist es, was ich mir von einem Vortrag erhoffe. Impulse, die das eigene Denken anregen.

Trotzdem war ich nicht überzeugt. Für mich war das am Ende zu viel Alufolie und zu wenig Beweis. Die meisten Anwesenden waren aber überzeugt.

Daher habe ich meine Gedanken noch mal sortiert und für Cindy aufgeschrieben (und ihr geschickt, bevor sie das Video veröffentlicht hat). Bevor Du jetzt aber meine Anmerkungen liest, solltest Du das Video sehen, oder zumindest die Zusammenfassung lesen. Denn Cindy macht ihren Case sehr schön und mitreißend deutlich.

Der Vollständigkeit halber solltest Du Dir auch noch mal die Punkte von Valentin Pletzer ansehen, vor allem aber die Kritik von Pedro Dias und Cindys Replik. Letzteres allein schon, weil das genau in Ton und Wertschätzung die Art ist, wie solche Diskussionen geführt werden sollten. Vorbildlich.

Ab hier bitte erst weiter, wenn Du mindestens die Zusammenfassung von Cindys Video gelesen hast.

(Ich danke ChatGPT für die Übersetzung meiner Mail an Cindy)

Hi Cindy

Wie versprochen, hier meine Hauptgedanken, warum ich nicht überzeugt bin, dass Google Dokumente unter Verwendung von nutzerseitig gerenderten HTML-Daten indexiert. Auch wenn ich die Theorie interessant finde und gerne daran glauben würde, denke ich, dass es komplexer ist. Ich stimme vollkommen zu, dass Google mehr als nur Klicks und Core Web Vitals Daten sammelt, und dein Punkt über Kreditkartendaten erinnert mich an den Panda-Fragebogen. Trotzdem bleibe ich skeptisch, was die Nutzung von nutzerseitig gerenderten Daten für Indexierungszwecke angeht.

"Der Leak": Ich habe dieses Jahr mehrere Stunden damit verbracht, die Crawling- und Rendering-Module zu untersuchen, die durch den Leak aufgedeckt wurden. Obwohl verschiedene Crawler erwähnt werden, gibt es keinen Hinweis darauf, dass alternative Datenquellen wie nutzerseitig gerendertes HTML in den Prozess einbezogen werden. "Die Honigtöpfe": Ich habe die Daten meiner Honeypots überprüft und festgestellt, dass bei jeder Anfrage an das HTML sofort eine Folgeanfrage an das timestamped JSON-Objekt gestellt wird, das nur verfügbar ist, wenn JavaScript ausgeführt wird. Diese Anfrage kommt immer von einer Googlebot-IP-Adresse. Nach meinen Beobachtungen rendert Googlebot jede indexierbare URL sofort, nachdem das HTML gecrawlt wurde. "Der Payload": Während COVID habe ich die Datenströme von Chrome zu Google genau untersucht und festgestellt, dass die Payloads zu klein sind, um ein vollständig gerendertes HTML zu transportieren. Zwar ist es technisch möglich, die Daten in kleine Pakete aufzuteilen und von verschiedenen Nutzern wieder zusammenzusetzen, aber das scheint unnötig kompliziert. Außerdem hätten datenschutzorientierte Plattformen wie Brave oder andere Aufpasser solche Praktiken wahrscheinlich aufgedeckt und offengelegt. "Die Gerätevielfalt": Kürzlich hat Audisto einen Test durchgeführt, um die Bildschirmgrößen bei Googles Rendering zu untersuchen. Sie stellten fest, dass die Höhe zwar fast unbegrenzt ist, es aber nur zwei Hauptbreiten-Einstellungen gibt, die es Google ermöglichen, das mobile Rendering auch für Desktop-Ergebnisse zu nutzen. Wenn Google Daten von Nutzergeräten verwenden würde, wäre eine viel größere Bandbreite an Bildschirmgrößen zu erwarten, nicht nur beim Crawlen, sondern auch in den Daten, die in der Search Console angezeigt werden. "Das PII-Risiko": Wenn Google gerenderte Daten von Nutzergeräten zurücksenden würde, bestünde ein ernstes Risiko, dass persönliche Informationen (PII) versehentlich indexiert werden. Wenn ich zum Beispiel bei der New York Times eingeloggt bin, könnte Google versehentlich den spezifischen Artikel indexieren, den ich gerade lese, und dieser würde dann in den SERPs erscheinen. Das Problem wird noch besorgniserregender bei sensiblen Daten wie Bankinformationen oder Informationen aus Foren für Arztbesuche. Es gibt keine zuverlässige Möglichkeit, dies zu verhindern, ohne potenziell wertvolle Inhalte während der Indexierung zu entfernen. Unter der DSGVO könnte eine solche Panne zu Geldstrafen von bis zu 2 % des globalen Umsatzes von Google führen. Noch schlimmer: Wenn ein solcher Prozess tief in die Infrastruktur von Google eingebettet wäre, wäre es schwer, ihn schnell zu entfernen, was zu jahrelangen Strafen führen könnte. Dies würde die ohnehin schon bestehenden regulatorischen Herausforderungen für Google weiter verschärfen. "Das Update-Paradox": Bisher habe ich noch nie beobachtet, dass ein Dokument indexiert wurde, ohne dass ein Besuch von Googlebot stattfand. Ebenso habe ich noch keine Aktualisierungen von Artikeln in den SERPs gesehen, ohne dass Googlebot (User-Agent + IP) die Seite nach den Änderungen gecrawlt hat. "Der ROI": Daten von 65 % des Internetverkehrs an Google-Server zurückzusenden, würde enorme Datenmengen erzeugen, selbst mit Sampling. Die Kosten für die Verarbeitung solcher Daten – noch bevor man PII, Normalisierung der Bildschirmgrößen usw. anspricht – wären astronomisch. Es gibt auch ein erhebliches Entdeckungsrisiko, insbesondere bei privaten Browsing-Sitzungen und ausgeloggten Nutzern. Die potenziellen Gewinne, wie die Erkennung von Cloaking (was nur wenige Webmaster verwenden) oder das Verständnis von Anzeigenplatzierungen, scheinen den enormen Aufwand nicht wert zu sein. Ich glaube auch, dass wir oft Googles Fähigkeiten überschätzen – eine Suchmaschine zu bauen ist unglaublich komplex, und einfachere Lösungen sind oft praktischer. Außerdem: Crawling mit Rendering ist teuer. Aber Google tut viel, um es machbarer zu machen: Das Weglassen des Paintings, nicht jedes mögliche File zu laden usw.

Deshalb sehe ich keinen Hinweis darauf, dass Google nicht regelmäßig indexierbare Seiten rendert. Aus diesem Grund bin ich nicht überzeugt, dass die potenziellen Vorteile der Nutzung nutzerseitig gerenderter Daten den enormen Aufwand rechtfertigen würden. Ich neige auch dazu zu glauben, dass wir oft Googles Fähigkeiten überschätzen. Eine Suchmaschine zu bauen ist unglaublich komplex, und in der Realität sind die Dinge oft einfacher, als wir annehmen.

Allerdings haben meine "Fakten" Schwächen:

- Google könnte all diese Informationen sammeln und sie einfach nicht in den SERPs und der Search Console anzeigen.

- Google könnte die Anfragen der Nutzer irgendwie über ihre IPs weiterleiten (und die Auswirkungen auf Geschwindigkeit, Privatsphäre usw. umgehen), sodass es wie Googlebot aussieht, obwohl es das nicht ist.

- Google könnte eine völlig andere Einstellung zu den Risiken haben.

- Mir fehlen wesentliche Elemente des Nutzens.

Aber ich würde mich sehr freuen, meinen Aluhut aus dem Schrank zu holen. Denn ich mag die Theorie sehr. Ich brauche nur mehr Beweise, um diese Fakten loszuwerden, die mich im Moment noch zurückhalten.

Viele Grüße

Johan

|

|

| SEO und SEA effektiv kombinieren |

Letzte Woche beim SEO Meetup Hamburg hat Gero Wenderholm uns mitgenommen auf eine Reise durch seine Vergangenheit. Als Head of Search hat er bei Tchibo die Bereiche SEO und SEA kombiniert geleitet und konnte so super viele Erfahrungen sammeln, Tests fahren und Dinge ausprobieren – die wichtigsten Erkenntnisse hat er beim Meetup vorgestellt – vielen Dank dafür 🙂.

SEO und SEA sind unterschiedliche Kanäle, die auf derselben Plattform stattfinden. Dennoch werden die Zahlen in den meisten Fällen getrennt voneinander betrachtet. Auch wir haben nur selten Gelegenheit, die Zahlen nebeneinander zu legen und nach Synergien, Optimierungsmöglichkeiten oder Problemen zu schauen. Dasselbe gilt übrigens für Social Daten, die uns SEOs ebenfalls häufig nicht vorliegen, aber durchaus spannend wären, in einige Analysen mit aufzunehmen. Leider sind wir aber ja meistens nicht im Wunschkonzert...

SEO und SEA können toll kombiniert werden und sich gegenseitig ergänzen. Es kann aber auch zu Kannibalisierung führen und sich gegenseitig negativ beeinflussen.

Wofür können wir SEA nutzen?

Wir können durch SEA nicht nur Suchvolumen ermitteln, sondern den Kanal ebenfalls nutzen, um Tests zu fahren, beispielsweise indem wir Snippets ändern und CTRs prüfen. Das ist auch eine tolle Möglichkeit um bei Keywords den Intent der Nutzer genauer zu erfahren – indem wir zusätzlich zu einem guten organischem Ranking eine Anzeige schalten zum selben Inhalt aber mit einer anderen Formulierung können wir prüfen, welches Snippet den Intent eher widerspiegelt.

Wir können mit SEA aber auch SEO Lücken schließen. Indem wir dort Ads schalten, wo wir organisch noch nicht gut ranken. Oder wir können Ads schalten, um präsenter auf der SERP zu sein und den Wettbewerb aus dem sichtbaren Bereich zu drücken.

Gero hat aber auch detaillierte Kniffe erläutert, wie das Anzeigenschalten auf bestimmte lokalisierte Suchen – beispielsweise um Filialen herum, um die Nutzer direkt in den Store zu locken anstatt auf die Website oder in bestimmten Bereichen mit entsprechender Kaufkraft.

Die wichtigsten Dinge, die Dir bewusst sein sollten:

SEO und SEA beeinflussen sich gegenseitig Prüfe die Ziele im Unternehmen und stelle im Idealfall sicher, dass gegensätzliche Ziele nicht vorkommen Analysiere beide Kanäle gemeinsam – Beispiel: geht die CTR im SEO runter bei gleichbleibender Position könnte es vielleicht sein, dass vermehrt Anzeigen geschaltet wurden SEO ist nachhaltiger als SEA – nutze die Anzeigen nur als Ergänzung

Wenn dich das Thema interessiert, schauen wir gern einmal auf Deine Zahlen und helfen Dir, das Potenzial optimal auszuschöpfen. Hierfür analysieren wir beispielsweise, wo SEA unnötig Geld ausgibt und unsere SEO Rankings torpediert. Wir können andersrum aber auch Low Hanging Fruits im SEO finden und dann gezielt nach Möglichkeiten schauen, um unsere SEO Rankings zu optimieren für Dinge, die im SEA schon besser funktionieren.

Das nächste SEO Meetup in Hamburg wird am 19. November sein und ich freue mich, dass Sandra dann ihr Wissen über Accessibility mit uns teilen wird. Wenn auch Du dabei sein möchtest, melde dich gern an https://www.meetup.com/de-DE/seo-meetup-hamburg/

|

|

| Back to Basics: Robots.txt |

Die robots.txt ist wie ein Regelwerk für Crawler. Sie steuert, was Bots auf Deiner Seite crawlen und welche Inhalte sie sich ansehen dürfen.

Das Einrichten einer robots.txt ist keine Pflicht. Solltest Du keine besitzen, werden die Crawler einfach davon ausgehen, dass sie jede Deiner Seiten crawlen dürfen. Da spricht auch prinzipiell nichts gegen.

Grundsätzlich kann eine robots.txt Dir aber sehr helfen, Dein Crawling effizienter zu gestalten. Vor allem, wenn Suchmaschinen Bots wie der Google Crawler sich auf Deiner Seite gerne mal verlaufen.

Ansehen kannst Du Dir eine robots.txt indem Du einfach /robots.txt an das Ende einer Domain packst. Beispielsweise so:

Wie richtet man eine robots.txt ein?

Du brauchst recht wenig in Deine robots.txt Datei schreiben. Für 99% der Fälle reicht das aus:

User-Agent: *

Disallow:

Sitemap: https://wngmn.de/sitemap.xml

Theoretisch kannst Du aber auch das schreiben:

User-Agent: *

Allow: /

Sitemap: https://wngmn.de/sitemap.xml

Beide Varianten erlauben es dem Crawler überall hinzugehen. Entweder indem "Disallow:" leer bleibt und so keine Verbote ausgesprochen sind, oder indem "Allow: /" Zugriff auf jedes Verzeichnis erlaubt.

Das Hinzufügen einer Sitemap ist ebenfalls nicht nötig, aber empfehlenswert. Genaueres dazu kannst Du in meinem Sitemap Artikel von vor einigen Wochen nachlesen. Achja, und "User-Agent: *" bedeutet einfach, dass die Vorgaben für jeden User-Agent, also jeden Crawlerbot gelten.

Beim Schreiben einer robots.txt kannst Du generell auf Sonderzeichen/Wildcards wie "*" zurückgreifen. Das "*"-Zeichen steht als Wildcard hierbei für jedes mögliche Zeichen. Das "$"-Zeichen beispielsweise für das Ende einer URL. Wenn Du Dich mit Regex auskennst, sollte das nicht sonderlich kompliziert für Dich sein.

Hier ein ausgeführtes Beispiel zur Veranschaulichung:

User-Agent: Googlebot

Disallow:

# erlaubt allen Googlebots auf alle Inhalte zuzugreifen

User-Agent: Googlebot-News

Disallow: /sexy-hexy-Porno-Artikel-Verzeichnis

Disallow: /satire-Artikel-Verzeichnis

# verbietet dem Newsbot den Zugriff auf Verzeichnisse mit Themen, die für News nicht zulässig sind

Folgende Anweisungen werden oft zusätzlich gerne ergänzt, werden von Google aber nicht mehr verwendet (oder wurden es noch nie):

Crawl Delay No Index No follow

Es gibt also keinen Grund, diese Directives in Deiner robots.txt zu verwenden.

Was gibt es noch zu beachten?

Auch wenn Du Deine robots.txt vernünftig geschrieben hast, gibt es dennoch ein paar weitere Anforderungen:

Die Datei muss immer im Root der Domain liegen. Deine robots.txt sollte utf-8 codiert sein. Nur die ersten 500kb werden von Google verarbeitet. Mache Deine robots.txt Datei also nicht zu groß. Wenn Du Kommentare in Deine robots.txt packen willst, kannst Du diese mit "#" Kennzeichnen.

Was sind gängige Crawler?

Falls Du dich oben gefragt hast, was genau die User-Agents sind. Hier ist eine Liste der gängigsten Crawler:

Hier findest Du auch eine ausgiebige Liste der verschiedenen Google Crawler.

Ist eine robots.txt für Crawler bindend?

Suchmaschinen-Bots sind nicht gezwungen, sich an Angaben in der robots.txt zu halten. Bei eindeutigen Angaben hält Google sich zwar immer daran, aber genau das kann auch manchmal zu Fallstricken führen. Setzt Du eine Seite auf noindex und schließt sie mit der robots.txt aus, verlinkst sie aber weiterhin intern, kann es passieren, dass Google diese im Index behält. Durch das Crawl-Verbot in der robots.txt sieht Google den noindex Tag nämlich gar nicht erst.

Nicht besonders gut gestimmte Crawler (und Perplexity) ignorieren Deine robots.txt auch gerne mal gänzlich. Nora hatte hierzu vor einer Weile ebenfalls einen Artikel über böse Bots geschrieben. Lies Dir diesen doch gerne durch, um Dir ein noch genaueres Bild zu machen.

Auch wenn robots.txt nicht zwingend bindend für jeden Crawler ist, bietet sie dennoch viele Vorteile.

Solltest Du eine große Domain haben, ist eine robots.txt wichtig zur effizienten Steuerung Deines Crawl Budgets. Vor allem, wenn Du in der GSC häufiger mal auf Crawl Probleme wie "Crawled, but not indexed." oder "Discovered, but not crawled." stößt kann eine robots.txt viel bewegen.

Falls Du noch etwas mehr über die robots.txt wissen möchtest, kannst Du dir gerne diesen robots.txt Artikel auf unserer Webseite durchlesen. Schau Dir auch gerne einfach mal die robots.txt Dateien einiger anderer Webseite an. Manchmal kann man daraus viel über eine Domain lernen.

|

|

| Mit diesen Inhalten übertriffst Du die Erwartungen Deiner Nutzer und Nutzerinnen |

William McKeen sagt folgendes über Serendipität:

"Looking for something and being surprised by what you find – even if it's not what you set out looking for – is one of life's greatest pleasures."

Die Parallele zur SEO und Content Marketing ist die Erwartungshaltung, die wir gegenüber Inhalten haben. In der organischen Suche erwarte ich etwas bestimmtes (= die Suchintention). Immer, wenn ich jemandem SEO erkläre, spreche ich das an. Es geht im Kern immer um reale Nachfrage, die wir mit dem richtigen Angebot treffen müssen.

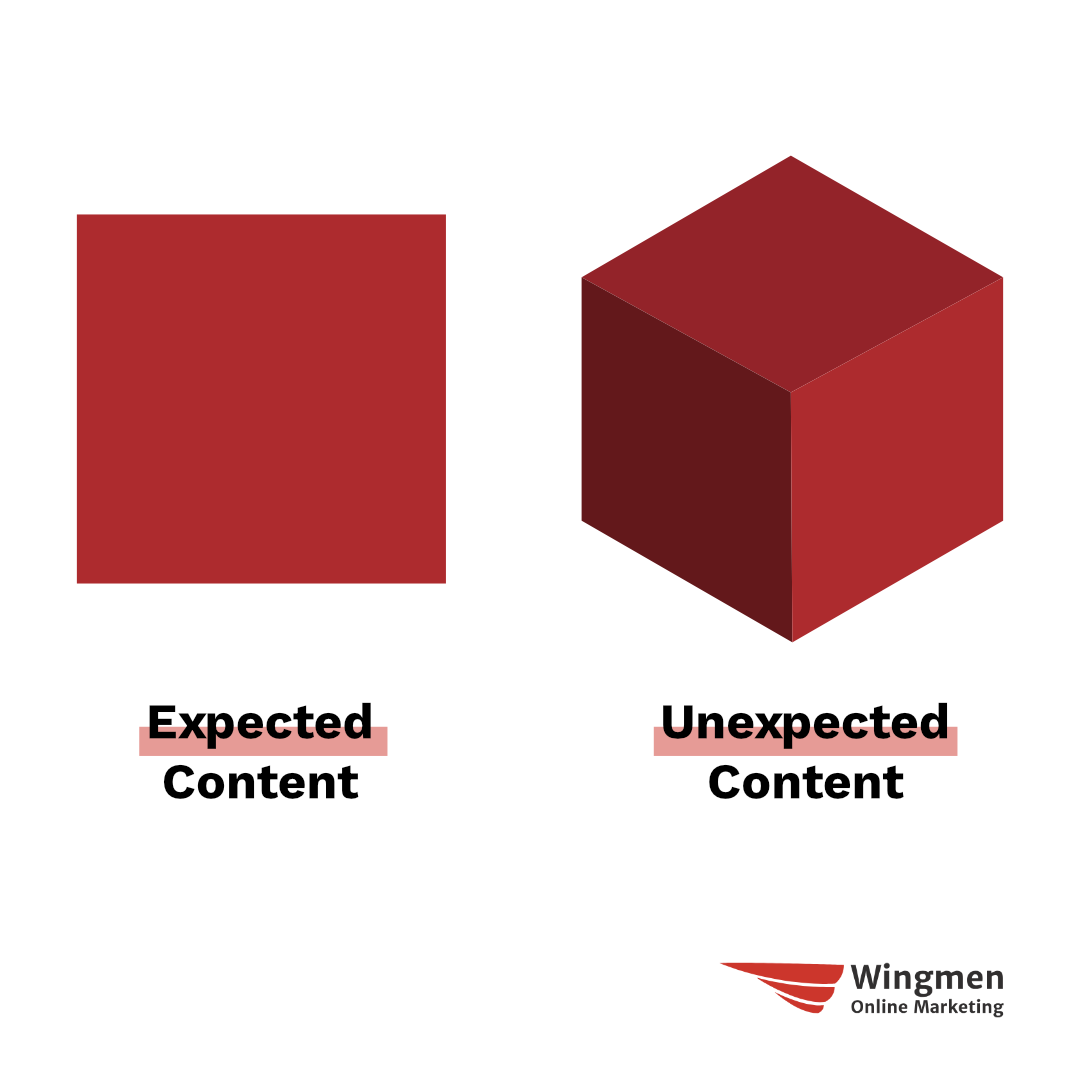

Es ist also ein erwarteter Inhalt (= Expected Content). Wenn ich über etwas stolpere, nach dem ich nicht gesucht habe, dann ist es ein unerwarteter Inhalt (= Unexpected Content).

In "Wie kannst Du die Qualität Deiner Inhalte messen?" habe ich das Thema bereits kurz angerissen.

Vor ein paar Jahren bin ich auf das Konzept von Andrew Holland in seinem Buch "The Value of SEO" gestoßen:

Damit Deine Content-Strategie richtig aufgeht, brauchst Du beides. Warum?

In Kurzform:

Bei Expected Content geht es in vielen Fällen nicht konkret um uns, sondern eine Information, die von egal wem kommen kann. SEO-Inhalte unterliegen bestimmten Restriktionen, damit sie funktionieren können. Nicht jedes Thema ist für SEO gemacht. Bei der Distribution funktionieren suchmaschinenoptimierte Inhalte vor allem in der organischen Suche, nicht aber in anderen Kanälen wie Social Media.

Die drei Aspekte schauen wir uns gemeinsam näher an.

Worum es beim Suchen geht

SEO 1x1: Damit Deine Inhalte in der organischen Suche performen, musst Du die Erwartungshaltung erfüllen (Suchintention) und Faktoren berücksichtigen, die Suchmaschinen wichtig sind.

Aber Erwartungen nur zu erfüllen, ist nicht so mächtig, wie sie zu übertreffen. Das ist mit SEO-Inhalten viel schwieriger als mit anderen Inhalten.

Expected Content (= SEO-Inhalte) lockt Traffic an – hält und bindet ihn aber nicht so stark, wie Unexpected Content. Es geht in vielen Fällen (bei non-Brand Traffic) nicht spezifisch um uns, sondern um eine Antwort auf eine Frage, ein Produkt was man kaufen möchte, etc.

Unexpected Content holt da ab, wo SEO den Traffic-Zug abstellt. Und der Zug hat mit Restriktionen auf dem Weg zum Ziel zu kämpfen.

Content-Restriktionen, um erfolgreich zu sein

"Ich mag nicht für SEO schreiben" höre ich immer wieder. Und ja, es gibt einige Sachen, auf die man achten sollte. Falls Du da ein paar einfache Tipps brauchst, kannst Du mal in diesen Artikeln nachlesen:

Aber auch mit SEO-Inhalten kann man begeistern. Es muss weder langweilig, monoton, noch robotisch sein. Damit solche Inhalte begeistern, musst Du Wege finden, wie sich Deine Ergebnisse abheben. Das passiert meistens dann, wenn es Informationsgewinn gibt, also Inhalte, die andere Suchergebnisse nicht haben.

Aus meiner Sicht muss das nicht nur Text sein – auch Grafiken, Tabellen, Videos, Tools, etc. können die Suchintention befriedigen und ein Wettbewerbsvorteil sein.

Oder, weil jemand die Inhalte schreibt bzw. diesen Prozess begleitet und die Zielgruppe gut kennt. Den Unterschied, ob jemand Ahnung hat, bemerkt man.

Das Thema habe ich unter anderem in "Good (Unique) Content, Bad (Copycat) Content – das können wir besser" thematisiert.

Die Stimme Deiner Inhalte ist extrem wichtig. Es ist beeindruckend, wie erkennbar manche Autor*innen sind. Genauso verhält es sich auch mit Deiner Marke, die idealerweise eine einzigartige Stimme hat.

Ganz wirst Du die Restriktionen aber auch so nicht los, da die Form des Inhalts den Distributionsweg vorgibt.

Die Inhaltsform bedingt die Content-Distribution

Es heißt oft, man müsse seine Inhalte besser vermarkten. Das unterschreibe ich. Aber mir fehlt dabei eine gewisse Nuance. SEO-Inhalte funktionieren über die organische Suche, weil der Inhalt entsprechend für diesen Kanal aufgebaut ist.

In vielen Fällen funktioniert ein SEO-Inhalt nicht, wenn ich ihn auf Social Media poste. Die Inhaltsform passt nicht zum Distributionskanal.

Umgekehrt ist es genauso. Social Media Content kann ich nicht 1:1 für SEO verwenden, weil der Funktionsmechanismus dahinter ein anderer ist. Das eine ist Pull (Inbound, z. B. SEO) und das andere ist Push.

Die Crux ist, dass ein Artikel keine Idee ist, sondern ein Vehikel, um Deine Ideen zu transportieren.

Du musst Deine Idee distribuieren, nicht (nur) Deinen Artikel. Dafür brauchst Du entsprechend des Kanals das richtige Vehikel. Mit einem Auto wirst Du es auf Wasser schwierig haben. Genauso aber auch mit einem Boot auf der Straße.

Ganz wichtig, also nochmal: Artikel sind keine Ideen, sondern ein Vehikel, um Deine Idee zu transportieren.

Theorie ist gut, Praxis ist besser: Beispiele für Unexpected Content und Serendipität

Es ist leicht, über das Thema zu schreiben, aber was ist mit konkreten Beispielen? Im Prinzip ist dieser Newsletter auch immer eine Wundertüte. Klar, eine gewisse Erwartungshaltung ist vorhanden. Wir möchten

die wichtigsten Neuigkeiten, elementare Evergreen-Themen, Anreize zum Nachdenken und hilfreiche Anleitungen liefern.

Aber bevor wir in Deinem Postfach landen, hast Du keine Ahnung, was auf Dich wartet.

Das ist aber nicht das einzige Beispiel in meinem Gepäck, denn um den Newsletter zu lesen, musstest Du ja erstmal abonnieren.

1. Hubspot

Auf der einen Seite rankt HubSpot für unglaublich viele Suchanfragen (und macht dabei viel trivialen Content, der relativ seelenlos klingt. Dass das nicht der richtige Weg ist, haben sie selbst erkannt).

Das erwarte ich: Wie baue ich eine Marketing-Strategie

Das überrascht mich: HubSpot spricht darüber, dass ihre Inhalte nicht gut genug sind

2. Target

Als einer der größten Einzelhändler der USA ist Target natürlich eine nachgefragte Marke und rankt ebenfalls für viele suchstarke Keywords. Sie haben aber auch spezifische Inhalte, die explizit auf Serendipität abzielen.

Das erwarte ich: Damenbekleidung als Kategorie

Das überrascht mich: Unerwartete, kuratierte Artikel, die immer neue Entdeckungen zulassen

3. New York Times

Ein Publisher – natürlich erwarte ich hier News und Artikel. Aber die NYT hat viel mehr als nur das – das meiste davon ist Unexpected Content und könnte dafür verantwortlich sein, dass sie im digitalen Bereich mehr als 10x so viele Subscriber haben, als im Printbereich.

Das erwarte ich: News und journalistische Artikel

Das überrascht mich: Interaktive Features, Formate wie Modern Love und The Hunt oder Cooking

4. Ahrefs

Content Marketing kann Ahrefs. Es ist eine bunte Mischung aus Inhalten, die für SEO gebaut sind und unerwartetem Kram. Gleichzeitig gestalten sie ihre SEO-Inhalte auch so, dass sie interessanter sind (z. B. in dem sie eindeutig aus eigener Erfahrung berichten).

Das erwarte ich: Ein Guide zu Basics von SEO Content (siehe oben)

Das überrascht mich: Warum Unternehmen wie HubSpot absichtlich schlechte Inhalte machen

Wenn ich etwas erwarte, dann bleibt meistens weniger Raum für Überraschungen offen. Aber genau das macht geniale Inhalte am Ende aus.

Content wäre ohne Serendipität langweilig

Serendipität ist laut Steven Johnson (in "Where Good Ideas Come From") eine von 7 Quellen von Innovationen und guten Ideen.

Die Welt wäre langweilig, wenn wir nur das bekämen, was wir erwarten. Achte mal auf Dein eigenes Konsumverhalten. Ich bin mir sicher, dass Du häufig nicht nur konkret suchst, sondern Dich überraschen und begeistern lässt.

SEO ist oft eine gute erste und wiederholende Anlaufstelle, um Traffic zu akquirieren. Um unsere Besucher*innen zu begeistern und langfristig an uns zu binden, reicht das aber (oft) nicht.

Wenn wir uns zu sehr auf "nur SEO" fokussieren und andere Kanäle vernachlässigen, erhöhen wir bei einer Abhängigkeit das Risiko und hissen gleichzeitig eine rote Flagge, weil wir keine richtige Marke sind, die User und Google begeistert.

Also: Spiele in der SEO mit den anderen Content-Menschen im Team, statt der einsame Lone Wolf zu sein. Sonst endest Du traffic-hungrig am Ende der Nahrungskette.

Überraschen Dich unsere Artikel manchmal?

|

|

|

|

|

Fragen? Immer gerne fragen!

|

Wir sind für Dich da.

Schreib uns gern jederzeit

eine E-Mail an [email protected] oder

ruf uns einfach kurz an: +49 40 22868040

Bis bald,

Deine Wingmenschen

|

|

Anckelmannsplatz 1, 20537 Hamburg, Germany

|

|